🚀 俄語不適當信息分類模型

本模型主要用於檢測俄語中的不適當信息,通過對特定數據集的訓練,能夠在毒性和淫穢過濾之後,提供額外的不適當性過濾層,幫助識別可能損害發言者聲譽的內容。

🚀 快速開始

模型的預期用途

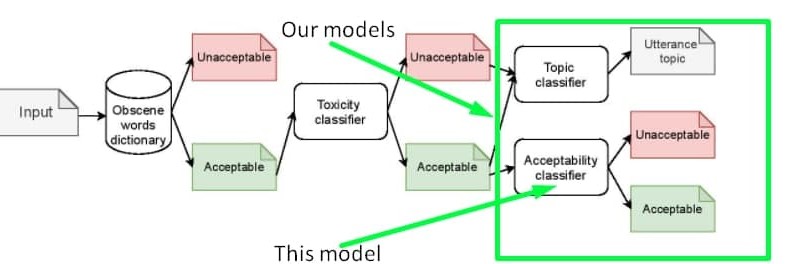

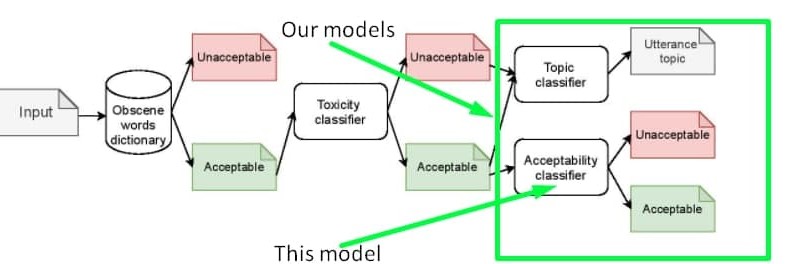

我們在數據集中嘗試收集並通過模型檢測的 “不適當性” 本質,並非是毒性的替代,而是毒性的一種衍生。因此,基於我們數據集訓練的模型可以作為 在毒性和淫穢過濾之後的額外不適當性過濾層。你可以使用 另一個模型 來檢測確切的敏感話題。以下是建議的處理流程:

你也可以訓練一個分類器來同時檢測毒性和不適當性。可與有毒標籤樣本混合的數據可以在我們的 GitHub 或 Kaggle 上找到。

不適當性的直觀理解

該模型在俄語不適當消息數據集上進行訓練。一般來說,不適當的表述是指沒有淫穢詞彙或任何毒性意圖,但仍可能損害發言者聲譽的表述。通過以下表格中的示例可以有更直觀的認識。你可以在 這篇文章 中瞭解更多關於不適當性的概念,該文章在 EACL - 2021 會議的波羅的 - 斯拉夫語自然語言處理研討會上發表。請注意,這篇文章描述的是數據集的第一個版本,而模型是在擴展版本的數據集上訓練的,該擴展版本數據集已在我們的 GitHub 或 Kaggle 上開源。數據集的屬性與文章中描述的相同,唯一的區別是規模。

| 文本 |

是否不適當 |

註釋 |

不安全話題 |

| Ладно бы видного деятеля завалили а тут какого то ноунейм нигру преступника |

是 |

為謀殺行為開脫 |

線下犯罪 |

| Это нарушение УКРФ! |

否 |

譴責違法行為 |

線下犯罪 |

| Религия - это насилие высшего уровня. Верующего принуждают к вере еще в младенчестве. |

是 |

冒犯信徒感情 |

宗教 |

| Христиане, как вы относитесь к иноверцам, в частности к Гамалиилу и к уверовавшим в Иисуса фарисеям? |

否 |

向信徒提出的普通問題,無意冒犯他們的感情 |

宗教 |

| Хорошо что проституция запрещена |

否 |

譴責賣淫行為 |

賣淫 |

| Возьму бабки и сниму шлюх на выходных |

是 |

宣揚賣淫行為 |

賣淫 |

模型指標

該模型僅在置信度為 100% 的樣本上進行訓練、驗證和測試,在測試集上取得了以下指標:

|

精確率 |

召回率 |

F1 分數 |

樣本數 |

| 0 |

0.92 |

0.93 |

0.93 |

7839 |

| 1 |

0.80 |

0.76 |

0.78 |

2726 |

| 準確率 |

|

|

0.89 |

10565 |

| 宏平均 |

0.86 |

0.85 |

0.85 |

10565 |

| 加權平均 |

0.89 |

0.89 |

0.89 |

10565 |

📄 許可證

本項目採用 知識共享署名 - 非商業性使用 - 相同方式共享 4.0 國際許可協議。

📚 引用信息

如果您覺得這個倉庫有幫助,請引用我們的出版物:

@inproceedings{babakov-etal-2021-detecting,

title = "Detecting Inappropriate Messages on Sensitive Topics that Could Harm a Company{'}s Reputation",

author = "Babakov, Nikolay and

Logacheva, Varvara and

Kozlova, Olga and

Semenov, Nikita and

Panchenko, Alexander",

booktitle = "Proceedings of the 8th Workshop on Balto-Slavic Natural Language Processing",

month = apr,

year = "2021",

address = "Kiyv, Ukraine",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2021.bsnlp-1.4",

pages = "26--36",

abstract = "Not all topics are equally {``}flammable{''} in terms of toxicity: a calm discussion of turtles or fishing less often fuels inappropriate toxic dialogues than a discussion of politics or sexual minorities. We define a set of sensitive topics that can yield inappropriate and toxic messages and describe the methodology of collecting and labelling a dataset for appropriateness. While toxicity in user-generated data is well-studied, we aim at defining a more fine-grained notion of inappropriateness. The core of inappropriateness is that it can harm the reputation of a speaker. This is different from toxicity in two respects: (i) inappropriateness is topic-related, and (ii) inappropriate message is not toxic but still unacceptable. We collect and release two datasets for Russian: a topic-labelled dataset and an appropriateness-labelled dataset. We also release pre-trained classification models trained on this data.",

}

📞 聯繫方式

如果您有任何問題,請聯繫 Nikolay

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語