🚀 クイックスタート

このモデルは、ロシア語の不適切なメッセージのデータセットを使用して訓練されています。主に、このモデルが検出する「不適切性」は毒性の代替ではなく、毒性の派生概念です。そのため、このモデルは、毒性と猥褻表現のフィルタリングの後に、不適切性の追加フィルタリングとして機能することができます。

✨ 主な機能

提案された使用方法

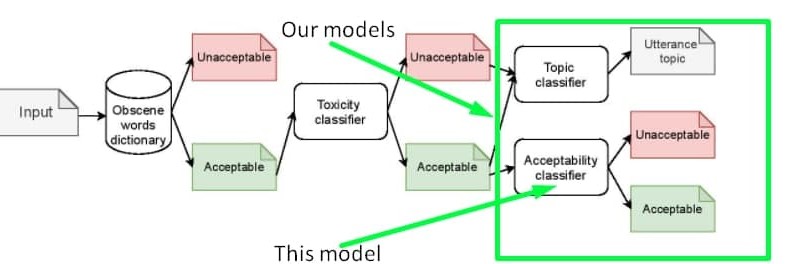

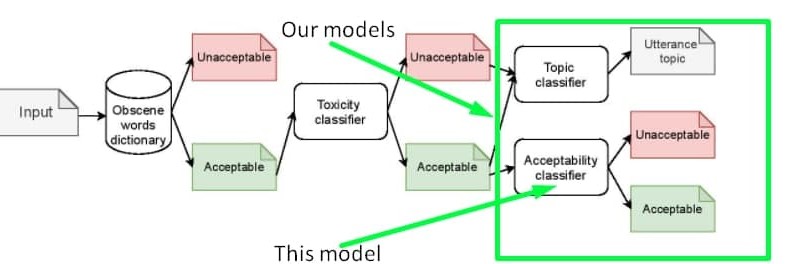

データセットに収集し、モデルで検出しようとした**「不適切性」**は、毒性の代替ではなく、むしろ毒性の派生概念です。したがって、このデータセットに基づくモデルは、毒性と猥褻表現のフィルタリングの後に、不適切性の追加フィルタリングとして機能することができます。正確な敏感なトピックを検出するには、別のモデルを使用できます。提案されたパイプラインは、以下の図に示されています。

また、毒性と不適切性の両方を検出するための1つの分類器を訓練することもできます。毒性ラベル付きのサンプルと混合するデータは、GitHubまたはkaggleで見つけることができます。

不適切性の直感

このモデルは、ロシア語の不適切なメッセージのデータセットを使用して訓練されています。一般的に、不適切な発話とは、猥褻な言葉や毒性のある意図がないものの、話者の評判を損なう可能性のある発話です。以下の表にいくつかのサンプルを示します。不適切性の概念について詳しくは、この記事を参照してください。この記事はEACL - 2021会議のBalto - Slavic NLPワークショップで発表されたものです。なお、この記事はデータセットの第1版を説明していますが、モデルは拡張版のデータセットで訓練されており、そのデータセットはGitHubまたはkaggleでオープンソース化されています。データセットの特性は記事で説明されているものと同じで、唯一の違いはサイズです。

| テキスト |

不適切 |

コメント |

危険なトピック |

| Ладно бы видного деятеля завалили а тут какого то ноунейм нигру преступника |

はい |

殺人の正当化 |

オフライン犯罪 |

| Это нарушение УКРФ! |

いいえ |

法律違反の非難 |

オフライン犯罪 |

| Религия - это насилие высшего уровня. Верующего принуждают к вере еще в младенчестве. |

はい |

信者の感情傷害 |

宗教 |

| Христиане, как вы относитесь к иноверцам, в частности к Гамалиилу и к уверовавшим в Иисуса фарисеям? |

いいえ |

信者への通常の質問で、感情傷害の意図はない |

宗教 |

| Хорошо что проституция запрещена |

いいえ |

売春の非難 |

売春 |

| Возьму бабки и сниму шлюх на выходных |

はい |

売春の普及 |

売春 |

メトリクス

モデルは、100%の信頼度を持つサンプルのみを使用して訓練、検証、およびテストされました。これにより、テストセットで以下のメトリクスが得られました。

|

適合率 |

再現率 |

F1スコア |

サポート |

| 0 |

0.92 |

0.93 |

0.93 |

7839 |

| 1 |

0.80 |

0.76 |

0.78 |

2726 |

| 正解率 |

|

|

0.89 |

10565 |

| マクロ平均 |

0.86 |

0.85 |

0.85 |

10565 |

| 加重平均 |

0.89 |

0.89 |

0.89 |

10565 |

📄 ライセンス

[Creative Commons Attribution - NonCommercial - ShareAlike 4.0 International License][cc - by - nc - sa]。

[![CC BY - NC - SA 4.0][cc - by - nc - sa - image]][cc - by - nc - sa]

[cc - by - nc - sa]: http://creativecommons.org/licenses/by - nc - sa/4.0/

[cc - by - nc - sa - image]: https://i.creativecommons.org/l/by - nc - sa/4.0/88x31.png

📚 ドキュメント

引用

このリポジトリが役立った場合は、以下の文献を引用してください。

@inproceedings{babakov-etal-2021-detecting,

title = "Detecting Inappropriate Messages on Sensitive Topics that Could Harm a Company{'}s Reputation",

author = "Babakov, Nikolay and

Logacheva, Varvara and

Kozlova, Olga and

Semenov, Nikita and

Panchenko, Alexander",

booktitle = "Proceedings of the 8th Workshop on Balto-Slavic Natural Language Processing",

month = apr,

year = "2021",

address = "Kiyv, Ukraine",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2021.bsnlp-1.4",

pages = "26--36",

abstract = "Not all topics are equally {``}flammable{''} in terms of toxicity: a calm discussion of turtles or fishing less often fuels inappropriate toxic dialogues than a discussion of politics or sexual minorities. We define a set of sensitive topics that can yield inappropriate and toxic messages and describe the methodology of collecting and labelling a dataset for appropriateness. While toxicity in user-generated data is well-studied, we aim at defining a more fine-grained notion of inappropriateness. The core of inappropriateness is that it can harm the reputation of a speaker. This is different from toxicity in two respects: (i) inappropriateness is topic-related, and (ii) inappropriate message is not toxic but still unacceptable. We collect and release two datasets for Russian: a topic-labelled dataset and an appropriateness-labelled dataset. We also release pre-trained classification models trained on this data.",

}

連絡先

質問がある場合は、Nikolayまでご連絡ください。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語