🚀 WizardLM-2-7B-abliterated

このモデルは、@failspyによる実装に基づいた、直交化されたbfloat16 safetensorの重みを持つWizardLM-2-7Bモデルです。詳細については以下を参照してください。

📦 GGUFファイル

GGUFファイルをここにアップロードします: https://huggingface.co/fearlessdots/WizardLM-2-7B-abliterated-GGUF

📝 プロンプトテンプレート

このモデルはVicunaのプロンプト形式を使用し、マルチターン会話をサポートしています。

オリジナルのモデルカード:

🏠 WizardLM-2リリースブログ

🤗 HFリポジトリ •🐱 GitHubリポジトリ • 🐦 Twitter • 📃 [WizardLM] • 📃 [WizardCoder] • 📃 [WizardMath]

👋 Discordに参加しましょう

🗞️ ニュース 🔥🔥🔥 [2024/04/15]

我々は、次世代の最先端大規模言語モデルであるWizardLM-2を導入し、オープンソース化しました。このモデルは、複雑なチャット、多言語、推論、エージェントなどの性能が向上しています。新しいモデルファミリーには、3つの最先端モデルが含まれています。

- WizardLM-2 8x22B: 我々の最も高度なモデルで、主要なプロプライエタリモデルと比較しても非常に競争力のある性能を示し、既存の最先端オープンソースモデルを一貫して上回ります。

- WizardLM-2 70B: トップレベルの推論能力を持ち、同サイズのモデルの中では第一選択です。

- WizardLM-2 7B: 最も高速で、既存の10倍大きいオープンソースの主要モデルと同等の性能を達成します。

WizardLM-2の詳細については、リリースブログ記事と今後公開される論文をご覧ください。

📚 モデル詳細

💪 モデルの能力

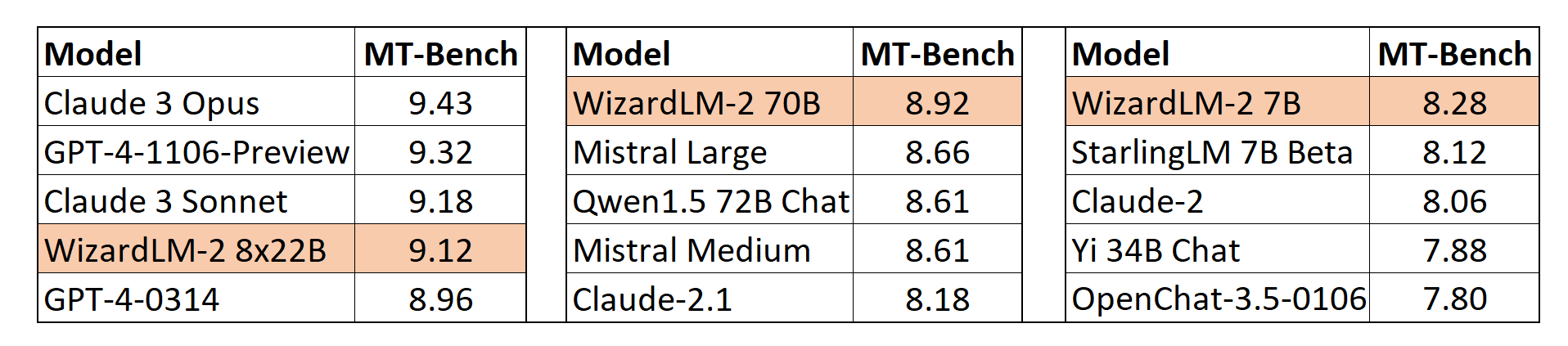

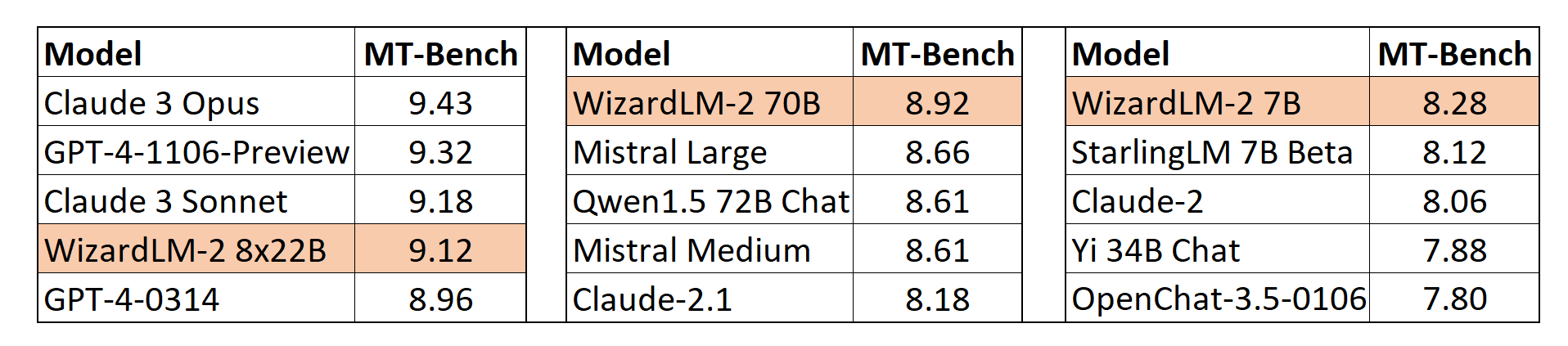

MT-Bench

我々は、lmsysによって提案されたGPT-4ベースの自動MT-Bench評価フレームワークを採用して、モデルの性能を評価しています。WizardLM-2 8x22Bは、最も高度なプロプライエタリモデルと比較しても非常に競争力のある性能を示します。また、WizardLM-2 7BとWizardLM-2 70Bは、7Bから70Bのモデル規模の他の主要ベースラインの中でもトップクラスの性能を発揮しています。

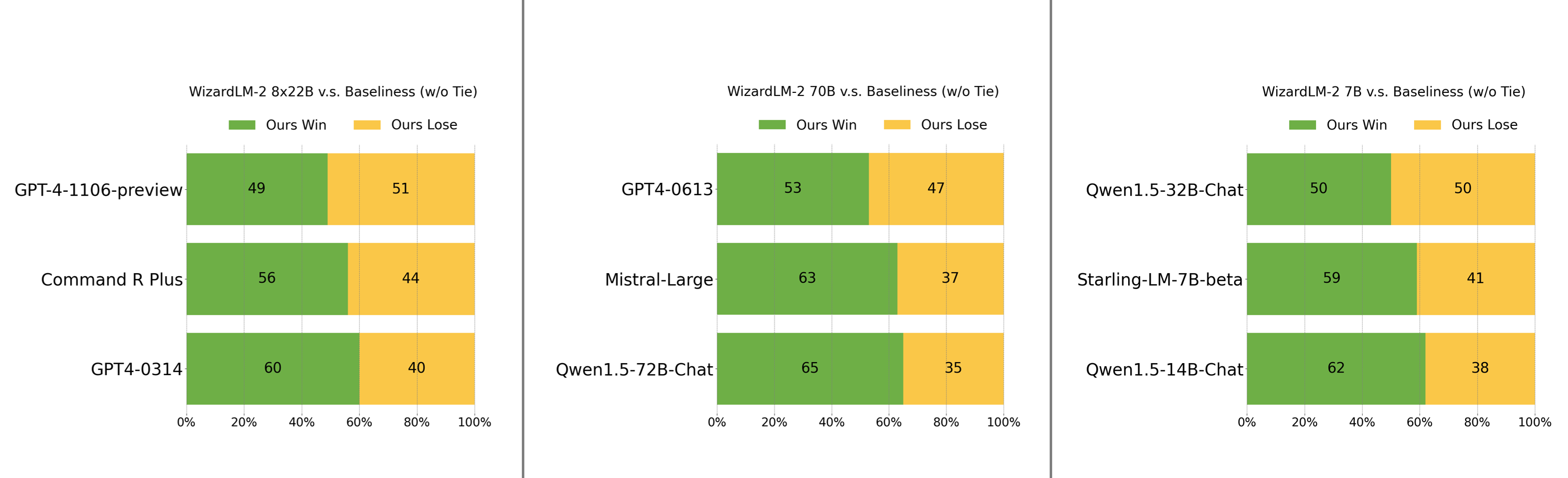

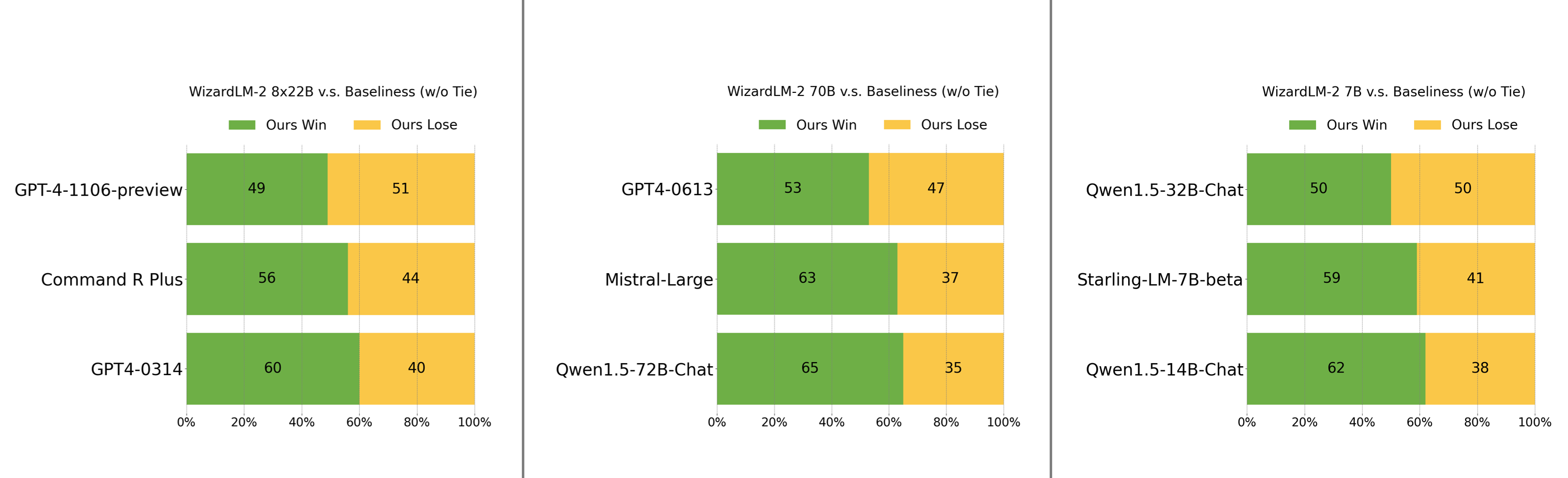

人間の嗜好評価

我々は、実世界の命令から構成される複雑で挑戦的なセットを慎重に収集しました。これには、文章作成、コーディング、数学、推論、エージェント、多言語など、人間の主要な要求が含まれています。勝敗率(引き分けを除く)を報告します。

- WizardLM-2 8x22Bは、GPT-4-1106-previewに僅かに劣り、Command R PlusやGPT4-0314よりも大幅に強力です。

- WizardLM-2 70Bは、GPT4-0613、Mistral-Large、Qwen1.5-72B-Chatよりも優れています。

- WizardLM-2 7Bは、Qwen1.5-32B-Chatと同等で、Qwen1.5-14B-ChatやStarling-LM-7B-betaを上回っています。

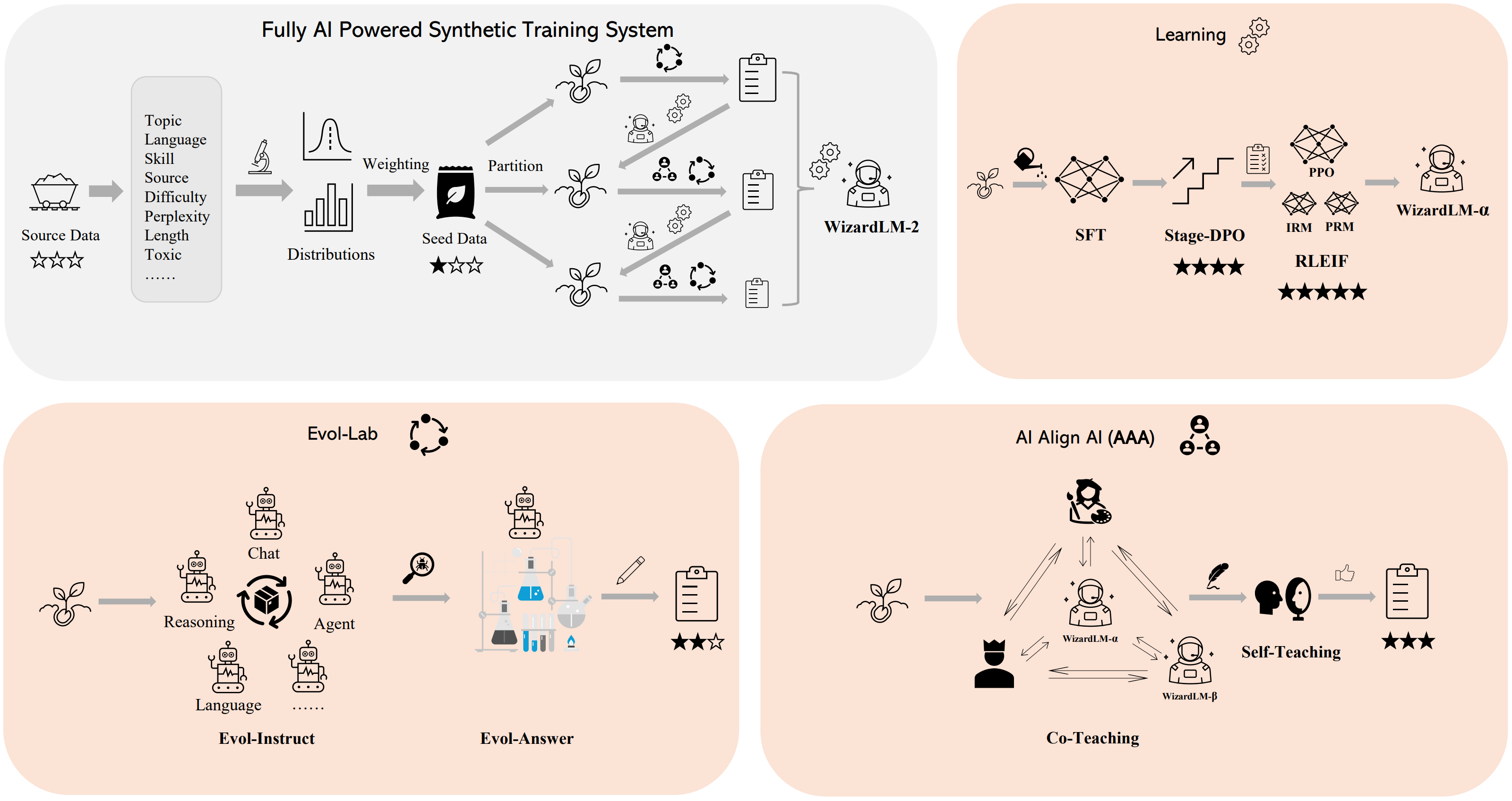

🛠️ 方法論の概要

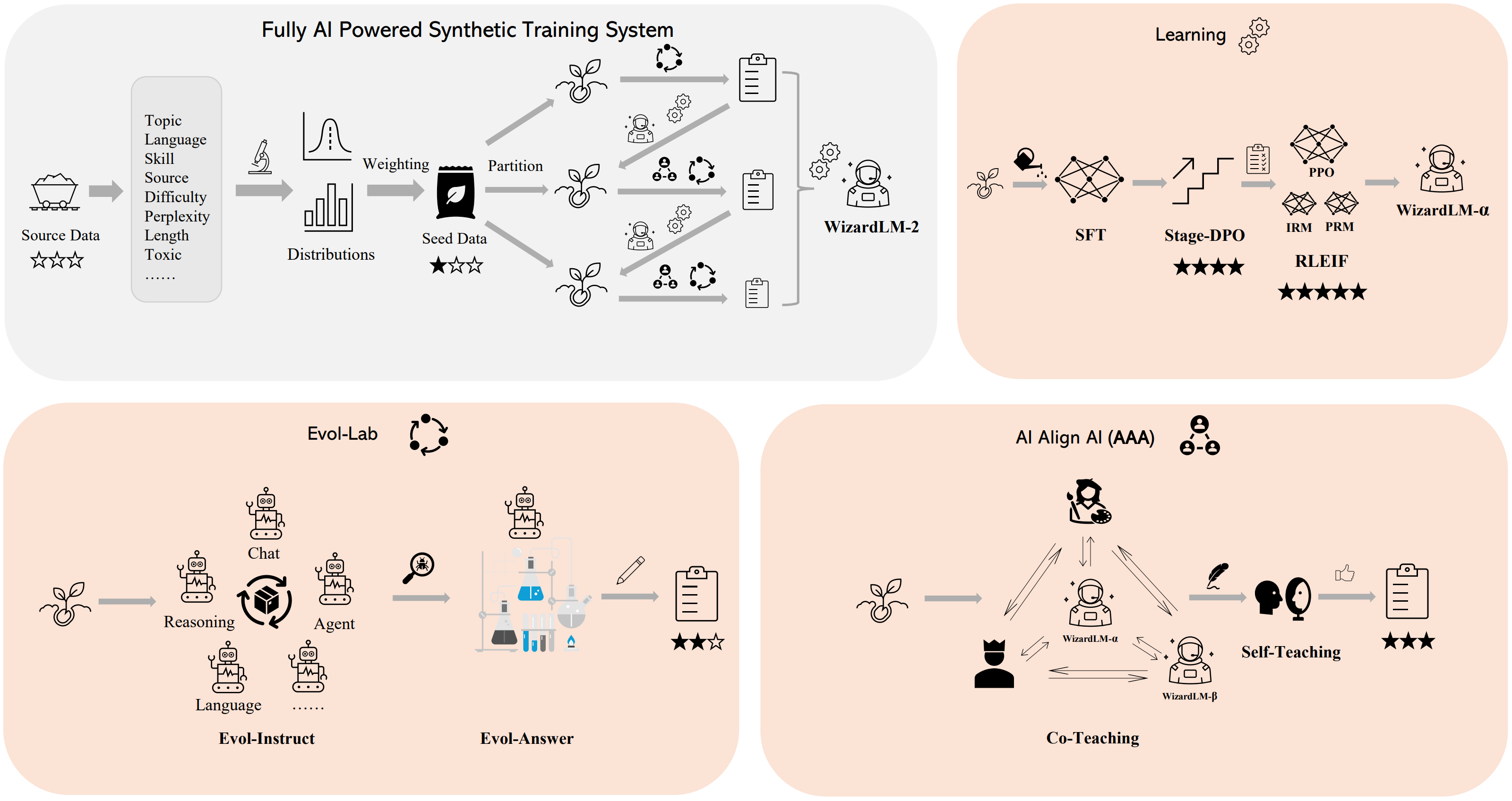

我々は、WizardLM-2モデルを訓練するために、完全にAI駆動の合成訓練システムを構築しました。このシステムの詳細については、ブログを参照してください。

💻 使用例

基本的な使用法

⚠️ 重要提示

このモデルのシステムプロンプトの使用に関する注意事項です。

WizardLM-2はVicunaのプロンプト形式を採用し、マルチターン会話をサポートしています。プロンプトは以下のようにする必要があります。

A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful,

detailed, and polite answers to the user's questions. USER: Hi ASSISTANT: Hello.</s>

USER: Who are you? ASSISTANT: I am WizardLM.</s>......

高度な使用法

我々は、GitHub上にWizardLM-2の推論デモコードを提供しています。

📄 ライセンス

このモデルはApache2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語