🚀 WizardLM-2-7B-abliterated

这是基于 @failspy 实现的、具有正交化bfloat16 safetensor权重的 WizardLM-2-7B 模型。更多信息如下:

📦 GGUF文件

我将在此处上传一些GGUF文件:https://huggingface.co/fearlessdots/WizardLM-2-7B-abliterated-GGUF

💬 提示模板

此模型使用 Vicuna 的提示格式,并支持 多轮 对话。

原始模型卡片:

🏠 WizardLM-2发布博客

🤗 HF仓库 •🐱 Github仓库 • 🐦 Twitter • 📃 [WizardLM] • 📃 [WizardCoder] • 📃 [WizardMath]

👋 加入我们的 Discord

🗞️ 新闻 🔥🔥🔥 [2024/04/15]

我们推出并开源了下一代最先进的大语言模型WizardLM-2,它在复杂对话、多语言、推理和智能体等方面的性能有所提升。新系列包括三款前沿模型:WizardLM-2 8x22B、WizardLM-2 70B和WizardLM-2 7B。

- WizardLM-2 8x22B是我们最先进的模型,与领先的专有模型相比表现出极具竞争力的性能,并且始终优于所有现有的最先进开源模型。

- WizardLM-2 70B达到了顶级推理能力,是相同规模下的首选。

- WizardLM-2 7B是最快的模型,并且与现有规模大10倍的开源领先模型取得了相当的性能。

有关WizardLM-2的更多详细信息,请阅读我们的 发布博客文章 和即将发表的论文。

📋 模型详情

💪 模型能力

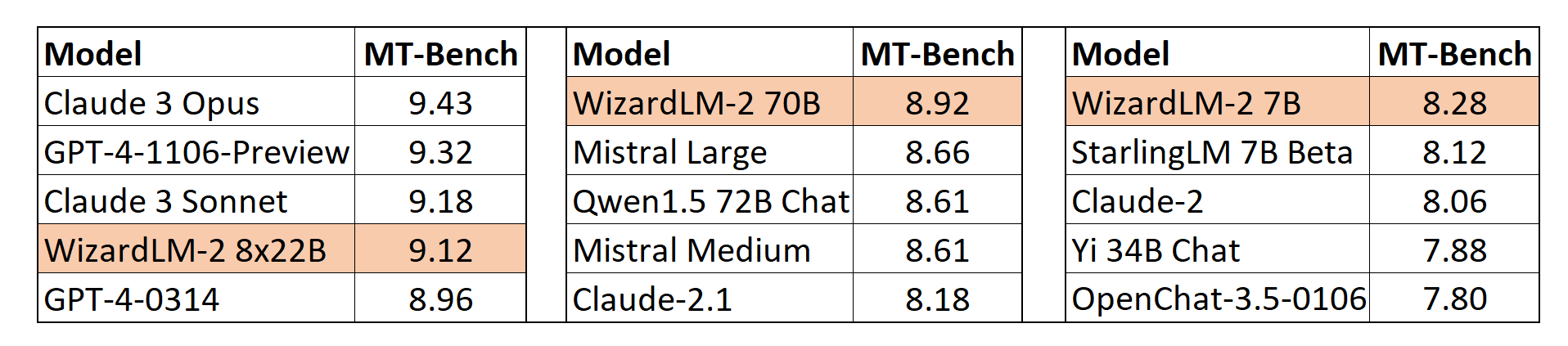

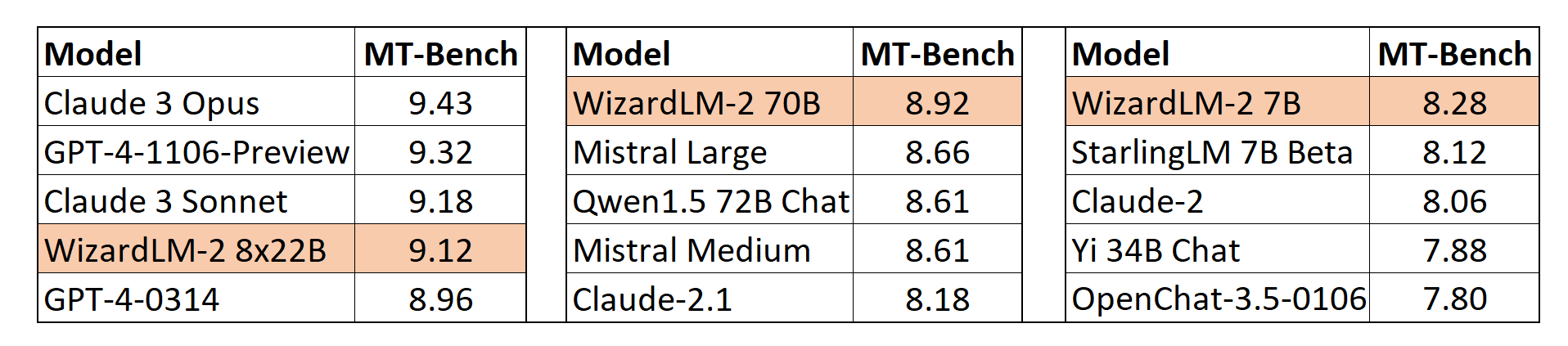

MT-Bench

我们还采用了lmsys提出的基于GPT-4的自动MT-Bench评估框架来评估模型性能。WizardLM-2 8x22B与最先进的专有模型相比,甚至表现出极具竞争力的性能。同时,WizardLM-2 7B和WizardLM-2 70B在7B到70B模型规模的其他领先基线模型中均为表现最佳的模型。

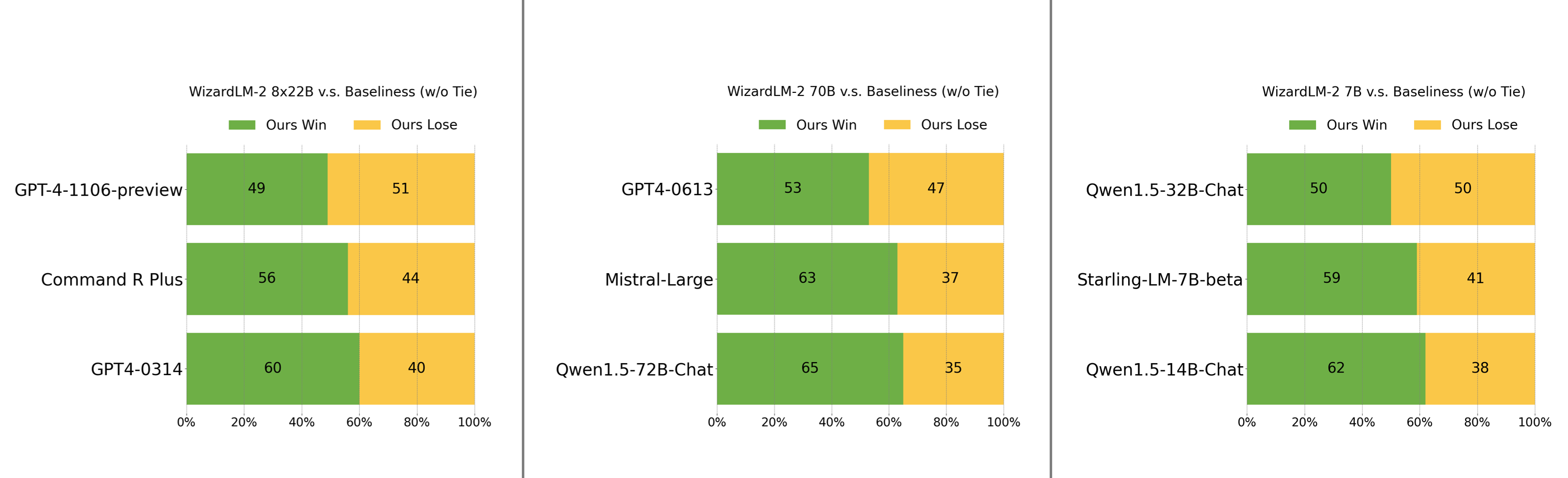

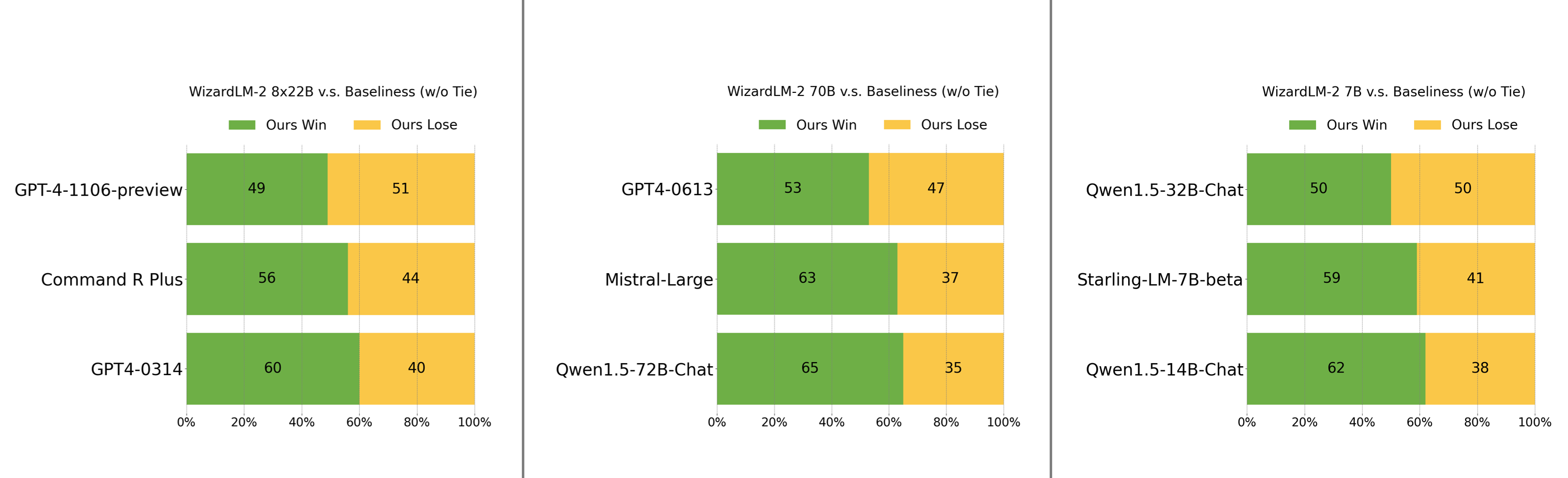

人工偏好评估

我们精心收集了一组复杂且具有挑战性的真实世界指令集,其中包括人类的主要需求,如写作、编码、数学、推理、智能体和多语言。我们报告了无平局的胜负率:

- WizardLM-2 8x22B仅略逊于GPT-4-1106-preview,并且明显强于Command R Plus和GPT4-0314。

- WizardLM-2 70B优于GPT4-0613、Mistral-Large和Qwen1.5-72B-Chat。

- WizardLM-2 7B与Qwen1.5-32B-Chat相当,并且超越了Qwen1.5-14B-Chat和Starling-LM-7B-beta。

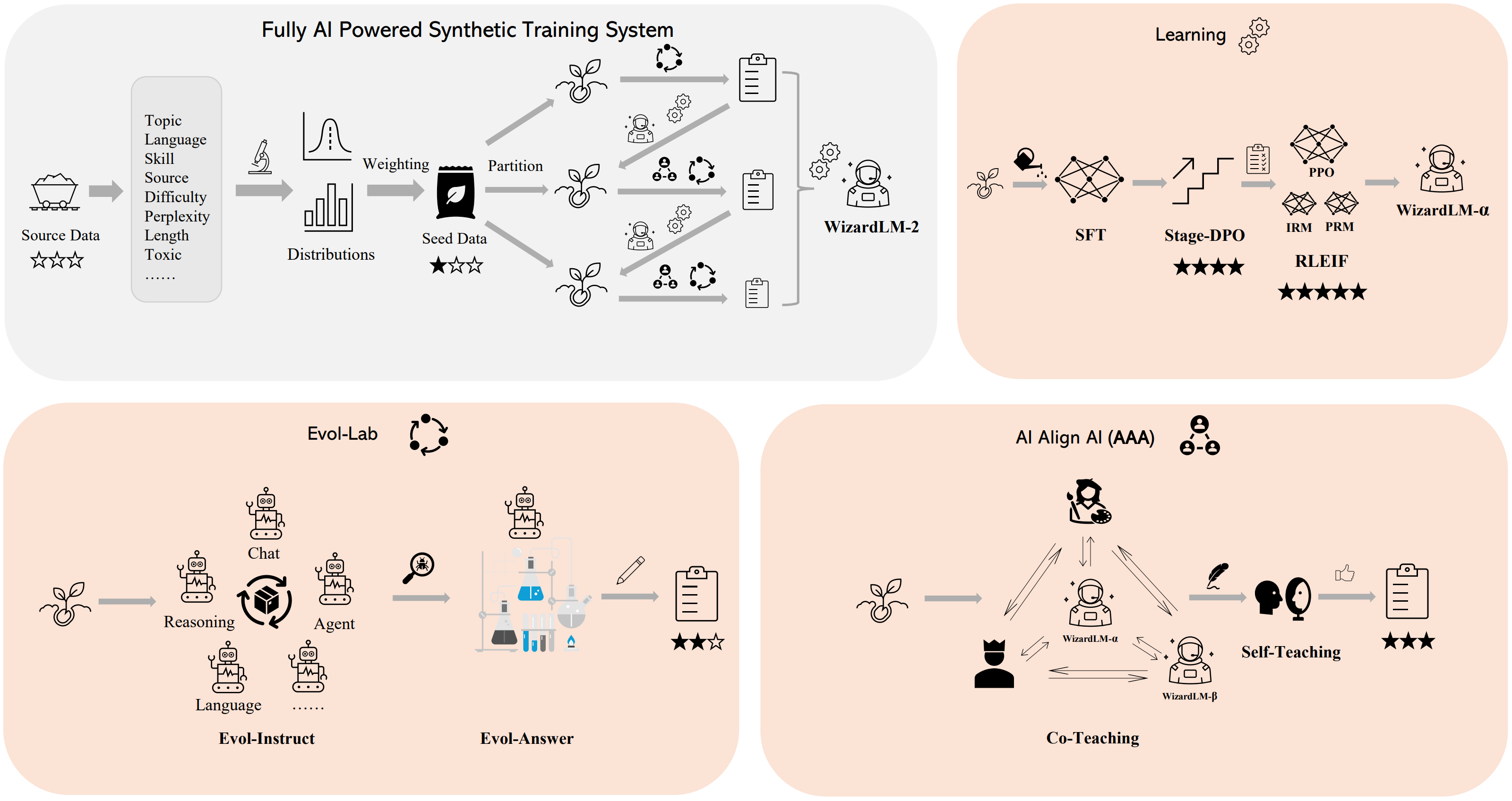

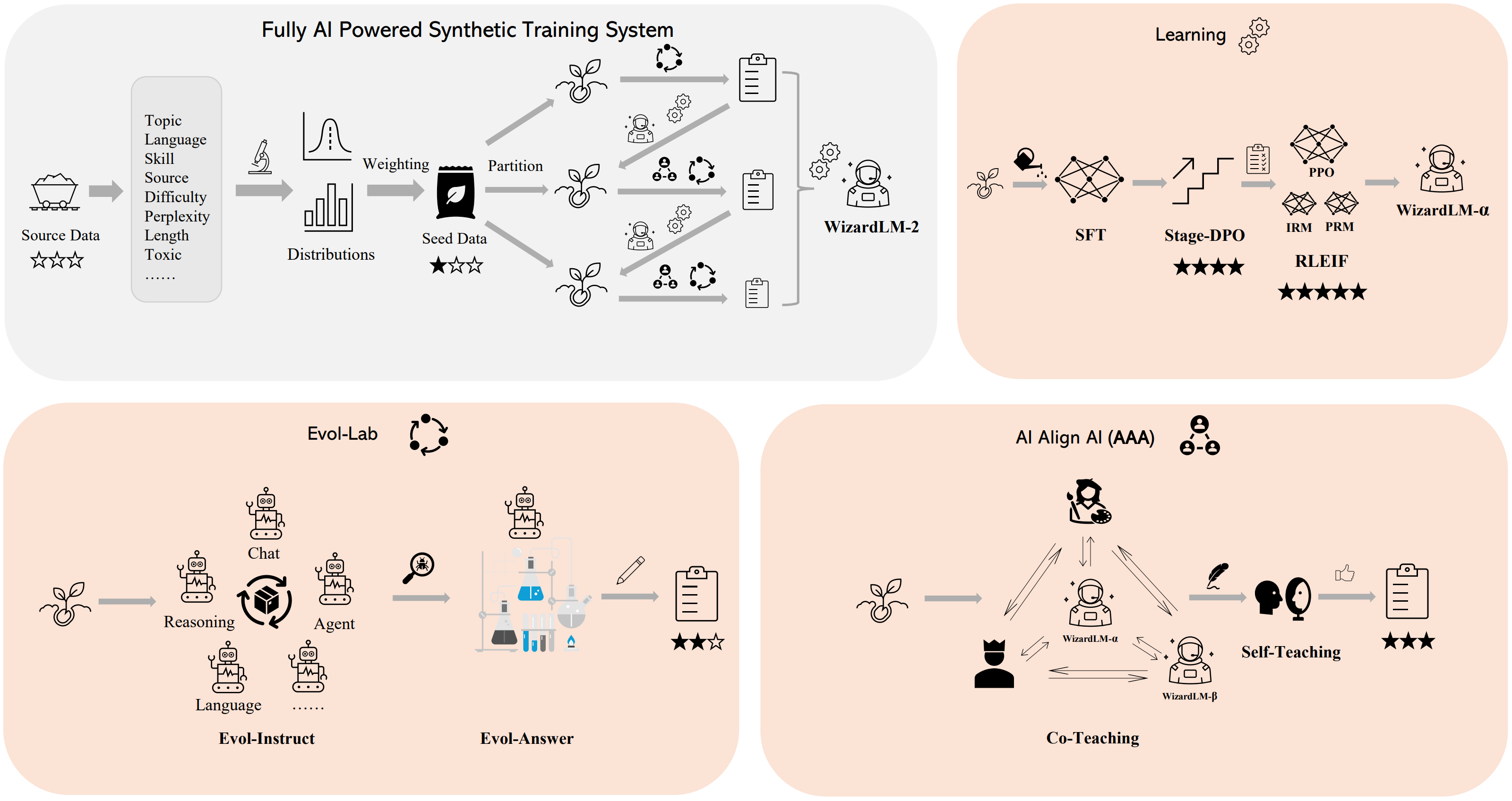

🛠️ 方法概述

我们构建了一个 全AI驱动的合成训练系统 来训练WizardLM-2模型,有关该系统的更多详细信息,请参考我们的 博客。

💻 使用方法

⚠️ 重要提示

WizardLM-2 采用 Vicuna 的提示格式,并支持 多轮 对话。提示应如下所示:

A chat between a curious user and an artificial intelligence assistant. The assistant gives helpful,

detailed, and polite answers to the user's questions. USER: Hi ASSISTANT: Hello.</s>

USER: Who are you? ASSISTANT: I am WizardLM.</s>......

推理WizardLM-2演示脚本

我们在github上提供了一个WizardLM-2推理演示 代码。

📄 许可证

本项目采用Apache-2.0许可证。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语