🚀 燃灯-T5-784M-QA-中文

このモデルは中国語の質問応答に特化したT5モデルで、文章と質問を入力することで、流暢で正確な回答を生成することができます。

🚀 クイックスタート

このモデルは、huggingface上で初めて公開された中国語の生成式質問応答モデルです。T5-Large構造に基づき、悟道180Gコーパスを使用して封神フレームワークで事前学習され、翻訳された中国語のSQuADとCMRC2018の2つの読解データセットで微調整されています。

✨ 主な機能

- 高品質な回答生成: 76%の回答が正解を含んでおり、RougeLとBLEU-4の値が高いことから、生成結果と正解の重複度が高いことがわかります。

- 柔軟な回答形式: 完全な文章を生成することができるため、回答の形式が柔軟です。

📦 インストール

pip install transformers==4.21.1

💻 使用例

基本的な使用法

import numpy as np

from transformers import T5Tokenizer,MT5ForConditionalGeneration

pretrain_path = 'IDEA-CCNL/Randeng-T5-784M-QA-Chinese'

tokenizer=T5Tokenizer.from_pretrained(pretrain_path)

model=MT5ForConditionalGeneration.from_pretrained(pretrain_path)

sample={"context":"在柏林,胡格诺派教徒创建了两个新的社区:多罗西恩斯塔特和弗里德里希斯塔特。到1700年,这个城市五分之一的人口讲法语。柏林胡格诺派在他们的教堂服务中保留了将近一个世纪的法语。他们最终决定改用德语,以抗议1806-1807年拿破仑占领普鲁士。他们的许多后代都有显赫的地位。成立了几个教会,如弗雷德里夏(丹麦)、柏林、斯德哥尔摩、汉堡、法兰克福、赫尔辛基和埃姆登的教会。","question":"除了多罗西恩斯塔特,柏林还有哪个新的社区?","idx":1}

plain_text='question:'+sample['question']+'knowledge:'+sample['context'][:self.max_knowledge_length]

res_prefix=tokenizer.encode('answer',add_special_tokens=False)

res_prefix.append(tokenizer.convert_tokens_to_ids('<extra_id_0>'))

res_prefix.append(tokenizer.eos_token_id)

l_rp=len(res_prefix)

tokenized=tokenizer.encode(plain_text,add_special_tokens=False,truncation=True,max_length=1024-2-l_rp)

tokenized+=res_prefix

batch=[tokenized]*2

input_ids=torch.tensor(np.array(batch),dtype=torch.long)

max_target_length=128

pred_ids = model.generate(input_ids=input_ids,max_new_tokens=max_target_length,do_sample=True,top_p=0.9)

pred_tokens=tokenizer.batch_decode(pred_ids, skip_special_tokens=True, clean_up_tokenization_spaces=False)[0]

res=pred_tokens.replace('<extra_id_0>','').replace('有答案:','')

📚 ドキュメント

モデルカテゴリ

| 属性 |

详情 |

| モデルタイプ |

通用 - 自然言語変換 - 燃灯 - T5 |

| パラメータ |

784M |

| 追加情報 |

中国語生成式質問応答 |

モデル性能

CMRC 2018の開発セットでの性能(元のタスクは開始と終了の予測問題ですが、ここでは生成応答の問題として扱っています)

| モデル |

回答包含率 |

RougeL |

BLEU-4 |

F1 |

EM |

| 当モデル |

76.0 |

82.7 |

61.1 |

77.9 |

57.1 |

| MacBERT-Large(SOTA) |

- |

- |

- |

88.9 |

70.0 |

当モデルは生成品質と精度が非常に高く、生成された回答の76%が正解を含んでいます。RougeLとBLEU-4の値が高いことから、生成結果と正解の重複度が高いことがわかります。当モデルのEM値が低いのは、生成されるのが大部分が完全な文章であるのに対し、正解は通常文章の断片であるためです。

P.S. SOTAモデルは抽出型のMRCタスクとして開始と終了タグのみを予測します。

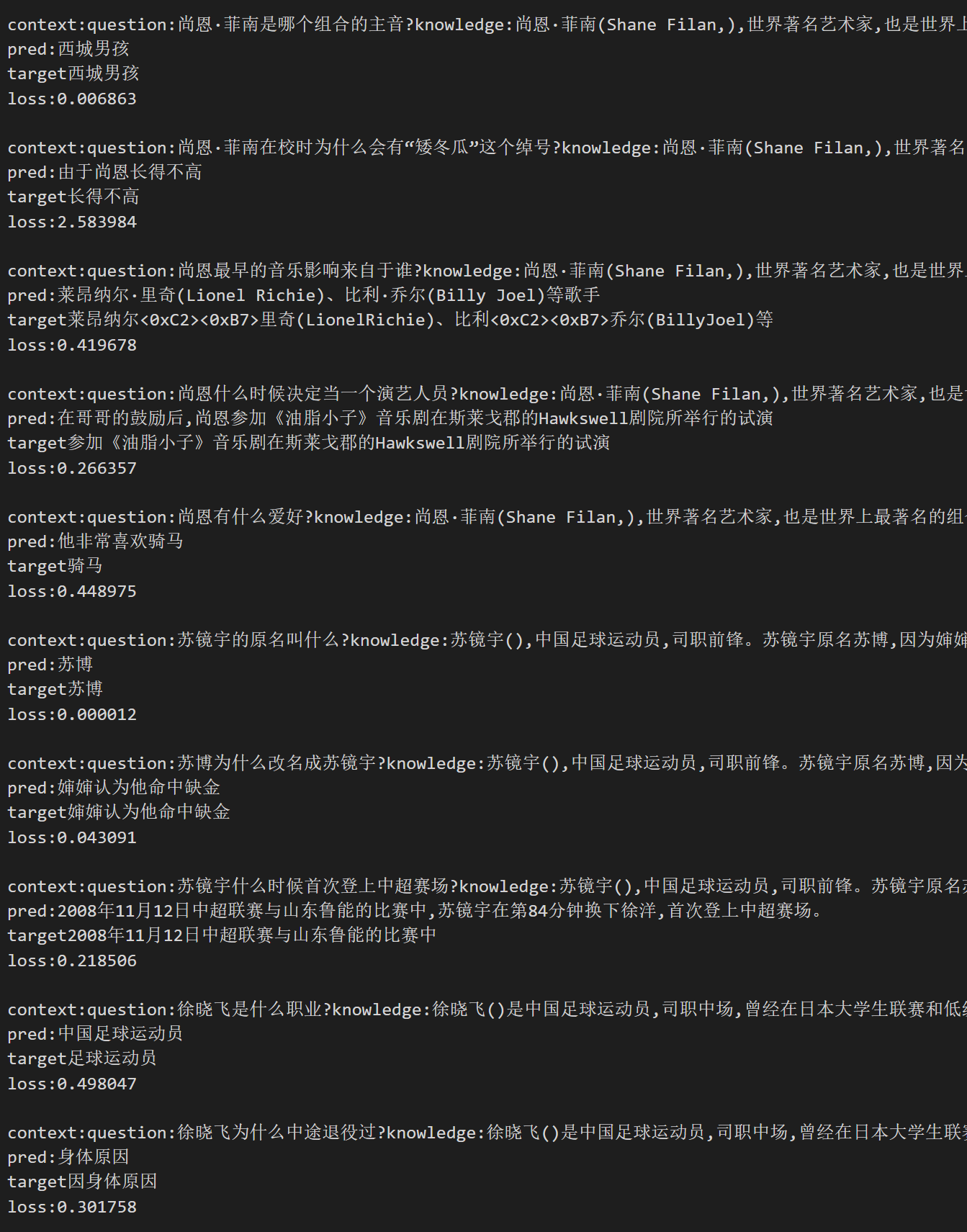

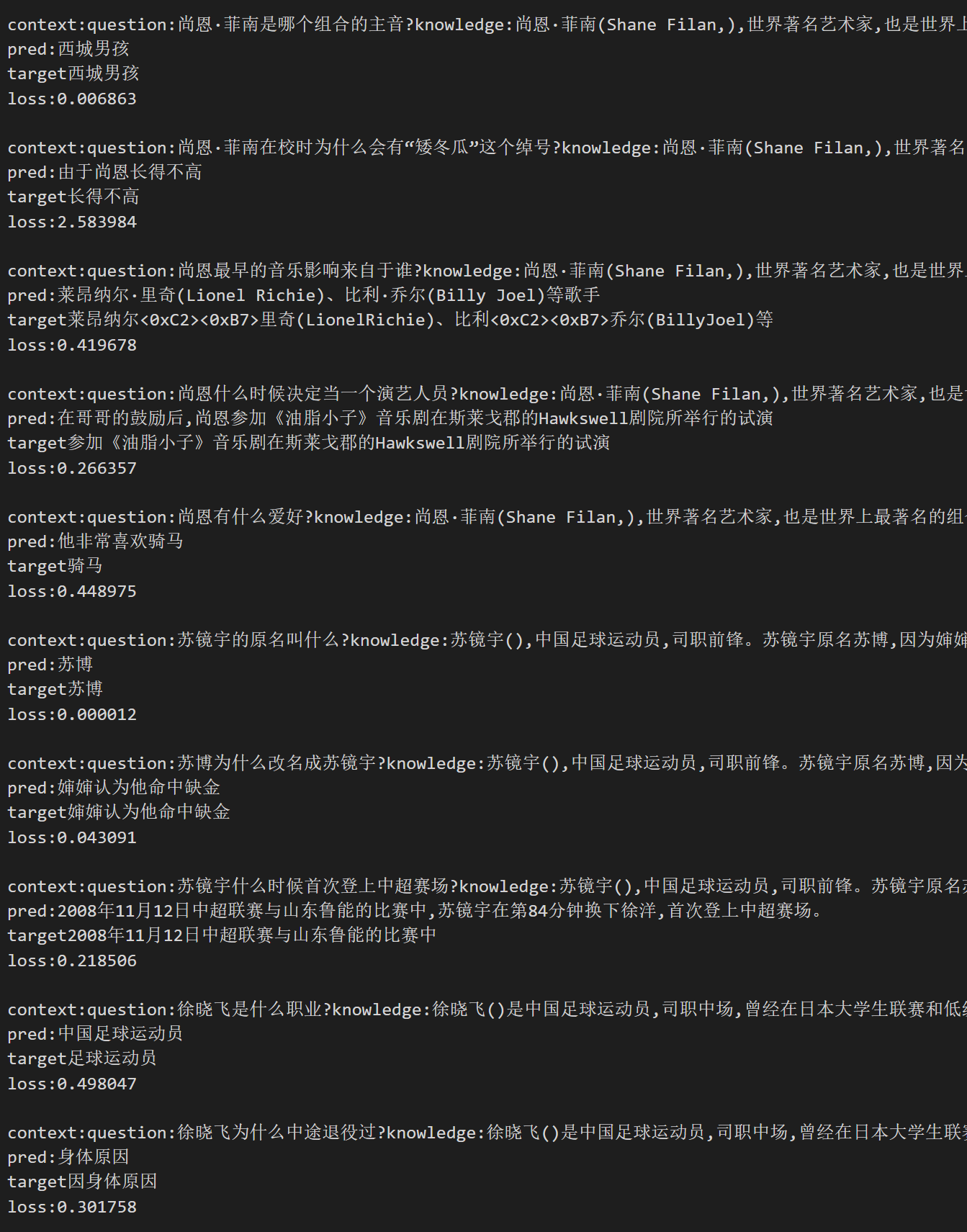

サンプル

以下はランダムに選ばれたサンプルです。

pred: 画像内の生成結果、target: 正解を示します。

画像が表示されない場合は、「ファイルとバージョン」で画像を見つけることができます。

📄 ライセンス

このモデルはApache-2.0ライセンスの下で公開されています。

📖 引用

もしあなたの研究や開発でこのモデルを使用した場合は、以下の論文を引用してください。

@article{fengshenbang,

author = {Jiaxing Zhang and Ruyi Gan and Junjie Wang and Yuxiang Zhang and Lin Zhang and Ping Yang and Xinyu Gao and Ziwei Wu and Xiaoqun Dong and Junqing He and Jianheng Zhuo and Qi Yang and Yongfeng Huang and Xiayu Li and Yanghan Wu and Junyu Lu and Xinyu Zhu and Weifeng Chen and Ting Han and Kunhao Pan and Rui Wang and Hao Wang and Xiaojun Wu and Zhongshen Zeng and Chongpei Chen},

title = {Fengshenbang 1.0: Being the Foundation of Chinese Cognitive Intelligence},

journal = {CoRR},

volume = {abs/2209.02970},

year = {2022}

}

また、以下のウェブサイトも引用することができます。

@misc{Fengshenbang-LM,

title={Fengshenbang-LM},

author={IDEA-CCNL},

year={2021},

howpublished={\url{https://github.com/IDEA-CCNL/Fengshenbang-LM}},

}

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語