Kominilm

K

Kominilm

由 BM-K 开发

KoMiniLM是一个轻量级韩语语言模型,旨在解决大型语言模型在实际应用中的延迟和容量限制问题。

下载量 244

发布时间 : 5/23/2022

模型简介

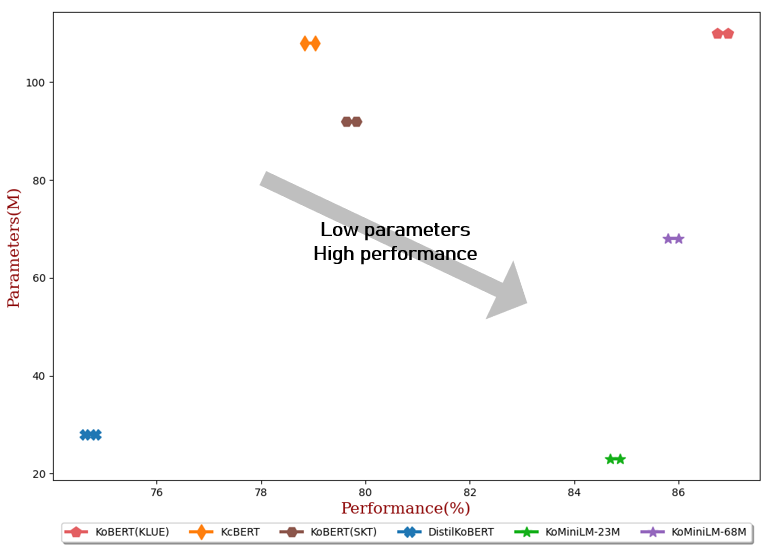

KoMiniLM是一个轻量级的韩语语言模型,通过蒸馏技术从教师模型KLUE-BERT中提取知识,适用于多种韩语自然语言处理任务。

模型特点

轻量级设计

模型参数规模小(23M/68M),适合在资源有限的环境中部署和使用。

知识蒸馏

通过自注意力分布和自注意力值关系从KLUE-BERT教师模型中蒸馏知识,提升模型性能。

多任务支持

在多种韩语NLP任务上表现优异,包括情感分析、命名实体识别、问答等。

模型能力

文本分类

命名实体识别

问答系统

文本相似度计算

情感分析

使用案例

情感分析

电影评论情感分析

使用NSMC数据集进行电影评论的情感分析。

准确率89.67±0.03 (23M模型)

命名实体识别

Naver NER任务

在Naver NLP挑战赛2018的NER任务上进行测试。

F1分数84.79±0.09 (23M模型)

问答系统

KorQuAD问答

在韩语问答数据集KorQuAD上进行测试。

EM/F1分数82.11±0.42 / 91.21±0.29 (23M模型)

精选推荐AI模型

Llama 3 Typhoon V1.5x 8b Instruct

专为泰语设计的80亿参数指令模型,性能媲美GPT-3.5-turbo,优化了应用场景、检索增强生成、受限生成和推理任务

大型语言模型 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-Tiny是一个基于SODA数据集训练的超小型对话模型,专为边缘设备推理设计,体积仅为Cosmo-3B模型的2%左右。

对话系统 Transformers 英语

Transformers 英语

Transformers 英语

Transformers 英语C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

基于RoBERTa架构的中文抽取式问答模型,适用于从给定文本中提取答案的任务。

问答系统 中文

R

uer

2,694

98