Kominilm

K

Kominilm

BM-Kによって開発

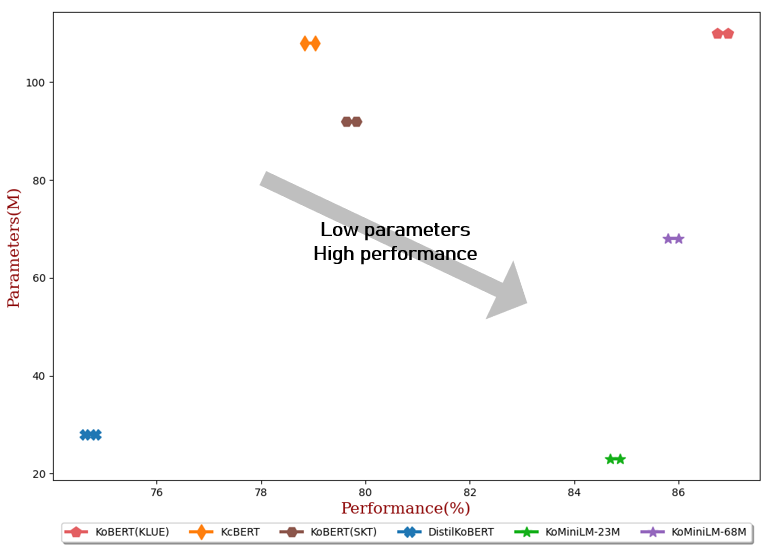

KoMiniLMは軽量な韓国語言語モデルで、大規模言語モデルの実際のアプリケーションにおける遅延と容量制限の問題を解決することを目的としています。

ダウンロード数 244

リリース時間 : 5/23/2022

モデル概要

KoMiniLMは軽量な韓国語言語モデルで、蒸留技術を用いて教師モデルKLUE-BERTから知識を抽出し、さまざまな韓国語自然言語処理タスクに適しています。

モデル特徴

軽量設計

モデルパラメータサイズが小さい(23M/68M)、リソースが限られた環境での展開と使用に適しています。

知識蒸留

自己注意分布と自己注意値関係を通じてKLUE-BERT教師モデルから知識を蒸留し、モデル性能を向上させます。

マルチタスクサポート

感情分析、固有表現認識、質問応答など、さまざまな韓国語NLPタスクで優れたパフォーマンスを発揮します。

モデル能力

テキスト分類

固有表現認識

質問応答システム

テキスト類似度計算

感情分析

使用事例

感情分析

映画レビュー感情分析

NSMCデータセットを使用して映画レビューの感情分析を行います。

精度89.67±0.03 (23Mモデル)

固有表現認識

Naver NERタスク

Naver NLPチャレンジ2018のNERタスクでテストを行います。

F1スコア84.79±0.09 (23Mモデル)

質問応答システム

KorQuAD質問応答

韓国語質問応答データセットKorQuADでテストを行います。

EM/F1スコア82.11±0.42 / 91.21±0.29 (23Mモデル)

おすすめAIモデル

Llama 3 Typhoon V1.5x 8b Instruct

タイ語専用に設計された80億パラメータの命令モデルで、GPT-3.5-turboに匹敵する性能を持ち、アプリケーションシナリオ、検索拡張生成、制限付き生成、推論タスクを最適化

大規模言語モデル Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-TinyはSODAデータセットでトレーニングされた超小型対話モデルで、エッジデバイス推論向けに設計されており、体積はCosmo-3Bモデルの約2%です。

対話システム Transformers 英語

Transformers 英語

Transformers 英語

Transformers 英語C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

RoBERTaアーキテクチャに基づく中国語抽出型QAモデルで、与えられたテキストから回答を抽出するタスクに適しています。

質問応答システム 中国語

R

uer

2,694

98