🚀 Stable Diffusion TrinArt/Trin-sama AI finetune v2

这是一个基于Stable Diffusion的模型,通过约40,000张各类高分辨率漫画/动漫风格图片进行了8个轮次的微调。它保留了原始Stable Diffusion的美学风格,同时向动漫/漫画风格微调。

🚀 快速开始

注意事项

本模型并非TrinArt上拥有1920万张图像的角色模型,而是原始Trin-sama Twitter机器人模型的改进版本。该模型旨在尽可能保留原始Stable Diffusion的美学风格,同时将模型向动漫/漫画风格引导。

其他TrinArt模型可在以下链接找到:

Diffusers

该模型已由 ayan4m1 移植到 diffusers,可以从以下分支轻松运行:

revision="diffusers-60k":训练了60,000步的检查点。revision="diffusers-95k":训练了95,000步的检查点。revision="diffusers-115k":训练了115,000步的检查点。

更多信息,请查看 “三种风格” 部分。

Gradio

我们还支持在Colab笔记本中使用 Gradio 网页界面与diffusers一起运行:

💻 使用示例

基础用法

文本到图像示例

from diffusers import StableDiffusionPipeline

pipe = StableDiffusionPipeline.from_pretrained("naclbit/trinart_stable_diffusion_v2", revision="diffusers-60k")

pipe.to("cuda")

image = pipe("A magical dragon flying in front of the Himalaya in manga style").images[0]

image

如果您想更快地运行管道或在不同的硬件上运行,请查看 优化文档。

图像到图像示例

from diffusers import StableDiffusionImg2ImgPipeline

import requests

from PIL import Image

from io import BytesIO

url = "https://scitechdaily.com/images/Dog-Park.jpg"

response = requests.get(url)

init_image = Image.open(BytesIO(response.content)).convert("RGB")

init_image = init_image.resize((768, 512))

pipe = StableDiffusionImg2ImgPipeline.from_pretrained("naclbit/trinart_stable_diffusion_v2", revision="diffusers-115k")

pipe.to("cuda")

images = pipe(prompt="Manga drawing of Brad Pitt", init_image=init_image, strength=0.75, guidance_scale=7.5).images

image

如果您想更快地运行管道或在不同的硬件上运行,请查看 优化文档。

📚 详细文档

版本2说明

V2检查点使用了丢弃法(dropouts),增加了10,000张图像,并采用了新的标签策略,经过更长时间的训练,旨在保留原始美学风格的同时改善结果。

三种风格

训练到115,000步/95,000步的检查点经过了进一步训练,但如果您觉得风格调整过度,可以使用训练到60,000步的检查点。

图像到图像

如果您想使用此模型运行 latent-diffusion 的库存ddim图像到图像脚本,必须将 use_ema 设置为 False。

硬件要求

训练信息

- 自定义数据集加载器,带有增强操作:水平翻转、中心裁剪和锁定宽高比的缩放。

- 学习率(LR):1.0e-5

- 10%的丢弃率

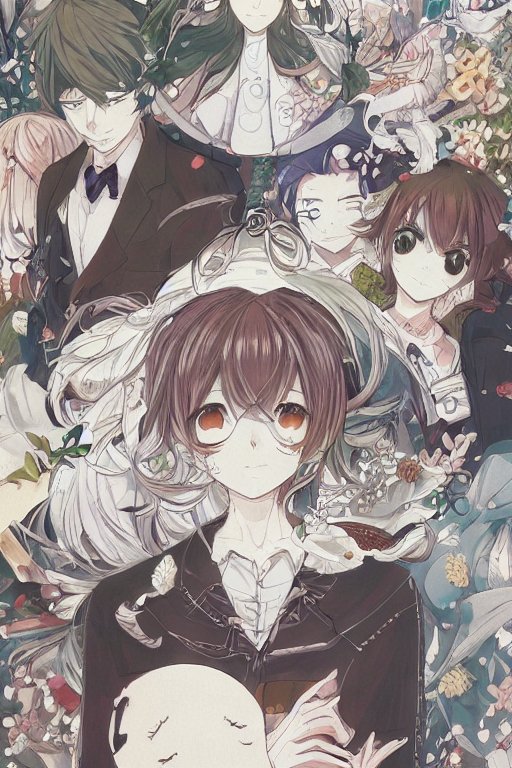

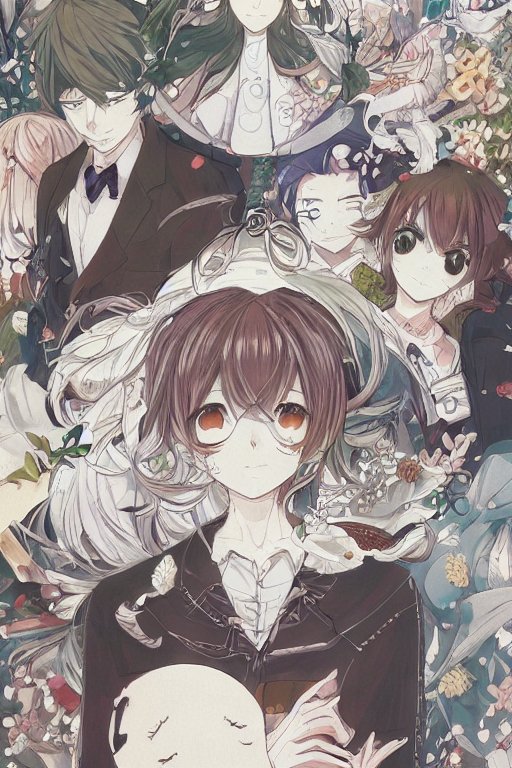

示例

每张图像均使用K. Crowson的k-lms(来自k-diffusion仓库)方法进行了50步扩散。

致谢

- Sta, AI小说家开发者 (https://ai-novel.com/) @ Bit192, Inc.

- Stable Diffusion - Rombach, Robin and Blattmann, Andreas and Lorenz, Dominik and Esser, Patrick and Ommer, Bjorn

📄 许可证

CreativeML OpenRAIL-M

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语