🚀 Stable Diffusion TrinArt/Trin-sama AI finetune v2

このモデルは、約4万枚の様々な高解像度のマンガ/アニメスタイルの画像を使って8エポック間ファインチューニングされたStable Diffusionモデルです。Twitterボット@trinsama (https://twitter.com/trinsama) でも使用されている同じモデルです。

🚀 クイックスタート

注意事項

このモデルはTrinArtの1920万枚画像のキャラクターモデルではなく、元のTrin-sama Twitterボットモデルの改良版です。このモデルは、元のStable Diffusionの美学をできるだけ維持しながら、モデルをアニメ/マンガスタイルに近づけることを目的としています。

他のTrinArtモデルは以下のリンクから見ることができます。

- https://huggingface.co/naclbit/trinart_derrida_characters_v2_stable_diffusion

- https://huggingface.co/naclbit/trinart_characters_19.2m_stable_diffusion_v1

Diffusers

このモデルはayan4m1によってdiffusersに移植されており、以下のブランチから簡単に実行できます。

- 60,000ステップで訓練されたチェックポイント:

revision="diffusers-60k"

- 95,000ステップで訓練されたチェックポイント:

revision="diffusers-95k"

- 115,000ステップで訓練されたチェックポイント:

revision="diffusers-115k"

詳細については、「Three flavors」セクションを参照してください。

Gradio

私たちは、diffusersを使ったGradioのウェブUIもサポートしており、colabノートブック内で実行できます。

✨ 主な機能

- 元のStable Diffusionの美学を維持しながら、アニメ/マンガスタイルに近づけることができます。

diffusersに移植されており、簡単に実行できます。- GradioのウェブUIをサポートしています。

📦 インストール

インストールに関する具体的なコマンドは原ドキュメントに記載されていないため、このセクションを省略します。

💻 使用例

基本的な使用法

テキストから画像への変換

from diffusers import StableDiffusionPipeline

pipe = StableDiffusionPipeline.from_pretrained("naclbit/trinart_stable_diffusion_v2", revision="diffusers-60k")

pipe.to("cuda")

image = pipe("A magical dragon flying in front of the Himalaya in manga style").images[0]

image

パイプラインをより高速に、または異なるハードウェアで実行したい場合は、最適化ドキュメントを参照してください。

画像から画像への変換

from diffusers import StableDiffusionImg2ImgPipeline

import requests

from PIL import Image

from io import BytesIO

url = "https://scitechdaily.com/images/Dog-Park.jpg"

response = requests.get(url)

init_image = Image.open(BytesIO(response.content)).convert("RGB")

init_image = init_image.resize((768, 512))

pipe = StableDiffusionImg2ImgPipeline.from_pretrained("naclbit/trinart_stable_diffusion_v2", revision="diffusers-115k")

pipe.to("cuda")

images = pipe(prompt="Manga drawing of Brad Pitt", init_image=init_image, strength=0.75, guidance_scale=7.5).images

image

パイプラインをより高速に、または異なるハードウェアで実行したい場合は、最適化ドキュメントを参照してください。

📚 ドキュメント

バージョン2

バージョン2は画像を1万枚追加したほか、ドロップアウトの適用、タグ付けの改善とより長いトレーニング時間により、SDのスタイルを保ったまま出力内容の改善を目指しています。

Three flavors

ステップ115000/95000のチェックポイントでスタイルが変わりすぎると感じる場合は、ステップ60000のチェックポイントを使用してみてください。

img2img

latent-diffusion のscriptsフォルダに入っているddim img2imgをこのモデルで動かす場合、use_emaはFalseにする必要があります。

ハードウェア

訓練情報

- データ拡張付きのカスタムデータセットローダー: XFlip、中央クロップ、アスペクト比固定のスケーリング

- 学習率: 1.0e-5

- 10%のドロップアウト

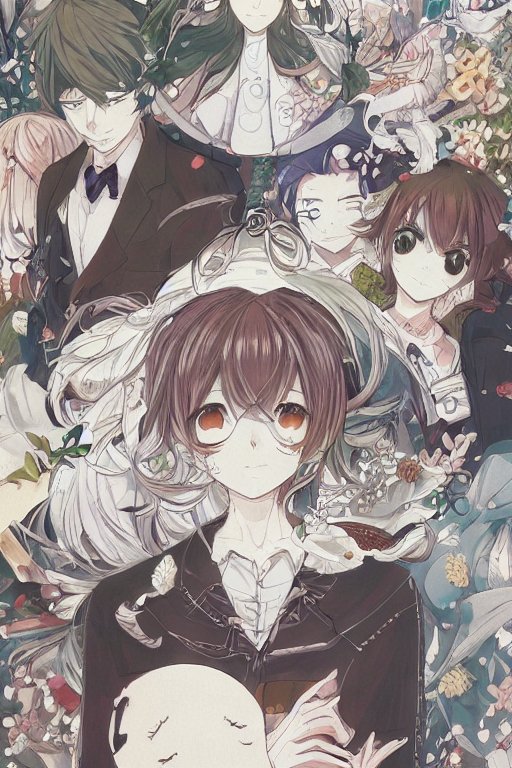

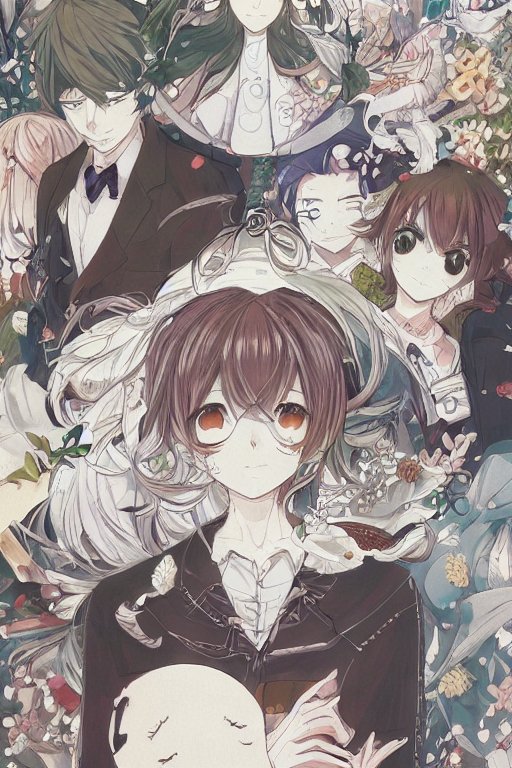

サンプル画像

各画像は、K. Crowsonのk-lms(k-diffusionリポジトリから)方法を使用して50ステップで生成されています。

クレジット

- Sta, AI Novelist Dev (https://ai-novel.com/) @ Bit192, Inc.

- Stable Diffusion - Rombach, Robin and Blattmann, Andreas and Lorenz, Dominik and Esser, Patrick and Ommer, Bjorn

🔧 技術詳細

- モデルタイプ: Stable Diffusionのファインチューン済モデル

- 訓練データ: 約4万枚のアニメ・マンガスタイルの高解像度画像

- 訓練方法: 8エポック間のファインチューニング

- チェックポイント: 60,000ステップ、95,000ステップ、115,000ステップ

📄 ライセンス

CreativeML OpenRAIL-M

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語