模型概述

模型特點

模型能力

使用案例

🚀 Openchat 3.5 0106 - GGUF

Openchat 3.5 0106 - GGUF 是一個文本生成模型,以 Mistral 為基礎,在文本生成任務中表現出色。本項目提供了該模型的 GGUF 量化格式文件,方便不同設備和場景下的使用。

🚀 快速開始

模型信息

| 屬性 | 詳情 |

|---|---|

| 模型創建者 | OpenChat |

| 模型名稱 | Openchat 3.5 0106 |

| 模型類型 | mistral |

| 管道標籤 | text-generation |

| 基礎模型 | openchat/openchat-3.5-0106 |

| 量化者 | TheBloke |

| 許可證 | apache-2.0 |

模型展示

TheBloke's LLM work is generously supported by a grant from andreessen horowitz (a16z)

✨ 主要特性

模型格式

本倉庫包含 OpenChat 的 Openchat 3.5 0106 的 GGUF 格式模型文件。這些文件使用了由 Massed Compute 提供的硬件進行量化。

GGUF 格式優勢

GGUF 是 llama.cpp 團隊在 2023 年 8 月 21 日引入的一種新格式,它取代了不再被 llama.cpp 支持的 GGML 格式。以下是一些已知支持 GGUF 的客戶端和庫:

- llama.cpp:GGUF 的源項目,提供 CLI 和服務器選項。

- text-generation-webui:最廣泛使用的 Web UI,具有許多功能和強大的擴展,支持 GPU 加速。

- KoboldCpp:功能齊全的 Web UI,支持所有平臺和 GPU 架構的 GPU 加速,尤其適合故事創作。

- GPT4All:免費開源的本地運行 GUI,支持 Windows、Linux 和 macOS,具有完整的 GPU 加速。

- LM Studio:適用於 Windows 和 macOS(Silicon)的易於使用且功能強大的本地 GUI,支持 GPU 加速,截至 2023 年 11 月 27 日,Linux 版本處於測試階段。

- LoLLMS Web UI:一個很棒的 Web UI,具有許多有趣和獨特的功能,包括一個完整的模型庫,便於選擇模型。

- Faraday.dev:一個有吸引力且易於使用的基於角色的聊天 GUI,適用於 Windows 和 macOS(Silicon 和 Intel),支持 GPU 加速。

- llama-cpp-python:一個支持 GPU 加速、LangChain 集成和 OpenAI 兼容 API 服務器的 Python 庫。

- candle:一個專注於性能的 Rust ML 框架,包括 GPU 支持,易於使用。

- ctransformers:一個支持 GPU 加速、LangChain 集成和 OpenAI 兼容 AI 服務器的 Python 庫。請注意,截至 2023 年 11 月 27 日,ctransformers 已經很長時間沒有更新,不支持許多最新的模型。

可用倉庫

- 用於 GPU 推理的 AWQ 模型

- 用於 GPU 推理的 GPTQ 模型,具有多種量化參數選項

- 用於 CPU+GPU 推理的 2、3、4、5、6 和 8 位 GGUF 模型

- OpenChat 原始未量化的 fp16 格式 PyTorch 模型,用於 GPU 推理和進一步轉換

📦 安裝指南

下載 GGUF 文件

手動下載注意事項:幾乎不需要克隆整個倉庫!提供了多種不同的量化格式,大多數用戶只需要選擇並下載單個文件。

以下客戶端/庫將自動為你下載模型,並提供可用模型列表供你選擇:

- LM Studio

- LoLLMS Web UI

- Faraday.dev

在 text-generation-webui 中下載

在“Download Model”下,輸入模型倉庫地址:TheBloke/openchat-3.5-0106-GGUF,然後在下方輸入要下載的具體文件名,例如:openchat-3.5-0106.Q4_K_M.gguf,最後點擊“Download”。

在命令行下載(包括同時下載多個文件)

推薦使用 huggingface-hub Python 庫:

pip3 install huggingface-hub

然後可以使用以下命令將任何單個模型文件高速下載到當前目錄:

huggingface-cli download TheBloke/openchat-3.5-0106-GGUF openchat-3.5-0106.Q4_K_M.gguf --local-dir . --local-dir-use-symlinks False

更高級的 huggingface-cli 下載用法(點擊查看)

你還可以使用通配符同時下載多個文件:

huggingface-cli download TheBloke/openchat-3.5-0106-GGUF --local-dir . --local-dir-use-symlinks False --include='*Q4_K*gguf'

有關使用 huggingface-cli 下載的更多文檔,請參閱:HF -> Hub Python Library -> Download files -> Download from the CLI。

為了在高速連接(1Gbit/s 或更高)上加速下載,請安裝 hf_transfer:

pip3 install hf_transfer

並將環境變量 HF_HUB_ENABLE_HF_TRANSFER 設置為 1:

HF_HUB_ENABLE_HF_TRANSFER=1 huggingface-cli download TheBloke/openchat-3.5-0106-GGUF openchat-3.5-0106.Q4_K_M.gguf --local-dir . --local-dir-use-symlinks False

Windows 命令行用戶:可以在下載命令前運行 set HF_HUB_ENABLE_HF_TRANSFER=1 來設置環境變量。

💻 使用示例

llama.cpp 命令示例

確保使用的是 d0cee0d 或更高版本的 llama.cpp。

./main -ngl 35 -m openchat-3.5-0106.Q4_K_M.gguf --color -c 8192 --temp 0.7 --repeat_penalty 1.1 -n -1 -p "GPT4 Correct User: {prompt}<|end_of_turn|>GPT4 Correct Assistant:"

-ngl 32:將其更改為要卸載到 GPU 的層數。如果沒有 GPU 加速,請刪除該參數。-c 8192:將其更改為所需的序列長度。對於擴展序列模型(例如 8K、16K、32K),必要的 RoPE 縮放參數會從 GGUF 文件中讀取並由 llama.cpp 自動設置。請注意,更長的序列長度需要更多的資源,因此可能需要減小此值。

如果想要進行聊天式對話,請將 -p <PROMPT> 參數替換為 -i -ins。

有關其他參數及其用法,請參考 llama.cpp 文檔。

在 text-generation-webui 中運行

更多說明可以在 text-generation-webui 文檔中找到,地址為:text-generation-webui/docs/04 ‐ Model Tab.md。

從 Python 代碼運行

可以使用 llama-cpp-python 或 ctransformers 庫從 Python 中使用 GGUF 模型。請注意,截至 2023 年 11 月 27 日,ctransformers 已經有一段時間沒有更新,並且與一些最新的模型不兼容。因此,建議使用 llama-cpp-python。

使用 llama-cpp-python 在 Python 代碼中加載此模型

完整文檔請參閱:llama-cpp-python 文檔。

首先安裝包

根據你的系統運行以下命令之一:

# 無 GPU 加速的基礎 ctransformers

pip install llama-cpp-python

# 帶有 NVidia CUDA 加速

CMAKE_ARGS="-DLLAMA_CUBLAS=on" pip install llama-cpp-python

# 或者帶有 OpenBLAS 加速

CMAKE_ARGS="-DLLAMA_BLAS=ON -DLLAMA_BLAS_VENDOR=OpenBLAS" pip install llama-cpp-python

# 或者帶有 CLBLast 加速

CMAKE_ARGS="-DLLAMA_CLBLAST=on" pip install llama-cpp-python

# 或者帶有 AMD ROCm GPU 加速(僅適用於 Linux)

CMAKE_ARGS="-DLLAMA_HIPBLAS=on" pip install llama-cpp-python

# 或者帶有 Metal GPU 加速(僅適用於 macOS 系統)

CMAKE_ARGS="-DLLAMA_METAL=on" pip install llama-cpp-python

# 在 Windows 中,在 PowerShell 中設置 CMAKE_ARGS 變量,例如對於 NVidia CUDA:

$env:CMAKE_ARGS = "-DLLAMA_OPENBLAS=on"

pip install llama-cpp-python

簡單的 llama-cpp-python 示例代碼

from llama_cpp import Llama

# 將 gpu_layers 設置為要卸載到 GPU 的層數。如果系統上沒有 GPU 加速,請將其設置為 0。

llm = Llama(

model_path="./openchat-3.5-0106.Q4_K_M.gguf", # 首先下載模型文件

n_ctx=8192, # 要使用的最大序列長度 - 請注意,更長的序列長度需要更多的資源

n_threads=8, # 要使用的 CPU 線程數,根據系統和性能進行調整

n_gpu_layers=35 # 如果有 GPU 加速,要卸載到 GPU 的層數

)

# 簡單推理示例

output = llm(

"GPT4 Correct User: {prompt}<|end_of_turn|>GPT4 Correct Assistant:", # 提示

max_tokens=512, # 生成最多 512 個令牌

stop=["</s>"], # 示例停止令牌 - 不一定適用於此特定模型!使用前請檢查。

echo=True # 是否回顯提示

)

# 聊天完成 API

llm = Llama(model_path="./openchat-3.5-0106.Q4_K_M.gguf", chat_format="llama-2") # 根據使用的模型設置 chat_format

llm.create_chat_completion(

messages = [

{"role": "system", "content": "You are a story writing assistant."},

{

"role": "user",

"content": "Write a story about llamas."

}

]

)

與 LangChain 一起使用

以下是使用 llama-cpp-python 和 ctransformers 與 LangChain 的指南:

📚 詳細文檔

提示模板

GPT4 Correct User: {prompt}<|end_of_turn|>GPT4 Correct Assistant:

兼容性

這些量化的 GGUFv2 文件與 2023 年 8 月 27 日之後的 llama.cpp 兼容,截至提交 d0cee0d。

它們還與許多第三方 UI 和庫兼容,請參閱本 README 頂部的列表。

量化方法解釋

點擊查看詳細信息

新的可用方法如下:

- GGML_TYPE_Q2_K:“type-1” 2 位量化,超級塊包含 16 個塊,每個塊有 16 個權重。塊尺度和最小值用 4 位量化。最終每個權重有效使用 2.5625 位(bpw)。

- GGML_TYPE_Q3_K:“type-0” 3 位量化,超級塊包含 16 個塊,每個塊有 16 個權重。尺度用 6 位量化。最終使用 3.4375 bpw。

- GGML_TYPE_Q4_K:“type-1” 4 位量化,超級塊包含 8 個塊,每個塊有 32 個權重。尺度和最小值用 6 位量化。最終使用 4.5 bpw。

- GGML_TYPE_Q5_K:“type-1” 5 位量化。與 GGML_TYPE_Q4_K 具有相同的超級塊結構,最終使用 5.5 bpw。

- GGML_TYPE_Q6_K:“type-0” 6 位量化。超級塊有 16 個塊,每個塊有 16 個權重。尺度用 8 位量化。最終使用 6.5625 bpw。

請參考下面的“提供的文件”表,查看哪些文件使用了哪些方法以及如何使用。

提供的文件

| 名稱 | 量化方法 | 位數 | 大小 | 所需最大 RAM | 使用場景 |

|---|---|---|---|---|---|

| openchat-3.5-0106.Q2_K.gguf | Q2_K | 2 | 3.08 GB | 5.58 GB | 最小,但質量損失顯著 - 不建議用於大多數用途 |

| openchat-3.5-0106.Q3_K_S.gguf | Q3_K_S | 3 | 3.16 GB | 5.66 GB | 非常小,但質量損失高 |

| openchat-3.5-0106.Q3_K_M.gguf | Q3_K_M | 3 | 3.52 GB | 6.02 GB | 非常小,但質量損失高 |

| openchat-3.5-0106.Q3_K_L.gguf | Q3_K_L | 3 | 3.82 GB | 6.32 GB | 小,但質量損失較大 |

| openchat-3.5-0106.Q4_0.gguf | Q4_0 | 4 | 4.11 GB | 6.61 GB | 舊版;小,但質量損失非常高 - 建議使用 Q3_K_M |

| openchat-3.5-0106.Q4_K_S.gguf | Q4_K_S | 4 | 4.14 GB | 6.64 GB | 小,但質量損失更大 |

| openchat-3.5-0106.Q4_K_M.gguf | Q4_K_M | 4 | 4.37 GB | 6.87 GB | 中等,質量平衡 - 推薦 |

| openchat-3.5-0106.Q5_0.gguf | Q5_0 | 5 | 5.00 GB | 7.50 GB | 舊版;中等,質量平衡 - 建議使用 Q4_K_M |

| openchat-3.5-0106.Q5_K_S.gguf | Q5_K_S | 5 | 5.00 GB | 7.50 GB | 大,質量損失低 - 推薦 |

| openchat-3.5-0106.Q5_K_M.gguf | Q5_K_M | 5 | 5.13 GB | 7.63 GB | 大,質量損失非常低 - 推薦 |

| openchat-3.5-0106.Q6_K.gguf | Q6_K | 6 | 5.94 GB | 8.44 GB | 非常大,質量損失極低 |

| openchat-3.5-0106.Q8_0.gguf | Q8_0 | 8 | 7.70 GB | 10.20 GB | 非常大,質量損失極低 - 不建議 |

注意:上述 RAM 數字假設沒有 GPU 卸載。如果將層卸載到 GPU,這將減少 RAM 使用並使用 VRAM 代替。

🔧 技術細節

原始模型卡片:OpenChat 的 Openchat 3.5 0106

Advancing Open-source Language Models with Mixed-Quality Data

Online Demo

|

Online Demo

|

GitHub

|

GitHub

|

Paper

|

Paper

|

Discord

Discord

Sponsored by RunPod

![]()

目錄

用法

要使用此模型,強烈建議按照我們倉庫中的 安裝指南 安裝 OpenChat 包,並通過運行下表中的服務命令使用 OpenChat 兼容 OpenAI 的 API 服務器。該服務器使用 vLLM 進行了高吞吐量部署優化,可以在具有 24GB RAM 的消費級 GPU 上運行。要啟用張量並行,請在服務命令後附加 --tensor-parallel-size N。

一旦啟動,服務器將在 localhost:18888 監聽請求,並與 OpenAI ChatCompletion API 規範 兼容。請參考以下示例請求作為參考。此外,你可以使用 OpenChat Web UI 獲得更友好的用戶體驗。

如果你想將服務器部署為在線服務,可以使用 --api-keys sk-KEY1 sk-KEY2 ... 指定允許的 API 密鑰,並使用 --disable-log-requests --disable-log-stats --log-file openchat.log 僅將日誌記錄到文件中。出於安全考慮,建議在服務器前使用 HTTPS 網關。

| 模型 | 大小 | 上下文 | 權重 | 服務命令 |

|---|---|---|---|---|

| OpenChat-3.5-0106 | 7B | 8192 | Huggingface | python -m ochat.serving.openai_api_server --model openchat/openchat-3.5-0106 --engine-use-ray --worker-use-ray |

示例請求(點擊展開)

💡 默認模式(GPT4 Correct):最適合編碼、聊天和常規任務

curl http://localhost:18888/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "openchat_3.5",

"messages": [{"role": "user", "content": "You are a large language model named OpenChat. Write a poem to describe yourself"}]

}'

🧮 數學推理模式:專為解決數學問題而設計

curl http://localhost:18888/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{

"model": "openchat_3.5",

"condition": "Math Correct",

"messages": [{"role": "user", "content": "10.3 − 7988.8133 = "}]

}'

對話模板

💡 默認模式(GPT4 Correct):最適合編碼、聊天和常規任務

GPT4 Correct User: Hello<|end_of_turn|>GPT4 Correct Assistant: Hi<|end_of_turn|>GPT4 Correct User: How are you today?<|end_of_turn|>GPT4 Correct Assistant:

🧮 數學推理模式:專為解決數學問題而設計

Math Correct User: 10.3 − 7988.8133=<|end_of_turn|>Math Correct Assistant:

⚠️ 注意:記得將 <|end_of_turn|> 設置為生成結束令牌。

默認(GPT4 Correct)模板也可以作為集成的 tokenizer.chat_template 使用,而不是手動指定模板:

messages = [

{"role": "user", "content": "Hello"},

{"role": "assistant", "content": "Hi"},

{"role": "user", "content": "How are you today?"}

]

tokens = tokenizer.apply_chat_template(messages, add_generation_prompt=True)

assert tokens == [1, 420, 6316, 28781, 3198, 3123, 1247, 28747, 22557, 32000, 420, 6316, 28781, 3198, 3123, 21631, 28747, 15359, 32000, 420, 6316, 28781, 3198, 3123, 1247, 28747, 1602, 460, 368, 3154, 28804, 32000, 420, 6316, 28781, 3198, 3123, 21631, 28747]

(實驗性)評估器/反饋功能

在本次發佈中,我們加入了評估器功能,以推動開源模型作為評估器的發展。你可以使用 默認模式(GPT4 Correct) 和以下提示(與 Prometheus 相同)來評估響應。

###任務描述:

給定一個指令(可能包含輸入)、一個要評估的響應、一個得分為 5 的參考答案以及一個代表評估標準的評分規則。

1. 嚴格根據給定的評分規則,撰寫一份詳細的反饋,評估響應的質量,而不是進行一般性評估。

2. 撰寫反饋後,給出一個 1 到 5 之間的整數分數。你應該參考評分規則。

3. 輸出格式應如下所示:"反饋:(針對標準撰寫的反饋)[結果](1 到 5 之間的整數)"

4. 請不要生成任何其他開頭、結尾和解釋。

###要評估的指令:

{orig_instruction}

###要評估的響應:

{orig_response}

###參考答案(得分 5):

{orig_reference_answer}

###評分規則:

[{orig_criteria}]

得分 1:{orig_score1_description}

得分 2:{orig_score2_description}

得分 3:{orig_score3_description}

得分 4:{orig_score4_description}

得分 5:{orig_score5_description}

###反饋:

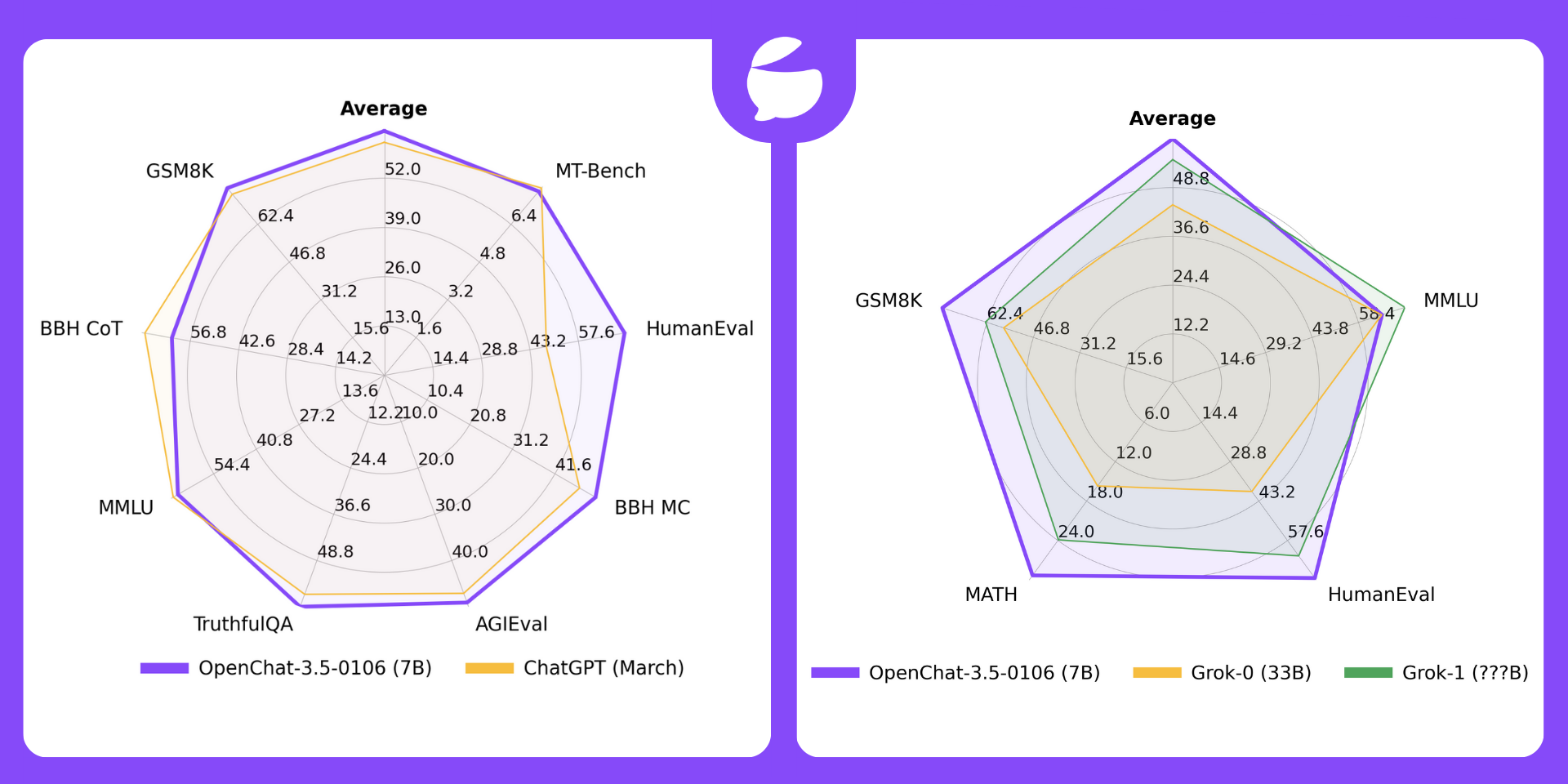

基準測試

| 模型 | # 參數 | 平均分 | MT-Bench | HumanEval | BBH MC | AGIEval | TruthfulQA | MMLU | GSM8K | BBH CoT |

|---|---|---|---|---|---|---|---|---|---|---|

| OpenChat-3.5-0106 | 7B | 64.5 | 7.8 | 71.3 | 51.5 | 49.1 | 61.0 | 65.8 | 77.4 | 62.2 |

| OpenChat-3.5-1210 | 7B | 63.8 | 7.76 | 68.9 | 49.5 | 48.0 | 61.8 | 65.3 | 77.3 | 61.8 |

| OpenChat-3.5 | 7B | 61.6 | 7.81 | 55.5 | 47.6 | 47.4 | 59.1 | 64.3 | 77.3 | 63.5 |

| ChatGPT(3 月版)* | ???B | 61.5 | 7.94 | 48.1 | 47.6 | 47.1 | 57.7 | 67.3 | 74.9 | 70.1 |

| OpenHermes 2.5 | 7B | 59.3 | 7.54 | 48.2 | 49.4 | 46.5 | 57.5 | 63.8 | 73.5 | 59.9 |

| OpenOrca Mistral | 7B | 52.7 | 6.86 | 38.4 | 49.4 | 42.9 | 45.9 | 59.3 | 59.1 | 58.1 |

| Zephyr-β^ | 7B | 34.6 | 7.34 | 22.0 | 40.6 | 39.0 | 40.8 | 39.8 | 5.1 | 16.0 |

| Mistral | 7B | - | 6.84 | 30.5 | 39.0 | 38.0 | - | 60.1 | 52.2 | - |

評估詳情(點擊展開)

*:ChatGPT(3 月版)的結果來自 GPT-4 技術報告、Chain-of-Thought Hub 和我們的評估。請注意,ChatGPT 不是一個固定的基線,會隨著時間快速發展。

^:Zephyr-β 經常無法遵循少樣本 CoT 指令,可能是因為它只與聊天數據對齊,而沒有在少樣本數據上進行訓練。

**: Mistral 和開源 SOTA 結果取自指令調優模型論文和官方倉庫中報告的結果。

所有模型都在聊天模式下進行評估(例如,應用相應的對話模板)。所有零樣本基準測試遵循與 AGIEval 論文和 Orca 論文相同的設置。CoT 任務使用與 Chain-of-Thought Hub 相同的配置,HumanEval 使用 EvalPlus 進行評估,MT-bench 使用 FastChat 運行。要重現我們的結果,請遵循 我們的倉庫 中的說明。

HumanEval+

| 模型 | 大小 | HumanEval+ pass@1 |

|---|---|---|

| OpenChat-3.5-0106 | 7B | 65.9 |

| ChatGPT(2023 年 12 月 12 日) | ???B | 64.6 |

| WizardCoder-Python-34B-V1.0 | 34B | 64.6 |

| OpenChat 3.5 1210 | 7B | 63.4 |

| OpenHermes 2.5 | 7B | 41.5 |

OpenChat-3.5 與 Grok 對比

🔥 OpenChat-3.5-0106(7B)現在在 所有 4 項基準測試 中都優於 Grok-0(33B),在平均表現和 3/4 項基準測試 中優於 Grok-1(???B)。

| 許可證 | # 參數 | 平均分 | MMLU | HumanEval | MATH | GSM8k | |

|---|---|---|---|---|---|---|---|

| OpenChat-3.5-0106 | Apache-2.0 | 7B | 61.0 | 65.8 | 71.3 | 29.3 | 77.4 |

| OpenChat-3.5-1210 | Apache-2.0 | 7B | 60.1 | 65.3 | 68.9 | 28.9 | 77.3 |

| OpenChat-3.5 | Apache-2.0 | 7B | 56.4 | 64.3 | 55.5 | 28.6 | 77.3 |

| Grok-0 | 專有許可證 | 33B | 44.5 | 65.7 | 39.7 | 15.7 | 56.8 |

| Grok-1 | 專有許可證 | ???B | 55.8 | 73 | 63.2 | 23.9 | 62.9 |

*:Grok 的結果由 X.AI 報告。

侷限性

基礎模型侷限性 儘管 OpenChat 具有先進的能力,但它仍然受到其基礎模型固有侷限性的約束。這些侷限性可能會影響模型在以下領域的性能:

- 複雜推理

- 數學和算術任務

- 編程和編碼挑戰

虛構不存在的信息 OpenChat 有時可能會生成不存在或不準確的信息,即所謂的“幻覺”。用戶應該意識到這種可能性,並驗證從模型獲得的任何關鍵信息。

安全性 OpenChat 有時可能會生成有害、仇恨言論、有偏見的響應,或回答不安全的問題。在需要安全和經過審核的響應的用例中,應用額外的 AI 安全措施至關重要。

📄 許可證

我們的 OpenChat 3.5 代碼和模型根據 Apache 許可證 2.0 分發。

引用

@article{wang2023openchat,

title={OpenChat: Advancing Open-source Language Models with Mixed-Quality Data},

author={Wang, Guan and Cheng, Sijie and Zhan, Xianyuan and Li, Xiangang and Song, Sen and Liu, Yang},

journal={arXiv preprint arXiv:2309.11235},

year={2023}

}

主要貢獻者

- Wang Guan [imonenext@gmail.com],Cheng Sijie [csj23@mails.tsinghua.edu.cn],Alpay Ariyak [aariyak@wpi.edu]

- 我們期待聽取你的意見,並在這個令人興奮的項目上進行合作!

Discord

如需進一步的支持,以及關於這些模型和人工智能的討論,請加入我們的: TheBloke AI 的 Discord 服務器

感謝與貢獻方式

感謝 chirper.ai 團隊! 感謝來自 gpus.llm-utils.org 的 Clay!

很多人問是否可以進行貢獻。我喜歡提供模型並幫助他人,也希望能夠花更多時間做這些事情,以及拓展到新的項目,如微調/訓練。

如果你有能力且願意貢獻,我將不勝感激,這將幫助我繼續提供更多模型,並開始新的人工智能項目。

捐贈者將在任何 AI/LLM/模型問題和請求上獲得優先支持,訪問私人 Discord 房間,以及其他福利。

- Patreon:https://patreon.com/TheBlokeAI

- Ko-Fi:https://ko-fi.com/TheBlokeAI

特別感謝:Aemon Algiz。

Patreon 特別提及:Michael Levine,阿明,Trailburnt,Nikolai Manek,John Detwiler,Randy H,Will Dee,Sebastain Graf,NimbleBox.ai,Eugene Pentland,Emad Mostaque,Ai Maven,Jim Angel,Jeff Scroggin,Michael Davis,Manuel Alberto Morcote,Stephen Murray,Robert,Justin Joy,Luke @flexchar,Brandon Frisco,Elijah Stavena,S_X,Dan Guido,Undi.,Komninos Chatzipapas,Shadi,theTransient,Lone Striker,Raven Klaugh,jjj,Cap'n Zoog,Michel-Marie MAUDET(LINAGORA),Matthew Berman,David,Fen Risland,Omer Bin Jawed,Luke Pendergrass,Kalila,OG,Erik Bjäreholt,Rooh Singh,Joseph William Delisle,Dan Lewis,TL,John Villwock,AzureBlack,Brad,Pedro Madruga,Caitlyn Gatomon,K,jinyuan sun,Mano Prime,Alex,Jeffrey Morgan,Alicia Loh,Illia Dulskyi,Chadd,transmissions 11,fincy,Rainer Wilmers,ReadyPlayerEmma,knownsqashed,Mandus,biorpg,Deo Leter,Brandon Phillips,SuperWojo,Sean Connelly,Iucharbius,Jack West,Harry Royden McLaughlin,Nicholas,terasurfer,Vitor Caleffi,Duane Dunston,Johann-Peter Hartmann,David Ziegler,Olakabola,Ken Nordquist,Trenton Dambrowitz,Tom X Nguyen,Vadim,Ajan Kanaga,Leonard Tan,Clay Pascal,Alexandros Triantafyllidis,JM33133,Xule,vamX,ya boyyy,subjectnull,Talal Aujan,Alps Aficionado,wassieverse,Ari Malik,James Bentley,Woland,Spencer Kim,Michael Dempsey,Fred von Graf,Elle,zynix,William Richards,Stanislav Ovsiannikov,Edmond Seymore,Jonathan Leane,Martin Kemka,usrbinkat,Enrico Ros

感謝所有慷慨的贊助者和捐贈者! 再次感謝 a16z 的慷慨資助。

Transformers

Transformers Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語