🚀 GPT - 2土耳其語模型

GPT - 2土耳其語模型是專門針對土耳其語定製的大型數據模型,屬於大語言模型(LLM)類別。它基於GPT - 2架構構建,擁有專門定製的分詞器結構,代表了一個土耳其語語言模型。該模型能夠利用給定的起始文本生成類似人類的文本,並且在大量的土耳其語文本數據集上進行了訓練。

🚀 快速開始

模型使用說明

重要提示:由於模型對大小寫敏感,因此提示詞必須全部使用小寫字母。

from transformers import GPT2Tokenizer, GPT2LMHeadModel

model_name = "cenkersisman/gpt2-turkish-128-token"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

prompt = "okyanusun derinliklerinde bulunan"

input_ids = tokenizer.encode(prompt, return_tensors="pt")

output = model.generate(input_ids, max_length=100, pad_token_id=tokenizer.eos_token_id)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

✨ 主要特性

GPT - 2土耳其語模型具有以下特性:

- 基於GPT - 2架構,專為土耳其語定製。

- 擁有特殊的分詞器結構,符合土耳其語的詞法特點。

- 能夠根據起始文本生成自然流暢的文本。

- 在大規模土耳其語文本數據集上進行訓練,具有廣泛的語言理解能力。

📦 安裝指南

文檔未提及安裝相關內容,若有安裝需求,可參考transformers庫的安裝方式來安裝所需依賴。

💻 使用示例

基礎用法

from transformers import GPT2Tokenizer, GPT2LMHeadModel

model_name = "cenkersisman/gpt2-turkish-128-token"

tokenizer = GPT2Tokenizer.from_pretrained(model_name)

model = GPT2LMHeadModel.from_pretrained(model_name)

prompt = "okyanusun derinliklerinde bulunan"

input_ids = tokenizer.encode(prompt, return_tensors="pt")

output = model.generate(input_ids, max_length=100, pad_token_id=tokenizer.eos_token_id)

generated_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(generated_text)

📚 詳細文檔

模型描述

GPT - 2土耳其語模型是一個專門為土耳其語定製的大型語言模型。它基於GPT - 2架構,分詞器結構是專門為土耳其語設計的。該模型能夠使用給定的起始文本生成類似人類的文本,並且在一個包含9億字符的維基百科數據集上進行了訓練。

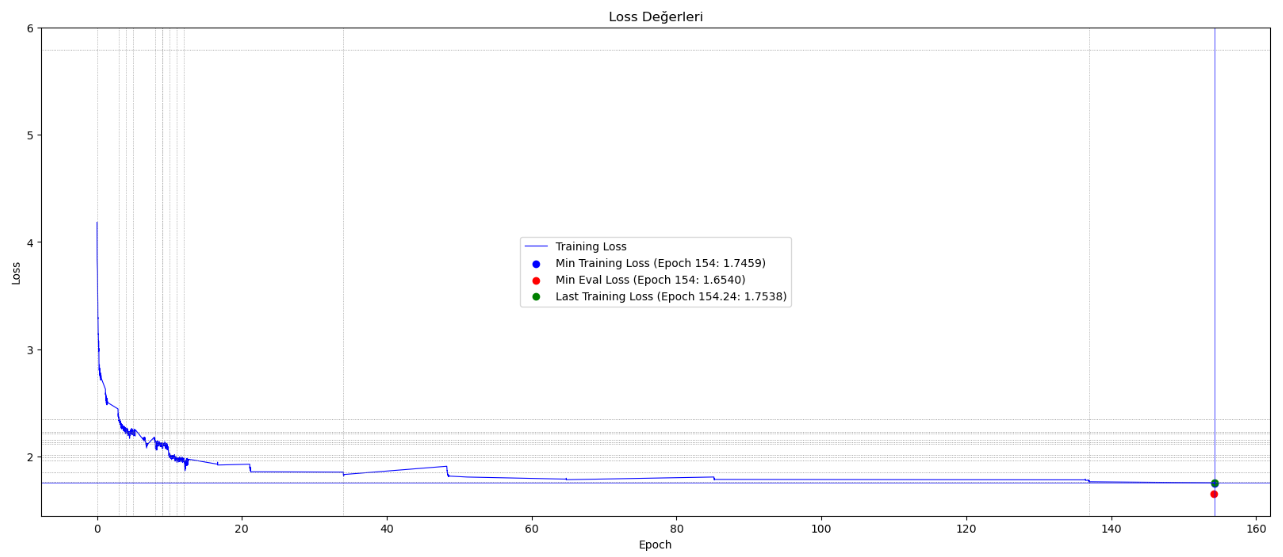

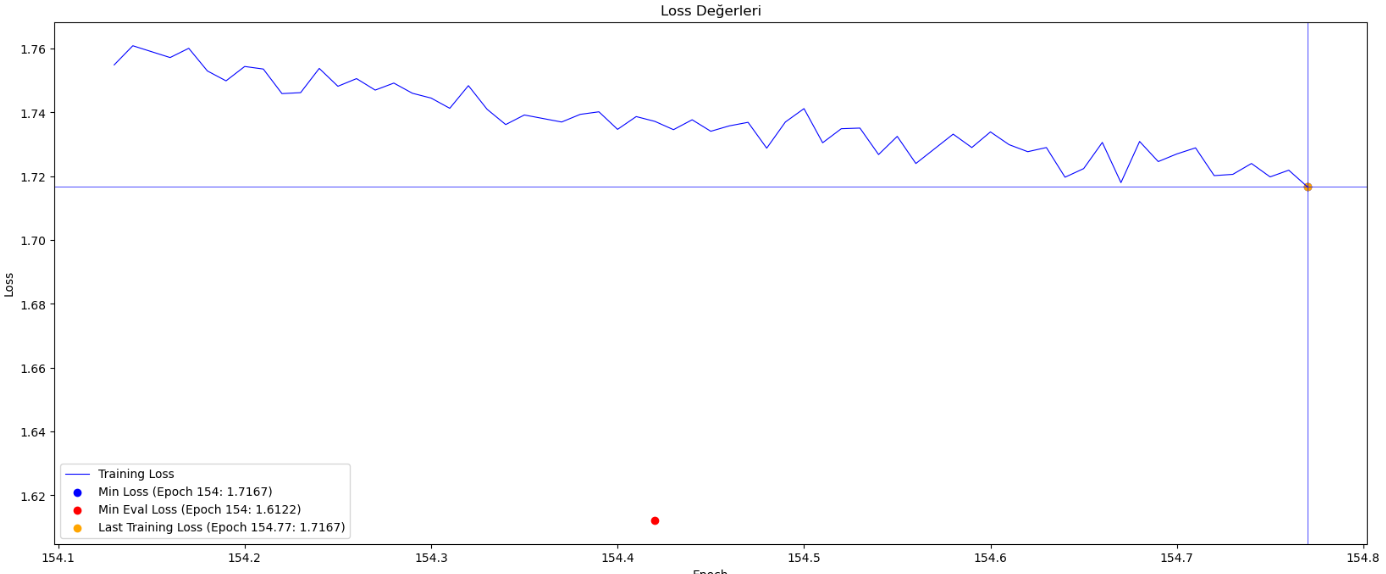

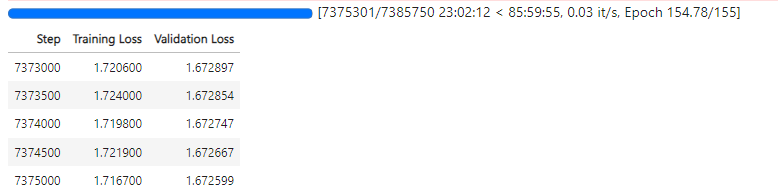

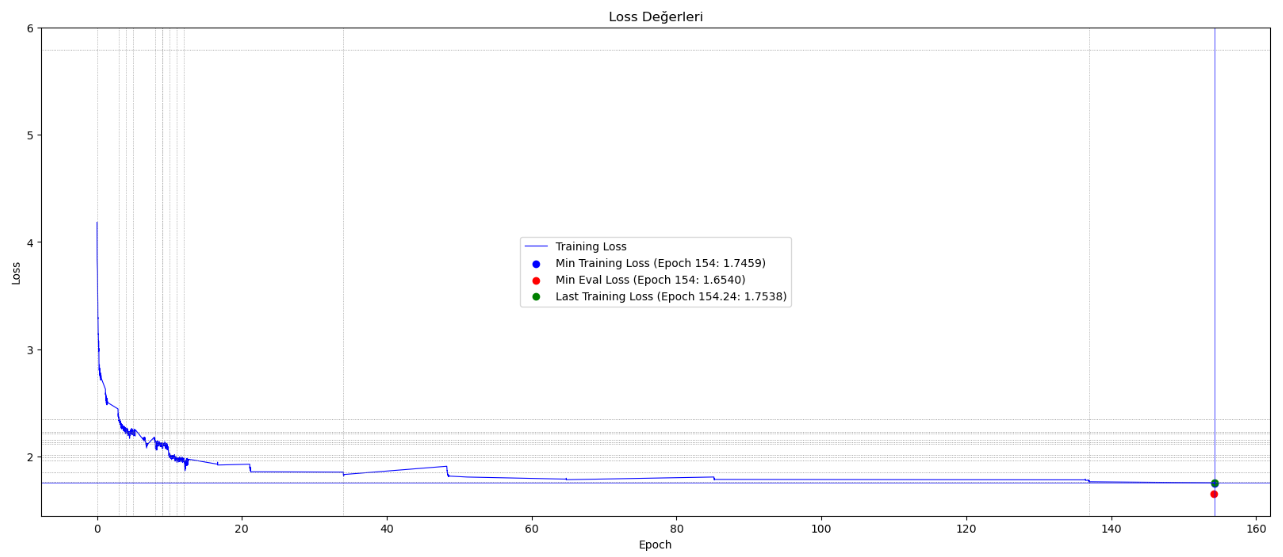

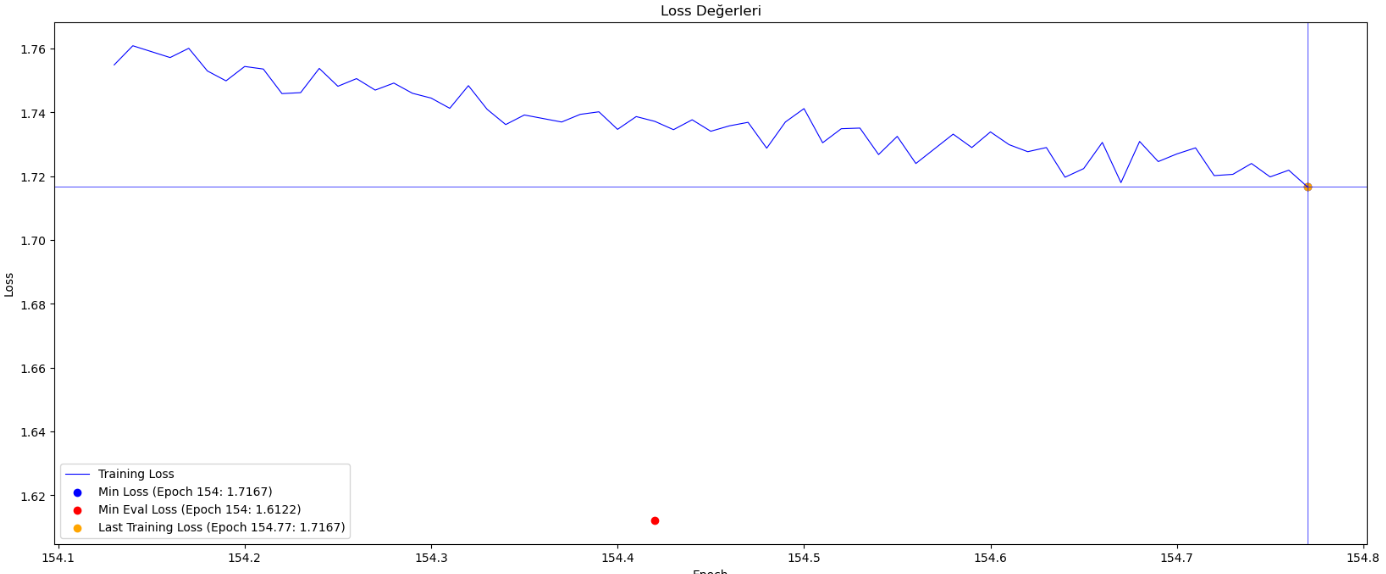

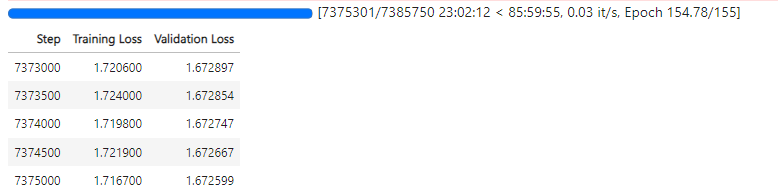

訓練集中的句子最多由128個詞元(詞元 = 詞根和詞綴)組成,因此生成的句子長度是有限的。模型使用了符合土耳其語詞法結構的分詞器,並在大約154個週期內進行了750萬步的訓練。訓練使用了具有4GB內存的Nvidia Geforce RTX 3050 GPU,還利用了16GB共享GPU,訓練過程中總共使用了20GB內存。

訓練過程曲線

🔧 技術細節

- 訓練數據:使用了9億字符的維基百科數據集進行訓練。

- 分詞器:採用了符合土耳其語詞法結構的分詞器。

- 訓練步數和週期:模型在大約154個週期內進行了750萬步的訓練。

- 硬件資源:訓練使用了具有4GB內存的Nvidia Geforce RTX 3050 GPU,還利用了16GB共享GPU,訓練過程中總共使用了20GB內存。

📄 許可證

文檔未提及許可證相關信息。

⚠️ 重要提示

此模型作為自迴歸語言模型進行訓練,這意味著其基本功能是接收一個文本序列並預測下一個詞元。儘管語言模型廣泛用於許多其他任務,但與此工作相關的仍有許多未知因素。

該模型在一個已知包含褻瀆、露骨內容和不良行為文本的數據集上進行了訓練。根據使用場景,此模型可能會生成社會無法接受的文本。

與所有語言模型一樣,很難預先預測此模型對特定輸入的響應方式,並且可能會在沒有警告的情況下出現攻擊性內容。建議在發佈結果之前,由人工對輸出進行審查或過濾,以審查不需要的內容並提高結果質量。

💡 使用建議

- 由於模型對大小寫敏感,提示詞請全部使用小寫字母。

- 在發佈模型生成的結果之前,務必進行人工審查,以確保內容符合社會道德規範。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語