🚀 42dot_LLM-PLM-1.3B

42dot LLM-PLM 是由 42dot 42dot LLM (大語言模型)的一部分。42dot LLM-PLM 使用韓語和英語文本語料庫進行預訓練,可作為多種韓語和英語自然語言任務的基礎語言模型。本倉庫包含該模型的 13 億參數版本。

📚 模型描述

超參數

42dot LLM-PLM 基於類似於 LLaMA 2 的 Transformer 解碼器架構構建,其超參數如下:

參數

層數

注意力頭數

隱藏層大小

前饋網絡大小

13 億

24

32

2048

5632

預訓練

預訓練大約花費了 49000 GPU 小時(NVIDIA A100)。相關設置如下:

參數

全局批次大小*

初始學習率

訓練迭代次數*

最大長度*

權重衰減

13 億

400 萬

4E - 4

140 萬億

4096

0.1

(* 單位:詞元)

預訓練數據集

我們使用了一組公開可用的文本語料庫,包括:

分詞器

分詞器基於字節級 BPE 算法。我們使用預訓練語料庫的一個子集從頭開始訓練其詞彙表。為構建該子集,分別從韓語和英語語料庫中採樣了 1000 萬個文檔。最終的詞彙表大小約為 5 萬個。

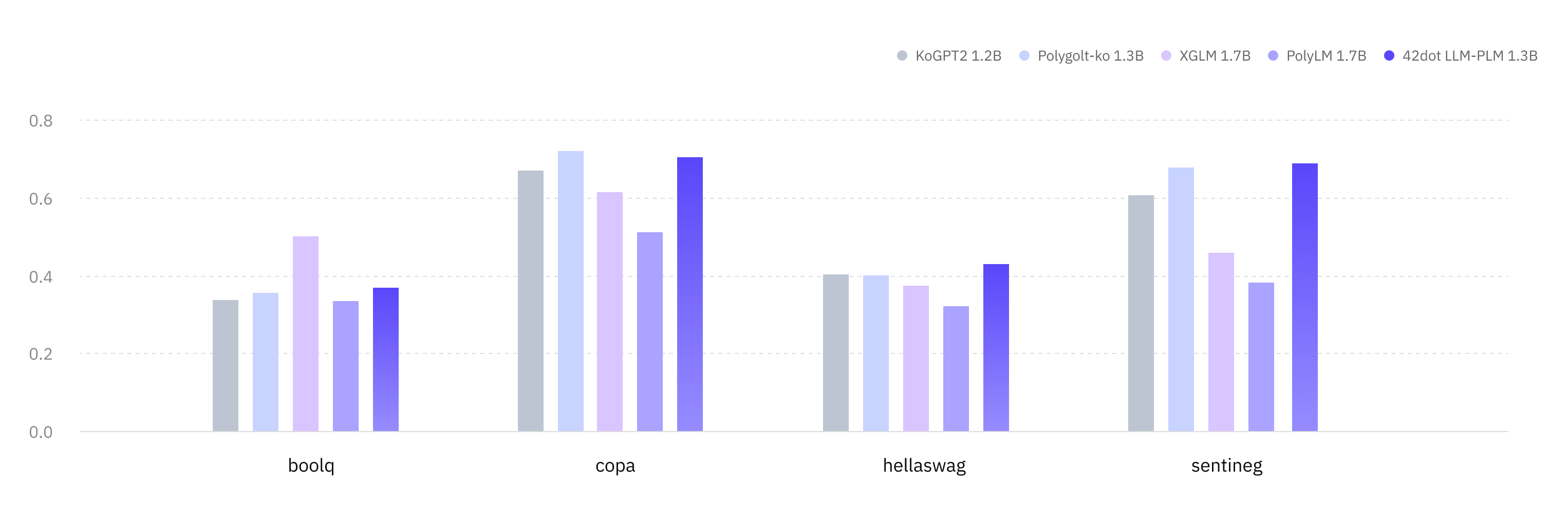

零樣本評估

我們在多種韓語和英語學術基準測試中對 42dot LLM-PLM 進行了評估。所有結果均使用 lm - eval - harness 和 Hugging Face Hub 上發佈的模型獲得。

韓語(KOBEST)

任務 / 宏 F1 值

KoGPT2 Polyglot - Ko XGLM PolyLM 42dot LLM - PLM

boolq

0.337

0.355

0.502 0.334

0.369

copa

0.67

0.721 0.616

0.513

0.704

hellaswag

0.404

0.401

0.374

0.321

0.431

sentineg

0.606

0.679

0.46

0.382

0.69

平均 0.504

0.539

0.488

0.388

0.549

英語

任務 / 指標

MPT

OPT

XGLM

PolyLM

42dot LLM - PLM

anli_r1/acc

0.309

0.341 0.334

0.336

0.325

anli_r2/acc

0.334

0.339

0.331

0.314

0.34

anli_r3/acc

0.33

0.336

0.333

0.339 0.333

arc_challenge/acc

0.268

0.234

0.21

0.198

0.288

arc_challenge/acc_norm

0.291

0.295

0.243

0.256

0.317

arc_easy/acc

0.608

0.571

0.537

0.461

0.628

arc_easy/acc_norm

0.555

0.51

0.479

0.404

0.564

boolq/acc

0.517

0.578

0.585

0.617

0.624

hellaswag/acc

0.415

0.415

0.362

0.322

0.422

hellaswag/acc_norm

0.532

0.537

0.458

0.372

0.544

openbookqa/acc

0.238 0.234

0.17

0.166

0.222

openbookqa/acc_norm

0.334

0.334

0.298

0.334

0.34

piqa/acc

0.714

0.718

0.697

0.667

0.725

piqa/acc_norm

0.72

0.724

0.703

0.649

0.727

record/f1

0.84

0.857 0.775

0.681

0.848

record/em

0.832

0.849 0.769

0.674

0.839

rte/acc

0.541

0.523

0.559 0.513

0.542

truthfulqa_mc/mc1

0.224

0.237

0.215

0.251 0.236

truthfulqa_mc/mc2

0.387

0.386

0.373

0.428 0.387

wic/acc

0.498

0.509 0.503

0.5

0.502

winogrande/acc

0.574

0.595 0.55

0.519

0.583

平均 0.479

0.482

0.452

0.429

0.492

⚠️ 侷限性與倫理考量

42dot LLM-PLM 存在一些其他大語言模型(LLM)常見的侷限性。例如,由於 42dot LLM-PLM 也會出現 幻覺現象 ,它可能會生成虛假和誤導性內容。此外,由於使用了網絡可用的訓練數據,42dot LLM-PLM 可能會生成有毒、有害和有偏見的內容。我們強烈建議 42dot LLM-PLM 用戶瞭解這些侷限性,並採取必要措施來減輕這些問題。

📢 免責聲明

42dot LLM 系列(“42dot LLM”)生成的內容不一定反映 42dot 公司(“42dot”)的觀點或意見。42dot 對因使用 42dot LLM 及其生成的內容而產生的任何直接、間接、暗示、懲罰性、特殊、偶然或其他後果性損害,不承擔任何責任。

📄 許可證

42dot LLM-PLM 採用知識共享署名 - 非商業性使用 4.0 國際許可協議(CC BY - NC 4.0)。

📝 引用

@misc{42dot2023llm,

title={42dot LLM: A Series of Large Language Model by 42dot},

author={42dot Inc.},

year={2023},

url = {https://github.com/42dot/42dot_LLM},

version = {1.0.0},

}

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語