🚀 Swin Transformer (小型モデル)

Swin Transformerは、解像度224x224のImageNet - 1kデータセットで学習されたモデルです。画像分類や密集認識タスクに強力なサポートを提供し、画像データを効果的に処理することができます。

🚀 クイックスタート

Swin Transformerモデルは画像分類タスクに使用できます。オリジナルのモデルを使用して画像分類を行うことも、モデルセンターで自分が興味のあるタスクに対して微調整されたバージョンを見つけることもできます。

以下は、このモデルを使用してCOCO 2017データセットの画像を1000のImageNetカテゴリの1つに分類するサンプルコードです。

from transformers import AutoFeatureExtractor, SwinForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

feature_extractor = AutoFeatureExtractor.from_pretrained("microsoft/swin-small-patch4-window7-224")

model = SwinForImageClassification.from_pretrained("microsoft/swin-small-patch4-window7-224")

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("Predicted class:", model.config.id2label[predicted_class_idx])

より多くのコード例については、ドキュメントを参照してください。

✨ 主な機能

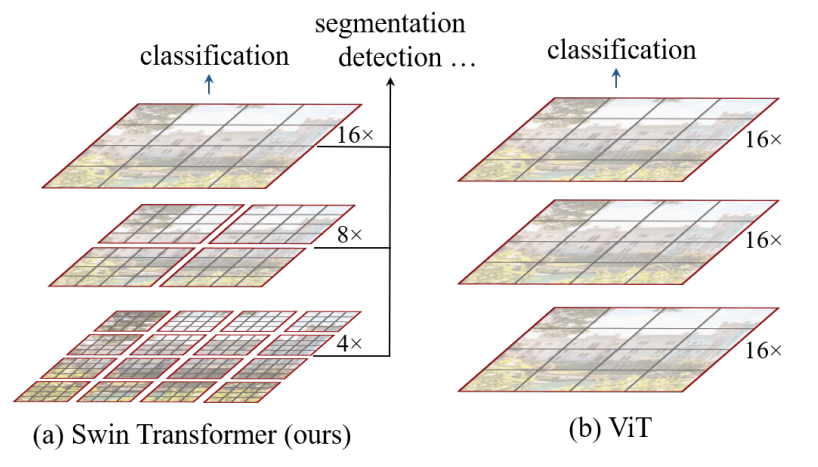

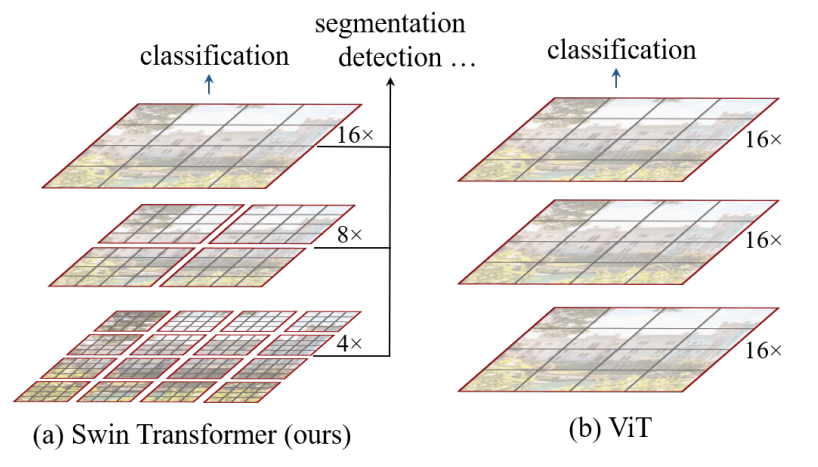

- 階層的特徴マップ:Swin Transformerは、より深い層で画像パッチ(灰色部分)を結合することで、階層的特徴マップを構築します。

- 線形計算量:各局所ウィンドウ(赤色部分)内でのみ自己注意を計算するため、入力画像サイズに対して線形の計算量を持ちます。これにより、画像分類や密集認識タスクの汎用バックボーンネットワークとして機能します。

- 比較優位性:以前のビジュアルTransformerと比較して、異なる解像度の特徴マップを生成でき、グローバル自己注意計算に伴う2次の計算量を回避します。

出典

出典

💻 使用例

基本的な使用法

from transformers import AutoFeatureExtractor, SwinForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

feature_extractor = AutoFeatureExtractor.from_pretrained("microsoft/swin-small-patch4-window7-224")

model = SwinForImageClassification.from_pretrained("microsoft/swin-small-patch4-window7-224")

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("Predicted class:", model.config.id2label[predicted_class_idx])

📚 ドキュメント

想定用途と制限

オリジナルのモデルを使用して画像分類を行うことができます。特定のタスクに対して微調整されたバージョンを取得するには、モデルセンターを参照してください。

BibTeX引用と引用情報

@article{DBLP:journals/corr/abs-2103-14030,

author = {Ze Liu and

Yutong Lin and

Yue Cao and

Han Hu and

Yixuan Wei and

Zheng Zhang and

Stephen Lin and

Baining Guo},

title = {Swin Transformer: Hierarchical Vision Transformer using Shifted Windows},

journal = {CoRR},

volume = {abs/2103.14030},

year = {2021},

url = {https://arxiv.org/abs/2103.14030},

eprinttype = {arXiv},

eprint = {2103.14030},

timestamp = {Thu, 08 Apr 2021 07:53:26 +0200},

biburl = {https://dblp.org/rec/journals/corr/abs-2103-14030.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

📄 ライセンス

このモデルはApache - 2.0ライセンスを採用しています。

情報テーブル

| 属性 |

詳細 |

| モデルタイプ |

Swin Transformer(小型モデル) |

| 学習データ |

ImageNet - 1k |

| 適用タスク |

画像分類、密集認識タスク |

免責事項

Swin Transformerを公開したチームはこのモデルのモデルカードを作成していません。このモデルカードはHugging Faceチームによって作成されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語