🚀 Swin Transformer (大規模モデル)

Swin Transformerモデルは、解像度384x384のImageNet - 21k(1400万枚の画像、21,841クラス)で事前学習されています。このモデルは、Liuらによる論文 Swin Transformer: Hierarchical Vision Transformer using Shifted Windows で紹介され、このリポジトリ で最初に公開されました。

免責事項:Swin Transformerを公開したチームはこのモデルのモデルカードを作成していないため、このモデルカードはHugging Faceチームによって作成されています。

🚀 クイックスタート

Swin Transformerモデルは、ImageNet - 21kで事前学習され、画像分類や密な認識タスクの汎用バックボーンとして機能します。以下のセクションでは、このモデルの詳細と使用方法を説明します。

✨ 主な機能

- 階層的特徴マップ:深い層で画像パッチをマージすることで、階層的な特徴マップを構築します。

- 線形計算量:各ローカルウィンドウ内でのみ自己注意を計算するため、入力画像サイズに対して線形の計算量を持ちます。

- 汎用性:画像分類と密な認識タスクの両方の汎用バックボーンとして使用できます。

📚 ドキュメント

モデルの説明

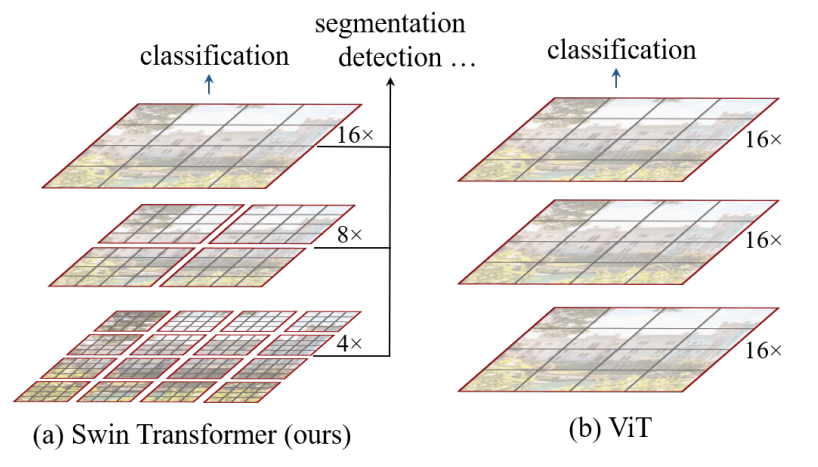

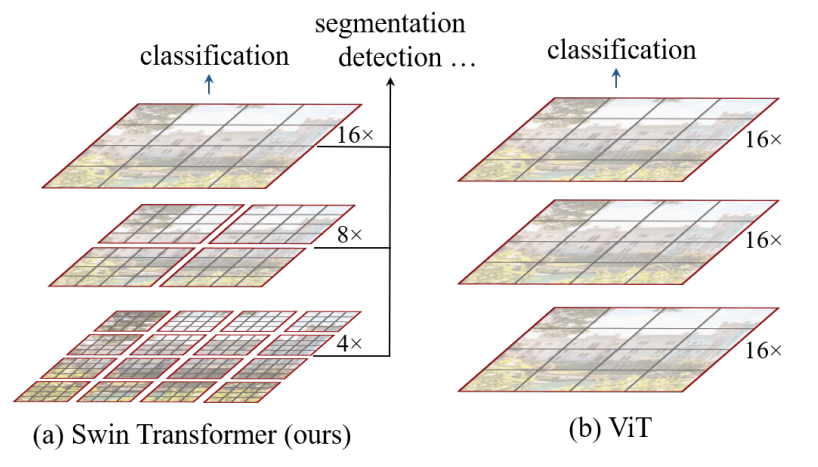

Swin TransformerはVision Transformerの一種です。深い層で画像パッチ(灰色で表示)をマージすることで階層的な特徴マップを構築し、各ローカルウィンドウ(赤色で表示)内でのみ自己注意を計算するため、入力画像サイズに対して線形の計算量を持ちます。このため、画像分類と密な認識タスクの両方の汎用バックボーンとして機能します。対照的に、以前のVision Transformerは単一の低解像度の特徴マップを生成し、グローバルに自己注意を計算するため、入力画像サイズに対して2次の計算量を持ちます。

出典

想定される用途と制限

この生モデルは画像分類に使用できます。関心のあるタスクで微調整されたバージョンを探すには、モデルハブ を参照してください。

使い方

以下は、COCO 2017データセットの画像を1,000のImageNetクラスのいずれかに分類するためにこのモデルを使用する方法です。

💻 使用例

基本的な使用法

from transformers import AutoFeatureExtractor, SwinForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

feature_extractor = AutoFeatureExtractor.from_pretrained("microsoft/swin-base-patch4-window12-384-in22k")

model = SwinForImageClassification.from_pretrained("microsoft/swin-base-patch4-window12-384-in22k")

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("予測されたクラス:", model.config.id2label[predicted_class_idx])

より多くのコード例については、ドキュメント を参照してください。

BibTeXエントリと引用情報

@article{DBLP:journals/corr/abs-2103-14030,

author = {Ze Liu and

Yutong Lin and

Yue Cao and

Han Hu and

Yixuan Wei and

Zheng Zhang and

Stephen Lin and

Baining Guo},

title = {Swin Transformer: Hierarchical Vision Transformer using Shifted Windows},

journal = {CoRR},

volume = {abs/2103.14030},

year = {2021},

url = {https://arxiv.org/abs/2103.14030},

eprinttype = {arXiv},

eprint = {2103.14030},

timestamp = {Thu, 08 Apr 2021 07:53:26 +0200},

biburl = {https://dblp.org/rec/journals/corr/abs-2103-14030.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

📄 ライセンス

このモデルはApache - 2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語