🚀 EMOVA-Qwen-2.5-3B

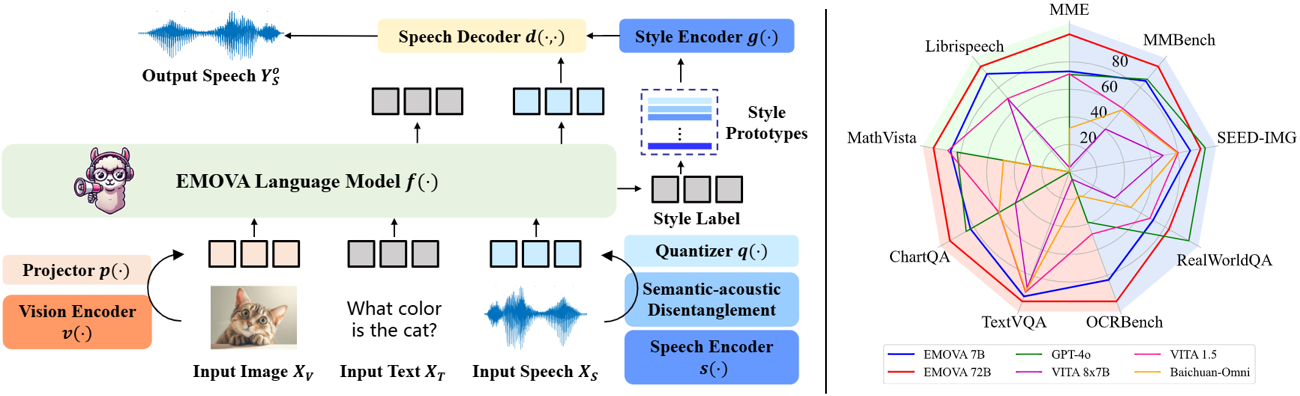

EMOVA(Emotionally Omni-present Voice Assistant)は、外部モデルに依存せずに、見る、聞く、話すことができる、新しいエンドツーエンドのオムニモーダル大規模言語モデル(LLM)です。オムニモーダル(すなわち、テキスト、ビジュアル、音声)の入力を与えると、EMOVAは音声デコーダとスタイルエンコーダを利用して、生き生きとした感情制御を伴うテキストと音声の両方の応答を生成することができます。EMOVAは、一般的なオムニモーダル理解と生成能力を備えており、高度なビジョン言語理解、感情的な音声対話、構造化データ理解を伴う音声対話において優れた性能を発揮します。

✨ 主な機能

- 最先端のオムニモーダル性能:EMOVAは、ビジョン言語と音声の両方のベンチマークで、同時に最先端の同等の結果を達成しています。最も性能の高いモデルであるEMOVA-72Bは、GPT-4oやGemini Pro 1.5などの商用モデルを上回っています。

- 感情的な音声対話:意味論的 - 音響的分離型の音声トークナイザと軽量なスタイル制御モジュールを採用して、シームレスなオムニモーダルアライメントと多様な音声スタイルの制御を実現しています。EMOVAは、24種類の音声スタイル制御(すなわち、2人の話者、3種類のピッチ、4種類の感情) を備えたバイリンガル(中国語と英語) の音声対話をサポートしています。

- 多様な構成:3つの構成、EMOVA-3B/7B/72Bをオープンソースで公開して、異なる計算予算でのオムニモーダル使用をサポートしています。モデルズーをチェックして、あなたの計算デバイスに最適なモデルを見つけてください!

📊 性能

| ベンチマーク |

EMOVA-3B |

EMOVA-7B |

EMOVA-72B |

GPT-4o |

VITA 8x7B |

VITA 1.5 |

Baichuan-Omni |

| MME |

2175 |

2317 |

2402 |

2310 |

2097 |

2311 |

2187 |

| MMBench |

79.2 |

83.0 |

86.4 |

83.4 |

71.8 |

76.6 |

76.2 |

| SEED-Image |

74.9 |

75.5 |

76.6 |

77.1 |

72.6 |

74.2 |

74.1 |

| MM-Vet |

57.3 |

59.4 |

64.8 |

- |

41.6 |

51.1 |

65.4 |

| RealWorldQA |

62.6 |

67.5 |

71.0 |

75.4 |

59.0 |

66.8 |

62.6 |

| TextVQA |

77.2 |

78.0 |

81.4 |

- |

71.8 |

74.9 |

74.3 |

| ChartQA |

81.5 |

84.9 |

88.7 |

85.7 |

76.6 |

79.6 |

79.6 |

| DocVQA |

93.5 |

94.2 |

95.9 |

92.8 |

- |

- |

- |

| InfoVQA |

71.2 |

75.1 |

83.2 |

- |

- |

- |

- |

| OCRBench |

803 |

814 |

843 |

736 |

678 |

752 |

700 |

| ScienceQA-Img |

92.7 |

96.4 |

98.2 |

- |

- |

- |

- |

| AI2D |

78.6 |

81.7 |

85.8 |

84.6 |

73.1 |

79.3 |

- |

| MathVista |

62.6 |

65.5 |

69.9 |

63.8 |

44.9 |

66.2 |

51.9 |

| Mathverse |

31.4 |

40.9 |

50.0 |

- |

- |

- |

- |

| Librispeech (WER↓) |

5.4 |

4.1 |

2.9 |

- |

3.4 |

8.1 |

- |

💻 使用例

このリポジトリには、EMOVAコードベースの元の形式で整理されたEMOVA-Qwen2.5-3Bのチェックポイントが含まれています。したがって、これはEMOVAコードベースと一緒に使用する必要があります。対応する設定ファイルは、こちらで提供されています。このチェックポイントを使用してウェブデモを起動するには、こちらをチェックしてください。

📄 ライセンス

このプロジェクトは、Apache 2.0ライセンスの下で公開されています。

📚 引用

@article{chen2024emova,

title={Emova: Empowering language models to see, hear and speak with vivid emotions},

author={Chen, Kai and Gou, Yunhao and Huang, Runhui and Liu, Zhili and Tan, Daxin and Xu, Jing and Wang, Chunwei and Zhu, Yi and Zeng, Yihan and Yang, Kuo and others},

journal={arXiv preprint arXiv:2409.18042},

year={2024}

}

📋 モデル情報

| 属性 |

詳情 |

| ライブラリ名 |

transformers |

| タグ |

Omni-modal-LLM、Multi-modal-LLM、Emotional-spoken-dialogue |

| ベースモデル |

Emova-ollm/qwen2vit600m、Emova-ollm/Qwen2.5-3B-Instruct_add_speech_token_4096_nostrip |

| データセット |

Emova-ollm/emova-alignment-7m、Emova-ollm/emova-sft-4m、Emova-ollm/emova-sft-speech-231k |

| 言語 |

en、zh |

| 新しいバージョン |

Emova-ollm/emova-qwen-2-5-3b-hf |

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語