🚀 mxbai-embed-large-v1-gguf

このモデルは、高品質な大規模データを使用して訓練された文埋め込みモデルです。GGUF形式のファイルを提供しており、複数の環境での使用に対応しています。

🚀 クイックスタート

モデル作成者: MixedBread AI

元のモデル: mxbai-embed-large-v1

✨ 主な機能

元の説明

これは当社の基本的な文埋め込みモデルです。高品質な大規模データを使用して、AnglE損失を用いて訓練されました。BERT-largeスケールでSOTA性能を達成しています。詳細はブログ記事を参照してください。

説明

このリポジトリには、mxbai-embed-large-v1埋め込みモデルのGGUF形式のファイルが含まれています。

これらのファイルは、consumer RTX 4090上でllama.cpp PR 5500、コミット 34aa045de を使用して変換および量子化されました。

このモデルは、最大512トークンのコンテキストをサポートしています。

互換性

これらのファイルは、コミット 4524290e8 以降の llama.cpp およびバージョン0.2.19以降の LM Studio と互換性があります。

📚 ドキュメント

量子化方法の説明

詳細を表示するにはクリック

利用可能な方法は以下の通りです。

* GGML_TYPE_Q2_K - 16個のブロックを含むスーパーブロックでの「タイプ1」の2ビット量子化。各ブロックには16個の重みがあります。ブロックのスケールと最小値は4ビットで量子化されます。これにより、重み1つあたり実効的に2.5625ビット (bpw) が使用されます。

* GGML_TYPE_Q3_K - 16個のブロックを含むスーパーブロックでの「タイプ0」の3ビット量子化。各ブロックには16個の重みがあります。スケールは6ビットで量子化されます。これにより、3.4375bpwが使用されます。

* GGML_TYPE_Q4_K - 8個のブロックを含むスーパーブロックでの「タイプ1」の4ビット量子化。各ブロックには32個の重みがあります。スケールと最小値は6ビットで量子化されます。これにより、4.5bpwが使用されます。

* GGML_TYPE_Q5_K - 「タイプ1」の5ビット量子化。GGML_TYPE_Q4_Kと同じスーパーブロック構造で、5.5bpwになります。

* GGML_TYPE_Q6_K - 「タイプ0」の6ビット量子化。16個のブロックを含むスーパーブロック。各ブロックには16個の重みがあります。スケールは8ビットで量子化されます。これにより、6.5625bpwが使用されます。

以下の「提供されるファイル」表を参照して、どのファイルがどの方法を使用しているかを確認してください。

提供されるファイル

💻 使用例

基本的な使用法

llama.cppでの使用例

単一の埋め込みを計算するには、llama.cppをビルドして以下のコマンドを実行します。

./embedding -ngl 99 -m [filepath-to-gguf].gguf -p 'search_query: What is TSNE?'

また、トークンの総数がコンテキスト長を超えない限り、複数のテキストをバッチで送信して埋め込むこともできます。embeddingの例では、最初の3つの埋め込みのみが表示されます。

texts.txt:

search_query: What is TSNE?

search_query: Who is Laurens Van der Maaten?

複数の埋め込みを計算するには、以下のコマンドを実行します。

./embedding -ngl 99 -m [filepath-to-gguf].gguf -f texts.txt

LM Studioでの使用例

以下から0.2.19ベータビルドをダウンロードします。

Windows MacOS Linux

インストール後、アプリを開きます。ホーム画面は以下のように表示されます。

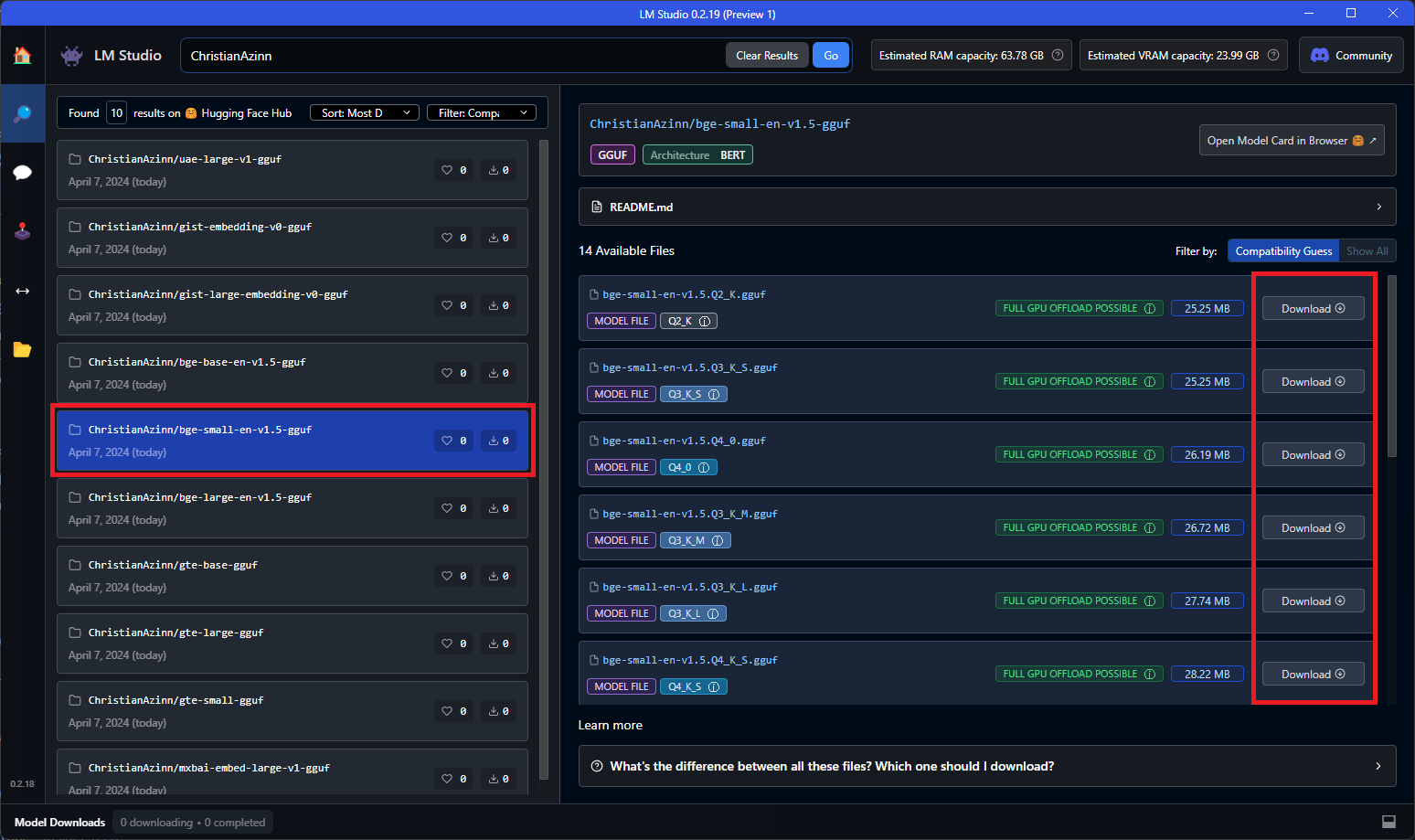

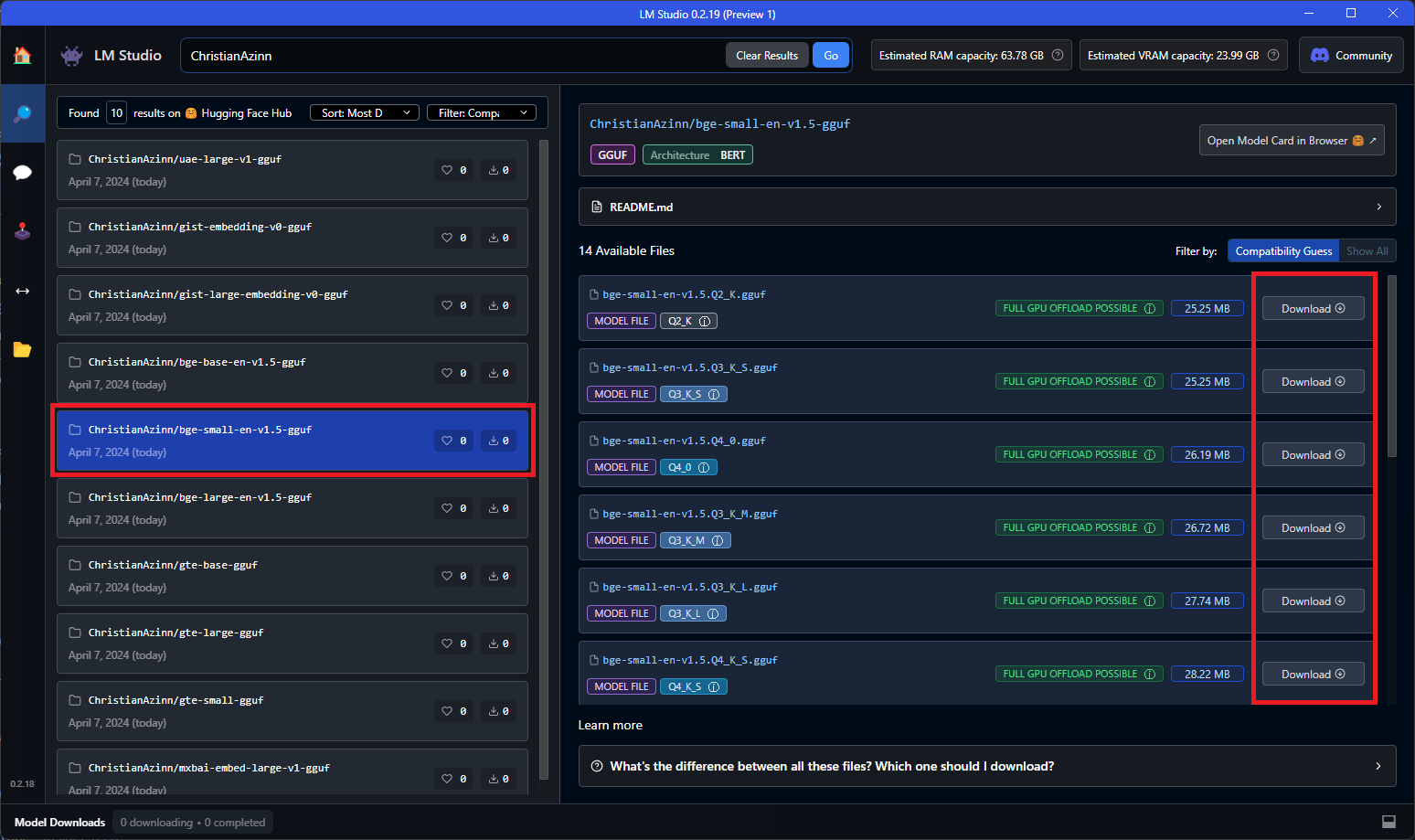

メイン検索バーで「ChristianAzinn」を検索するか、左メニューの「Search」タブに移動してそこで名前を検索します。

表示されたモデルから自分のモデルを選択し(この例では bge-small-en-v1.5-gguf を使用)、ダウンロードする量子化を選択します。このモデルは比較的小さいため、Q8_0をお勧めします。一般的に、リストの下に行くほど(または数字が大きくなるほど)、ファイルサイズが大きく、パフォーマンスが良くなります。

モデルが正常にダウンロードされると、緑色のチェックマークと「Downloaded」という単語が表示されます。これにはネットワーク速度に応じて時間がかかる場合があります。

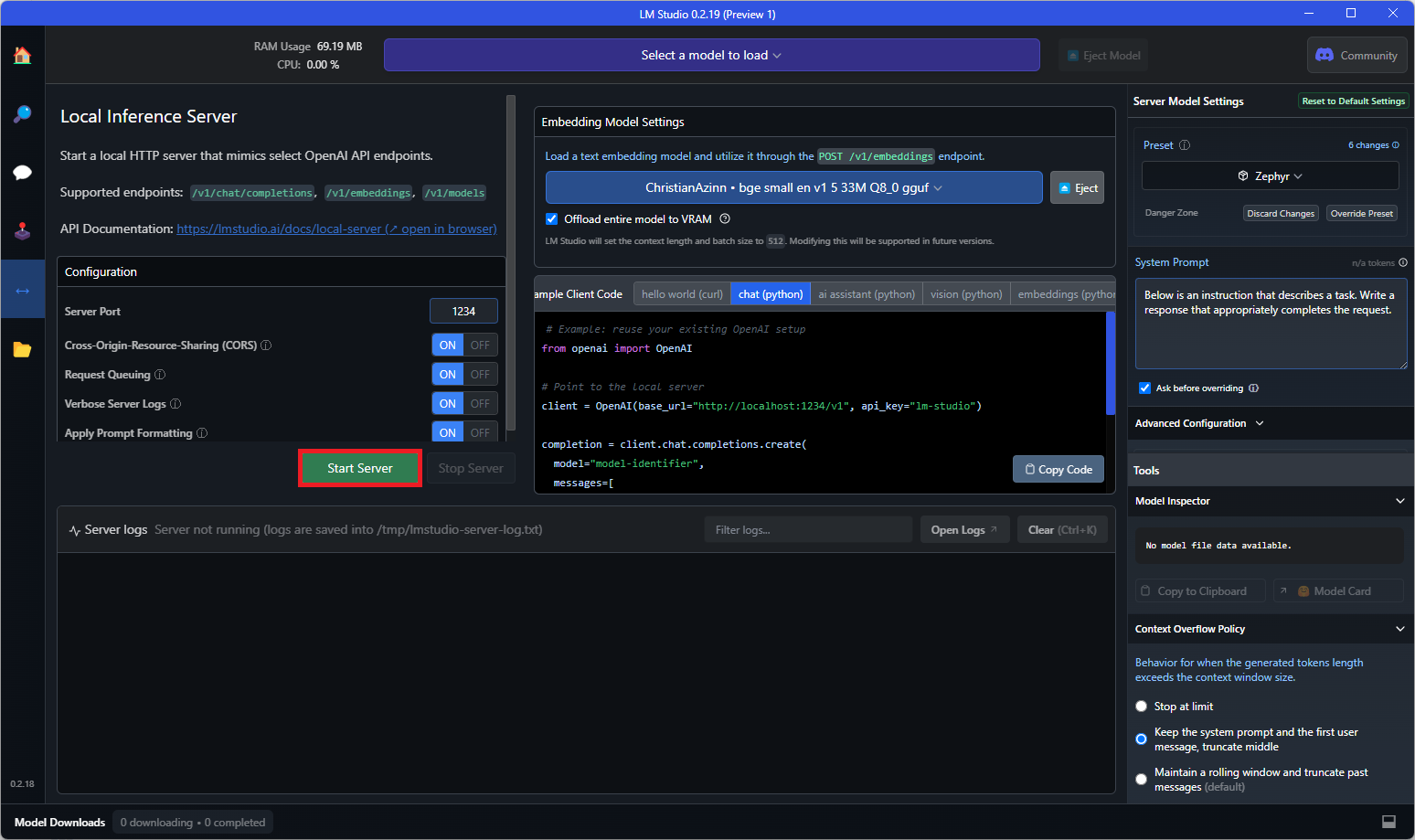

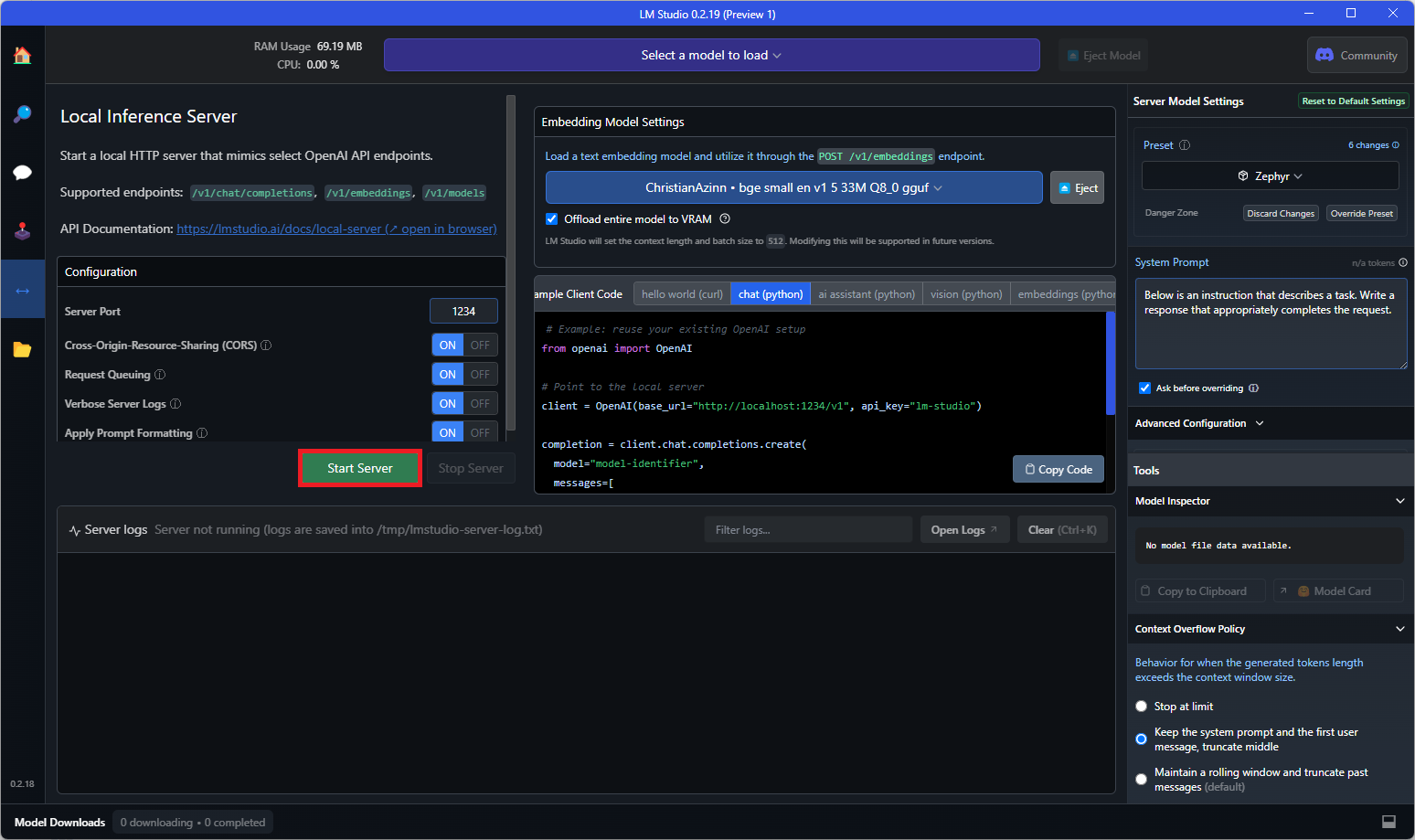

このモデルのダウンロードが完了したら、左メニューの「Local Server」タブに移動し、テキスト埋め込みモデルのローダーを開きます。このローダーはバージョン0.2.19以前では表示されないため、正しいバージョンをダウンロードしていることを確認してください。

表示されるドロップダウンから、先ほどダウンロードしたモデルを選択してロードします。VRAMに完全に収まらない場合は、右側のメニューでGPUオフロードなどの設定を調整する必要がある場合があります。

最後に、「Start Server」ボタンをクリックします。

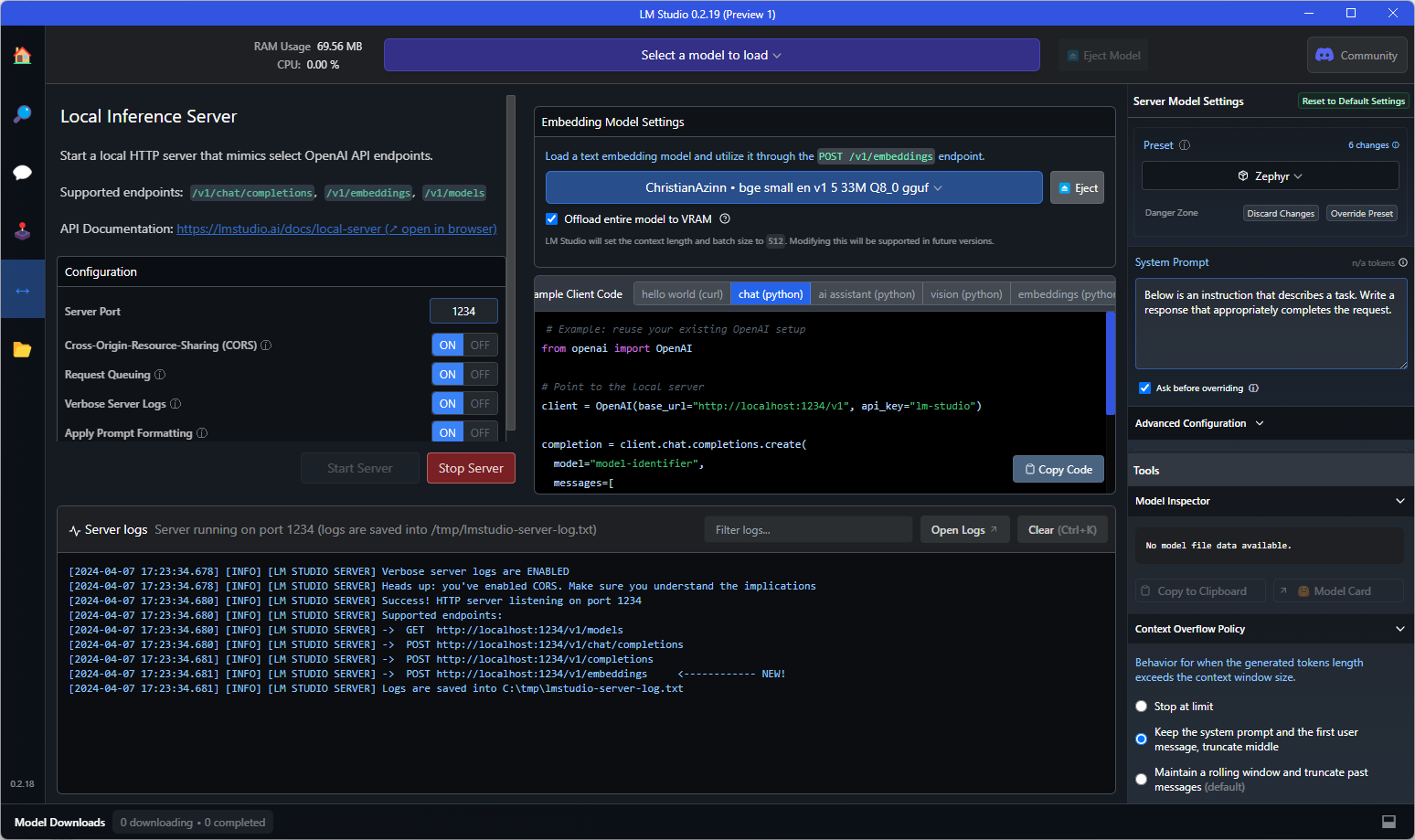

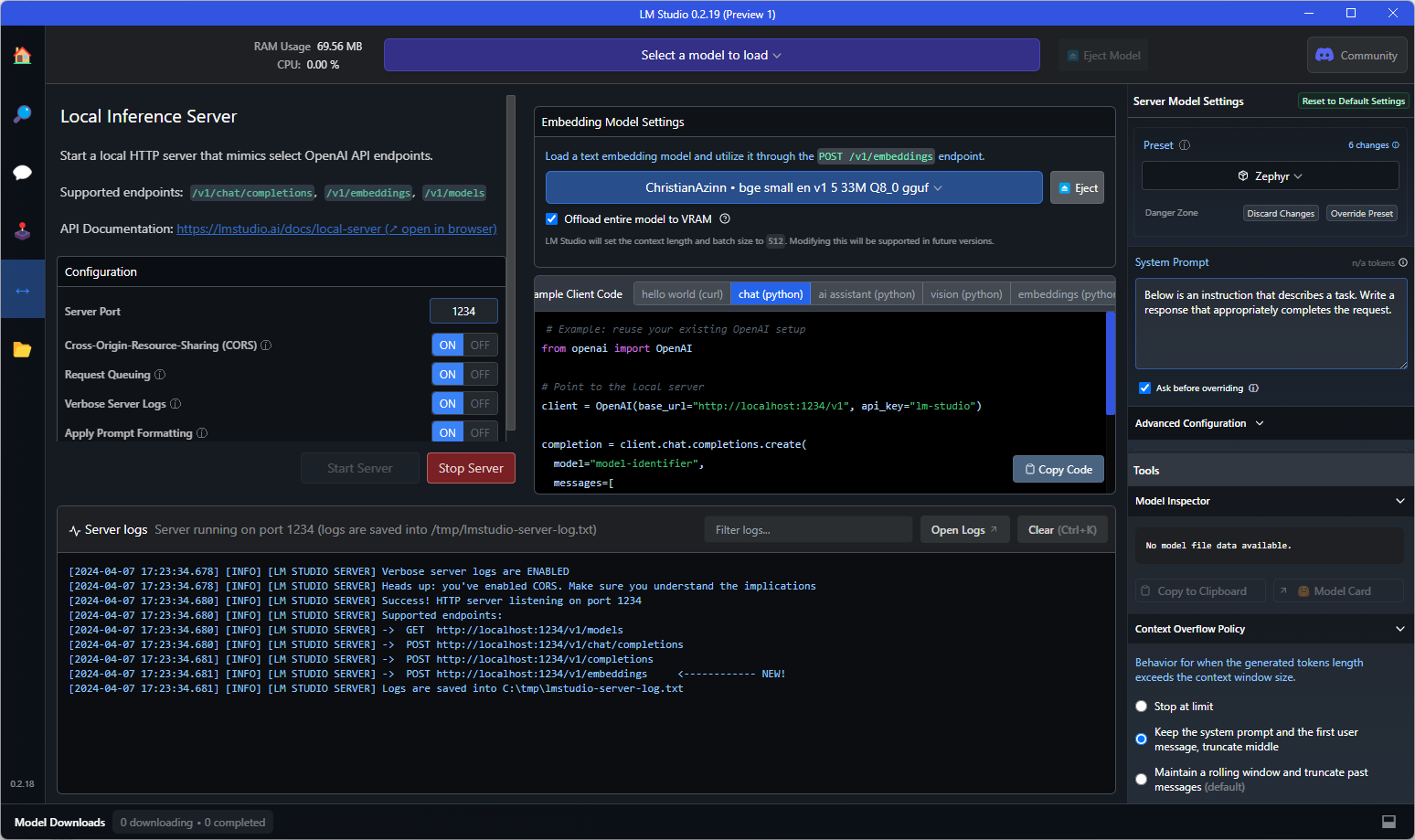

コンソールに以下のようなテキストが表示されれば、準備完了です!これを、OpenAI埋め込みAPIを必要とする任意のアプリケーションでそのまま置き換えて使用することができます。また、エンドポイントに直接クエリを送信してテストすることもできます。

APIエンドポイントへの例のcurlリクエスト:

curl http://localhost:1234/v1/embeddings \

-H "Content-Type: application/json" \

-d '{

"input": "Your text string goes here",

"model": "model-identifier-here"

}'

詳細については、LM Studioのテキスト埋め込みドキュメントを参照してください。

📄 ライセンス

このモデルは、Apache 2.0ライセンスの下で提供されています。

謝辞

LM StudioチームとオープンソースAIに取り組んでいるすべての方々に感謝します。

このREADMEは、別の優れた埋め込みモデルである nomic-ai-embed-text-v1.5-GGUF のREADMEや、伝説的な TheBloke のREADMEに触発されて作成されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語