🚀 mxbai-embed-large-v1-gguf

本項目提供了 mxbai-embed-large-v1 模型的 GGUF 格式文件,可用於特徵提取,在 BERT 大規模模型上實現了 SOTA 性能。

🚀 快速開始

與 llama.cpp 結合使用示例

若要計算單個嵌入向量,需先構建 llama.cpp 並運行以下命令:

./embedding -ngl 99 -m [filepath-to-gguf].gguf -p 'search_query: What is TSNE?'

你也可以提交一批文本進行嵌入處理,只要總令牌數不超過上下文長度即可。embedding 示例僅展示前三個嵌入向量。

texts.txt 文件內容如下:

search_query: What is TSNE?

search_query: Who is Laurens Van der Maaten?

計算多個嵌入向量的命令如下:

./embedding -ngl 99 -m [filepath-to-gguf].gguf -f texts.txt

與 LM Studio 結合使用示例

從以下鏈接下載 0.2.19 測試版:Windows MacOS Linux

安裝完成後,打開應用程序。主界面應如下所示:

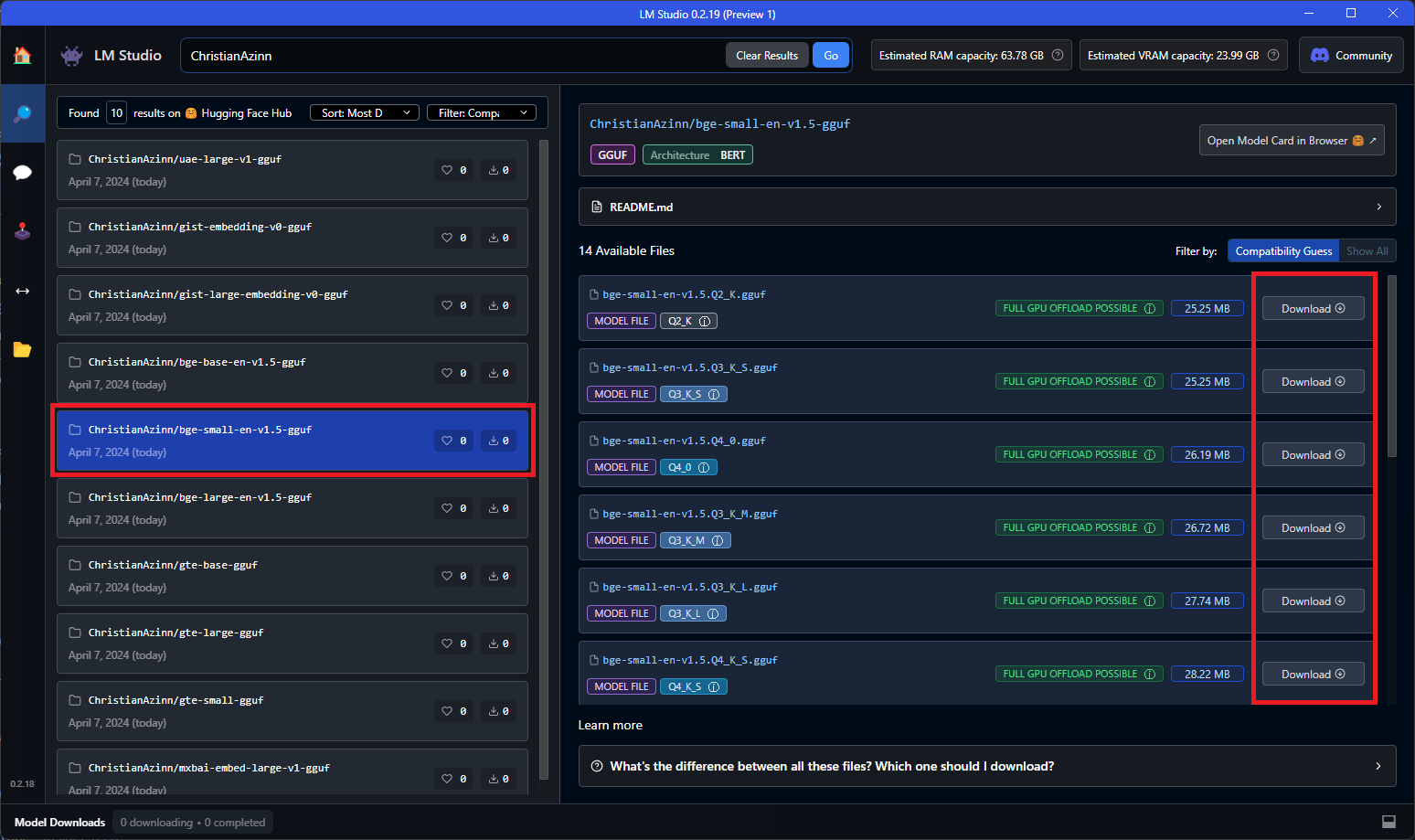

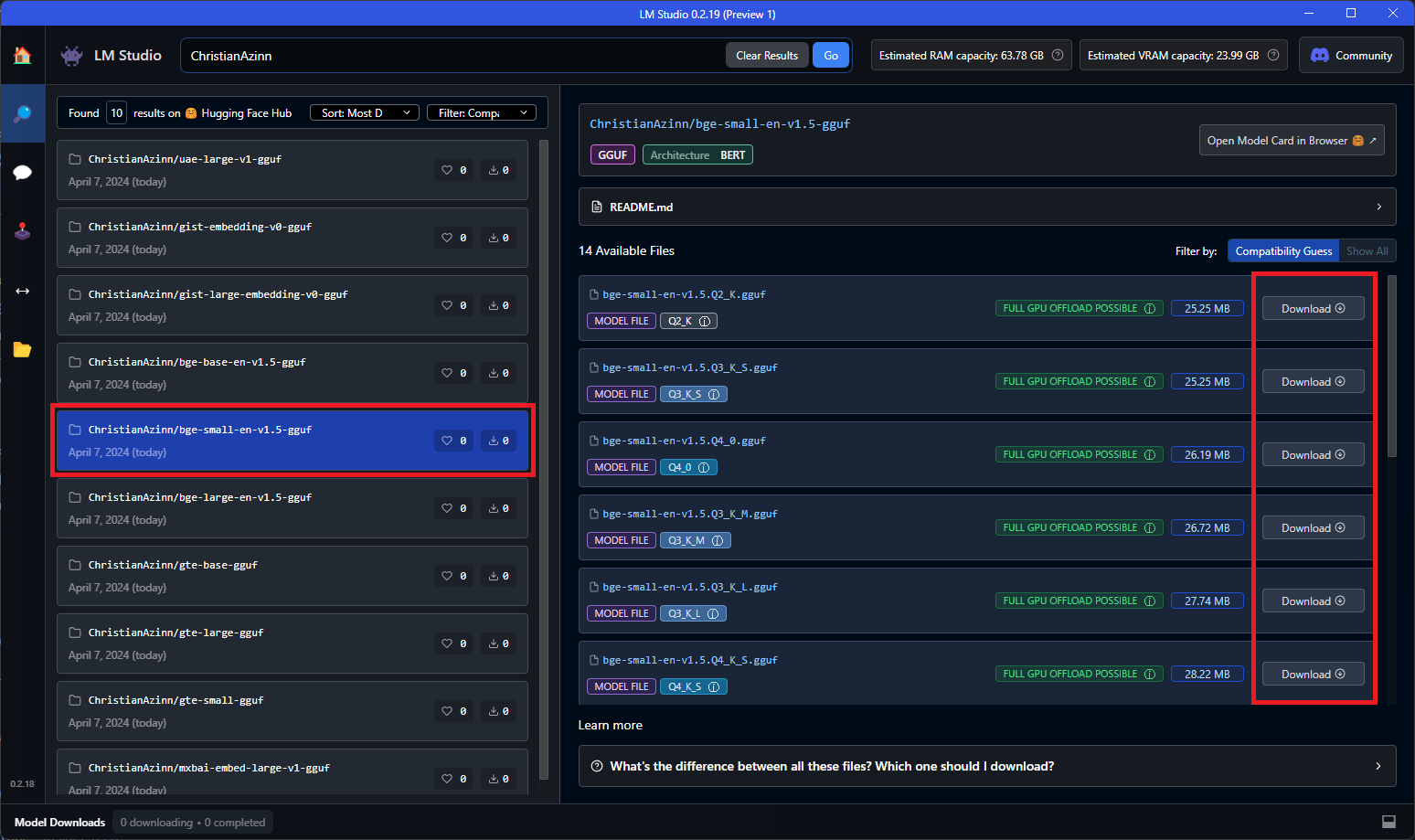

在主搜索欄中搜索 “ChristianAzinn”,或者點擊左側菜單中的 “搜索” 標籤進行搜索。

從搜索結果中選擇你的模型(本示例使用 bge-small-en-v1.5-gguf),並選擇要下載的量化版本。由於該模型較小,建議選擇 Q8_0,若條件允許也可選擇 f16/32。通常,列表越靠下(或數字越大),文件越大,性能越好。

模型下載成功後,你將看到綠色對勾和 “已下載” 字樣,下載時間取決於你的網絡速度。

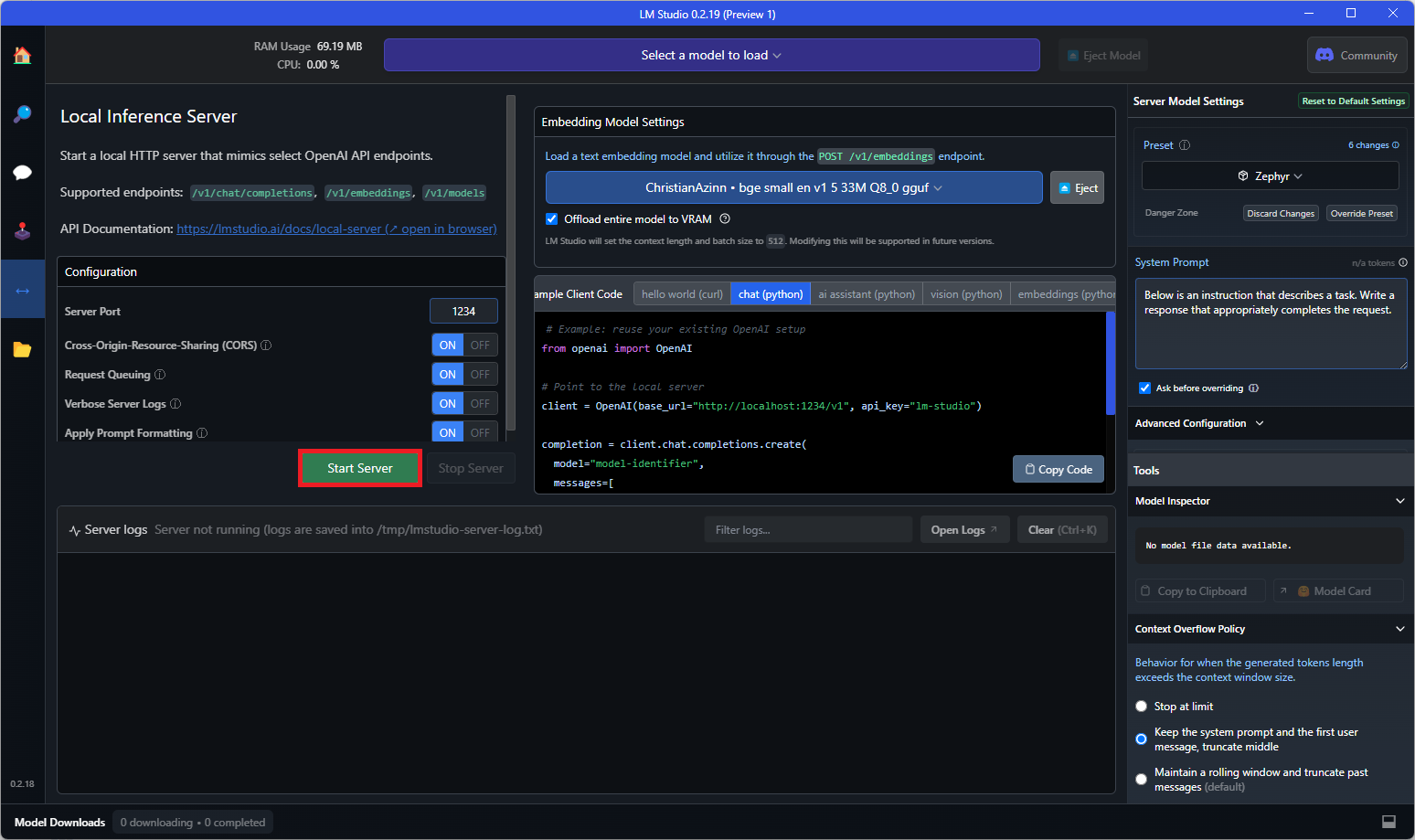

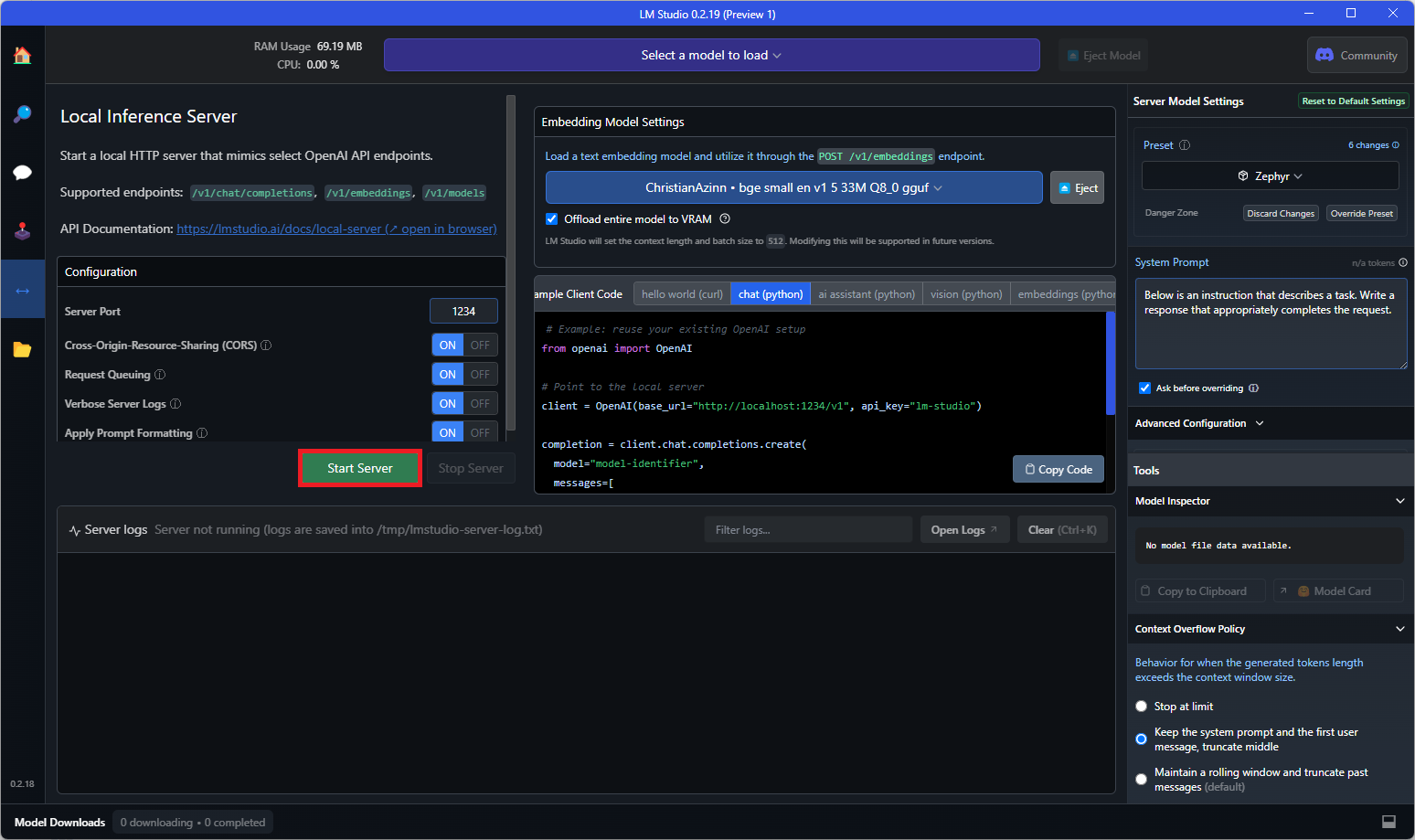

模型下載完成後,點擊左側菜單中的 “本地服務器” 標籤,打開文本嵌入模型加載器。該加載器在 0.2.19 版本之前不可用,請確保下載的是正確版本。

從下拉列表中選擇剛剛下載的模型進行加載。若模型無法完全加載到顯存中,你可能需要在右側菜單中調整配置,如 GPU 卸載。

最後,點擊 “啟動服務器” 按鈕:

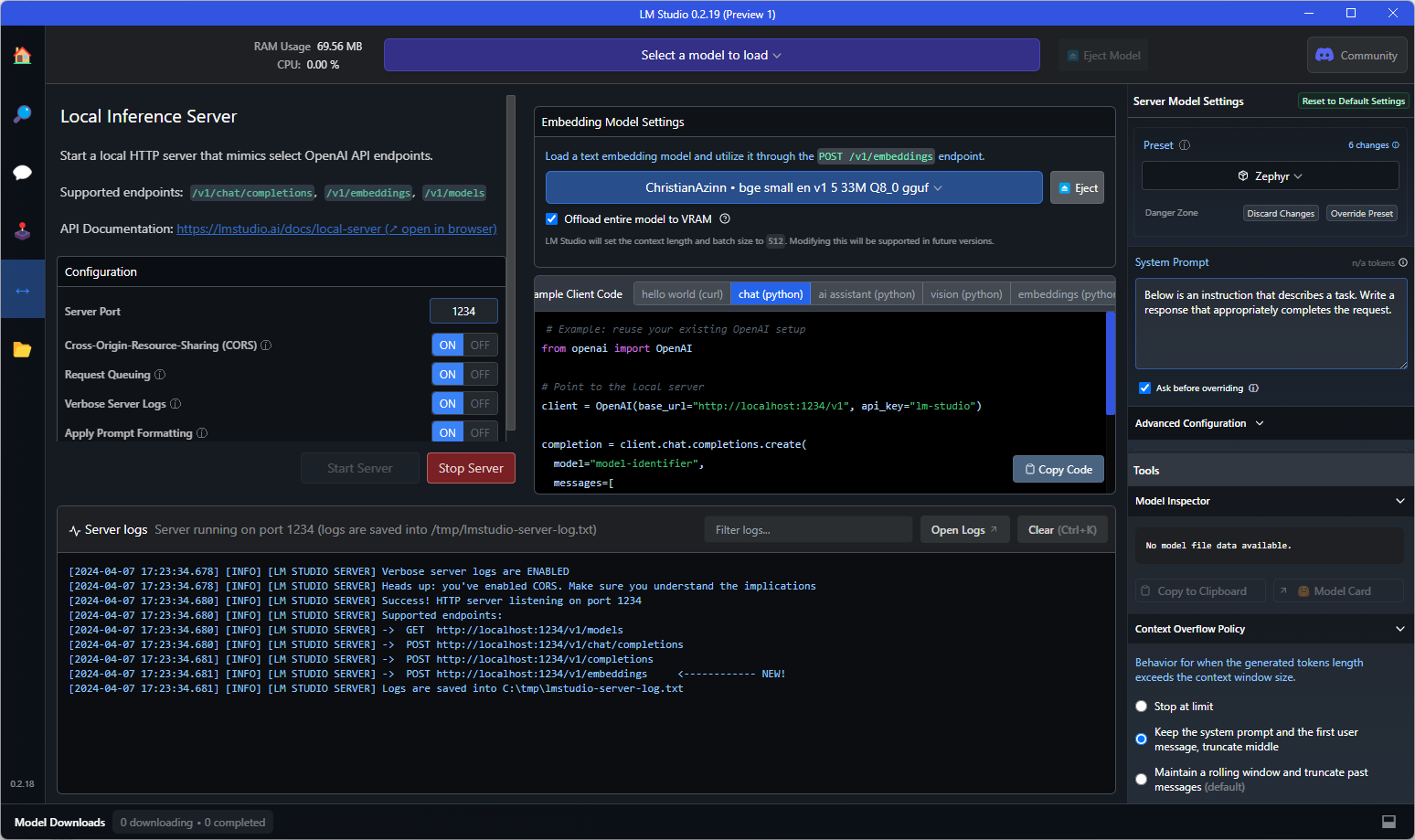

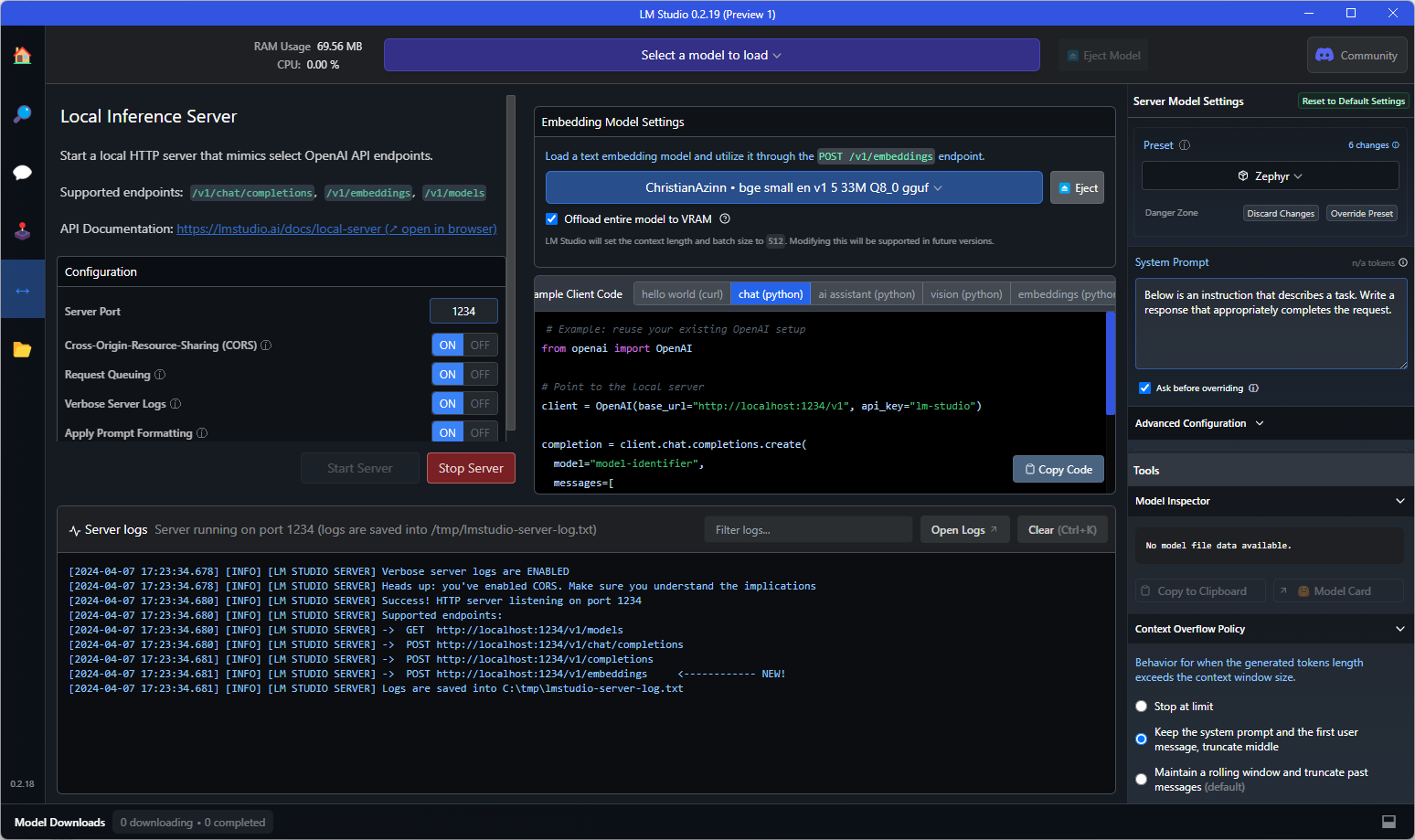

若在控制檯看到如下文本,則表示一切就緒!你可以在任何需要的應用程序中直接替換 OpenAI 嵌入 API 使用該模型,也可以直接查詢端點進行測試。

以下是一個向 API 端點發送的示例 curl 請求:

curl http://localhost:1234/v1/embeddings \

-H "Content-Type: application/json" \

-d '{

"input": "Your text string goes here",

"model": "model-identifier-here"

}'

更多信息請參考 LM Studio 文本嵌入文檔。

✨ 主要特性

📚 詳細文檔

原始模型描述

這是我們的基礎句子嵌入模型,它使用 AnglE 損失函數在高質量大規模數據上進行訓練,在 BERT 大規模模型上取得了 SOTA 性能。更多信息請查看我們的 博客文章。

本倉庫描述

本倉庫包含 mxbai-embed-large-v1 嵌入模型的 GGUF 格式文件。

這些文件是使用 llama.cpp PR 5500,提交記錄為 34aa045de,在消費級 RTX 4090 上進行轉換和量化的。

該模型支持最多 512 個令牌的上下文。

兼容性

這些文件與截至提交記錄 4524290e8 的 llama.cpp 兼容,也與版本 0.2.19 的 LM Studio 兼容。

量化方法說明

點擊查看詳情

可用的量化方法如下:

* GGML_TYPE_Q2_K - “類型 1” 2 位量化,超級塊包含 16 個塊,每個塊有 16 個權重。塊的縮放因子和最小值使用 4 位量化,最終每個權重有效使用 2.5625 位(bpw)。

* GGML_TYPE_Q3_K - “類型 0” 3 位量化,超級塊包含 16 個塊,每個塊有 16 個權重。縮放因子使用 6 位量化,最終每個權重使用 3.4375 位。

* GGML_TYPE_Q4_K - “類型 1” 4 位量化,超級塊包含 8 個塊,每個塊有 32 個權重。縮放因子和最小值使用 6 位量化,最終每個權重使用 4.5 位。

* GGML_TYPE_Q5_K - “類型 1” 5 位量化,與 GGML_TYPE_Q4_K 具有相同的超級塊結構,最終每個權重使用 5.5 位。

* GGML_TYPE_Q6_K - “類型 0” 6 位量化,超級塊有 16 個塊,每個塊有 16 個權重。縮放因子使用 8 位量化,最終每個權重使用 6.5625 位。

請參考下面的 “提供的文件” 表格,瞭解哪些文件使用了哪些方法以及如何使用。

提供的文件

📄 許可證

本模型採用 Apache-2.0 許可證。

致謝

感謝 LM Studio 團隊以及所有從事開源 AI 工作的人員。

本 README 受 nomic-ai-embed-text-v1.5-GGUF(另一個優秀的嵌入模型)和傳奇的 TheBloke 的 README 啟發。

模型元信息

| 屬性 |

詳情 |

| 模型類型 |

BERT |

| 模型創建者 |

MixedBread AI |

| 量化者 |

ChristianAzinn |

| 庫名稱 |

sentence-transformers |

| 任務標籤 |

特徵提取 |

| 標籤 |

mteb、transformers、transformers.js、gguf |

| 基礎模型 |

mixedbread-ai/mxbai-embed-large-v1 |

| 推理 |

否 |

| 語言 |

英語 |

| 許可證 |

Apache-2.0 |

| 模型名稱 |

mxbai-embed-large-v1 |

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語