🚀 WizardMath: 強化進化命令(RLEIF)による大規模言語モデルの数学的推論能力の強化

WizardMathは、強化進化命令(RLEIF)を通じて大規模言語モデルの数学的推論能力を強化するプロジェクトです。複数のモデルバージョンを提供し、様々なベンチマークで高い性能を発揮しています。

🤗 HFリポジトリ •🐱 GitHubリポジトリ • 🐦 Twitter • 📃 [WizardLM] • 📃 [WizardCoder] • 📃 [WizardMath]

👋 Discordに参加しましょう

📊 モデル情報

WizardCoder関連モデル

WizardMath関連モデル

WizardLM関連モデル

| モデル |

チェックポイント |

論文 |

MT-Bench |

AlpacaEval |

GSM8k |

HumanEval |

ライセンス |

| WizardLM-70B-V1.0 |

🤗 HFリンク |

📃近日公開予定 |

7.78 |

92.91% |

77.6% |

50.6 pass@1 |

Llama 2 ライセンス |

| WizardLM-13B-V1.2 |

🤗 HFリンク |

|

7.06 |

89.17% |

55.3% |

36.6 pass@1 |

Llama 2 ライセンス |

| WizardLM-13B-V1.1 |

🤗 HFリンク |

|

6.76 |

86.32% |

|

25.0 pass@1 |

非商用 |

| WizardLM-30B-V1.0 |

🤗 HFリンク |

|

7.01 |

|

|

37.8 pass@1 |

非商用 |

| WizardLM-13B-V1.0 |

🤗 HFリンク |

|

6.35 |

75.31% |

|

24.0 pass@1 |

非商用 |

| WizardLM-7B-V1.0 |

🤗 HFリンク |

📃 [WizardLM] |

|

|

|

19.1 pass@1 |

非商用 |

GitHubリポジトリ: https://github.com/nlpxucan/WizardLM/tree/main/WizardMath

Twitter: https://twitter.com/WizardLM_AI/status/1689998428200112128

Discord: https://discord.gg/VZjjHtWrKs

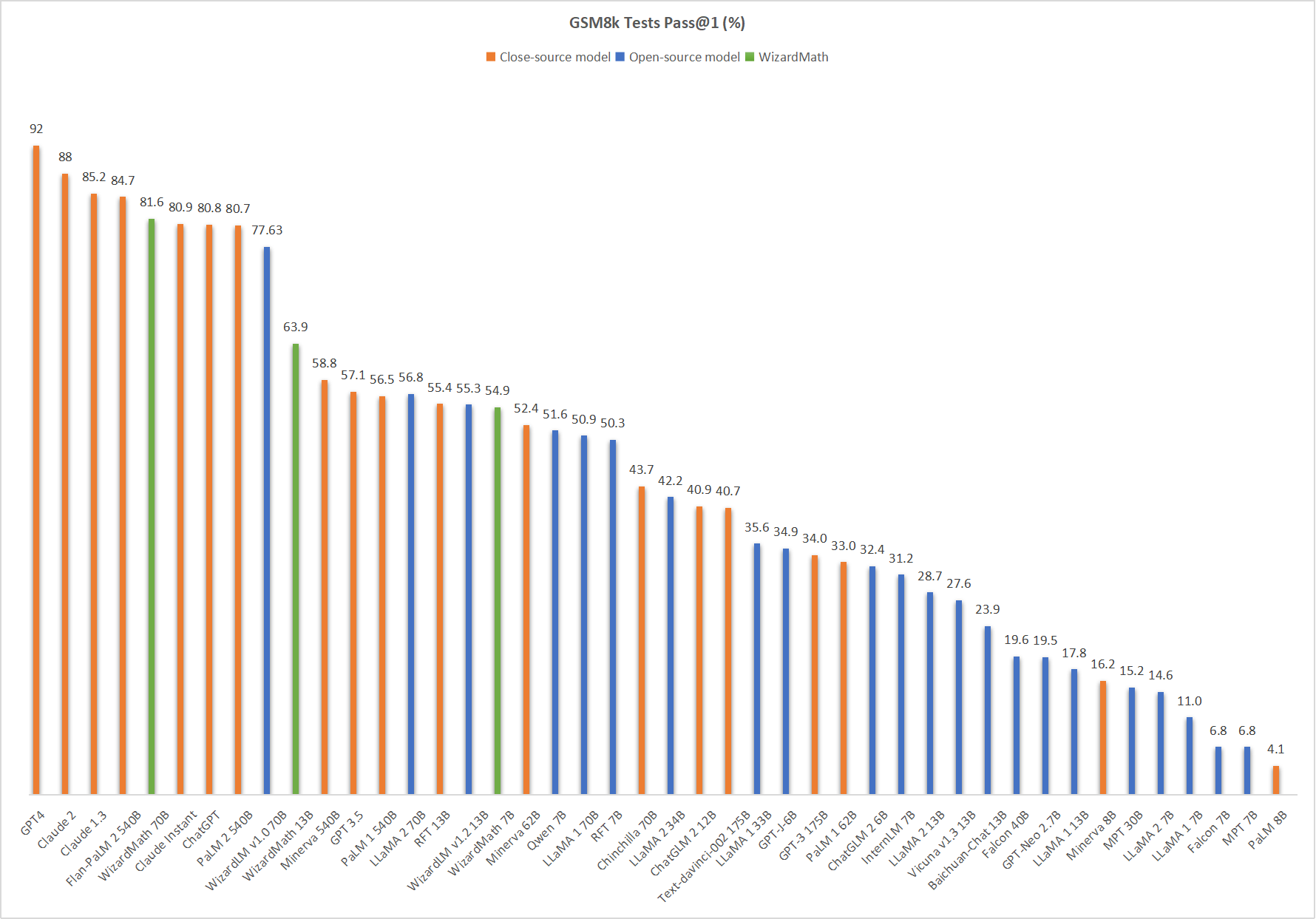

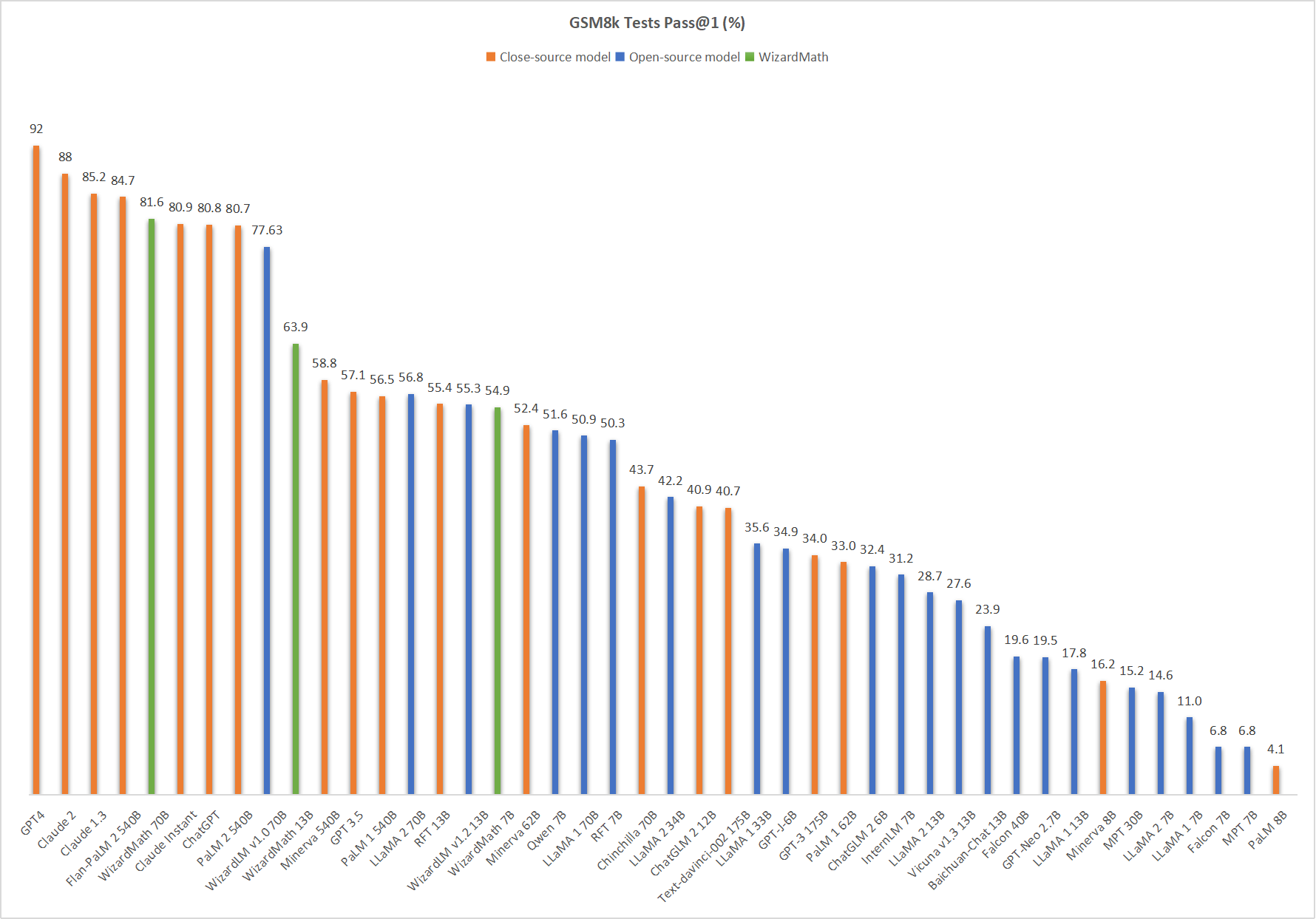

📊 WizardMath-V1.0と他のLLMの比較

🔥 以下の図は、私たちのWizardMath-70B-V1.0がこのベンチマークで5位にランクインし、ChatGPT (81.6 vs. 80.8)、Claude Instant (81.6 vs. 80.9)、PaLM 2 540B (81.6 vs. 80.7)を上回っていることを示しています。

⚠️ 重要提示

モデルのシステムプロンプトの使用に関する注意事項です。私たちと厳密に同じシステムプロンプトを使用してください。また、定量化されたバージョンの精度は保証していません。

デフォルトバージョン

"Below is an instruction that describes a task. Write a response that appropriately completes the request.\n\n### Instruction:\n{instruction}\n\n### Response:"

CoTバージョン

(❗ 簡単な数学問題に対しては、CoTプロンプトの使用はお勧めしません。)

"Below is an instruction that describes a task. Write a response that appropriately completes the request.\n\n### Instruction:\n{instruction}\n\n### Response: Let's think step by step."

💻 WizardMath推論デモスクリプト

私たちは、WizardMathの推論デモコードをこちらで提供しています。

⚠️ 重要提示

最近、組織全体のコード、データ、モデルのオープンソースポリシーと規制に明確な変更がありました。それにもかかわらず、私たちはまだモデルの重みを公開するために努力してきましたが、データにはより厳格な審査が必要であり、法務チームによるレビュー中です。研究者は、許可なく公開する権限を持っていません。ご理解いただければ幸いです。

📄 引用

このリポジトリのデータ、方法、またはコードを使用する場合は、以下のように引用してください。

@article{luo2023wizardmath,

title={WizardMath: Empowering Mathematical Reasoning for Large Language Models via Reinforced Evol-Instruct},

author={Luo, Haipeng and Sun, Qingfeng and Xu, Can and Zhao, Pu and Lou, Jianguang and Tao, Chongyang and Geng, Xiubo and Lin, Qingwei and Chen, Shifeng and Zhang, Dongmei},

journal={arXiv preprint arXiv:2308.09583},

year={2023}

}

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語