🚀 M-CTC-T

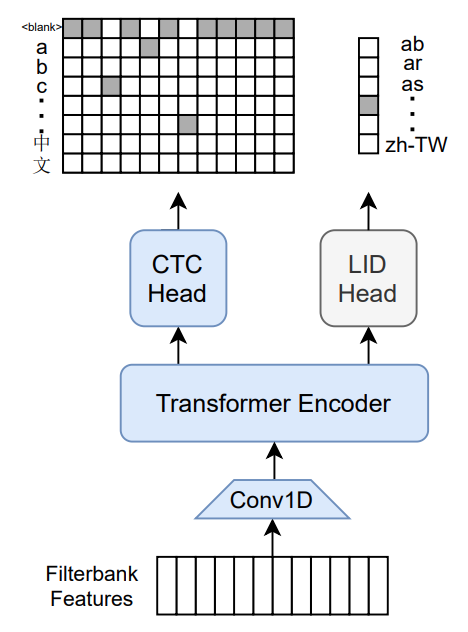

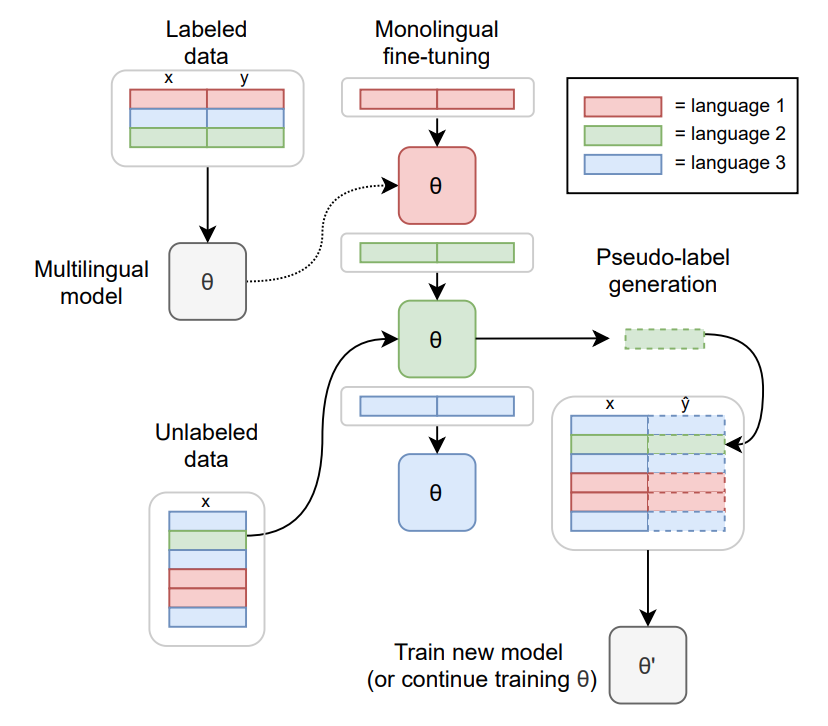

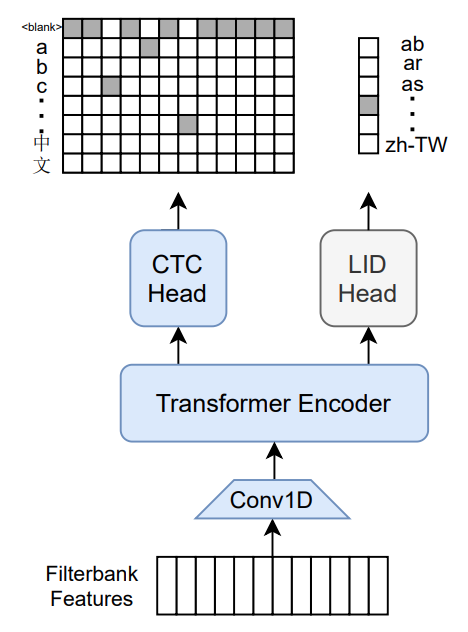

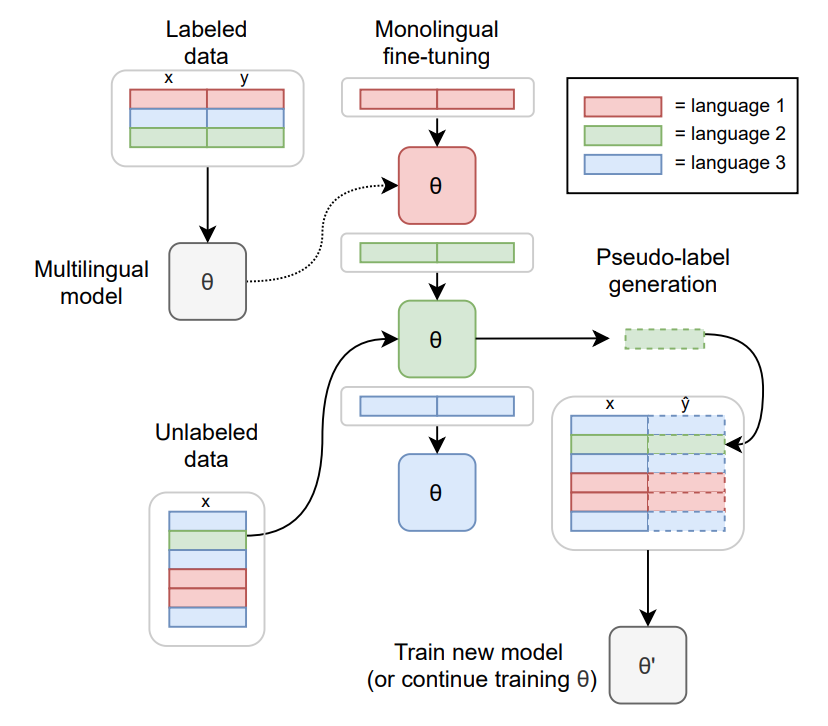

Meta AIによる大規模な多言語音声認識モデルです。このモデルは10億パラメータのTransformerエンコーダで、8065の文字ラベルに対するCTCヘッドと60の言語IDラベルに対する言語識別ヘッドを備えています。Common Voice(バージョン6.1、2020年12月リリース)とVoxPopuliで学習され、その後はCommon Voiceのみで学習されまし。ラベルは正規化されていない文字レベルの文字起こし(句読点や大文字は削除されていません)です。モデルは16Khzの音声信号からのメルフィルタバンク特徴量を入力とします。

オリジナルのFlashlightコード、モデルチェックポイント、およびColabノートブックは、https://github.com/flashlight/wav2letter/tree/main/recipes/mling_pl で見つけることができます。

✨ 主な機能

- 大規模な多言語音声認識が可能です。

- 10億パラメータのTransformerエンコーダを使用しています。

- 8065の文字ラベルに対するCTCヘッドと60の言語IDラベルに対する言語識別ヘッドを備えています。

📦 インストール

ドキュメントに具体的なインストール手順が記載されていないため、このセクションをスキップします。

💻 使用例

基本的な使用法

import torch

import torchaudio

from datasets import load_dataset

from transformers import MCTCTForCTC, MCTCTProcessor

model = MCTCTForCTC.from_pretrained("speechbrain/m-ctc-t-large")

processor = MCTCTProcessor.from_pretrained("speechbrain/m-ctc-t-large")

ds = load_dataset("patrickvonplaten/librispeech_asr_dummy", "clean", split="validation")

input_features = processor(ds[0]["audio"]["array"], sampling_rate=ds[0]["audio"]["sampling_rate"], return_tensors="pt").input_features

with torch.no_grad():

logits = model(input_features).logits

predicted_ids = torch.argmax(logits, dim=-1)

transcription = processor.batch_decode(predicted_ids)

高度な使用法

ドキュメントに高度な使用法のコード例が記載されていないため、このセクションをスキップします。

📚 ドキュメント

モデル情報

| 属性 |

详情 |

| モデルタイプ |

大規模な多言語音声認識モデル |

| 学習データ |

Common Voice(バージョン6.1、2020年12月リリース)とVoxPopuli |

引用情報

論文

著者: Loren Lugosch, Tatiana Likhomanenko, Gabriel Synnaeve, Ronan Collobert

@article{lugosch2021pseudo,

title={Pseudo-Labeling for Massively Multilingual Speech Recognition},

author={Lugosch, Loren and Likhomanenko, Tatiana and Synnaeve, Gabriel and Collobert, Ronan},

journal={ICASSP},

year={2022}

}

貢献者

Chan Woo Kim氏(https://huggingface.co/cwkeam )に、Flashlight C++からPyTorchへのモデルの移植に対して大きな感謝を表します。

学習方法

モデルの学習方法の詳細については、公式論文を参照してください。

評価結果

Common Voiceに対する結果(すべての言語で平均):

文字誤り率 (CER):

質問とヘルプ

このモデルに関する質問やヘルプが必要な場合は、このリポジトリでディスカッションを開くか、プルリクエストを送信し、@lorenlugosch、@cwkeamまたは@patrickvonplatenをタグ付けしてください。

📄 ライセンス

このモデルはApache-2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語