Wav2vec LnNor IPA Ft

W

Wav2vec LnNor IPA Ft

由 MultiBridge 开发

基于wav2vec2-base微调的音素识别模型,支持英语语音转国际音标(IPA)

下载量 16

发布时间 : 3/2/2025

模型简介

该模型通过对TIMIT和LnNor数据集的微调开发,专门用于音素识别任务,预测结果采用国际音标(IPA)表示。

模型特点

多数据集微调

结合TIMIT和LnNor数据集进行训练,增强模型泛化能力

国际音标输出

直接输出国际音标(IPA)表示,便于语音学研究

预训练特征保留

冻结编码器保留了wav2vec2-base的有用预学习特征

模型能力

英语音素识别

语音转音标

自动音标转写

使用案例

语音处理

自动音标转写

将原始语音转换为音素序列

语音处理组件

作为语音处理流程中的组件或原型开发

🚀 MultiBridge/wav2vec-LnNor-IPA-ft模型卡片

本模型专为音素识别任务而构建。它通过在TIMIT和LnNor数据集上微调wav2vec2基础模型而开发,预测结果采用国际音标(IPA)表示。

🚀 快速开始

使用以下代码开始使用该模型:

from transformers import Wav2Vec2Processor, Wav2Vec2ForCTC

from datasets import load_dataset

import torch

# load model and processor

processor = Wav2Vec2Processor.from_pretrained("MultiBridge/wav2vec-LnNor-IPA-ft")

model = Wav2Vec2ForCTC.from_pretrained("MultiBridge/wav2vec-LnNor-IPA-ft")

# load dummy dataset and read soundfiles

ds = load_dataset("hf-internal-testing/librispeech_asr_dummy", split="validation")

# tokenize

input_values = processor(ds[0]["audio"]["array"], return_tensors="pt").input_values

# retrieve logits

with torch.no_grad():

logits = model(input_values).logits

# take argmax and decode

predicted_ids = torch.argmax(logits, dim=-1)

transcription = processor.batch_decode(predicted_ids)

# => should give ['mɪstɝkwɪltɝɪzðəəpɑslʌvðəmɪdəlklæsəzændwiɑəɡlædtəwɛlkəmhɪzɡɑspəl'] for MISTER QUILTER IS THE APOSTLE OF THE MIDDLE CLASSES AND WE ARE GLAD TO WELCOME HIS GOSPEL

✨ 主要特性

- 基于Transformer架构,专为音素识别任务设计。

- 微调自facebook/wav2vec2-base模型。

- 支持英语的自动音素转录。

📦 安装指南

文档未提及具体安装步骤,故跳过该章节。

💻 使用示例

基础用法

from transformers import Wav2Vec2Processor, Wav2Vec2ForCTC

from datasets import load_dataset

import torch

# load model and processor

processor = Wav2Vec2Processor.from_pretrained("MultiBridge/wav2vec-LnNor-IPA-ft")

model = Wav2Vec2ForCTC.from_pretrained("MultiBridge/wav2vec-LnNor-IPA-ft")

# load dummy dataset and read soundfiles

ds = load_dataset("hf-internal-testing/librispeech_asr_dummy", split="validation")

# tokenize

input_values = processor(ds[0]["audio"]["array"], return_tensors="pt").input_values

# retrieve logits

with torch.no_grad():

logits = model(input_values).logits

# take argmax and decode

predicted_ids = torch.argmax(logits, dim=-1)

transcription = processor.batch_decode(predicted_ids)

# => should give ['mɪstɝkwɪltɝɪzðəəpɑslʌvðəmɪdəlklæsəzændwiɑəɡlædtəwɛlkəmhɪzɡɑspəl'] for MISTER QUILTER IS THE APOSTLE OF THE MIDDLE CLASSES AND WE ARE GLAD TO WELCOME HIS GOSPEL

📚 详细文档

模型详情

| 属性 | 详情 |

|---|---|

| 开发方 | Multibridge |

| 资助方 | EEA金融机制和挪威金融机制 |

| 共享方 | Multibridge |

| 模型类型 | Transformer |

| 语言 | 英语 |

| 许可证 | cc-by-4.0 |

| 微调基础模型 | facebook/wav2vec2-base |

用途

- 自动语音转录:将原始语音转换为音素序列。

- 语音处理应用:作为语音处理管道或原型的组件。

偏差、风险和局限性

- 数据特异性:通过排除短于2秒或长于30秒的录音,以及少于5个音素的标签,一些自然语音变化被忽略。这可能会影响模型在实际应用中的性能。模型的性能受TIMIT和LnNor数据集特征的影响,这可能导致潜在的偏差,特别是当目标应用涉及这些数据集中未充分代表的说话者或方言时。LnNor包含非母语语音和自动生成的标注,这些标注反映的是规范音素,而非自然语音或非母语发音的真实发音。这可能导致模型无法准确预测非母语语音。

- 冻结编码器:冻结编码器保留了有用的预学习特征,但也阻止了模型完全适应新数据集。

建议

评估模型在您特定用例中的性能。

训练详情

训练数据

- TIMIT:一个广泛用于语音转录的数据集,为语音研究提供了标准基准。

- LnNor:一个多语言数据集,包含挪威语、英语和波兰语的高质量语音记录。该数据集由具有不同语言水平的非母语人士编译而成。LnNor中的音素标注使用WebMAUS工具生成,这意味着它们代表的是规范音素,而非自然语音或非母语发音的真实发音。

训练过程

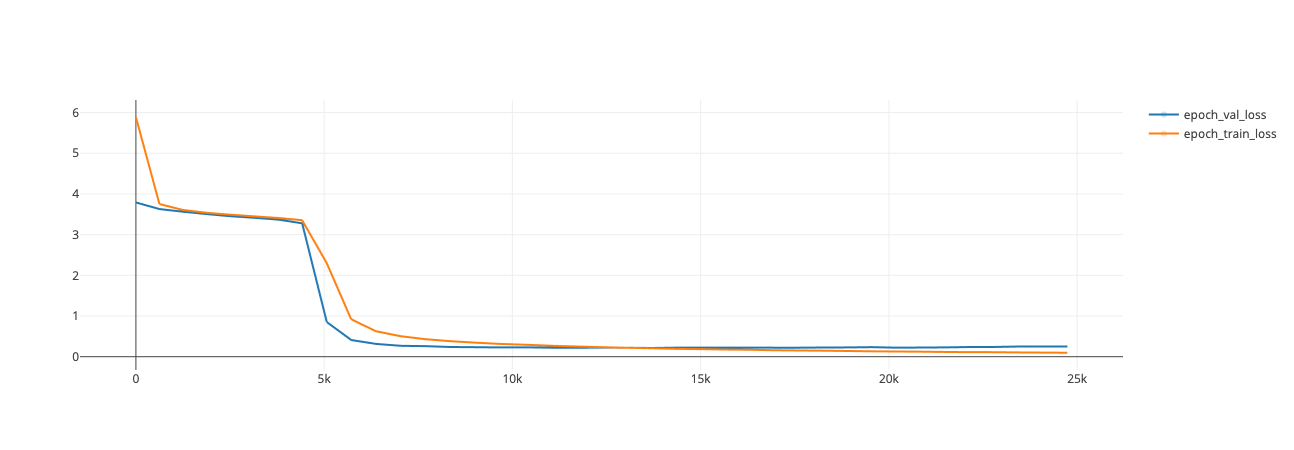

原始的预训练编码器表示被保留 - 在微调过程中,编码器保持冻结,以最小化训练时间和资源消耗。模型使用CTC损失和AdamW优化器进行训练,没有使用学习率调度器。

预处理

训练数据集经过过滤。短于2秒或长于30秒的录音被移除。任何由少于5个音素组成的标签被丢弃。

训练超参数

- 学习率:1e-5

- 优化器:AdamW

- 批量大小:64

- 权重衰减:0.001

- 训练轮数:40

速度、大小、时间

- 平均每轮训练时间:650秒

- 更新次数:约25k

- 最终训练损失:0.09713

- 最终验证损失:0.2142

评估

测试数据、因素和指标

- 测试数据:模型在TIMIT的测试集上进行评估。

- 指标:CER/PER(音素错误率)

结果

TIMIT测试集上的PER(音素错误率):0.0416

环境影响

可以使用机器学习影响计算器(来自Lacoste等人(2019))估算碳排放。

- 硬件类型:Nvidia A100 - 80

- 使用时长:[需要更多信息]

- 云服务提供商:波兹南工业大学

- 计算区域:波兰

- 碳排放:[需要更多信息]

技术规格

模型架构和目标

Transformer模型 + CTC损失

计算基础设施

- 硬件:2 x Nvidia A100 - 80

- 软件:python 3.12,transformers 4.50.0,torch 2.6.0

引用

如果您在研究中使用LnNor数据集,请引用以下论文:

@article{magdalena2024lnnor,

title={The LnNor Corpus: A spoken multilingual corpus of non-native and native Norwegian, English and Polish (Part 1)},

author={Magdalena, Wrembel and Hwaszcz, Krzysztof and Agnieszka, Pludra and Ska{\l}ba, Anna and Weckwerth, Jaros{\l}aw and Walczak, Angelika and Sypia{\'n}ska, Jolanta and {\.Z}ychli{\'n}ski, Sylwiusz and Malarski, Kamil and K{\k{e}}dzierska, Hanna and others},

year={2024},

publisher={Adam Mickiewicz University}

}

@article{wrembel2024lnnor,

title={The LnNor Corpus: A spoken multilingual corpus of non-native and native Norwegian, English and Polish--Part 2},

author={Wrembel, Magdalena and Hwaszcz, Krzysztof and Pludra, Agnieszka and Ska{\l}ba, Anna and Weckwerth, Jaros{\l}aw and Malarski, Kamil and Cal, Zuzanna Ewa and K{\k{e}}dzierska, Hanna and Czarnecki-Verner, Tristan and Balas, Anna and others},

year={2024},

publisher={Adam Mickiewicz University}

}

模型卡片作者

- Agnieszka Pludra

- Izabela Krysińska

- Piotr Kabaciński

模型卡片联系方式

- agnieszka.pludra@pearson.com

- izabela.krysinska@pearson.com

- piotr.kabacinski@pearson.com

📄 许可证

本模型使用cc-by-4.0许可证。

Voice Activity Detection

MIT

基于pyannote.audio 2.1版本的语音活动检测模型,用于识别音频中的语音活动时间段

语音识别

V

pyannote

7.7M

181

Wav2vec2 Large Xlsr 53 Portuguese

Apache-2.0

这是一个针对葡萄牙语语音识别任务微调的XLSR-53大模型,基于Common Voice 6.1数据集训练,支持葡萄牙语语音转文本。

语音识别 其他

W

jonatasgrosman

4.9M

32

Whisper Large V3

Apache-2.0

Whisper是由OpenAI提出的先进自动语音识别(ASR)和语音翻译模型,在超过500万小时的标注数据上训练,具有强大的跨数据集和跨领域泛化能力。

语音识别 支持多种语言

W

openai

4.6M

4,321

Whisper Large V3 Turbo

MIT

Whisper是由OpenAI开发的最先进的自动语音识别(ASR)和语音翻译模型,经过超过500万小时标记数据的训练,在零样本设置下展现出强大的泛化能力。

语音识别 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言W

openai

4.0M

2,317

Wav2vec2 Large Xlsr 53 Russian

Apache-2.0

基于facebook/wav2vec2-large-xlsr-53模型微调的俄语语音识别模型,支持16kHz采样率的语音输入

语音识别 其他

W

jonatasgrosman

3.9M

54

Wav2vec2 Large Xlsr 53 Chinese Zh Cn

Apache-2.0

基于facebook/wav2vec2-large-xlsr-53模型微调的中文语音识别模型,支持16kHz采样率的语音输入。

语音识别 中文

W

jonatasgrosman

3.8M

110

Wav2vec2 Large Xlsr 53 Dutch

Apache-2.0

基于facebook/wav2vec2-large-xlsr-53微调的荷兰语语音识别模型,在Common Voice和CSS10数据集上训练,支持16kHz音频输入。

语音识别 其他

W

jonatasgrosman

3.0M

12

Wav2vec2 Large Xlsr 53 Japanese

Apache-2.0

基于facebook/wav2vec2-large-xlsr-53模型微调的日语语音识别模型,支持16kHz采样率的语音输入

语音识别 日语

W

jonatasgrosman

2.9M

33

Mms 300m 1130 Forced Aligner

基于Hugging Face预训练模型的文本与音频强制对齐工具,支持多种语言,内存效率高

语音识别 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言M

MahmoudAshraf

2.5M

50

Wav2vec2 Large Xlsr 53 Arabic

Apache-2.0

基于facebook/wav2vec2-large-xlsr-53微调的阿拉伯语语音识别模型,在Common Voice和阿拉伯语语音语料库上训练

语音识别 阿拉伯语

W

jonatasgrosman

2.3M

37

精选推荐AI模型

Llama 3 Typhoon V1.5x 8b Instruct

专为泰语设计的80亿参数指令模型,性能媲美GPT-3.5-turbo,优化了应用场景、检索增强生成、受限生成和推理任务

大型语言模型 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-Tiny是一个基于SODA数据集训练的超小型对话模型,专为边缘设备推理设计,体积仅为Cosmo-3B模型的2%左右。

对话系统 Transformers 英语

Transformers 英语

Transformers 英语

Transformers 英语C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

基于RoBERTa架构的中文抽取式问答模型,适用于从给定文本中提取答案的任务。

问答系统 中文

R

uer

2,694

98