🚀 OpenHands LM v0.1

OpenHands LM v0.1 是一款开源的编码模型,基于强大的基础模型进行微调。它具备 128K 令牌上下文窗口,能处理大型代码库和长期软件工程任务。在 SWE - Bench Verified 基准测试中表现出色,可本地部署,为软件开发提供了有力支持。

📄 许可证

本项目采用 MIT 许可证。

🚀 快速开始

你可以通过以下途径立即开始使用 OpenHands LM:

- 从 Hugging Face 下载模型:该模型可在 Hugging Face 上获取,并直接从那里下载。

- 使用模型服务框架创建与 OpenAI 兼容的端点:为获得最佳性能,建议使用 SGLang 或 vLLM 在 GPU 上部署此模型。

- 将你的 OpenHands 代理指向新模型:下载 OpenHands,并按照 使用与 OpenAI 兼容的端点 的说明进行操作。

✨ 主要特性

- 开源且可本地运行:模型开源并可在 Hugging Face 上获取,你可以下载并在本地运行。

- 合理的模型规模:模型大小为 32B,可在单个 3090 GPU 等硬件上本地运行。

- 强大的性能表现:在软件工程任务中表现出色,在 SWE - Bench Verified 上的验证解决率达到 37.2%,性能可与参数多 20 倍的模型相媲美。

- 专业的微调过程:基于 Qwen Coder 2.5 Instruct 32B 进行微调,使用 OpenHands 自身在多种开源仓库上生成的训练数据,采用基于 RL 的框架 SWE - Gym 进行训练。

- 大上下文窗口:具有 128K 令牌上下文窗口,适合处理大型代码库和长期软件工程任务。

📚 详细文档

模型基础

OpenHands LM 构建于 Qwen Coder 2.5 Instruct 32B 的基础之上,利用其强大的编码基础能力。我们的微调过程具有独特性:

- 使用 OpenHands 自身在多种开源仓库上生成的训练数据。

- 采用 SWE - Gym 中基于 RL 的框架,设置训练环境,使用现有代理生成训练数据,并在成功解决的示例上对模型进行微调。

性能评估

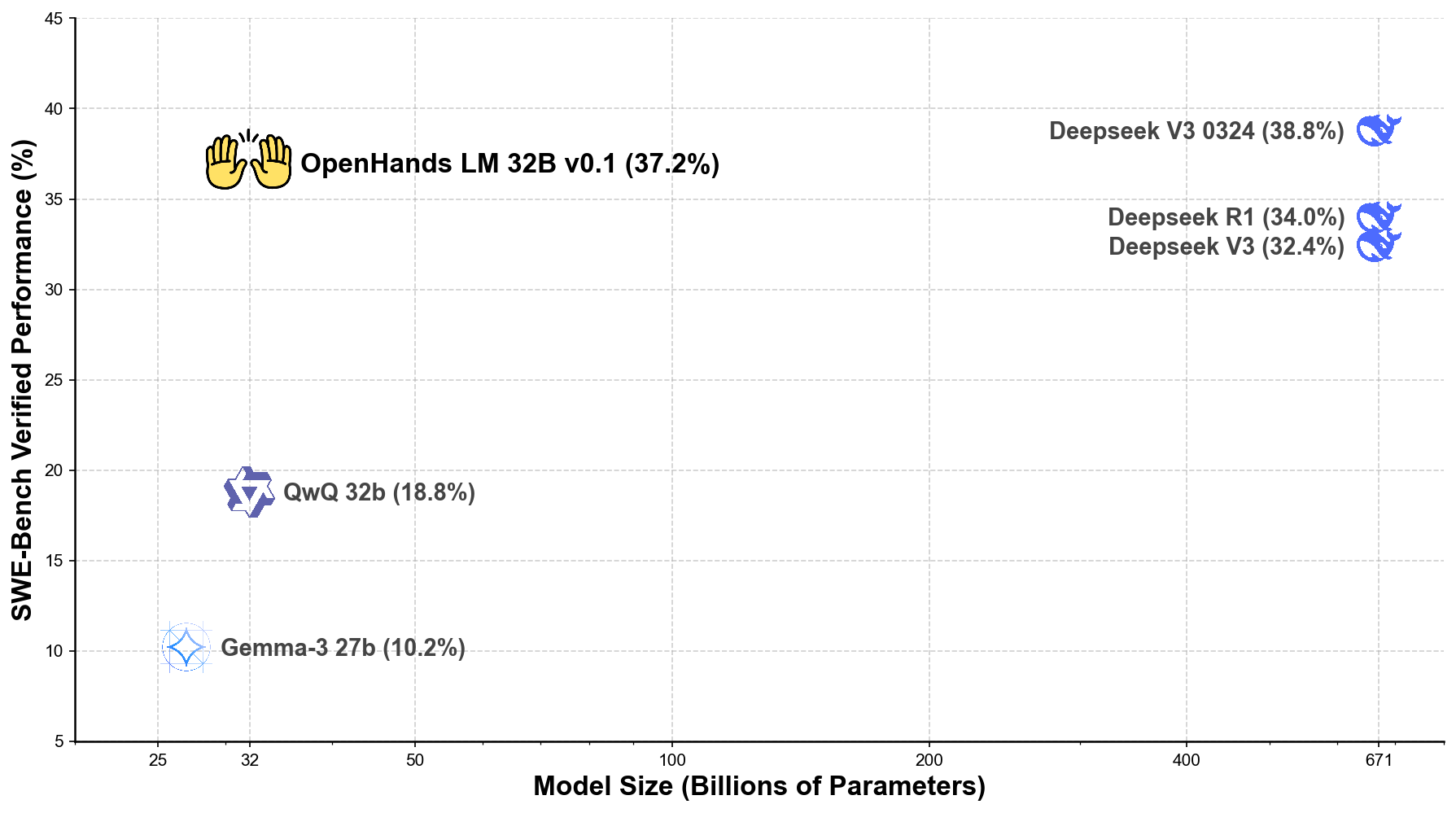

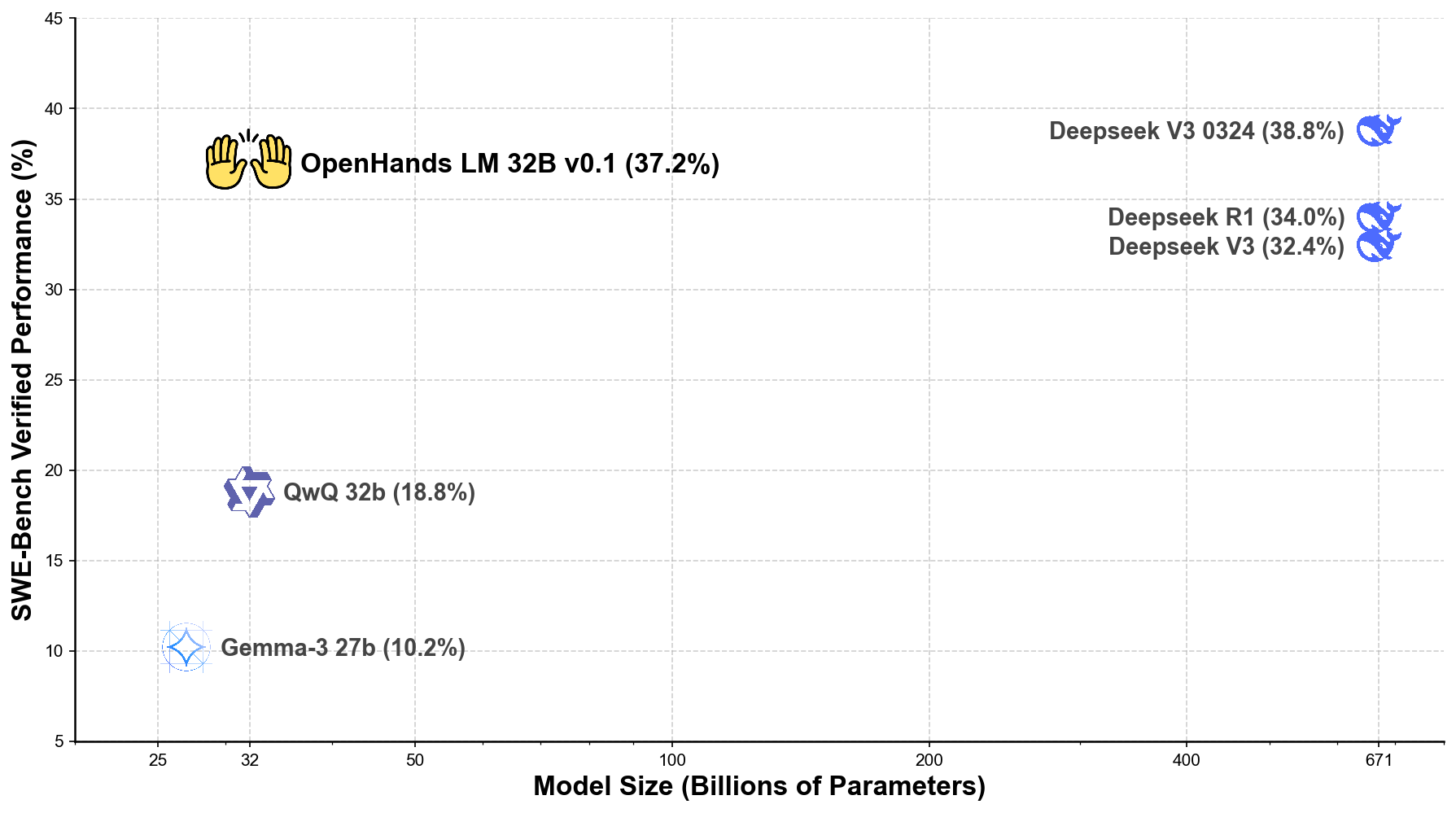

我们使用最新的 迭代评估协议 在 SWE - Bench Verified 基准测试 上对 OpenHands LM 进行了评估,结果令人印象深刻:

- 在 SWE - Bench Verified 上的验证解决率达到 37.2%。

- 性能与参数多 20 倍 的模型相当,包括具有 671B 参数的 Deepseek V3 0324(38.8%)。

以下是 OpenHands LM 与其他领先开源模型的性能对比图:

未来规划

本次初始版本的发布仅仅是我们旅程的开始。我们将根据社区反馈和持续的研究计划不断改进 OpenHands LM。

需要注意的是,该模型仍处于研究预览阶段,存在一些局限性:

- 可能最适合解决 GitHub 问题的任务,在更多样化的软件工程任务中表现欠佳。

- 有时可能会生成重复步骤。

- 对量化较为敏感,在较低量化级别下可能无法发挥全部性能。

我们的下一个版本将着重解决这些局限性。此外,我们还在开发更紧凑的模型版本(包括 7B 参数的变体),以支持计算资源有限的用户。这些较小的模型将保留 OpenHands LM 的核心优势,同时大幅降低硬件要求。

🔧 技术细节

AWQ 量化

由 stelterlab 使用 casper - hansen 的 AutoAWQ 在 INT4 GEMM 中完成。

基础信息

| 属性 |

详情 |

| 模型类型 |

文本生成 |

| 基础模型 |

all - hands/openhands - lm - 32b - v0.1 |

| 训练数据 |

SWE - Gym/SWE - Gym |

🤝 加入我们的社区

我们邀请你加入 OpenHands LM 的发展之旅:

通过分享你的经验和反馈,你将有助于塑造这个开源项目的未来。让我们共同为未来的软件开发创造更好的工具!我们迫不及待地想看到你使用 OpenHands LM 创造出的成果!

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语