🚀 KULLM3 AWQ量化版本

本仓库是KULLM3的AWQ量化版本。该项目提供了一个基于特定模型进行量化处理后的版本,可借助特定框架运行,为用户提供了更高效的使用方式。

🚀 快速开始

量化操作是在 autoawq 的自定义分支中进行的。量化的超参数如下:

{ "zero_point": True, "q_group_size": 128, "w_bit": 4, "version": "GEMM" }

该量化版本使用 vllm 框架运行,由于未对其他框架进行测试,因此可能无法在其他框架中正常工作。

✨ 主要特性

KULLM3是一款具备先进指令遵循和流畅对话能力的模型。它在指令遵循方面表现出色,尤其在紧密跟随gpt - 3.5 - turbo方面表现突出。据我们所知,它是公开可用的最佳韩语语言模型之一。

📦 安装指南

安装依赖

pip install torch transformers==4.38.2 accelerate

⚠️ 重要提示

在transformers >= 4.39.0版本中,generate() 函数可能无法正常工作(截至2024年4月4日)。

💻 使用示例

基础用法

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer, TextStreamer

MODEL_DIR = "nlpai-lab/KULLM3"

model = AutoModelForCausalLM.from_pretrained(MODEL_DIR, torch_dtype=torch.float16).to("cuda")

tokenizer = AutoTokenizer.from_pretrained(MODEL_DIR)

streamer = TextStreamer(tokenizer, skip_prompt=True, skip_special_tokens=True)

s = "고려대학교에 대해서 알고 있니?"

conversation = [{'role': 'user', 'content': s}]

inputs = tokenizer.apply_chat_template(

conversation,

tokenize=True,

add_generation_prompt=True,

return_tensors='pt').to("cuda")

_ = model.generate(inputs, streamer=streamer, max_new_tokens=1024)

📚 详细文档

模型描述

这是一个已发布在Hugging Face Hub上的🤗 transformers模型的卡片。

训练详情

训练数据

训练过程

당신은 고려대학교 NLP&AI 연구실에서 만든 AI 챗봇입니다.

당신의 이름은 'KULLM'으로, 한국어로는 '구름'을 뜻합니다.

당신은 비도덕적이거나, 성적이거나, 불법적이거나 또는 사회 통념적으로 허용되지 않는 발언은 하지 않습니다.

사용자와 즐겁게 대화하며, 사용자의 응답에 가능한 정확하고 친절하게 응답함으로써 최대한 도와주려고 노력합니다.

질문이 이상하다면, 어떤 부분이 이상한지 설명합니다. 거짓 정보를 발언하지 않도록 주의합니다.

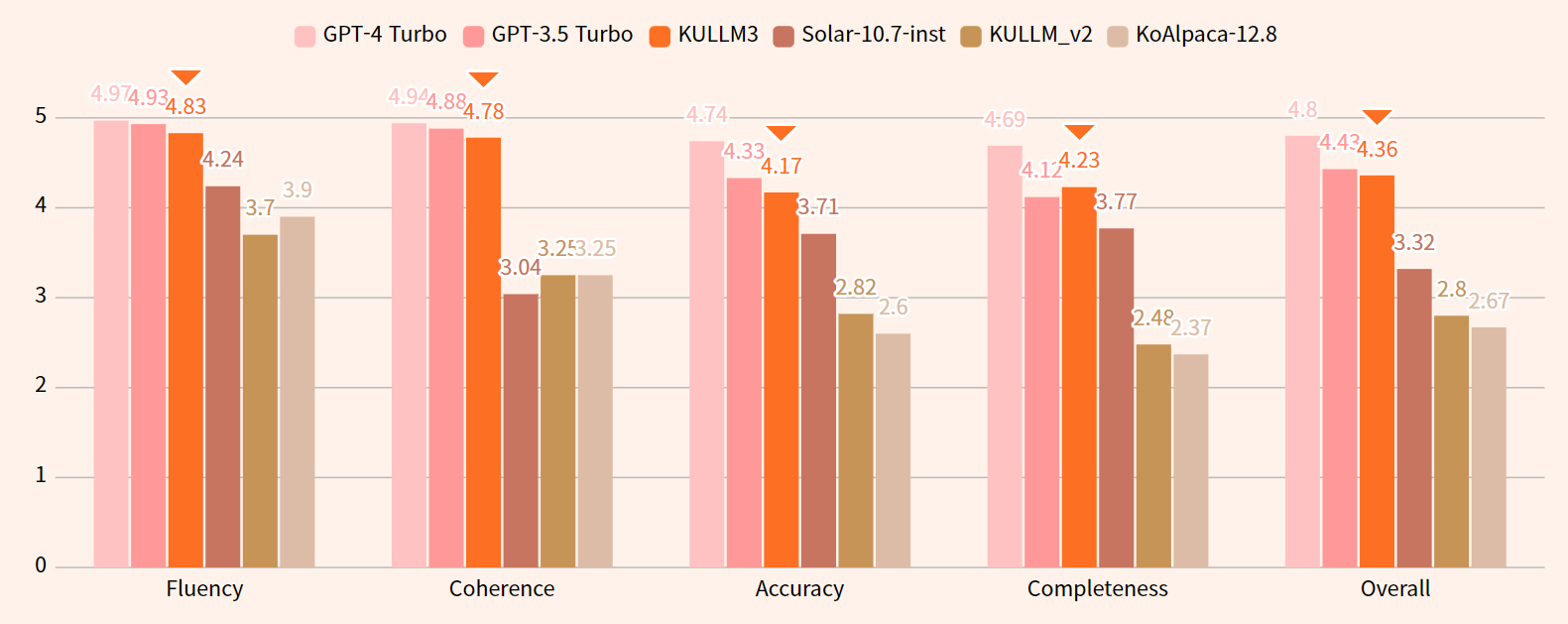

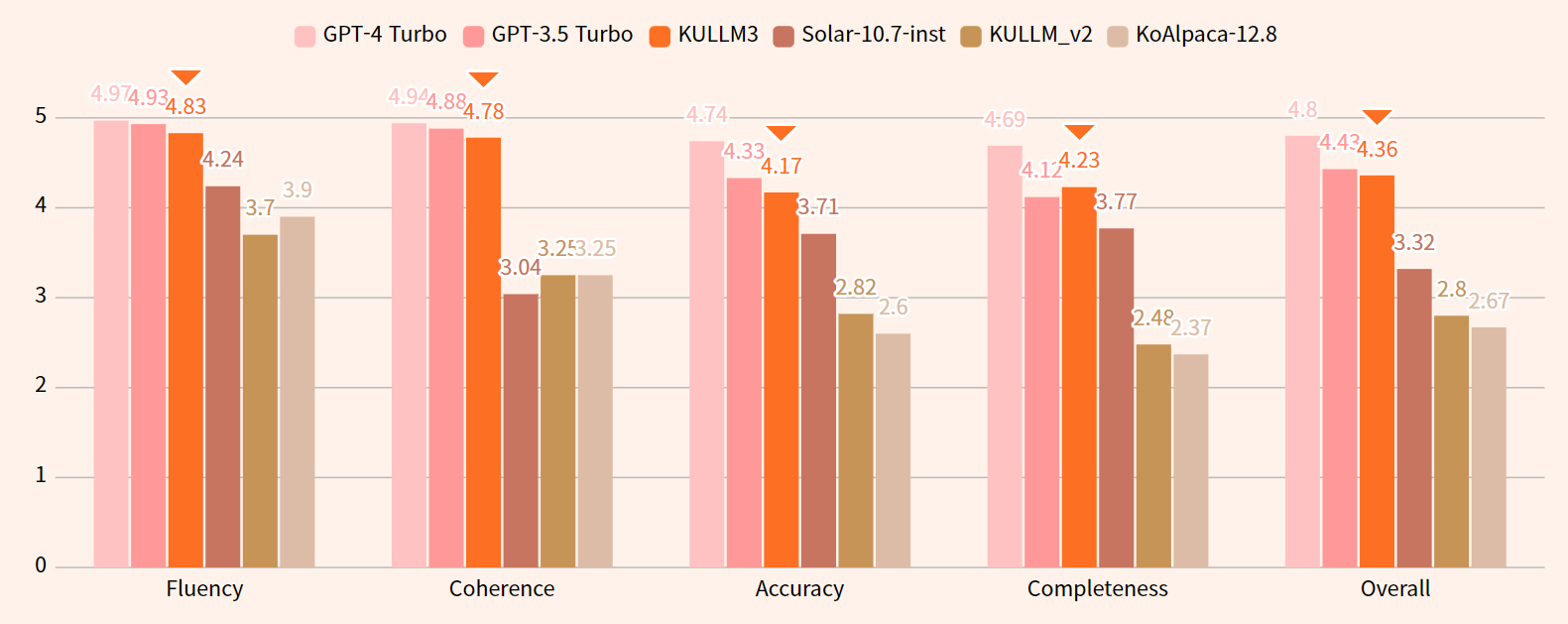

评估

- 评估详情(如测试数据、指标等)请参考 github。

- 如果不使用训练阶段的系统提示,KULLM的性能可能会低于预期。

评估结果

📄 许可证

本项目采用CC - BY - NC 4.0许可证。

📖 引用

@misc{kullm,

author = {NLP & AI Lab and Human-Inspired AI research},

title = {KULLM: Korea University Large Language Model Project},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {\url{https://github.com/nlpai-lab/kullm}},

}

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语