模型概述

模型特點

模型能力

使用案例

🚀 小夜曲XL εpsilon

小夜曲XL εpsilon是小夜曲XL系列的第五次重大迭代,使用520萬張圖像的數據集,通過LyCORIS進行微調,在消費級硬件上完成訓練,並且完全開源。該模型在文本到圖像轉換方面表現出色,能生成高質量且風格多樣的圖像。

🚀 快速開始

Kohaku XL Epsilon是小夜曲XL系列的第五次重大迭代版本,它使用了包含520萬張圖像的數據集,並採用LyCORIS進行微調。該模型在消費級硬件上完成訓練,並且完全開源。

模型效果展示

通過以下圖像查看器,你可以直觀地看到Kohaku XL Epsilon生成的部分圖像效果:

加入我們

歡迎加入我們的社區交流:Discord

✨ 主要特性

- 數據集豐富:使用了包含520萬張圖像的數據集進行訓練,能生成更豐富多樣的圖像。

- 微調技術:採用LyCORIS進行微調,提升了模型的性能和穩定性。

- 開源免費:模型完全開源,方便開發者進行二次開發和研究。

- 風格多樣:掌握了更多藝術家的風格,並且在組合多個藝術家標籤時穩定性更高。

💻 使用示例

基礎用法

<1girl/1boy/1other/...>,

<character>, <series>, <artists>,

<general tags>,

<quality tags>, <year tags>, <meta tags>, <rating tags>

高級用法

Kohaku XL Epsilon掌握了比Delta更多藝術家的風格,並且在組合多個藝術家標籤時穩定性更高。建議用戶創建自己的風格提示。以下是一些不錯的風格提示示例:

ask \(askzy\), torino aqua, migolu, (jiu ye sang:1.1), (rumoon:0.9), (mizumi zumi:1.1)

ciloranko, maccha \(mochancc\), lobelia \(saclia\), migolu,

ask \(askzy\), wanke, (jiu ye sang:1.1), (rumoon:0.9), (mizumi zumi:1.1)

shiro9jira, ciloranko, ask \(askzy\), (tianliang duohe fangdongye:0.8)

(azuuru:1.1), (torino aqua:1.2), (azuuru:1.1), kedama milk,

fuzichoco, ask \(askzy\), chen bin, atdan, hito, mignon

ask \(askzy\), torino aqua, migolu

標籤使用說明

- 通用標籤:所有在danbooru上受歡迎度至少為1000的標籤都應該可以正常使用;受歡迎度至少為100的標籤在高權重強調下可能會起作用。

- 去除下劃線:記得去除標籤中的所有下劃線(短標籤中的下劃線可能是表情符號標籤的一部分,無需去除)。

- 特殊標籤處理:當標籤中有括號且使用sd-webui時,記得使用

xxx\(yyy\)格式。

特殊標籤

- 質量標籤:masterpiece(傑作), best quality(最佳質量), great quality(高質量), good quality(良好質量), normal quality(普通質量), low quality(低質量), worst quality(最差質量)

- 評級標籤:safe(安全), sensitive(敏感), nsfw(不適宜公開), explicit(明確限制)

- 日期標籤:newest(最新), recent(近期), mid(中期), early(早期), old(舊的)

分辨率說明

該模型針對ARB 1024x1024的分辨率進行訓練,最小分辨率為256,最大分辨率為4096。這意味著你可以使用標準的SDXL分辨率。不過,建議選擇略高於1024x1024的分辨率,並應用hires-fix以獲得更好的效果。更多信息請查看提供的示例圖像。

📚 詳細文檔

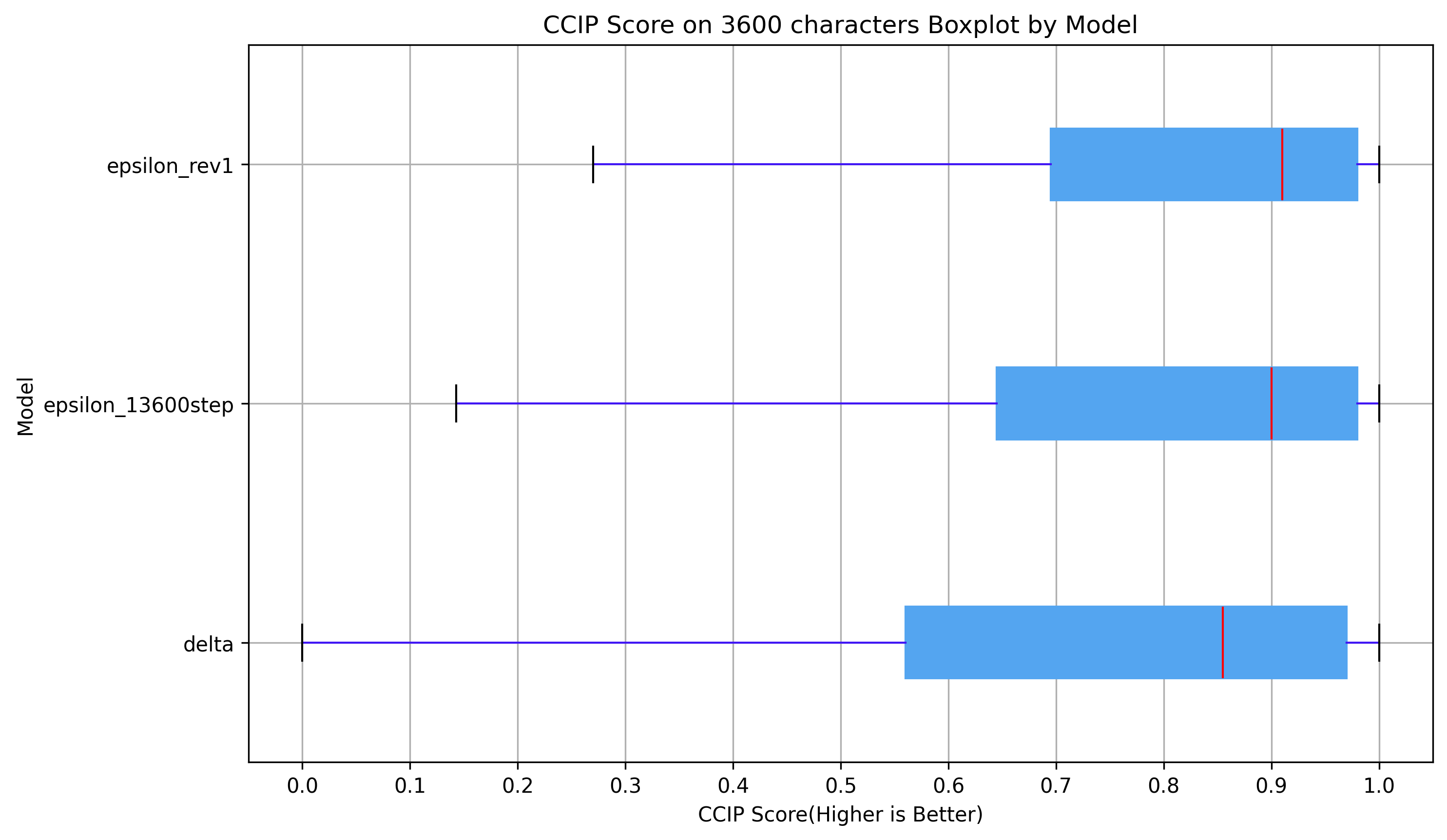

模型基準測試

在3600字符的CCIP評分中(0~1,分數越高越好),Kohaku XL Epsilon明顯優於Kohaku XL Delta。

模型誕生過程

為什麼是Epsilon

和Delta一樣,這是對新數據集的一次測試,並且效果良好。與Delta相比,其輸出結果也有很大不同。

數據集

該模型的訓練數據集來自HakuBooru,從danbooru2023數據集中挑選了520萬張圖像。具體挑選過程如下:從ID 0到200萬中挑選了100萬個帖子,從ID 200萬到499.9999萬中挑選了200萬個帖子,以及挑選了ID 500萬之後的所有帖子,總計535萬個帖子。經過過濾刪除的帖子、黃金賬戶帖子和沒有圖像(可能是GIF或MP4)的帖子後,最終數據集包含520萬張圖像。挑選過程基本是隨機的,但使用了固定種子以確保可重複性。

進一步處理

- 標籤洗牌:在每個步驟中打亂通用標籤的順序。

- 標籤丟棄:在每個步驟中隨機丟棄15%的通用標籤。

訓練

Kohaku XL Epsilon的訓練藉助了LyCORIS項目和kohya-ss/sd-scripts的訓練器。

算法:LoKr 該模型使用LoKr算法進行訓練,觸發全矩陣,不同模塊的因子為2~8。目的是證明LoRA/LyCORIS在訓練基礎模型中的適用性。原始LoKr文件大小小於800MB,並且TE未凍結。原始LoKr文件也以“delta-lokr”版本提供。詳細設置請參考Kohaku XL Delta的LyCORIS配置文件。

其他訓練細節

| 屬性 | 詳情 |

|---|---|

| 硬件 | 四塊RTX 3090顯卡 |

| 訓練圖像數量 | 5,210,319 |

| 批次大小 | 4 |

| 梯度累積步數 | 16 |

| 等效批次大小 | 256 |

| 總訓練輪數 | 1 |

| 總步數 | 20354 |

| 優化器 | Lion8bit |

| 學習率 | UNet為2e-5 / TE為5e-6 |

| 學習率調度器 | 常數(帶熱身) |

| 熱身步數 | 1000 |

| 權重衰減 | 0.1 |

| 貝塔值 | 0.9, 0.95 |

| 最小SNR伽馬值 | 5 |

| 噪聲偏移 | 0.0357 |

| 分辨率 | 1024x1024 |

| 最小桶分辨率 | 256 |

| 最大桶分辨率 | 4096 |

| 混合精度 | FP16 |

警告:bitsandbytes的0.36.0~0.41.0版本在8位優化器中存在嚴重漏洞,可能會影響訓練,因此必須進行更新。

訓練成本 使用四塊RTX 3090顯卡進行DDP訓練,在520萬張圖像的數據集上完成1輪訓練大約需要12到13天。等效批次大小為256時,每個步驟大約需要49到50秒完成。

為什麼發佈13600步的中間檢查點

訓練進度在13600步到15300步之間崩潰,並且kohya-ss訓練器之前沒有實現恢復和跳過步驟的功能。儘管Kohya和我已經弄清楚瞭如何正確處理並進行了一些合理性檢查,但我仍然不能完全確保最終結果的正確性。因此,我發佈了最終的中間檢查點,以便任何想要復現訓練的人有機會找出最終結果的問題。

未來計劃

目前我專注於製作新的數據集(目標是1000萬到1500萬張圖像),並等待SD3的發佈,看看是否值得嘗試。我也可能會對Epsilon進行一些小的微調,並以rev2/3/4等版本發佈,但目前數據集仍然是我的主要關注點。

🔧 技術細節

算法原理

模型使用LoKr算法進行訓練,觸發全矩陣,不同模塊的因子為2~8,目的是證明LoRA/LyCORIS在訓練基礎模型中的適用性。

訓練優化

在訓練過程中,採用了梯度累積、學習率調度等優化策略,以提高模型的訓練效果和穩定性。

數據處理

對數據集進行了標籤洗牌和標籤丟棄等處理,以增加數據的多樣性和模型的泛化能力。

📄 許可證

本模型遵循“Fair-AI public license 1.0-SD”許可協議,更多信息請參考原始許可證:https://freedevproject.org/faipl-1.0-sd/

參考與資源

參考文獻

[1] SHIH-YING YEH, Yu-Guan Hsieh, Zhidong Gao, Bernard B W Yang, Giyeong Oh, & Yanmin Gong (2024). Navigating Text-To-Image Customization: From LyCORIS Fine-Tuning to Model Evaluation. In The Twelfth International Conference on Learning Representations. [2] HakuBooru - text-image dataset maker for booru style image platform. https://github.com/KohakuBlueleaf/HakuBooru [3] Danbooru2023: A Large-Scale Crowdsourced and Tagged Anime Illustration Dataset. https://huggingface.co/datasets/nyanko7/danbooru2023 [4] kohya-ss/sd-scripts. https://github.com/kohya-ss/sd-scripts [5] LyCORIS - Lora beYond Conventional methods, Other Rank adaptation Implementations for Stable diffusion. https://github.com/KohakuBlueleaf/LyCORIS/blob/main/docs/Algo-Details.md#lokr [6] TimDettmers/bitsandbytes - issue 659/152/227/262 - Wrong indented lines cause bugs for a long time. https://github.com/TimDettmers/bitsandbytes/issues/659

相關資源

- Kohaku XL beta: https://civitai.com/models/162577/kohaku-xl-beta

- Kohaku XL gamma: https://civitai.com/models/270291/kohaku-xl-gamma

- Kohaku XL delta: https://civitai.com/models/332076/kohaku-xl-delta

⚠️ 重要提示 bitsandbytes的0.36.0~0.41.0版本在8位優化器中存在嚴重漏洞,可能會影響訓練,因此必須進行更新。

💡 使用建議 建議選擇略高於1024x1024的分辨率,並應用hires-fix以獲得更好的圖像效果。同時,用戶可以根據自己的需求創建獨特的風格提示,以發揮模型的最大潛力。

AI藝術應該展現出AI的特色,而不是模仿人類。

(有趣的事實:這句口號來自我的個人主頁,很多人喜歡並將其放在他們的模型頁面上。)

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語