模型概述

模型特點

模型能力

使用案例

🚀 Wan-Fun

😊 歡迎!Wan-Fun 是一個強大的文本到視頻生成項目,能夠根據輸入的文本生成高質量的視頻,為用戶帶來豐富的視覺體驗。

🚀 快速開始

1. 雲使用: AliyunDSW/Docker

a. 通過阿里雲 DSW

DSW 有免費 GPU 時間,用戶可申請一次,申請後 3 個月內有效。

阿里雲在Freetier提供免費 GPU 時間,獲取並在阿里雲 PAI - DSW 中使用,5 分鐘內即可啟動 CogVideoX - Fun。

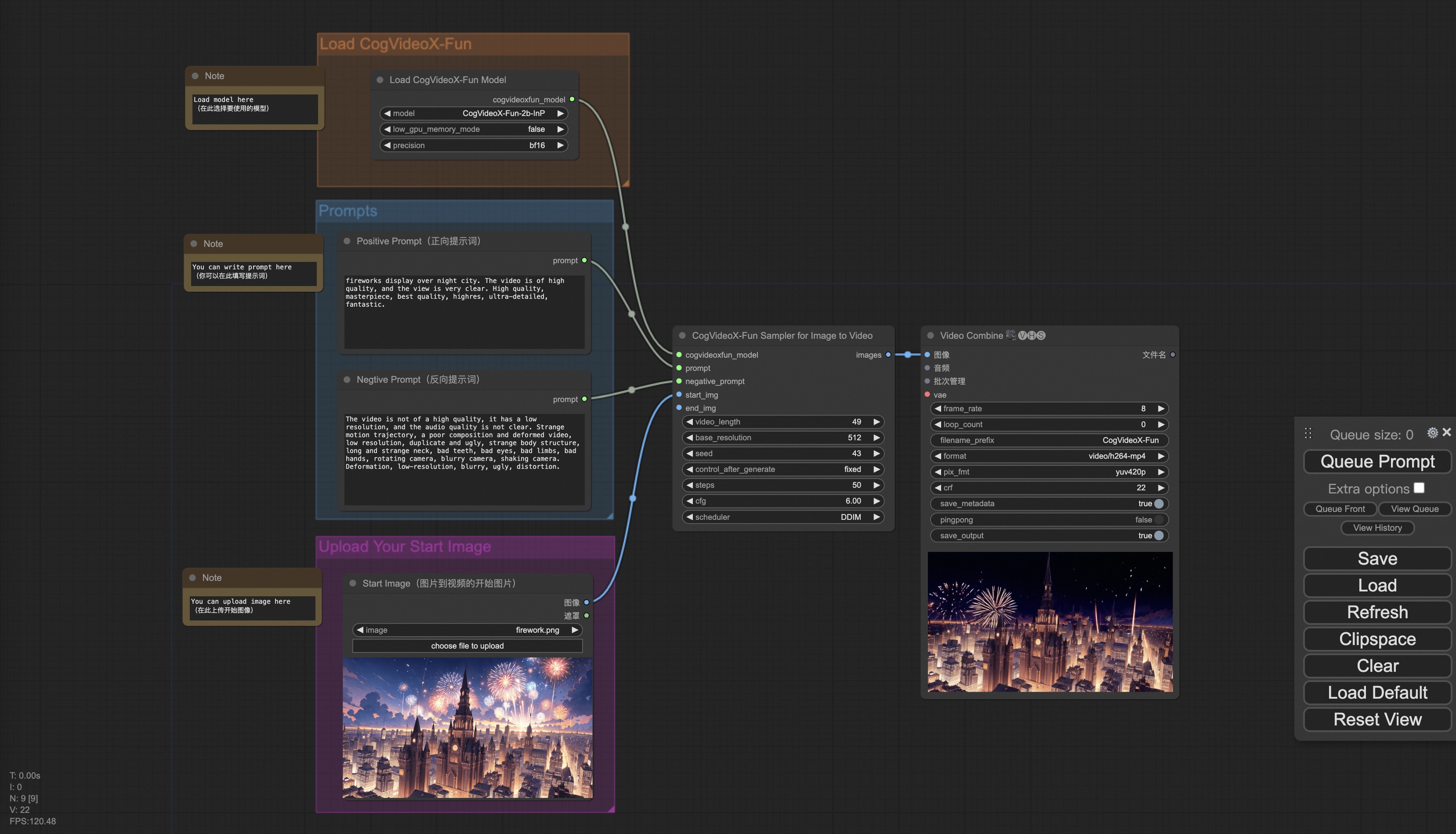

b. 通過 ComfyUI

我們的 ComfyUI 界面如下,具體查看ComfyUI README。

c. 通過 docker

使用 docker 的情況下,請保證機器中已經正確安裝顯卡驅動與 CUDA 環境,然後依次執行以下命令:

# pull image

docker pull mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# enter image

docker run -it -p 7860:7860 --network host --gpus all --security-opt seccomp:unconfined --shm-size 200g mybigpai-public-registry.cn-beijing.cr.aliyuncs.com/easycv/torch_cuda:cogvideox_fun

# clone code

git clone https://github.com/aigc-apps/VideoX-Fun.git

# enter VideoX-Fun's dir

cd VideoX-Fun

# download weights

mkdir models/Diffusion_Transformer

mkdir models/Personalized_Model

# Please use the hugginface link or modelscope link to download the model.

# CogVideoX-Fun

# https://huggingface.co/alibaba-pai/CogVideoX-Fun-V1.1-5b-InP

# https://modelscope.cn/models/PAI/CogVideoX-Fun-V1.1-5b-InP

# Wan

# https://huggingface.co/alibaba-pai/Wan2.1-Fun-V1.1-14B-InP

# https://modelscope.cn/models/PAI/Wan2.1-Fun-V1.1-14B-InP

2. 本地安裝: 環境檢查/下載/安裝

a. 環境檢查

我們已驗證該庫可在以下環境中執行:

Windows 的詳細信息:

- 操作系統 Windows 10

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU: Nvidia - 3060 12G & Nvidia - 3090 24G

Linux 的詳細信息:

- 操作系統 Ubuntu 20.04, CentOS

- python: python3.10 & python3.11

- pytorch: torch2.2.0

- CUDA: 11.8 & 12.1

- CUDNN: 8+

- GPU:Nvidia - V100 16G & Nvidia - A10 24G & Nvidia - A100 40G & Nvidia - A100 80G

我們需要大約 60GB 的可用磁盤空間,請檢查!

b. 權重放置

我們最好將權重按照指定路徑進行放置:

通過 comfyui:

將模型放入 Comfyui 的權重文件夾ComfyUI/models/Fun_Models/:

📦 ComfyUI/

├── 📂 models/

│ └── 📂 Fun_Models/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

運行自身的 python 文件或 ui 界面:

📦 models/

├── 📂 Diffusion_Transformer/

│ ├── 📂 CogVideoX-Fun-V1.1-2b-InP/

│ ├── 📂 CogVideoX-Fun-V1.1-5b-InP/

│ ├── 📂 Wan2.1-Fun-V1.1-14B-InP

│ └── 📂 Wan2.1-Fun-V1.1-1.3B-InP/

├── 📂 Personalized_Model/

│ └── your trained trainformer model / your trained lora model (for UI load)

✨ 主要特性

- 多分辨率支持:支持多分辨率(512,768,1024)的視頻預測。

- 多語言預測:支持多語言輸入進行視頻生成。

- 多種控制條件:支持不同的控制條件,如 Canny、Depth、Pose、MLSD 等,還支持參考圖 + 控制條件進行控制以及使用軌跡控制。

- 多模型選擇:提供不同規模的模型權重,如 1.3B 和 14B,滿足不同需求。

📦 安裝指南

雲使用

- 阿里雲 DSW:在Freetier獲取免費 GPU 時間,在阿里雲 PAI - DSW 中使用,5 分鐘內可啟動 CogVideoX - Fun。

- ComfyUI:具體查看ComfyUI README。

- Docker:確保機器安裝顯卡驅動與 CUDA 環境,按上述命令拉取鏡像、進入容器、克隆代碼和下載權重。

本地安裝

- 環境檢查:確保系統環境符合上述 Windows 或 Linux 的要求,並檢查磁盤空間。

- 權重放置:根據使用方式將權重放置到指定文件夾。

💻 使用示例

生成

a、顯存節省方案

由於 Wan2.1 的參數非常大,我們需要考慮顯存節省方案,以節省顯存適應消費級顯卡。我們給每個預測文件都提供了 GPU_memory_mode,可以在 model_cpu_offload,model_cpu_offload_and_qfloat8,sequential_cpu_offload 中進行選擇。該方案同樣適用於 CogVideoX - Fun 的生成。

- model_cpu_offload 代表整個模型在使用後會進入 cpu,可以節省部分顯存。

- model_cpu_offload_and_qfloat8 代表整個模型在使用後會進入 cpu,並且對 transformer 模型進行了 float8 的量化,可以節省更多的顯存。

- sequential_cpu_offload 代表模型的每一層在使用後會進入 cpu,速度較慢,節省大量顯存。

qfloat8 會部分降低模型的性能,但可以節省更多的顯存。如果顯存足夠,推薦使用 model_cpu_offload。

b、通過 comfyui

具體查看ComfyUI README。

c、運行 python 文件

- 步驟 1:下載對應權重放入 models 文件夾。

- 步驟 2:根據不同的權重與預測目標使用不同的文件進行預測。當前該庫支持 CogVideoX - Fun、Wan2.1 和 Wan2.1 - Fun,在 examples 文件夾下用文件夾名以區分,不同模型支持的功能不同,請視具體情況予以區分。以 CogVideoX - Fun 為例。

- 文生視頻:

- 使用 examples/cogvideox_fun/predict_t2v.py 文件中修改 prompt、neg_prompt、guidance_scale 和 seed。

- 而後運行 examples/cogvideox_fun/predict_t2v.py 文件,等待生成結果,結果保存在 samples/cogvideox - fun - videos 文件夾中。

- 圖生視頻:

- 使用 examples/cogvideox_fun/predict_i2v.py 文件中修改 validation_image_start、validation_image_end、prompt、neg_prompt、guidance_scale 和 seed。

- validation_image_start 是視頻的開始圖片,validation_image_end 是視頻的結尾圖片。

- 而後運行 examples/cogvideox_fun/predict_i2v.py 文件,等待生成結果,結果保存在 samples/cogvideox - fun - videos_i2v 文件夾中。

- 視頻生視頻:

- 使用 examples/cogvideox_fun/predict_v2v.py 文件中修改 validation_video、validation_image_end、prompt、neg_prompt、guidance_scale 和 seed。

- validation_video 是視頻生視頻的參考視頻。您可以使用以下視頻運行演示:演示視頻

- 而後運行 examples/cogvideox_fun/predict_v2v.py 文件,等待生成結果,結果保存在 samples/cogvideox - fun - videos_v2v 文件夾中。

- 普通控制生視頻(Canny、Pose、Depth 等):

- 使用 examples/cogvideox_fun/predict_v2v_control.py 文件中修改 control_video、validation_image_end、prompt、neg_prompt、guidance_scale 和 seed。

- control_video 是控制生視頻的控制視頻,是使用 Canny、Pose、Depth 等算子提取後的視頻。您可以使用以下視頻運行演示:演示視頻

- 而後運行 examples/cogvideox_fun/predict_v2v_control.py 文件,等待生成結果,結果保存在 samples/cogvideox - fun - videos_v2v_control 文件夾中。

- 文生視頻:

- 步驟 3:如果想結合自己訓練的其他 backbone 與 Lora,則看情況修改 examples/{model_name}/predict_t2v.py 中的 examples/{model_name}/predict_i2v.py 和 lora_path。

d、通過 ui 界面

webui 支持文生視頻、圖生視頻、視頻生視頻和普通控制生視頻(Canny、Pose、Depth 等)。當前該庫支持 CogVideoX - Fun、Wan2.1 和 Wan2.1 - Fun,在 examples 文件夾下用文件夾名以區分,不同模型支持的功能不同,請視具體情況予以區分。以 CogVideoX - Fun 為例。

- 步驟 1:下載對應權重放入 models 文件夾。

- 步驟 2:運行 examples/cogvideox_fun/app.py 文件,進入 gradio 頁面。

- 步驟 3:根據頁面選擇生成模型,填入 prompt、neg_prompt、guidance_scale 和 seed 等,點擊生成,等待生成結果,結果保存在 sample 文件夾中。

📚 詳細文檔

模型地址

V1.1

| 名稱 | 存儲空間 | Hugging Face | Model Scope | 描述 |

|---|---|---|---|---|

| Wan2.1 - Fun - V1.1 - 1.3B - InP | 19.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 1.3B 文圖生視頻權重,以多分辨率訓練,支持首尾圖預測。 |

| Wan2.1 - Fun - V1.1 - 14B - InP | 47.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 14B 文圖生視頻權重,以多分辨率訓練,支持首尾圖預測。 |

| Wan2.1 - Fun - V1.1 - 1.3B - Control | 19.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 1.3B 視頻控制權重支持不同的控制條件,如 Canny、Depth、Pose、MLSD 等,支持參考圖 + 控制條件進行控制,支持使用軌跡控制。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

| Wan2.1 - Fun - V1.1 - 14B - Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 14B 視頻控制權重支持不同的控制條件,如 Canny、Depth、Pose、MLSD 等,支持參考圖 + 控制條件進行控制,支持使用軌跡控制。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

| Wan2.1 - Fun - V1.1 - 1.3B - Control - Camera | 19.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 1.3B 相機鏡頭控制權重。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

| Wan2.1 - Fun - V1.1 - 14B - Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - V1.1 - 14B 相機鏡頭控制權重。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

V1.0

| 名稱 | 存儲空間 | Hugging Face | Model Scope | 描述 |

|---|---|---|---|---|

| Wan2.1 - Fun - 1.3B - InP | 19.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - 1.3B 文圖生視頻權重,以多分辨率訓練,支持首尾圖預測。 |

| Wan2.1 - Fun - 14B - InP | 47.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - 14B 文圖生視頻權重,以多分辨率訓練,支持首尾圖預測。 |

| Wan2.1 - Fun - 1.3B - Control | 19.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - 1.3B 視頻控制權重,支持不同的控制條件,如 Canny、Depth、Pose、MLSD 等,同時支持使用軌跡控制。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

| Wan2.1 - Fun - 14B - Control | 47.0 GB | 🤗Link | 😄Link | Wan2.1 - Fun - 14B 視頻控制權重,支持不同的控制條件,如 Canny、Depth、Pose、MLSD 等,同時支持使用軌跡控制。支持多分辨率(512,768,1024)的視頻預測,以 81 幀、每秒 16 幀進行訓練,支持多語言預測 |

視頻作品

Wan2.1 - Fun - V1.1 - 14B - InP && Wan2.1 - Fun - V1.1 - 1.3B - InP

Wan2.1 - Fun - V1.1 - 14B - Control && Wan2.1 - Fun - V1.1 - 1.3B - Control

Generic Control Video + Reference Image:

| Reference Image | Control Video | Wan2.1 - Fun - V1.1 - 14B - Control | Wan2.1 - Fun - V1.1 - 1.3B - Control |

|

|

|||

Generic Control Video (Canny, Pose, Depth, etc.) and Trajectory Control:

Wan2.1 - Fun - V1.1 - 14B - Control - Camera && Wan2.1 - Fun - V1.1 - 1.3B - Control - Camera

| Pan Up | Pan Left | Pan Right |

| Pan Down | Pan Up + Pan Left | Pan Up + Pan Right |

📄 許可證

本項目採用 Apache License (Version 2.0)。

🔗 參考文獻

- CogVideo: https://github.com/THUDM/CogVideo/

- EasyAnimate: https://github.com/aigc-apps/EasyAnimate

- Wan2.1: https://github.com/Wan-Video/Wan2.1/

- ComfyUI - KJNodes: https://github.com/kijai/ComfyUI - KJNodes

- ComfyUI - EasyAnimateWrapper: https://github.com/kijai/ComfyUI - EasyAnimateWrapper

- ComfyUI - CameraCtrl - Wrapper: https://github.com/chaojie/ComfyUI - CameraCtrl - Wrapper

- CameraCtrl: https://github.com/hehao13/CameraCtrl

Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語