🚀 基於ResNet - 50骨幹網絡的可變形DETR模型

可變形DETR(Deformable Detection Transformer)模型在COCO 2017目標檢測數據集(11.8萬張標註圖像)上進行了端到端訓練。該模型由Zhu等人在論文《Deformable DETR: Deformable Transformers for End-to-End Object Detection》中提出,並首次在此倉庫發佈。

聲明:發佈可變形DETR的團隊並未為此模型撰寫模型卡片,此模型卡片由Hugging Face團隊編寫。

🚀 快速開始

你可以使用該原始模型進行目標檢測。前往模型中心查看所有可用的可變形DETR模型。

✨ 主要特性

- 端到端訓練:在COCO 2017目標檢測數據集上進行端到端訓練,簡化了目標檢測流程。

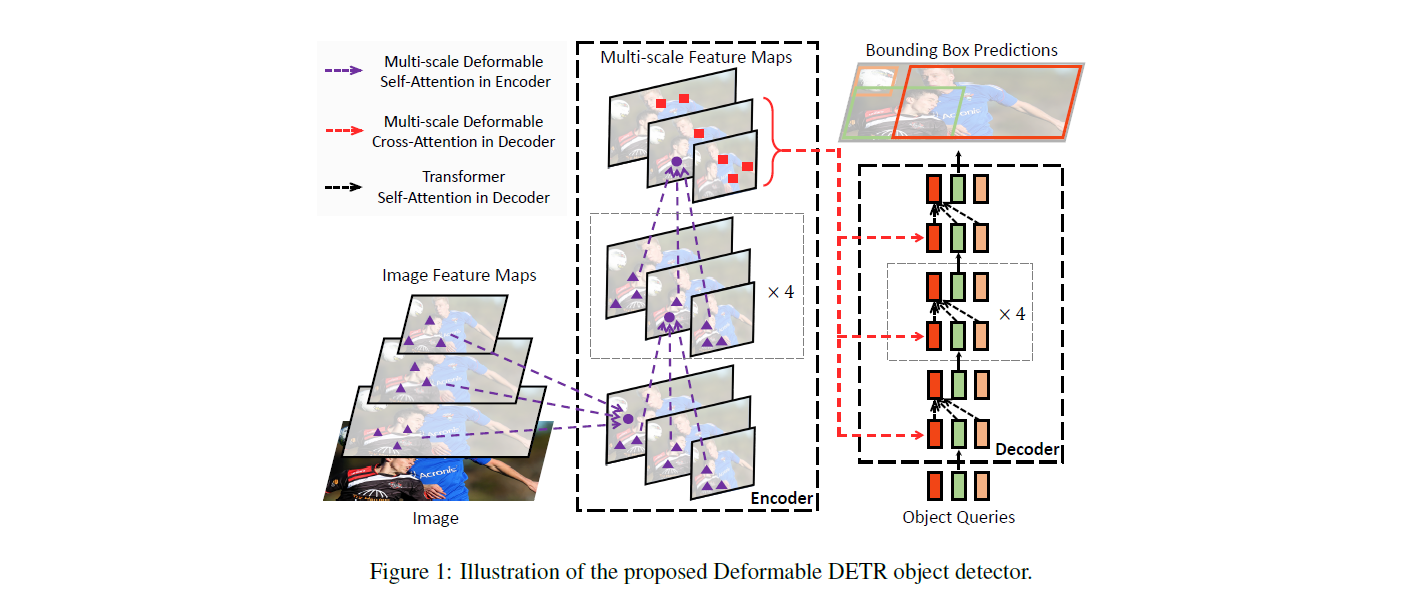

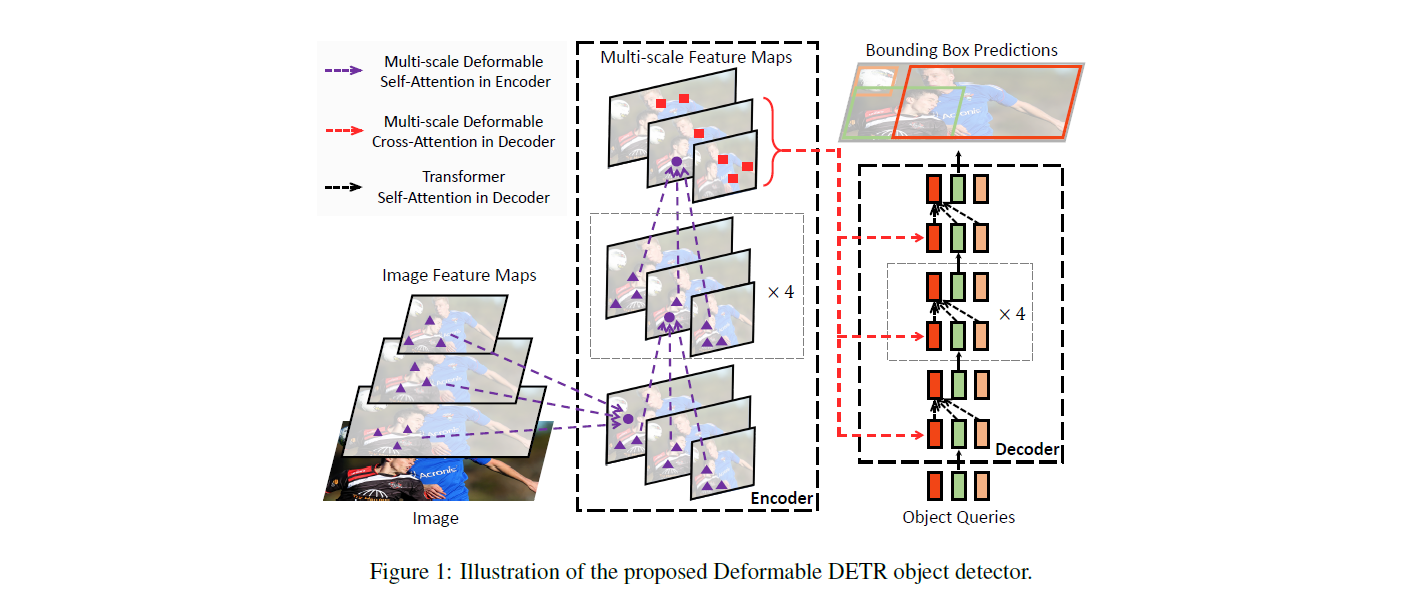

- 基於Transformer架構:採用編碼器 - 解碼器的Transformer架構,結合卷積骨幹網絡,提升了檢測性能。

- 目標查詢機制:使用目標查詢來檢測圖像中的物體,每個查詢負責尋找特定的物體。

📚 詳細文檔

模型描述

DETR模型是一個帶有卷積骨幹網絡的編碼器 - 解碼器Transformer。為了進行目標檢測,在解碼器輸出的基礎上添加了兩個頭部:一個用於類別標籤的線性層和一個用於邊界框的多層感知機(MLP)。該模型使用所謂的目標查詢來檢測圖像中的物體,對於COCO數據集,目標查詢的數量設置為100。

模型使用“二分匹配損失”進行訓練:將N = 100個目標查詢的預測類別和邊界框與真實標註進行比較,真實標註會填充到相同的長度N(例如,如果一張圖像僅包含4個物體,那麼96個標註的類別將為“無物體”,邊界框為“無邊界框”)。使用匈牙利匹配算法在N個查詢和N個標註之間創建最優的一對一映射。然後,使用標準的交叉熵損失(用於類別)和L1損失與廣義IoU損失的線性組合(用於邊界框)來優化模型的參數。

預期用途與限制

你可以使用該原始模型進行目標檢測。目前,特徵提取器和模型都支持PyTorch。

💻 使用示例

基礎用法

from transformers import AutoImageProcessor, DeformableDetrForObjectDetection

import torch

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

processor = AutoImageProcessor.from_pretrained("SenseTime/deformable-detr")

model = DeformableDetrForObjectDetection.from_pretrained("SenseTime/deformable-detr")

inputs = processor(images=image, return_tensors="pt")

outputs = model(**inputs)

target_sizes = torch.tensor([image.size[::-1]])

results = processor.post_process_object_detection(outputs, target_sizes=target_sizes, threshold=0.7)[0]

for score, label, box in zip(results["scores"], results["labels"], results["boxes"]):

box = [round(i, 2) for i in box.tolist()]

print(

f"Detected {model.config.id2label[label.item()]} with confidence "

f"{round(score.item(), 3)} at location {box}"

)

此代碼的輸出示例如下:

Detected cat with confidence 0.856 at location [342.19, 24.3, 640.02, 372.25]

Detected remote with confidence 0.739 at location [40.79, 72.78, 176.76, 117.25]

Detected cat with confidence 0.859 at location [16.5, 52.84, 318.25, 470.78]

📦 安裝指南

文檔未提及安裝步驟,可參考Hugging Face的transformers庫安裝說明進行安裝。

🔧 技術細節

訓練數據

可變形DETR模型在COCO 2017目標檢測數據集上進行訓練,該數據集分別包含11.8萬張和5000張用於訓練和驗證的標註圖像。

BibTeX引用

@misc{https://doi.org/10.48550/arxiv.2010.04159,

doi = {10.48550/ARXIV.2010.04159},

url = {https://arxiv.org/abs/2010.04159},

author = {Zhu, Xizhou and Su, Weijie and Lu, Lewei and Li, Bin and Wang, Xiaogang and Dai, Jifeng},

keywords = {Computer Vision and Pattern Recognition (cs.CV), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {Deformable DETR: Deformable Transformers for End-to-End Object Detection},

publisher = {arXiv},

year = {2020},

copyright = {arXiv.org perpetual, non-exclusive license}

}

📄 許可證

本模型採用Apache - 2.0許可證。

| 屬性 |

詳情 |

| 模型類型 |

可變形DETR模型 |

| 訓練數據 |

COCO 2017目標檢測數據集 |

⚠️ 重要提示

發佈可變形DETR的團隊並未為此模型撰寫模型卡片,此模型卡片由Hugging Face團隊編寫。

💡 使用建議

可以根據實際需求調整目標檢測的閾值,以平衡檢測的精度和召回率。

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語