🚀 Data2Vec-Vision(基礎大小模型,僅預訓練)

Data2Vec-Vision 是一個基於 BEiT 架構的模型,在 ImageNet-1k 數據集上進行自監督預訓練。該模型可用於圖像分類任務,為相關領域的研究和應用提供了有力支持。

🚀 快速開始

你可以使用這個原始模型進行圖像分類。若想尋找針對特定任務的微調版本,可查看 模型中心。

✨ 主要特性

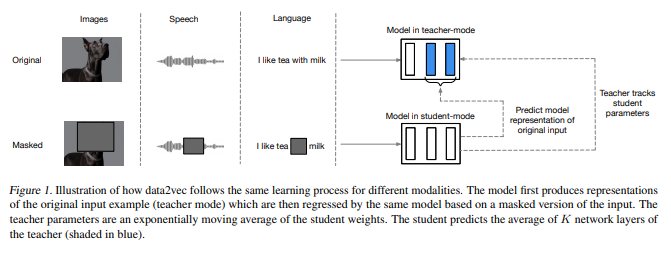

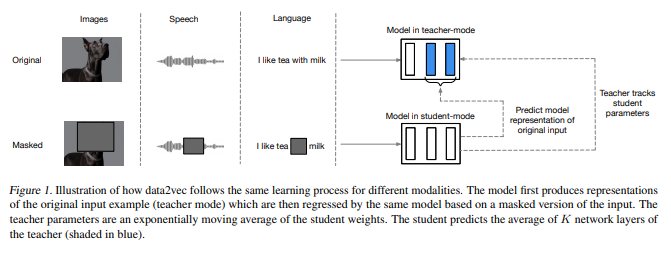

- 跨模態通用性:data2vec 框架使用相同的學習方法應用於語音、自然語言處理或計算機視覺領域。

- 自蒸餾學習:通過自蒸餾設置,基於輸入的掩碼視圖預測完整輸入數據的潛在表示。

- 上下文潛在表示:預測包含整個輸入信息的上下文潛在表示,而非特定模態的局部目標。

📚 詳細文檔

預訓練方法

更多信息請查看 官方論文。

更多信息請查看 官方論文。

摘要

雖然自監督學習的總體思想在不同模態之間是相同的,但實際的算法和目標卻大相徑庭,因為它們是針對單一模態開發的。為了更接近通用的自監督學習,我們提出了 data2vec 框架,該框架對語音、自然語言處理或計算機視覺使用相同的學習方法。其核心思想是在使用標準 Transformer 架構的自蒸餾設置中,基於輸入的掩碼視圖預測完整輸入數據的潛在表示。與預測本質上是局部的特定模態目標(如單詞、視覺標記或人類語音單元)不同,data2vec 預測包含整個輸入信息的上下文潛在表示。在語音識別、圖像分類和自然語言理解的主要基準測試上的實驗表明,該方法達到了新的技術水平,或與主流方法具有競爭力。

預期用途和限制

你可以使用原始模型進行圖像分類。查看 模型中心 以尋找針對你感興趣任務的微調版本。

訓練數據

BEiT 模型在 ImageNet-1k 數據集上進行預訓練,該數據集包含 120 萬張圖像和 1000 個類別。

訓練過程

預處理

訓練/驗證期間圖像預處理的確切細節可在 此處 找到。

圖像被調整大小/重新縮放至相同分辨率(224x224),並在 RGB 通道上進行歸一化,均值為 (0.5, 0.5, 0.5),標準差為 (0.5, 0.5, 0.5)。

預訓練

所有與預訓練相關的超參數,請參考 原始論文 和 原始代碼庫。

評估結果

關於幾個圖像分類基準的評估結果,請參考原始論文的表 1。請注意,對於微調,使用更高分辨率可獲得最佳結果。當然,增加模型大小會提高性能。

BibTeX 引用和引用信息

@misc{https://doi.org/10.48550/arxiv.2202.03555,

doi = {10.48550/ARXIV.2202.03555},

url = {https://arxiv.org/abs/2202.03555},

author = {Baevski, Alexei and Hsu, Wei-Ning and Xu, Qiantong and Babu, Arun and Gu, Jiatao and Auli, Michael},

keywords = {Machine Learning (cs.LG), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language},

publisher = {arXiv},

year = {2022},

copyright = {arXiv.org perpetual, non-exclusive license}

}

📄 許可證

本項目採用 Apache-2.0 許可證。

📦 信息表格

| 屬性 |

詳情 |

| 模型類型 |

用於圖像分類的預訓練 BEiT 模型 |

| 訓練數據 |

ImageNet-1k 數據集,包含 120 萬張圖像和 1000 個類別 |

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語 更多信息請查看

更多信息請查看