模型概述

模型特點

模型能力

使用案例

🚀 阿拉伯語大模型Wav2Vec2-Large-XLSR-53

本項目基於預訓練模型 facebook/wav2vec2-large-xlsr-53,在阿拉伯語上進行了微調。使用了 Common Voice 和 Arabic Speech Corpus 的訓練集數據。使用該模型時,請確保語音輸入的採樣率為 16kHz。

🚀 快速開始

本模型是基於預訓練模型 facebook/wav2vec2-large-xlsr-53 在阿拉伯語語音數據上微調得到的。使用時需注意語音輸入採樣率為 16kHz。

✨ 主要特性

- 數據集豐富:使用了 Common Voice 和 Arabic Speech Corpus 兩個數據集進行訓練。

- 格式特殊:使用 Buckwalter 轉寫 格式表示阿拉伯語,僅包含 ASCII 字符。

📦 安裝指南

文檔未提及安裝步驟,故跳過此章節。

💻 使用示例

基礎用法

模型可以直接使用(無需語言模型),示例代碼如下:

import torch

import torchaudio

from datasets import load_dataset

from lang_trans.arabic import buckwalter

from transformers import Wav2Vec2ForCTC, Wav2Vec2Processor

dataset = load_dataset("common_voice", "ar", split="test[:10]")

resamplers = { # all three sampling rates exist in test split

48000: torchaudio.transforms.Resample(48000, 16000),

44100: torchaudio.transforms.Resample(44100, 16000),

32000: torchaudio.transforms.Resample(32000, 16000),

}

def prepare_example(example):

speech, sampling_rate = torchaudio.load(example["path"])

example["speech"] = resamplers[sampling_rate](speech).squeeze().numpy()

return example

dataset = dataset.map(prepare_example)

processor = Wav2Vec2Processor.from_pretrained("elgeish/wav2vec2-large-xlsr-53-arabic")

model = Wav2Vec2ForCTC.from_pretrained("elgeish/wav2vec2-large-xlsr-53-arabic").eval()

def predict(batch):

inputs = processor(batch["speech"], sampling_rate=16000, return_tensors="pt", padding=True)

with torch.no_grad():

predicted = torch.argmax(model(inputs.input_values).logits, dim=-1)

predicted[predicted == -100] = processor.tokenizer.pad_token_id # see fine-tuning script

batch["predicted"] = processor.tokenizer.batch_decode(predicted)

return batch

dataset = dataset.map(predict, batched=True, batch_size=1, remove_columns=["speech"])

for reference, predicted in zip(dataset["sentence"], dataset["predicted"]):

print("reference:", reference)

print("predicted:", buckwalter.untrans(predicted))

print("--")

以下是代碼的輸出示例:

reference: ألديك قلم ؟

predicted: هلديك قالر

--

reference: ليست هناك مسافة على هذه الأرض أبعد من يوم أمس.

predicted: ليست نالك مسافة على هذه الأرض أبعد من يوم أمس

--

reference: إنك تكبر المشكلة.

predicted: إنك تكبر المشكلة

--

reference: يرغب أن يلتقي بك.

predicted: يرغب أن يلتقي بك

--

reference: إنهم لا يعرفون لماذا حتى.

predicted: إنهم لا يعرفون لماذا حتى

--

reference: سيسعدني مساعدتك أي وقت تحب.

predicted: سيسئدني مساعد سكرأي وقت تحب

--

reference: أَحَبُّ نظريّة علمية إليّ هي أن حلقات زحل مكونة بالكامل من الأمتعة المفقودة.

predicted: أحب ناضريةً علمية إلي هي أنحل قتزح المكونا بالكامل من الأمت عن المفقودة

--

reference: سأشتري له قلماً.

predicted: سأشتري له قلما

--

reference: أين المشكلة ؟

predicted: أين المشكل

--

reference: وَلِلَّهِ يَسْجُدُ مَا فِي السَّمَاوَاتِ وَمَا فِي الْأَرْضِ مِنْ دَابَّةٍ وَالْمَلَائِكَةُ وَهُمْ لَا يَسْتَكْبِرُونَ

predicted: ولله يسجد ما في السماوات وما في الأرض من دابة والملائكة وهم لا يستكبرون

--

📚 詳細文檔

評估

可以在 Common Voice 的阿拉伯語測試數據上對模型進行評估,示例代碼如下:

import jiwer

import torch

import torchaudio

from datasets import load_dataset

from lang_trans.arabic import buckwalter

from transformers import set_seed, Wav2Vec2ForCTC, Wav2Vec2Processor

set_seed(42)

test_split = load_dataset("common_voice", "ar", split="test")

resamplers = { # all three sampling rates exist in test split

48000: torchaudio.transforms.Resample(48000, 16000),

44100: torchaudio.transforms.Resample(44100, 16000),

32000: torchaudio.transforms.Resample(32000, 16000),

}

def prepare_example(example):

speech, sampling_rate = torchaudio.load(example["path"])

example["speech"] = resamplers[sampling_rate](speech).squeeze().numpy()

return example

test_split = test_split.map(prepare_example)

processor = Wav2Vec2Processor.from_pretrained("elgeish/wav2vec2-large-xlsr-53-arabic")

model = Wav2Vec2ForCTC.from_pretrained("elgeish/wav2vec2-large-xlsr-53-arabic").to("cuda").eval()

def predict(batch):

inputs = processor(batch["speech"], sampling_rate=16000, return_tensors="pt", padding=True)

with torch.no_grad():

predicted = torch.argmax(model(inputs.input_values.to("cuda")).logits, dim=-1)

predicted[predicted == -100] = processor.tokenizer.pad_token_id # see fine-tuning script

batch["predicted"] = processor.tokenizer.batch_decode(predicted)

return batch

test_split = test_split.map(predict, batched=True, batch_size=16, remove_columns=["speech"])

transformation = jiwer.Compose([

# normalize some diacritics, remove punctuation, and replace Persian letters with Arabic ones

jiwer.SubstituteRegexes({

r'[auiFNKo\~_،؟»\?;:\-,\.؛«!"]': "", "\u06D6": "",

r"[\|\{]": "A", "p": "h", "ک": "k", "ی": "y"}),

# default transformation below

jiwer.RemoveMultipleSpaces(),

jiwer.Strip(),

jiwer.SentencesToListOfWords(),

jiwer.RemoveEmptyStrings(),

])

metrics = jiwer.compute_measures(

truth=[buckwalter.trans(s) for s in test_split["sentence"]], # Buckwalter transliteration

hypothesis=test_split["predicted"],

truth_transform=transformation,

hypothesis_transform=transformation,

)

print(f"WER: {metrics['wer']:.2%}")

測試結果:26.55%

訓練

更多訓練細節請參考 使用阿拉伯語語音語料庫進行微調。

本模型使用 Buckwalter 轉寫 格式表示阿拉伯語,該格式僅包含 ASCII 字符。使用 lang-trans 包進行阿拉伯語字母的轉寫。

使用 此腳本 首先在 Arabic Speech Corpus 數據集的訓練集上對 facebook/wav2vec2-large-xlsr-53 進行微調,使用測試集進行模型選擇,得到的模型保存為 elgeish/wav2vec2-large-xlsr-53-levantine-arabic。

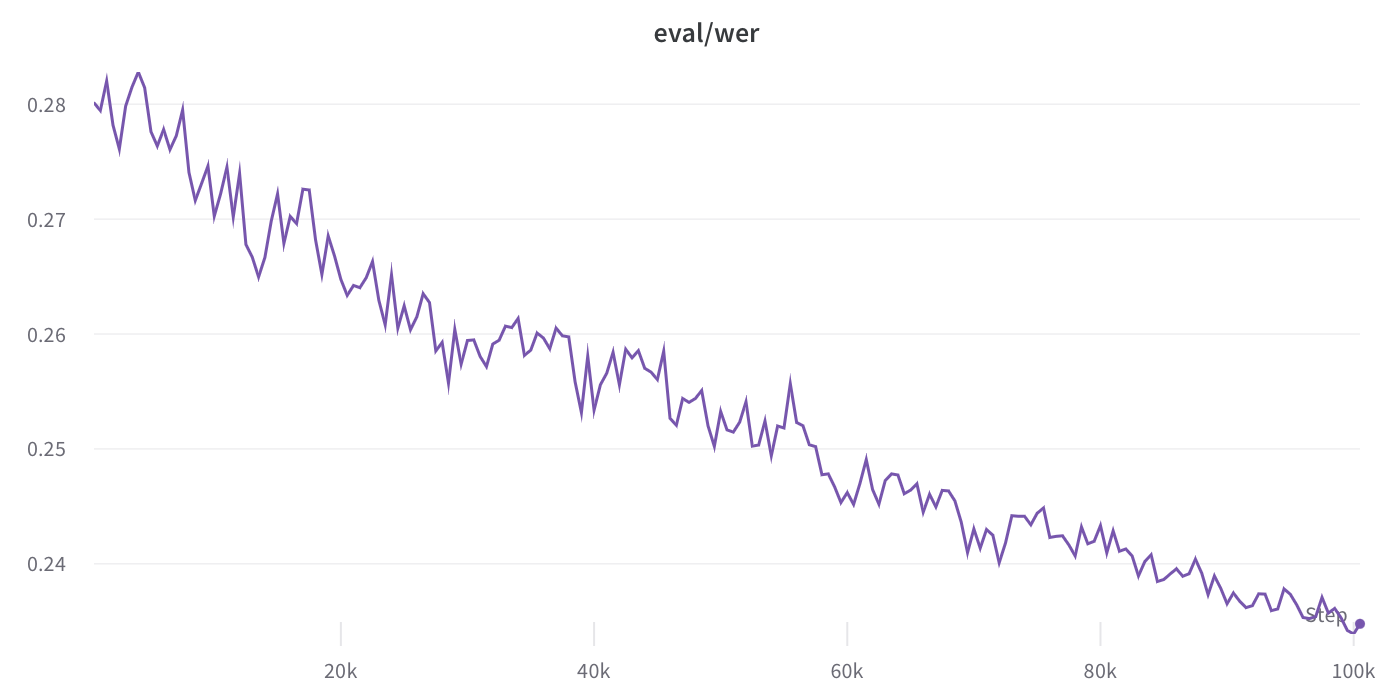

然後使用 Common Voice 數據集的訓練集繼續訓練,使用驗證集進行模型選擇。訓練在 Fine-Tune-XLSR Week 的截止日期停止,此模型是在 100k 步時的檢查點,驗證集的字錯率(WER)為 23.39%。

值得注意的是,驗證集的字錯率呈下降趨勢,這表明進一步訓練(以 7e-6 的衰減學習率繼續訓練)有提升模型性能的潛力。

🔧 技術細節

文檔未提供具體技術細節,故跳過此章節。

📄 許可證

本模型使用的許可證為 Apache-2.0。

💡 使用建議

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語