🚀 ColQwen2.5-3b-multilingual:基於Qwen2.5-VL-3B-Instruct與ColBERT策略的多語言視覺檢索器

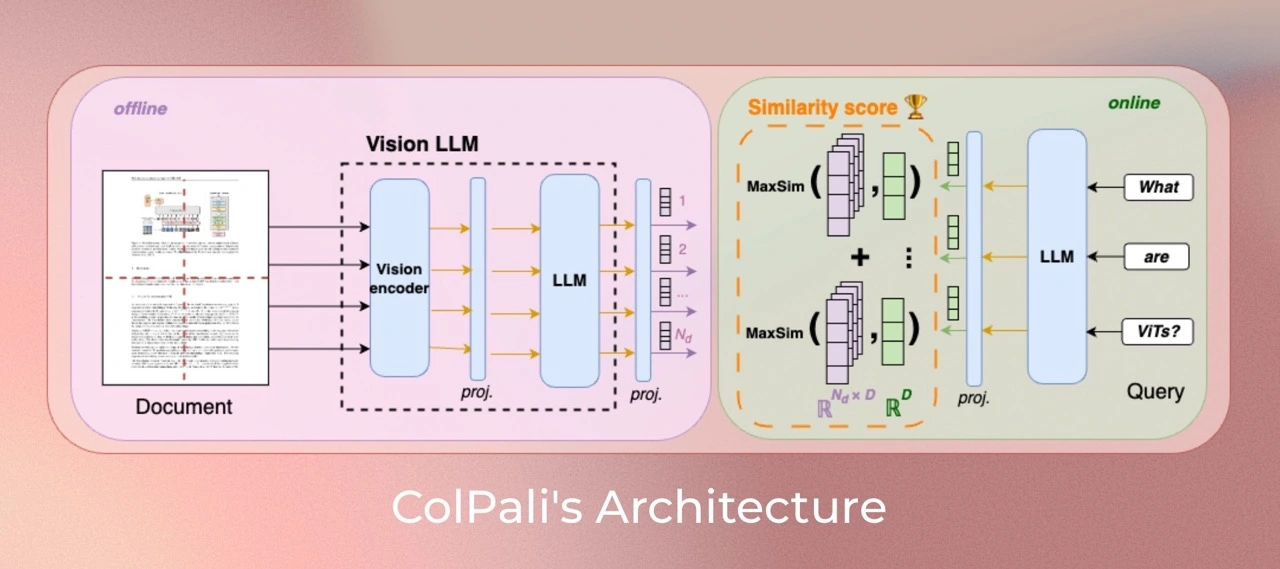

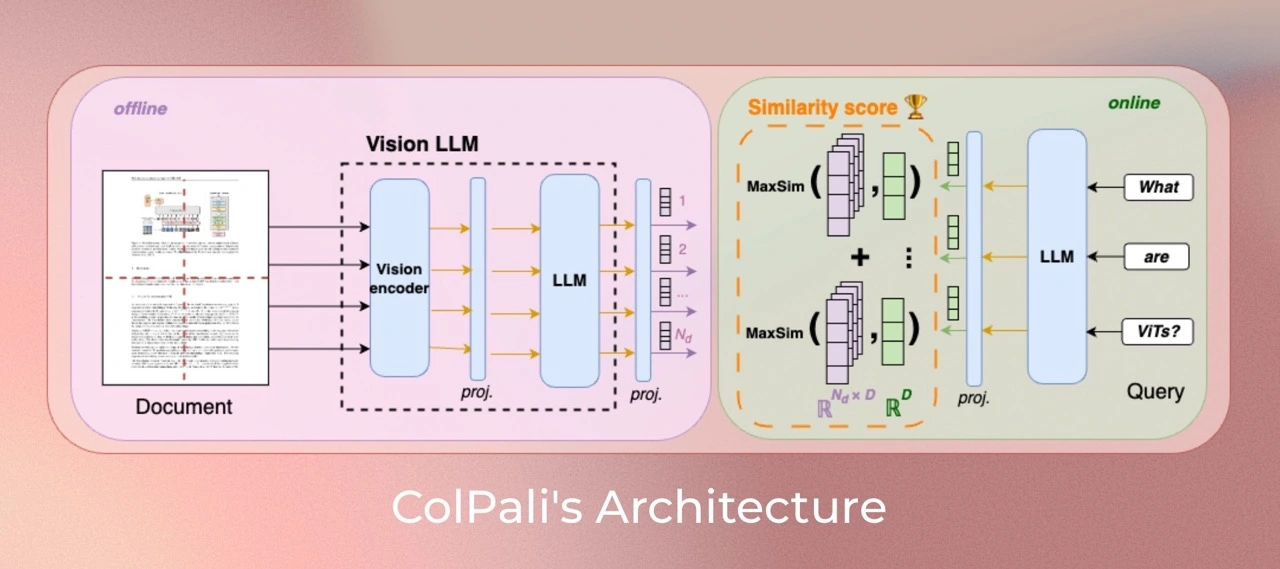

ColQwen2.5-3b-multilingual是一個基於視覺語言模型(VLMs)的新型模型架構和訓練策略的模型,旨在從文檔的視覺特徵中高效地對文檔進行索引。它是Qwen2.5-VL-3B的擴展版本,能夠生成ColBERT風格的文本和圖像多向量表示。

主要信息

- 排名情況:截至2025年2月2日,在Vidore基準測試中,參數小於70億的模型中排名第1,總體排名第3。Vidore排行榜上報告的分數對應於checkpoint - 1800。

- 訓練版本:這是在4xA100 80GB上訓練的基礎版本,每個設備的批量大小為128,梯度累積步數為2,訓練了5個epoch。

✨ 主要特性

- 多語言支持:支持英語、法語、西班牙語、意大利語和德語等多種語言。

- 動態圖像分辨率:模型可以接受動態圖像分辨率作為輸入,而不會像ColPali那樣改變其縱橫比。最大分辨率設置為最多創建768個圖像塊。實驗表明,增加圖像塊的數量可以顯著提高性能,但會增加內存需求。

- 高效文檔檢索:基於ColBERT策略,能夠高效地從視覺特徵中索引文檔。

📦 安裝指南

環境要求

- 確保

colpali-engine從源代碼安裝或版本高於0.3.1。

transformers版本必須大於4.45.0。

ColPali安裝

pip install git+https://github.com/illuin-tech/colpali

或

pip install git+https://github.com/illuin-tech/colpali@colqwen2_5

Qwen2.5安裝

Qwen2.5 - VL的代碼已經集成在最新的Hugging face transformers中,建議使用以下命令從源代碼構建:

pip install git+https://github.com/huggingface/transformers accelerate

否則可能會遇到以下錯誤:

KeyError: 'qwen2_5_vl'

💻 使用示例

基礎用法

import torch

from PIL import Image

from colpali_engine.models import ColQwen2_5, ColQwen2_5_Processor

model = ColQwen2_5.from_pretrained(

"Metric-AI/colqwen2.5-3b-multilingual",

torch_dtype=torch.bfloat16,

device_map="cuda:0",

).eval()

processor = ColQwen2_5_Processor.from_pretrained("Metric-AI/colqwen2.5-3b-multilingual")

images = [

Image.new("RGB", (32, 32), color="white"),

Image.new("RGB", (16, 16), color="black"),

]

queries = [

"Is attention really all you need?",

"What is the amount of bananas farmed in Salvador?",

]

batch_images = processor.process_images(images).to(model.device)

batch_queries = processor.process_queries(queries).to(model.device)

with torch.no_grad():

image_embeddings = model(**batch_images)

query_embeddings = model(**batch_queries)

scores = processor.score_multi_vector(query_embeddings, image_embeddings)

📚 詳細文檔

數據集

- 合成數據:從

openbmb/VisRAG-Ret-Train-Synthetic-data數據集中選擇並預處理。

- 領域內VQA數據集:來自

openbmb/VisRAG-Ret-Train-In-domain-data。

- Docmatix數據集:從

Metric-AI/rag_docmatix_100k數據集中提取。

- Colpali數據集:來自

vidore/colpali_train_set。

- 多語言數據集:來自

llamaindex/vdr-multilingual-train。

模型訓練參數

使用低秩適配器(LoRA)在語言模型的Transformer層以及最終隨機初始化的投影層上進行訓練,其中alpha = 128,r = 128,並使用paged_adamw_8bit優化器。

訓練環境為4xA100 GPU,採用分佈式數據並行(通過accelerate),學習率為2e - 4,線性衰減,熱身步驟為1%,每個設備的批量大小為128,梯度累積步數為2,使用bfloat16格式。

侷限性

- 聚焦範圍:模型主要聚焦於PDF類型的文檔和資源豐富的語言,可能限制了其對其他文檔類型或代表性不足語言的泛化能力。

- 支持情況:模型依賴於從ColBERT後期交互機制派生的多向量檢索,可能需要工程努力才能適應缺乏原生多向量支持的廣泛使用的向量檢索框架。

📄 許可證

ColQwen2.5的視覺語言骨幹模型(Qwen2.5 - VL)遵循apache2.0許可證。附加到模型的適配器遵循MIT許可證。

🔗 引用

如果在研究中使用了該組織的模型,請按以下方式引用原始論文:

@misc{faysse2024colpaliefficientdocumentretrieval,

title={ColPali: Efficient Document Retrieval with Vision Language Models},

author={Manuel Faysse and Hugues Sibille and Tony Wu and Bilel Omrani and Gautier Viaud and Céline Hudelot and Pierre Colombo},

year={2024},

eprint={2407.01449},

archivePrefix={arXiv},

primaryClass={cs.IR},

url={https://arxiv.org/abs/2407.01449},

}

開發者信息

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語