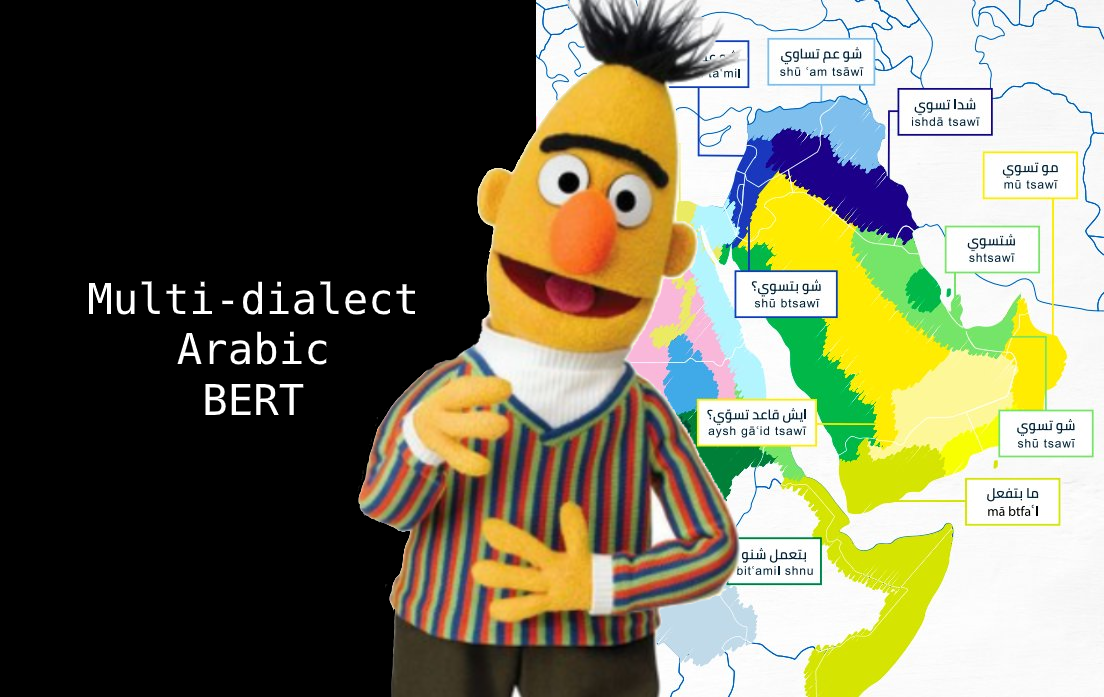

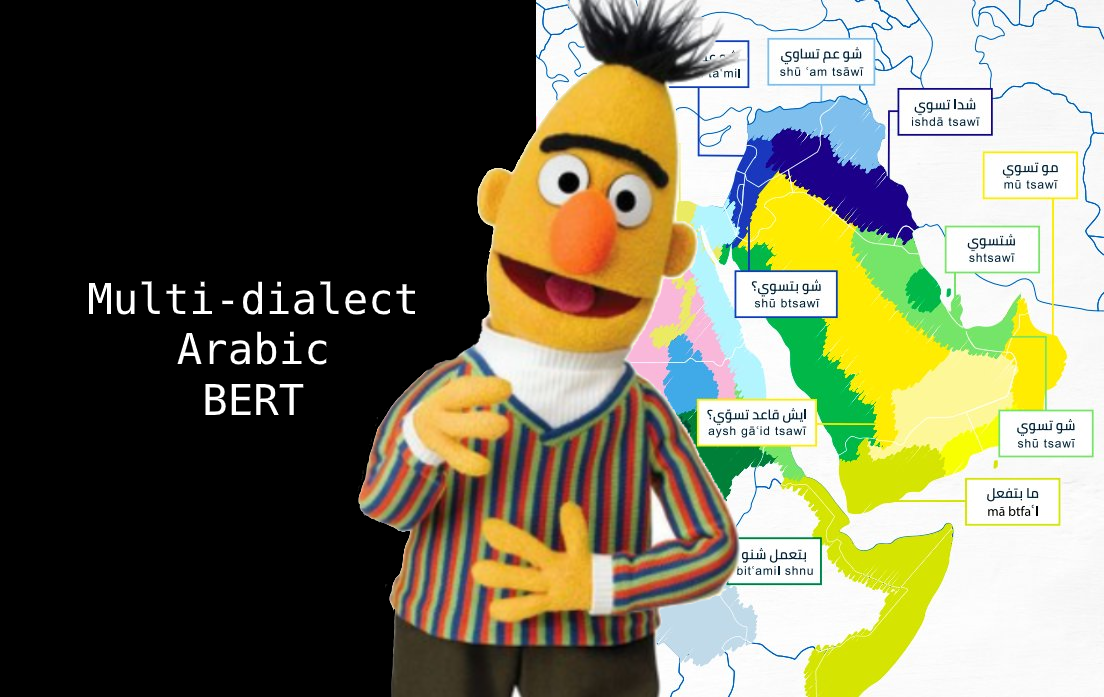

🚀 多方言阿拉伯語BERT模型

本項目是多方言阿拉伯語BERT模型的代碼倉庫,由 Mawdoo3-AI 開發。該模型旨在解決阿拉伯語不同方言的處理問題,為阿拉伯語的自然語言處理任務提供更強大的支持。

🚀 快速開始

本模型的權重可以使用HuggingFace的transformers庫進行加載。

基礎用法

from transformers import AutoTokenizer, AutoModel

tokenizer = AutoTokenizer.from_pretrained("bashar-talafha/multi-dialect-bert-base-arabic")

model = AutoModel.from_pretrained("bashar-talafha/multi-dialect-bert-base-arabic")

高級用法

使用pipeline的示例:

from transformers import pipeline

fill_mask = pipeline(

"fill-mask",

model="bashar-talafha/multi-dialect-bert-base-arabic ",

tokenizer="bashar-talafha/multi-dialect-bert-base-arabic "

)

fill_mask(" سافر الرحالة من مطار [MASK] ")

[{'sequence': '[CLS] سافر الرحالة من مطار الكويت [SEP]', 'score': 0.08296813815832138, 'token': 3226},

{'sequence': '[CLS] سافر الرحالة من مطار دبي [SEP]', 'score': 0.05123933032155037, 'token': 4747},

{'sequence': '[CLS] سافر الرحالة من مطار مسقط [SEP]', 'score': 0.046838656067848206, 'token': 13205},

{'sequence': '[CLS] سافر الرحالة من مطار القاهرة [SEP]', 'score': 0.03234650194644928, 'token': 4003},

{'sequence': '[CLS] سافر الرحالة من مطار الرياض [SEP]', 'score': 0.02606341242790222, 'token': 2200}]

✨ 主要特性

本模型並非從頭開始訓練多方言阿拉伯語BERT模型,而是使用 Arabic-BERT 初始化模型的權重,並在 The Nuanced Arabic Dialect Identification (NADI) shared task 的1000萬條未標記阿拉伯語推文數據上進行訓練。

📚 詳細文檔

如需更多信息,請查看 原始倉庫。

📄 許可證

引用本工作

@misc{talafha2020multidialect,

title={Multi-Dialect Arabic BERT for Country-Level Dialect Identification},

author={Bashar Talafha and Mohammad Ali and Muhy Eddin Za'ter and Haitham Seelawi and Ibraheem Tuffaha and Mostafa Samir and Wael Farhan and Hussein T. Al-Natsheh},

year={2020},

eprint={2007.05612},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

Transformers 支持多種語言

Transformers 支持多種語言 Transformers 支持多種語言

Transformers 支持多種語言 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語