Model Overview

Model Features

Model Capabilities

Use Cases

🚀 GLM-4.1V-9B-Thinking-AWQ

本仓库托管了GLM-4.1V-9B-Thinking的AWQ量化版本。GLM-4.1V-9B-Thinking是一款强大的视觉语言模型(VLM),旨在实现多模态理解和推理。

该模型在论文GLM-4.1V-Thinking: Towards Versatile Multimodal Reasoning with Scalable Reinforcement Learning中被提出。

官方GitHub仓库:https://github.com/THUDM/GLM-4.1V-Thinking

基础模型:ZhipuAI/GLM-4.1V-9B-Thinking

🚀 快速开始

模型更新日期

2025-07-03

1. 首次commit

2. 确定支持1、2、4卡的`tensor-parallel-size`启动

依赖项

vllm==0.9.2

⚠️ 重要提示

2025年7月3日的临时安装命令如下:

pip3 install -r requirements.txt

git clone https://github.com/zRzRzRzRzRzRzR/vllm.git

cd vllm

git checkout glm4_1-v

VLLM_USE_PRECOMPILED=1 pip install --editable .

模型列表

| 文件大小 | 最近更新时间 |

|---|---|

6.9GB |

2025-07-03 |

模型下载

from modelscope import snapshot_download

snapshot_download('dengcao/GLM-4.1V-9B-Thinking-AWQ', cache_dir="本地路径")

👋 加入我们的 Discord

📖 查看GLM-4.1V-9B-Thinking 论文。

💡 在 Hugging Face 或 ModelScope 上尝试GLM-4.1V-9B-Thinking的在线演示。

📍 在 智谱基础模型开放平台 使用GLM-4.1V-9B-Thinking API。

✨ 主要特性

视觉语言模型(VLM)已成为智能系统的基础组成部分。随着现实世界中的AI任务日益复杂,VLM必须超越基本的多模态感知,提升其在复杂任务中的推理能力。这包括提高准确性、全面性和智能性,以实现复杂问题解决、长上下文理解和多模态智能体等应用。

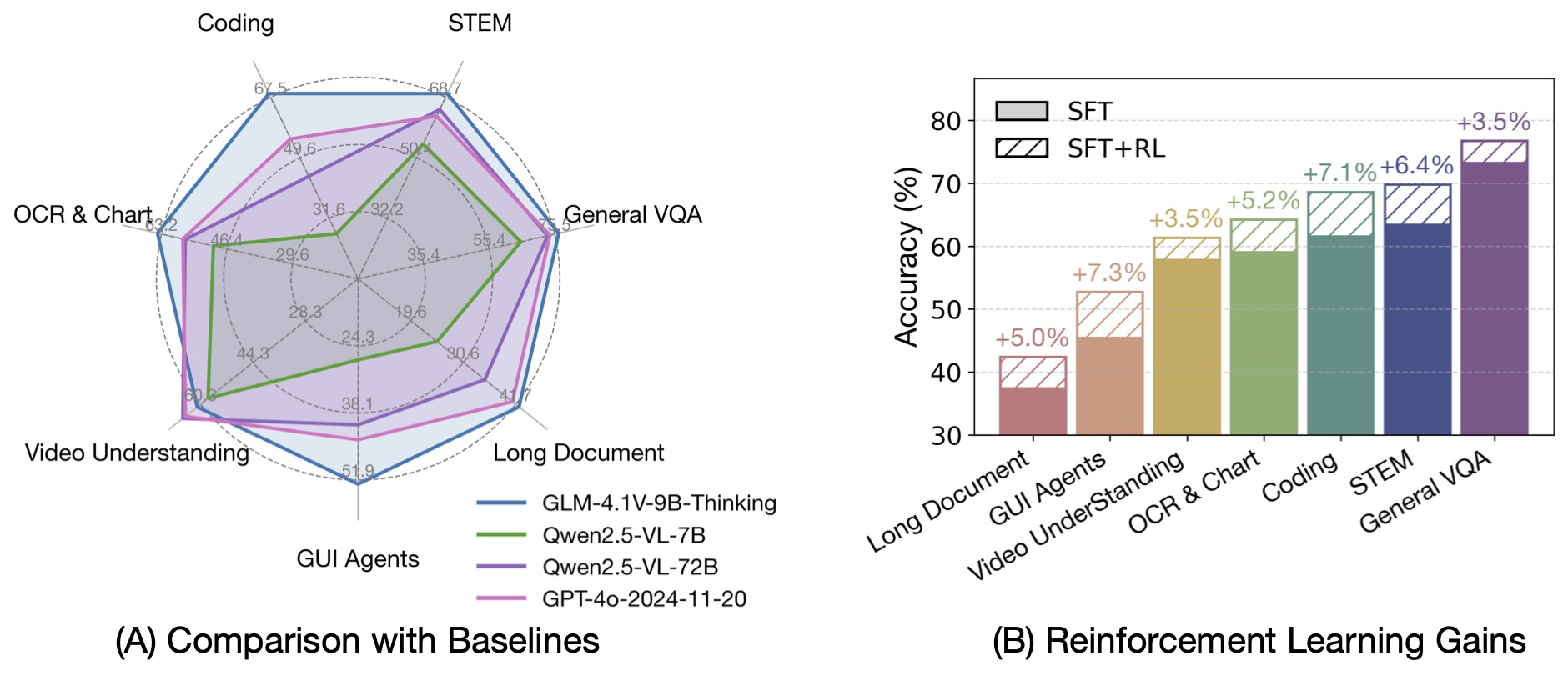

基于GLM-4-9B-0414基础模型,我们推出了新的开源VLM模型GLM-4.1V-9B-Thinking,旨在探索视觉语言模型推理能力的上限。通过引入“思维范式”并利用强化学习,该模型显著提升了其能力。在100亿参数的VLM中,它达到了领先水平,在18个基准任务上与甚至超过了720亿参数的Qwen-2.5-VL-72B。我们还开源了基础模型GLM-4.1V-9B-Base,以支持对VLM能力边界的进一步研究。

与上一代模型CogVLM2和GLM-4V系列相比,GLM-4.1V-Thinking有以下改进:

- 该系列中首个专注于推理的模型,不仅在数学领域,而且在各个子领域都取得了世界领先的性能。

- 支持64k上下文长度。

- 处理任意宽高比和最高4K的图像分辨率。

- 提供支持中英文双语使用的开源版本。

📦 安装指南

依赖项

vllm==0.9.2

⚠️ 重要提示

2025年7月3日的临时安装命令如下:

pip3 install -r requirements.txt

git clone https://github.com/zRzRzRzRzRzRzR/vllm.git

cd vllm

git checkout glm4_1-v

VLLM_USE_PRECOMPILED=1 pip install --editable .

💻 使用示例

模型推理

所有推理脚本都位于inference文件夹中,包括:

trans_infer_cli.py:一个使用transformers库作为后端的命令行交互脚本,支持多轮对话。trans_infer_gradio.py:一个基于Gradio的Web UI脚本,使用transformers后端,支持图像、视频、PDF和PPT等多模态输入。- 使用

vllm的OpenAI兼容API服务,vllm_api_request.py中提供了一个简单的请求示例。

vllm serve THUDM/GLM-4.1V-9B-Thinking --limit-mm-per-prompt '{"image":32}' --allowed-local-media-path /

-

如果未指定

--limit-mm-per-prompt,则仅支持1张图像。该模型每个输入最多支持1个视频或300张图像,不支持同时输入图像和视频。 -

必须设置

--allowed-local-media-path以允许访问本地多模态输入。 -

trans_infer_bench:用于GLM-4.1V-9B-Thinking推理的学术基准测试脚本。主要特点:- 如果思考超过8192个标记,会自动中断思考并追加

</think><answer>以提示模型生成最终答案。 - 演示了基于视频的输入,对于其他模态,需要进行修改。

- 仅提供了

transformers版本。对于vllm,需要自定义实现以支持此逻辑。

- 如果思考超过8192个标记,会自动中断思考并追加

-

vllm_request_gui_agent.py:此脚本演示了如何处理模型响应并构建用于GUI智能体用例的提示。它涵盖了移动、桌面和Web环境的策略,可集成到您的应用框架中。有关GUI智能体的详细文档,请参阅此文件。 -

对于昇腾NPU推理,请查看此处。

模型微调

LLaMA-Factory现在支持对该模型进行微调。以下是一个使用两张图像的示例数据集。请像下面这样在finetune.json文件中准备您的数据集:

[

{

"messages": [

{

"content": "<image>Who are they?",

"role": "user"

},

{

"content": "<think>

User ask me to observe the image and get the answer. I Know they are Kane and Gretzka from Bayern Munich.</think>

<answer>They're Kane and Gretzka from Bayern Munich.</answer>",

"role": "assistant"

},

{

"content": "<image>What are they doing?",

"role": "user"

},

{

"content": "<think>

I need to observe what this people are doing. Oh, They are celebrating on the soccer field.</think>

<answer>They are celebrating on the soccer field.</answer>",

"role": "assistant"

}

],

"images": [

"mllm_demo_data/1.jpg",

"mllm_demo_data/2.jpg"

]

}

]

<think> ... </think>内的内容将不存储在对话历史中,也不会在微调期间使用。<image>标签将在预处理期间被实际图像数据替换。

准备好数据集后,您可以使用标准的LLaMA-Factory管道进行微调。

📚 详细文档

模型信息

模型下载链接

| 模型 | 下载链接 | 模型类型 |

|---|---|---|

| GLM-4.1V-9B-Thinking | 🤗 Hugging Face 🤖 ModelScope |

推理模型 |

| GLM-4.1V-9B-Base | 🤗 Hugging Face 🤖 ModelScope |

基础模型 |

该模型的算法实现可在官方transformers仓库中找到。

运行时要求

推理

| 设备(单GPU) | 框架 | 最小内存 | 速度 | 精度 |

|---|---|---|---|---|

| NVIDIA A100 | transformers | 22GB | 14 - 22 Tokens / s | BF16 |

| NVIDIA A100 | vLLM | 22GB | 60 - 70 Tokens / s | BF16 |

微调

以下结果基于使用LLaMA-Factory工具包进行的图像微调。

| 设备(集群) | 策略 | 最小内存 / GPU数量 | 批量大小(每个GPU) | 冻结设置 |

|---|---|---|---|---|

| NVIDIA A100 | LORA | 21GB / 1 GPU | 1 | 冻结VIT |

| NVIDIA A100 | FULL ZERO2 | 280GB / 4 GPUs | 1 | 冻结VIT |

| NVIDIA A100 | FULL ZERO3 | 192GB / 4 GPUs | 1 | 冻结VIT |

| NVIDIA A100 | FULL ZERO2 | 304GB / 4 GPUs | 1 | 不冻结 |

| NVIDIA A100 | FULL ZERO3 | 210GB / 4 GPUs | 1 | 不冻结 |

注意:使用Zero2进行微调可能会导致零损失,建议使用Zero3进行稳定训练。

基准性能

基于GLM-4-9B-0414基础模型,我们推出了新的开源VLM模型GLM-4.1V-9B-Thinking,它引入了“思维”范式并利用课程采样强化学习(RLCS)全面提升了模型能力。在100亿参数的视觉语言模型中,它达到了领先水平,在18个基准任务上与甚至超过了720亿参数的Qwen-2.5-VL。我们还开源了基础模型GLM-4.1V-9B-Base,以支持对视觉语言模型前沿的进一步研究。

🔧 技术细节

本仓库代码基于GLM-4-9B-0414基础模型,通过引入“思维范式”和强化学习的方式,提升了模型的推理能力。具体实现细节可参考官方transformers仓库。

📄 许可证

- 本仓库中的代码根据Apache License 2.0发布。

- 模型GLM-4.1V-9B-Thinking和GLM-4.1V-9B-Base均根据MIT License许可。

引用

如果您认为我们的工作有帮助,请考虑引用以下论文:

@misc{glmvteam2025glm41vthinkingversatilemultimodalreasoning,

title={GLM-4.1V-Thinking: Towards Versatile Multimodal Reasoning with Scalable Reinforcement Learning},

author={GLM-V Team and Wenyi Hong and Wenmeng Yu and Xiaotao Gu and Guo Wang and Guobing Gan and Haomiao Tang and Jiale Cheng and Ji Qi and Junhui Ji and Lihang Pan and Shuaiqi Duan and Weihan Wang and Yan Wang and Yean Cheng and Zehai He and Zhe Su and Zhen Yang and Ziyang Pan and Aohan Zeng and Baoxu Wang and Boyan Shi and Changyu Pang and Chenhui Zhang and Da Yin and Fan Yang and Guoqing Chen and Jiazheng Xu and Jiali Chen and Jing Chen and Jinhao Chen and Jinghao Lin and Jinjiang Wang and Junjie Chen and Leqi Lei and Letian Gong and Leyi Pan and Mingzhi Zhang and Qinkai Zheng and Sheng Yang and Shi Zhong and Shiyu Huang and Shuyuan Zhao and Siyan Xue and Shangqin Tu and Shengbiao Meng and Tianshu Zhang and Tianwei Luo and Tianxiang Hao and Wenkai Li and Wei Jia and Xin Lyu and Xuancheng Huang and Yanling Wang and Yadong Xue and Yanfeng Wang and Yifan An and Yifan Du and Yiming Shi and Yiheng Huang and Yilin Niu and Yuan Wang and Yuanchang Yue and Yuchen Li and Yutao Zhang and Yuxuan Zhang and Zhanxiao Du and Zhenyu Hou and Zhao Xue and Zhengxiao Du and Zihan Wang and Peng Zhang and Debing Liu and Bin Xu and Juanzi Li and Minlie Huang and Yuxiao Dong and Jie Tang},

year={2025},

eprint={2507.01006},

archivePrefix={arXiv},

primaryClass={cs.CV},

url={https://arxiv.org/abs/2507.01006},

}

Transformers

Transformers Transformers English

Transformers English Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers

Transformers Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers

Transformers Transformers Supports Multiple Languages

Transformers Supports Multiple Languages Transformers English

Transformers English