🚀 GLM-4.1V-9B-Thinking

GLM-4.1V-9B-Thinkingは、視覚言語モデルに基づく革新的な成果です。複雑なタスクにおける推論能力を向上させることを目的としており、多くの分野のベンチマークテストで優れた性能を発揮し、インテリジェントシステムの発展に強力なサポートを提供します。

📄 GLM-4.1V-9B-Thinkingの 論文 を確認してください。

🧪 GLM-4.1V-9B-Thinkingの Hugging Face または ModelScope のオンラインデモを試してみてください。

💻 智譜基礎モデルオープンプラットフォーム でGLM-4.1V-9B-Thinking APIを使用してください。

🚀 クイックスタート

高速推論

これは transformers ライブラリを使用して単一画像の推論を行う簡単な例です。

まず、ソースコードから transformers ライブラリをインストールします。

pip install git+https://github.com/huggingface/transformers.git

次に、以下のコードを実行します。

from transformers import AutoProcessor, Glm4vForConditionalGeneration

import torch

MODEL_PATH = "THUDM/GLM-4.1V-9B-Thinking"

messages = [

{

"role": "user",

"content": [

{

"type": "image",

"url": "https://upload.wikimedia.org/wikipedia/commons/f/fa/Grayscale_8bits_palette_sample_image.png"

},

{

"type": "text",

"text": "describe this image"

}

],

}

]

processor = AutoProcessor.from_pretrained(MODEL_PATH, use_fast=True)

model = Glm4vForConditionalGeneration.from_pretrained(

pretrained_model_name_or_path=MODEL_PATH,

torch_dtype=torch.bfloat16,

device_map="auto",

)

inputs = processor.apply_chat_template(

messages,

tokenize=True,

add_generation_prompt=True,

return_dict=True,

return_tensors="pt"

).to(model.device)

generated_ids = model.generate(**inputs, max_new_tokens=8192)

output_text = processor.decode(generated_ids[0][inputs["input_ids"].shape[1]:], skip_special_tokens=False)

print(output_text)

ビデオ推論やウェブデモのデプロイなど、より多くのコードについては、私たちの GitHub をご覧ください。

✨ 主な機能

視覚言語モデル(VLMs)は、インテリジェントシステムの基盤となるコンポーネントになっています。現実世界のAIタスクがますます複雑になるにつれ、VLMsは基本的なマルチモーダル感知を超え、複雑なタスクにおける推論能力を向上させる必要があります。これには、複雑な問題解決、長文脈理解、マルチモーダルエージェントなどのアプリケーションを実現するために、精度、包括性、知性の向上が含まれます。

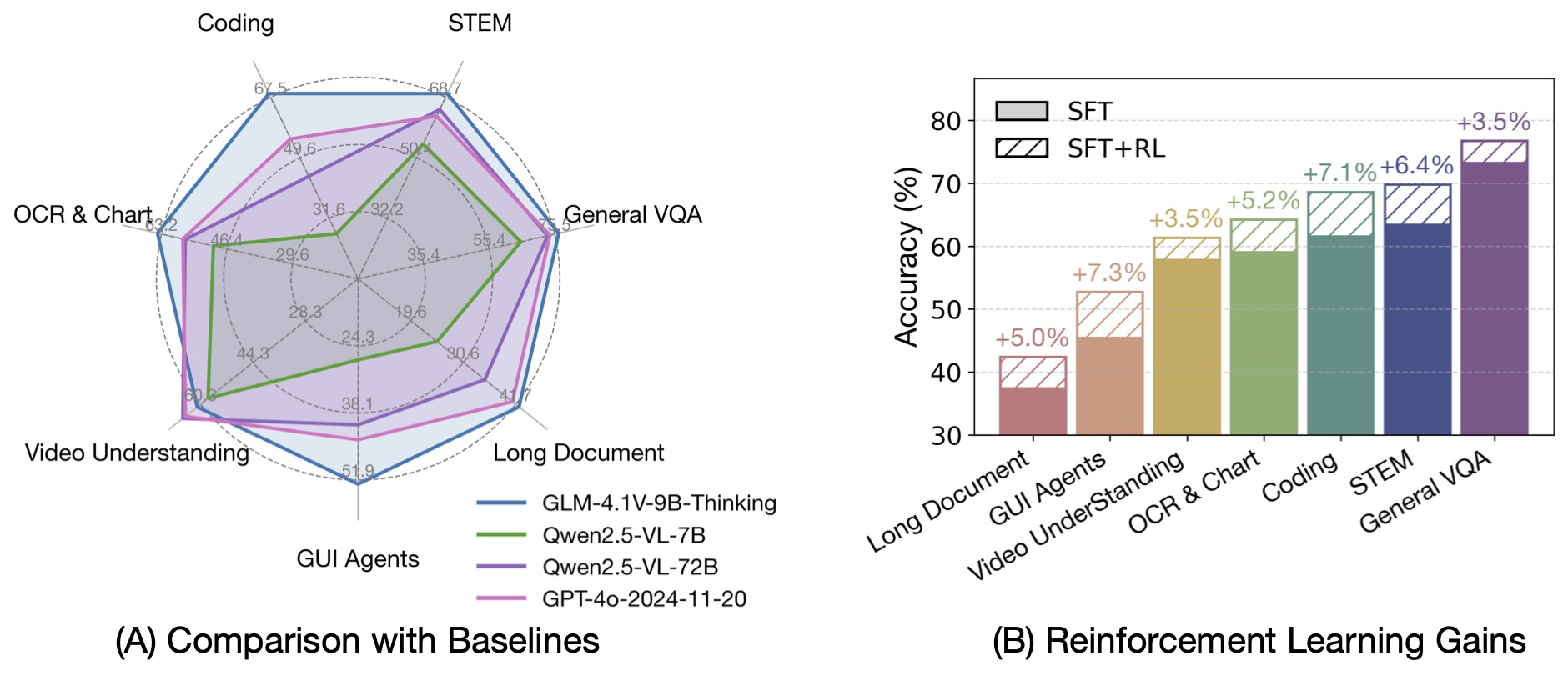

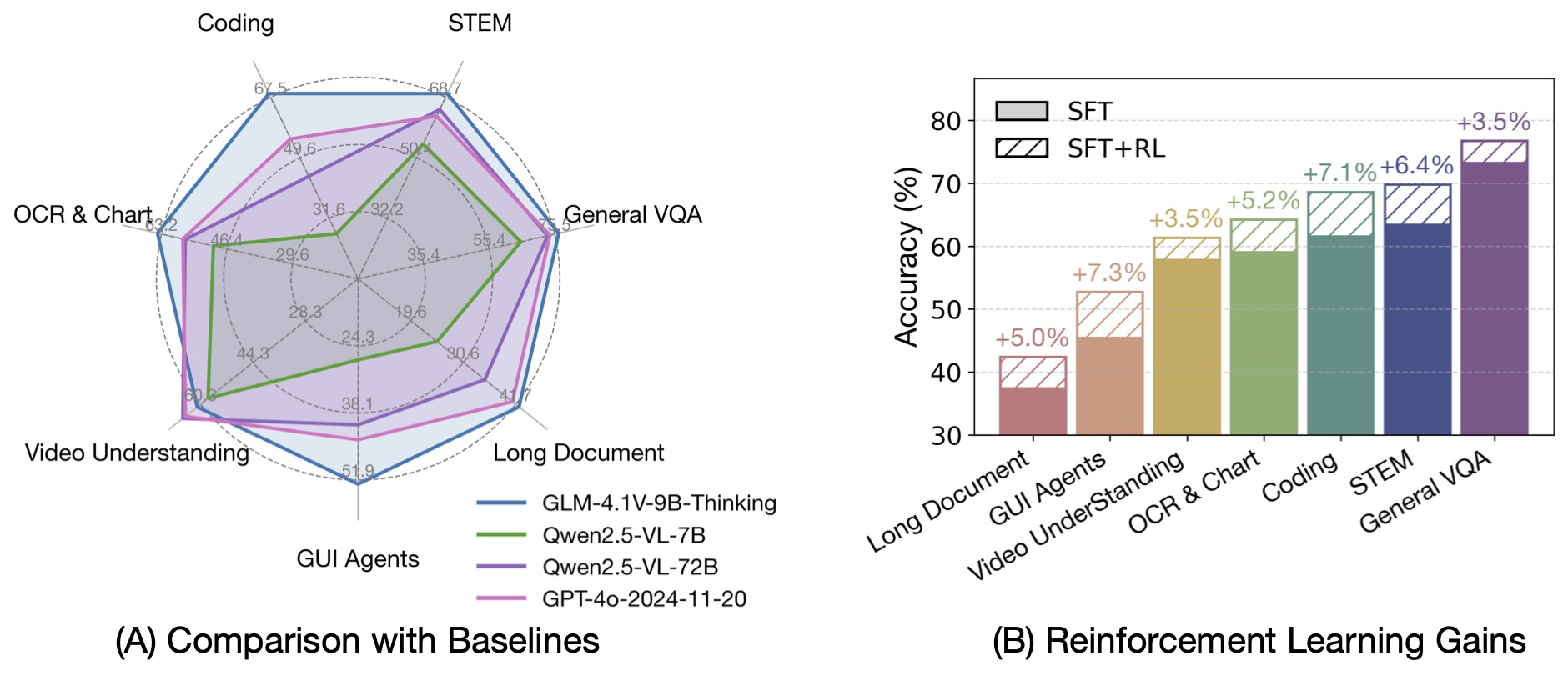

GLM-4-9B-0414 基礎モデルに基づいて、新しいオープンソースの視覚言語モデル GLM-4.1V-9B-Thinking をリリースしました。このモデルは、視覚言語モデルの推論能力の上限を探求することを目的としています。「思考パラダイム」を導入し、強化学習を利用することで、このモデルはその能力を大幅に向上させました。100億パラメータの視覚言語モデルの中で、最も先進的な性能を達成し、18のベンチマークタスクで、720億パラメータのQwen-2.5-VL-72Bと同等またはそれ以上の性能を発揮します。また、視覚言語モデルの能力限界に関するさらなる研究をサポートするために、基礎モデルGLM-4.1V-9B-Baseをオープンソース化しました。

前世代のモデルであるCogVLM2やGLM-4Vシリーズと比較して、GLM-4.1V-Thinking には以下の改善点があります。

- このシリーズで初めて推論に特化したモデルで、数学分野だけでなく、すべてのサブ分野で世界トップレベルの性能を達成しています。

- 64k のコンテキスト長をサポートしています。

- 任意のアスペクト比 を処理でき、最大 4K の画像解像度をサポートしています。

- 中英語のバイリンガル での使用をサポートするオープンソース版が提供されています。

ベンチマークテストの性能

思考連鎖推論パラダイムを導入することで、GLM-4.1V-9B-Thinkingは回答の精度、豊富さ、説明性を大幅に向上させました。これは、従来の非推論型視覚モデルを全面的に上回っています。28のベンチマークタスクのうち、23のタスクで100億パラメータレベルのモデルの中で最高の性能を達成し、18のタスクで720億パラメータのQwen-2.5-VL-72Bを上回っています。

📚 ドキュメント

モデルの概要

視覚言語モデル(VLMs)は、インテリジェントシステムの基盤となるコンポーネントになっています。現実世界のAIタスクがますます複雑になるにつれ、VLMsは基本的なマルチモーダル感知を超え、複雑なタスクにおける推論能力を向上させる必要があります。これには、複雑な問題解決、長文脈理解、マルチモーダルエージェントなどのアプリケーションを実現するために、精度、包括性、知性の向上が含まれます。

GLM-4-9B-0414 基礎モデルに基づいて、新しいオープンソースの視覚言語モデル GLM-4.1V-9B-Thinking をリリースしました。このモデルは、視覚言語モデルの推論能力の上限を探求することを目的としています。「思考パラダイム」を導入し、強化学習を利用することで、このモデルはその能力を大幅に向上させました。100億パラメータの視覚言語モデルの中で、最も先進的な性能を達成し、18のベンチマークタスクで、720億パラメータのQwen-2.5-VL-72Bと同等またはそれ以上の性能を発揮します。また、視覚言語モデルの能力限界に関するさらなる研究をサポートするために、基礎モデルGLM-4.1V-9B-Baseをオープンソース化しました。

📄 ライセンス

このプロジェクトはMITライセンスを採用しています。

| 属性 |

詳細 |

| モデルタイプ |

画像テキストからテキスト |

| 基礎モデル |

THUDM/GLM-4-9B-0414 |

| ライブラリ名 |

transformers |

| タグ |

推論 |

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語