🚀 SigLIP (形状最適化モデル)

SigLIPは、WebLiデータセットで384x384の解像度で事前学習されたモデルです。このモデルは、Zhaiらによる論文 Sigmoid Loss for Language Image Pre-Training で紹介され、このリポジトリ で最初に公開されました。

このモデルはSoViT - 400mアーキテクチャを持ち、Alabdulmohsinらによる Getting ViT in Shape: Scaling Laws for Compute - Optimal Model Design で提示された形状最適化バージョンです。

免責事項: SigLIPを公開したチームはこのモデルのモデルカードを作成していないため、このモデルカードはHugging Faceチームによって作成されています。

🚀 クイックスタート

このセクションでは、SigLIPモデルの概要、用途、使い方、学習手順、評価結果などの基本的な情報を提供します。

✨ 主な機能

モデルの概要

SigLIPは、CLIP のようなマルチモーダルモデルで、損失関数が改良されています。シグモイド損失は画像 - テキストペアのみで動作し、正規化のためにペアワイズ類似度のグローバルなビューを必要としません。これにより、バッチサイズをさらに拡大できると同時に、小さなバッチサイズでも良好な性能を発揮します。

著者の一人によるSigLIPの概要は こちら で確認できます。

想定用途と制限

このモデルは、ゼロショット画像分類や画像 - テキスト検索などのタスクに使用できます。他のバージョンや関心のあるタスクについては モデルハブ を参照してください。

📦 インストール

このREADMEには具体的なインストール手順が記載されていないため、このセクションを省略します。

💻 使用例

基本的な使用法

以下は、このモデルを使用してゼロショット画像分類を行う例です。

from PIL import Image

import requests

from transformers import AutoProcessor, AutoModel

import torch

model = AutoModel.from_pretrained("google/siglip-so400m-patch14-384")

processor = AutoProcessor.from_pretrained("google/siglip-so400m-patch14-384")

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

texts = ["a photo of 2 cats", "a photo of 2 dogs"]

inputs = processor(text=texts, images=image, padding="max_length", return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

logits_per_image = outputs.logits_per_image

probs = torch.sigmoid(logits_per_image)

print(f"{probs[0][0]:.1%} that image 0 is '{texts[0]}'")

高度な使用法

パイプラインAPIを使用することで、ユーザーが複雑さを意識することなく推論を行うことができます。

from transformers import pipeline

from PIL import Image

import requests

image_classifier = pipeline(task="zero-shot-image-classification", model="google/siglip-so400m-patch14-384")

url = 'http://images.cocodataset.org/val2017/000000039769.jpg'

image = Image.open(requests.get(url, stream=True).raw)

outputs = image_classifier(image, candidate_labels=["2 cats", "a plane", "a remote"])

outputs = [{"score": round(output["score"], 4), "label": output["label"] } for output in outputs]

print(outputs)

より多くのコード例については、ドキュメント を参照してください。

📚 ドキュメント

学習手順

学習データ

SigLIPは、WebLIデータセット (Chen et al., 2023) で事前学習されています。

前処理

画像は同じ解像度 (384x384) にリサイズ/リスケールされ、RGBチャネル全体で平均 (0.5, 0.5, 0.5) と標準偏差 (0.5, 0.5, 0.5) で正規化されます。

テキストはトークン化され、同じ長さ (64トークン) にパディングされます。

コンピューティング環境

このモデルは、16個のTPU - v4チップで3日間学習されました。

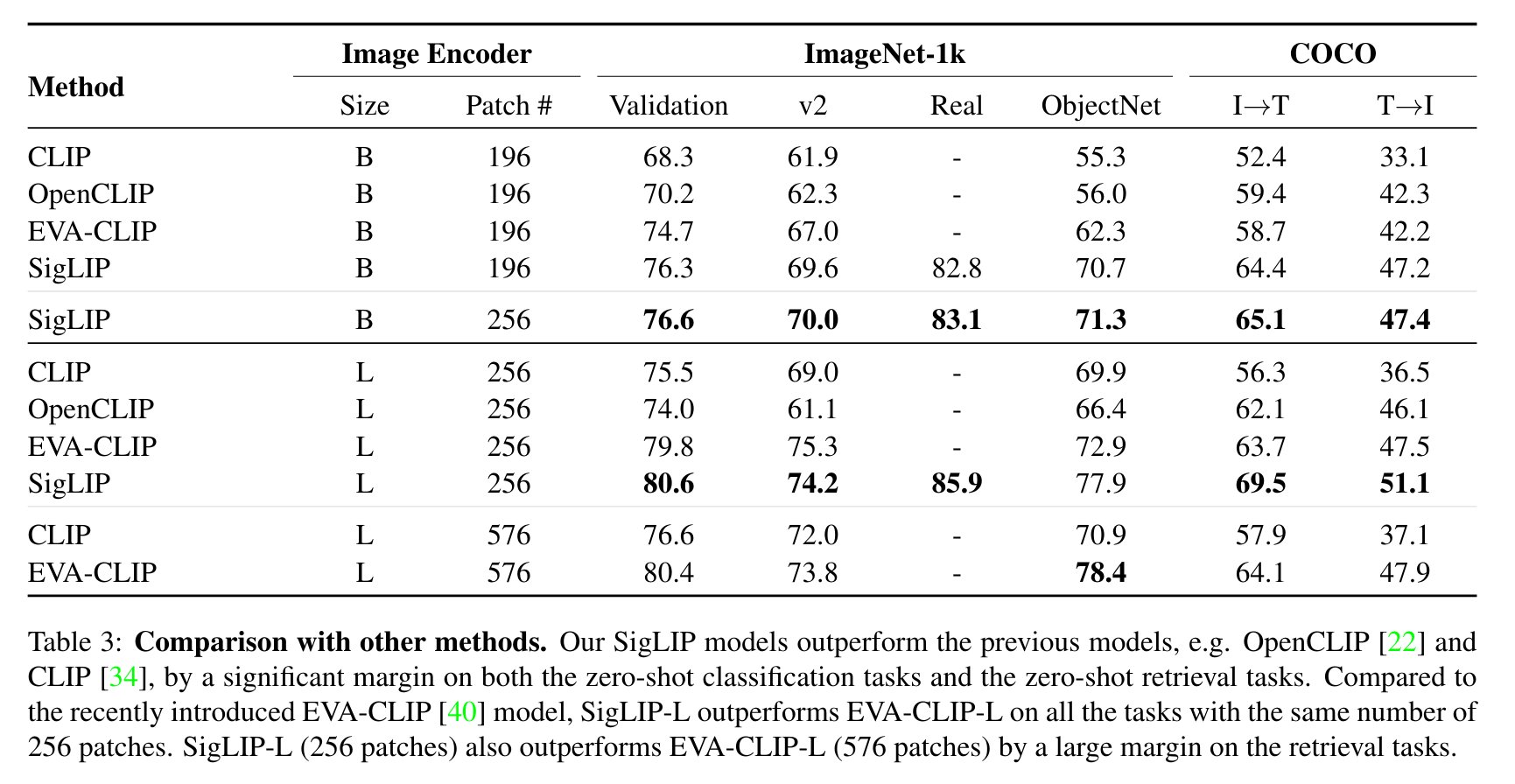

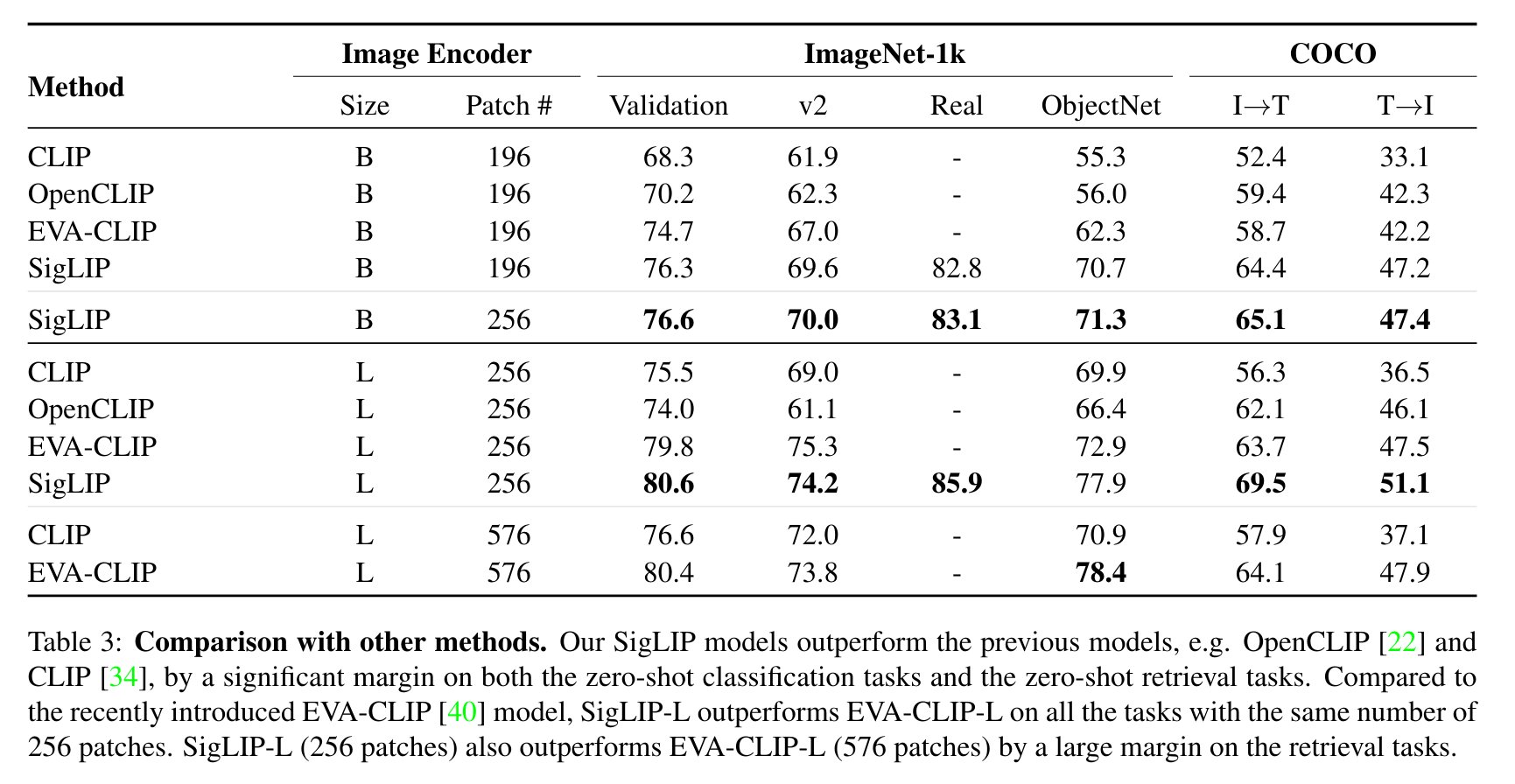

評価結果

CLIPと比較したSigLIPの評価結果を以下に示します(論文から引用)。

BibTeXエントリと引用情報

@misc{zhai2023sigmoid,

title={Sigmoid Loss for Language Image Pre-Training},

author={Xiaohua Zhai and Basil Mustafa and Alexander Kolesnikov and Lucas Beyer},

year={2023},

eprint={2303.15343},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

📄 ライセンス

このモデルはApache - 2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語