🚀 Data2Vec-Vision (ベースサイズのモデル、ImageNet-1kでファインチューニング済み)

BEiTモデルは自己教師付き学習方式で事前学習され、解像度224x224のImageNet-1k(120万枚の画像、1000クラス)でファインチューニングされました。このモデルは、Alexei Baevski、Wei-Ning Hsu、Qiantong Xu、Arun Babu、Jiatao Gu、Michael Auliによる論文 data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language で紹介され、このリポジトリ で最初に公開されました。

免責事項: Facebookチームはこのモデルのモデルカードを作成していないため、このモデルカードはHugging Faceチームによって作成されています。

🚀 クイックスタート

このモデルは、自己教師付き学習方式で事前学習されたBEiTモデルをImageNet-1kでファインチューニングしたもので、画像分類タスクに使用できます。

✨ 主な機能

- 自己教師付き学習による事前学習とImageNet-1kでのファインチューニング

- 画像分類タスクに適用可能

📚 ドキュメント

事前学習方法

詳細については、公式論文 を参照してください。

概要

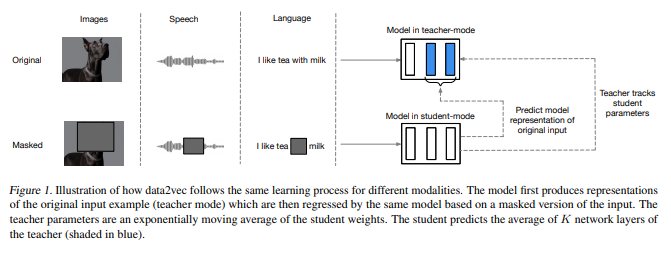

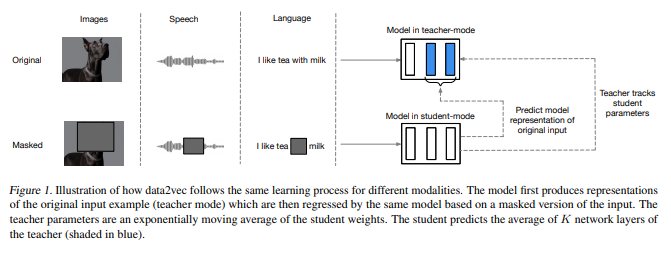

自己教師付き学習の一般的な考え方はモダリティを問わず同じですが、実際のアルゴリズムや目的は大きく異なります。これは、単一のモダリティを念頭に開発されたためです。一般的な自己教師付き学習に近づくために、私たちはdata2vecというフレームワークを提案します。このフレームワークは、音声、自然言語処理、コンピュータビジョンのいずれにも同じ学習方法を使用します。核心的なアイデアは、標準的なTransformerアーキテクチャを使用した自己蒸留設定で、入力のマスクされたビューに基づいて、入力データ全体の潜在表現を予測することです。data2vecは、本質的に局所的な単語、視覚トークン、人間の音声の単位などのモダリティ固有のターゲットを予測するのではなく、入力全体の情報を含む文脈化された潜在表現を予測します。音声認識、画像分類、自然言語理解の主要なベンチマークでの実験は、新しい最先端技術または主要なアプローチに対する競争力のあるパフォーマンスを示しています。

想定される用途と制限

この生モデルは画像分類に使用できます。関心のあるタスクでファインチューニングされたバージョンを探すには、モデルハブ を参照してください。

💻 使用例

基本的な使用法

from transformers import BeitFeatureExtractor, Data2VecVisionForImageClassification

from PIL import Image

import requests

url = 'http://images.cocodataset.org/val2017/000000039769.jpg'

image = Image.open(requests.get(url, stream=True).raw)

feature_extractor = BeitFeatureExtractor.from_pretrained('facebook/data2vec-vision-base-ft1k')

model = Data2VecVisionForImageClassification.from_pretrained('facebook/data2vec-vision-base-ft1k')

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("Predicted class:", model.config.id2label[predicted_class_idx])

現在、特徴抽出器とモデルの両方がPyTorchをサポートしています。

🔧 技術詳細

学習データ

BEiTモデルは、120万枚の画像と1000クラスから構成される ImageNet-1k で事前学習およびファインチューニングされました。

学習手順

前処理

学習/検証中の画像の前処理の正確な詳細は、ここ で確認できます。

画像は同じ解像度(224x224)にリサイズ/リスケールされ、RGBチャネル全体で平均(0.5, 0.5, 0.5)、標準偏差(0.5, 0.5, 0.5)で正規化されます。

事前学習

すべての事前学習関連のハイパーパラメータについては、元の論文 と 元のコードベース を参照してください。

評価結果

いくつかの画像分類ベンチマークでの評価結果については、元の論文の表1を参照してください。ファインチューニングに関しては、より高い解像度で最良の結果が得られます。もちろん、モデルサイズを大きくするとパフォーマンスが向上します。

私たちはこのモデルを ImageNet1K で評価し、トップ1精度 = 83.97 を得ました。一方、元の論文ではトップ1精度 = 84.2と報告されています。

評価プロセスを再現したい場合は、このColabノートブック を使用できます。

BibTeXエントリと引用情報

@misc{https://doi.org/10.48550/arxiv.2202.03555,

doi = {10.48550/ARXIV.2202.03555},

url = {https://arxiv.org/abs/2202.03555},

author = {Baevski, Alexei and Hsu, Wei-Ning and Xu, Qiantong and Babu, Arun and Gu, Jiatao and Auli, Michael},

keywords = {Machine Learning (cs.LG), FOS: Computer and information sciences, FOS: Computer and information sciences},

title = {data2vec: A General Framework for Self-supervised Learning in Speech, Vision and Language},

publisher = {arXiv},

year = {2022},

copyright = {arXiv.org perpetual, non-exclusive license}

}

📄 ライセンス

このモデルはApache-2.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語