Swinv2 Base Patch4 Window12to16 192to256 22kto1k Ft

Swin Transformer v2は、階層的特徴マップと局所ウィンドウ自己注意機構により効率的な画像分類を実現する視覚Transformerモデルです。

ダウンロード数 459

リリース時間 : 6/16/2022

モデル概要

このモデルはImageNet-21kで事前学習され、ImageNet-1kでファインチューニングされており、画像分類タスクに適しています。残差後正規化、コサイン注意、対数間隔連続位置バイアスなどの改良技術を採用しています。

モデル特徴

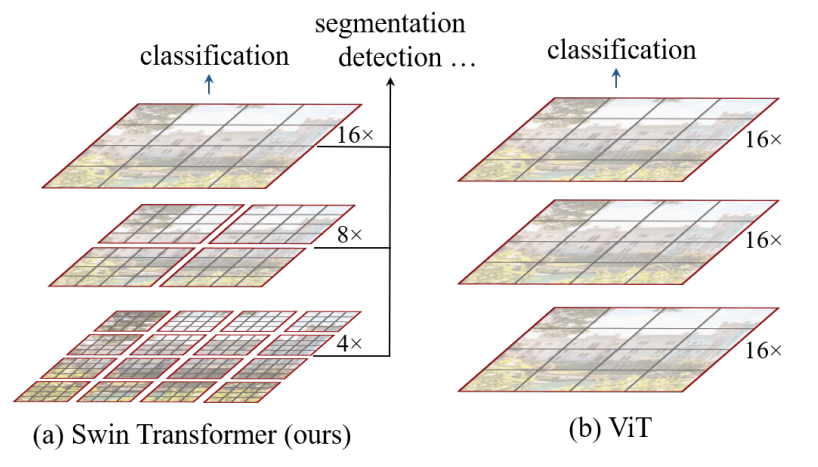

階層的特徴マップ

より深い層で画像パッチを統合して階層的特徴マップを構築し、画像分類や密な認識タスクに適しています。

局所ウィンドウ自己注意

局所ウィンドウ内でのみ自己注意を計算し、計算複雑度が入力画像サイズに対して線形関係にあります。

訓練安定性の向上

残差後正規化とコサイン注意を組み合わせて訓練安定性を向上させます。

高解像度転移能力

対数間隔連続位置バイアス法を採用し、低解像度事前学習モデルを高解像度入力タスクに効果的に転移させます。

モデル能力

画像分類

視覚的特徴抽出

使用事例

コンピュータビジョン

ImageNet画像分類

画像を1000のImageNetカテゴリのいずれかに分類します。

おすすめAIモデル

Llama 3 Typhoon V1.5x 8b Instruct

タイ語専用に設計された80億パラメータの命令モデルで、GPT-3.5-turboに匹敵する性能を持ち、アプリケーションシナリオ、検索拡張生成、制限付き生成、推論タスクを最適化

大規模言語モデル Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-TinyはSODAデータセットでトレーニングされた超小型対話モデルで、エッジデバイス推論向けに設計されており、体積はCosmo-3Bモデルの約2%です。

対話システム Transformers 英語

Transformers 英語

Transformers 英語

Transformers 英語C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

RoBERTaアーキテクチャに基づく中国語抽出型QAモデルで、与えられたテキストから回答を抽出するタスクに適しています。

質問応答システム 中国語

R

uer

2,694

98