🚀 NAT (small variant)

NAT-Smallは、解像度224x224のImageNet-1Kで学習されたモデルです。

このモデルは、Hassaniらによる論文 Neighborhood Attention Transformer で紹介され、このリポジトリ で最初に公開されました。

🚀 クイックスタート

NAT-Smallは画像分類に使用できます。興味のあるタスクに関するファインチューニング済みバージョンを モデルハブ で探すことができます。

✨ 主な機能

- 画像分類タスクに適用可能です。

- Neighborhood Attention (NA) をベースとした階層型ビジョントランスフォーマーです。

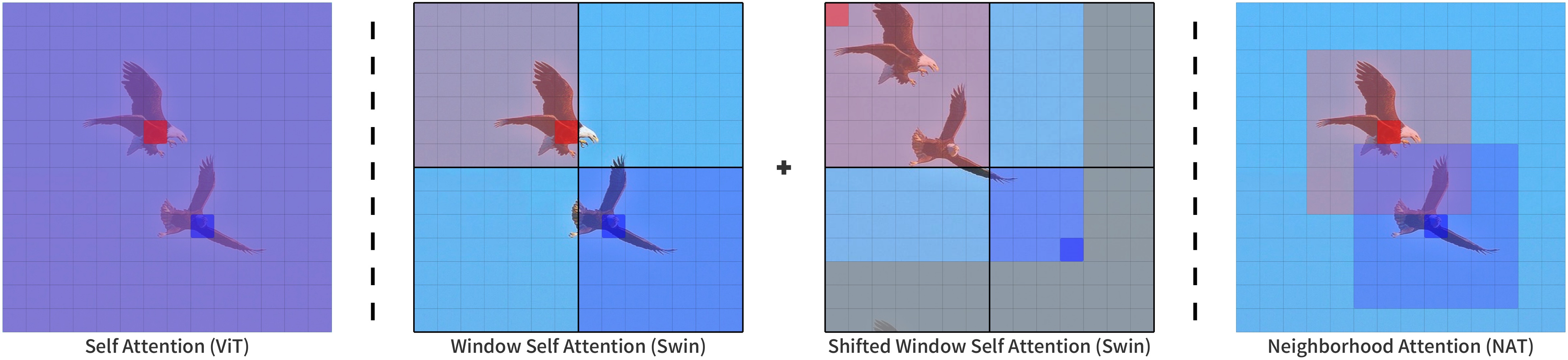

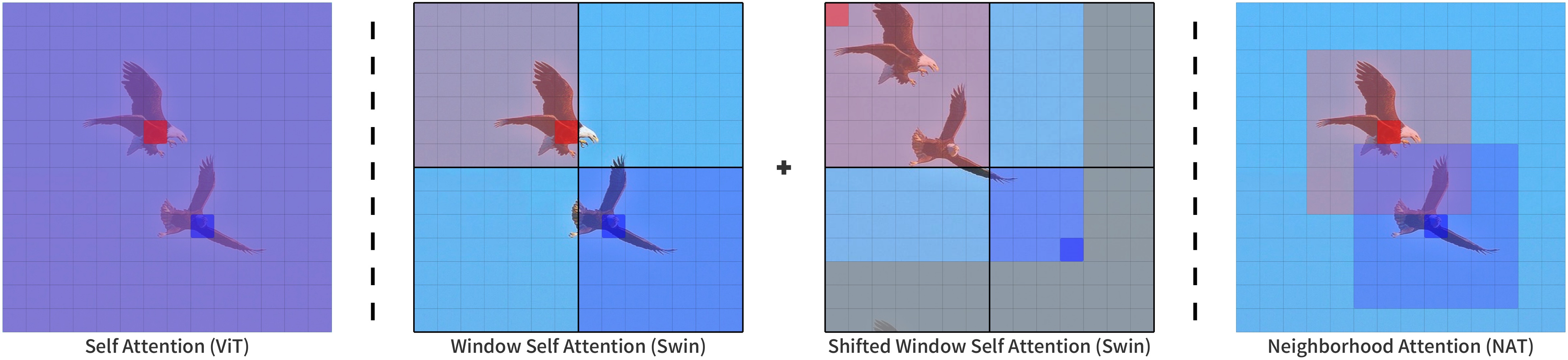

- NAは、各トークンの受容野が最も近い隣接ピクセルに制限された制限的な自己注意パターンです。

- NAはスライディングウィンドウ型の注意パターンであり、非常に柔軟で並進等変性を維持します。

📚 ドキュメント

モデルの説明

NATは、Neighborhood Attention (NA) をベースとした階層型ビジョントランスフォーマーです。Neighborhood Attentionは、各トークンの受容野が最も近い隣接ピクセルに制限された制限的な自己注意パターンです。NAはスライディングウィンドウ型の注意パターンであり、非常に柔軟で並進等変性を維持します。

NAは、その拡張である NATTEN を通じてPyTorchで実装されています。

出典

想定される用途と制限

このモデルは画像分類に使用できます。興味のあるタスクに関するファインチューニング済みバージョンを モデルハブ で探すことができます。

例

以下は、このモデルを使用してCOCO 2017データセットの画像を1,000のImageNetクラスのいずれかに分類する方法です。

from transformers import AutoImageProcessor, NatForImageClassification

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

feature_extractor = AutoImageProcessor.from_pretrained("shi-labs/nat-small-in1k-224")

model = NatForImageClassification.from_pretrained("shi-labs/nat-small-in1k-224")

inputs = feature_extractor(images=image, return_tensors="pt")

outputs = model(**inputs)

logits = outputs.logits

predicted_class_idx = logits.argmax(-1).item()

print("予測されたクラス:", model.config.id2label[predicted_class_idx])

詳細な例については、ドキュメント を参照してください。

要件

このモデルは、transformers の他に NATTEN パッケージが必要です。

Linuxユーザーは、shi-labs.com/natten を参照して、事前コンパイル済みのバイナリを使用したインストール手順を確認できます(正しいホイールURLを取得するためにtorchビルドを選択してください)。

または、pip install natten を使用してデバイス上でコンパイルすることもできますが、これには数分かかる場合があります。Macユーザーは後者のオプションのみ利用可能です(事前コンパイル済みのバイナリはありません)。

詳細については、NATTENのGitHub を参照してください。

BibTeXエントリと引用情報

@article{hassani2022neighborhood,

title = {Neighborhood Attention Transformer},

author = {Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi},

year = 2022,

url = {https://arxiv.org/abs/2204.07143},

eprint = {2204.07143},

archiveprefix = {arXiv},

primaryclass = {cs.CV}

}

📄 ライセンス

このモデルはMITライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語