🚀 Mask2Former

Mask2Formerは、ADE20kのセマンティックセグメンテーションで学習されたモデルです(tinyサイズ版、Swinバックボーン)。このモデルは論文 Masked-attention Mask Transformer for Universal Image Segmentation で紹介され、このリポジトリ で最初に公開されました。

なお、Mask2Formerを公開したチームはこのモデルのモデルカードを作成していないため、このモデルカードはHugging Faceチームによって作成されています。

✨ 主な機能

モデルの説明

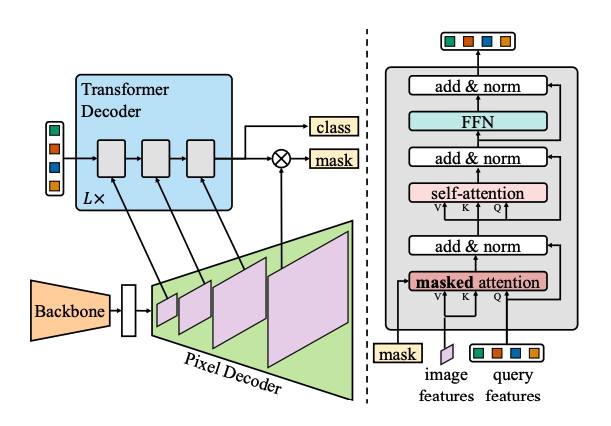

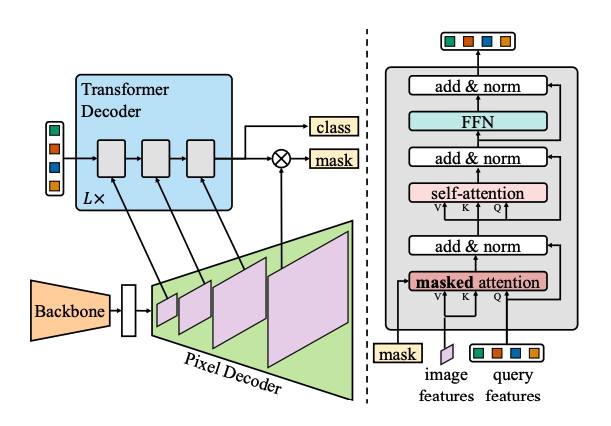

Mask2Formerは、同じパラダイムでインスタンス、セマンティック、パノプティックセグメンテーションを扱います。具体的には、一連のマスクと対応するラベルを予測することで、すべての3つのタスクをインスタンスセグメンテーションとして扱います。Mask2Formerは、以前のSOTAである MaskFormer を性能と効率の両面で上回っています。具体的な改善点は以下の通りです。

- ピクセルデコーダをより高度なマルチスケール変形可能アテンションTransformerに置き換える。

- マスクされたアテンションを持つTransformerデコーダを採用し、追加の計算を導入することなく性能を向上させる。

- 損失をマスク全体ではなくサブサンプリングされたポイントで計算することで、トレーニング効率を向上させる。

想定される用途と制限

この特定のチェックポイントはパノプティックセグメンテーションに使用できます。あなたが興味のあるタスクで微調整された他のバージョンを探すには、モデルハブ を参照してください。

📦 インストール

このREADMEにはインストール手順が記載されていないため、このセクションは省略されます。

💻 使用例

基本的な使用法

このモデルの使用方法は以下の通りです。

import requests

import torch

from PIL import Image

from transformers import AutoImageProcessor, Mask2FormerForUniversalSegmentation

processor = AutoImageProcessor.from_pretrained("facebook/mask2former-swin-tiny-ade-semantic")

model = Mask2FormerForUniversalSegmentation.from_pretrained("facebook/mask2former-swin-tiny-ade-semantic")

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

inputs = processor(images=image, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

class_queries_logits = outputs.class_queries_logits

masks_queries_logits = outputs.masks_queries_logits

predicted_semantic_map = processor.post_process_semantic_segmentation(outputs, target_sizes=[image.size[::-1]])[0]

より多くのコード例については、ドキュメント を参照してください。

📚 ドキュメント

このセクションでは、モデルに関する詳細な情報を提供します。

モデルの属性

| 属性 |

详情 |

| モデルタイプ |

Mask2Formerモデル(Swinバックボーン、tinyサイズ版) |

| 学習データ |

ADE20kセマンティックセグメンテーションデータセット |

ライセンス

このモデルは、他のライセンスの下で提供されています。具体的なライセンス情報は、元のリポジトリを参照してください。

デモウィジェット

以下のデモウィジェットを使用して、モデルの出力を確認できます。

引用

このモデルは、以下の論文で紹介されています。

BibTeX形式での引用は以下の通りです。

@article{DBLP:journals/corr/abs-2112-01527,

author = {Bowen Cheng and

Ishan Misra and

Alexander G. Schwing and

Alexander Kirillov and

Rohit Girdhar},

title = {Masked-attention Mask Transformer for Universal Image Segmentation},

journal = {CoRR},

volume = {abs/2112.01527},

year = {2021},

url = {https://arxiv.org/abs/2112.01527},

eprinttype = {arXiv},

eprint = {2112.01527},

timestamp = {Tue, 07 Dec 2021 15:36:22 +0100},

biburl = {https://dblp.org/rec/journals/corr/abs-2112-01527.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

@article{DBLP:journals/corr/abs-2107-06278,

author = {Bowen Cheng and

Ishan Misra and

Alexander G. Schwing and

Alexander Kirillov and

Rohit Girdhar},

title = {MaskFormer: Per-Pixel Classification is Not All You Need for Semantic

and Panoptic Segmentation},

journal = {CoRR},

volume = {abs/2107.06278},

year = {2021},

url = {https://arxiv.org/abs/2107.06278},

eprinttype = {arXiv},

eprint = {2107.06278},

timestamp = {Wed, 21 Jul 2021 15:55:02 +0200},

biburl = {https://dblp.org/rec/journals/corr/abs-2107-06278.bib},

bibsource = {dblp computer science bibliography, https://dblp.org}

}

以上です。もし他に質問や必要な情報があれば、お知らせください。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語