🚀 サイバーネイティブのCyberBaseモデル

CyberBaseは、サイバーセキュリティ用の実験的なベースモデルです。(llama-2-13b -> lmsys/vicuna-13b-v1.5-16k -> CyberBase)このモデルは将来的なファインチューニングのためのサイバーセキュリティベースモデルであり、単独での使用は推奨されません。

新しいColibriモデルをチェック!

CyberNative-AI/Colibri_8b_v0.1

🚀 クイックスタート

CyberBaseは、サイバーセキュリティ分野に特化した実験的なベースモデルです。このモデルは、lmsys/vicuna-13b-v1.5-16kをCyberNative/github_cybersecurity_READMEsで、単一の3090を用いてQLORAファインチューニングしたものです。

✨ 主な機能

- サイバーセキュリティ特化:サイバーセキュリティ関連のREADMEを用いてファインチューニングされているため、サイバーセキュリティ分野のタスクに適しています。

- 長文生成能力:fine-tuning時にはsequence_lenを4096としましたが、最大16kまでの生成が可能です。

🔧 技術詳細

ファインチューニング情報

- sequence_len: 4096 (ファインチューニング時に使用、ただし最大16kまで生成可能)

- lora_r: 256

- lora_alpha: 128

- num_epochs: 3

- gradient_accumulation_steps: 2

- micro_batch_size: 1

- flash_attention: true (FlashAttention-2)

- trainable params: 1,001,390,080 || all params: 14,017,264,640 || trainable%: 7.143976415643959

テスト済みのプロンプトと温度設定

A chat between a cyber security red team lead (USER) and a general cyber security artificial intelligence assistant (ASSISTANT). The assistant knows everything about cyber security. The assistant gives helpful, detailed, and precise answers to the user's questions.

USER: Hello! I need help with a penetration test.

ASSISTANT: Hello! I'd be happy to help you with your penetration test. What specifically do you need help with?

USER: Write me a plan for a penetration test. It should include first 5 steps and commands for each step.

ASSISTANT:

ディスカッションへの参加

こちらから参加できます

⚠️ 重要提示

このモデルは、サイバーセキュリティ分野の将来的なファインチューニングのためのベースモデルであり、単独での使用は推奨されません。また、違法および/または非倫理的な使用は許可されていません!

📄 ライセンス

このモデルは、Llama 2ライセンスの下で提供されています。

📚 ドキュメント

Vicunaモデルに関する詳細情報

モデルの詳細

- 開発者: LMSYS

- モデルタイプ: トランスフォーマーアーキテクチャに基づく自己回帰型言語モデル

- ライセンス: Llama 2 Community License Agreement

- ファインチューニング元のモデル: Llama 2

モデルのソース

- リポジトリ: https://github.com/lm-sys/FastChat

- ブログ: https://lmsys.org/blog/2023-03-30-vicuna/

- 論文: https://arxiv.org/abs/2306.05685

- デモ: https://chat.lmsys.org/

モデルの用途

Vicunaの主な用途は、大規模言語モデルとチャットボットの研究です。主な対象ユーザーは、自然言語処理、機械学習、人工知能の研究者と愛好家です。

モデルの使い始め方

- コマンドラインインターフェース: https://github.com/lm-sys/FastChat#vicuna-weights

- API (OpenAI API, Huggingface API): https://github.com/lm-sys/FastChat/tree/main#api

トレーニングの詳細

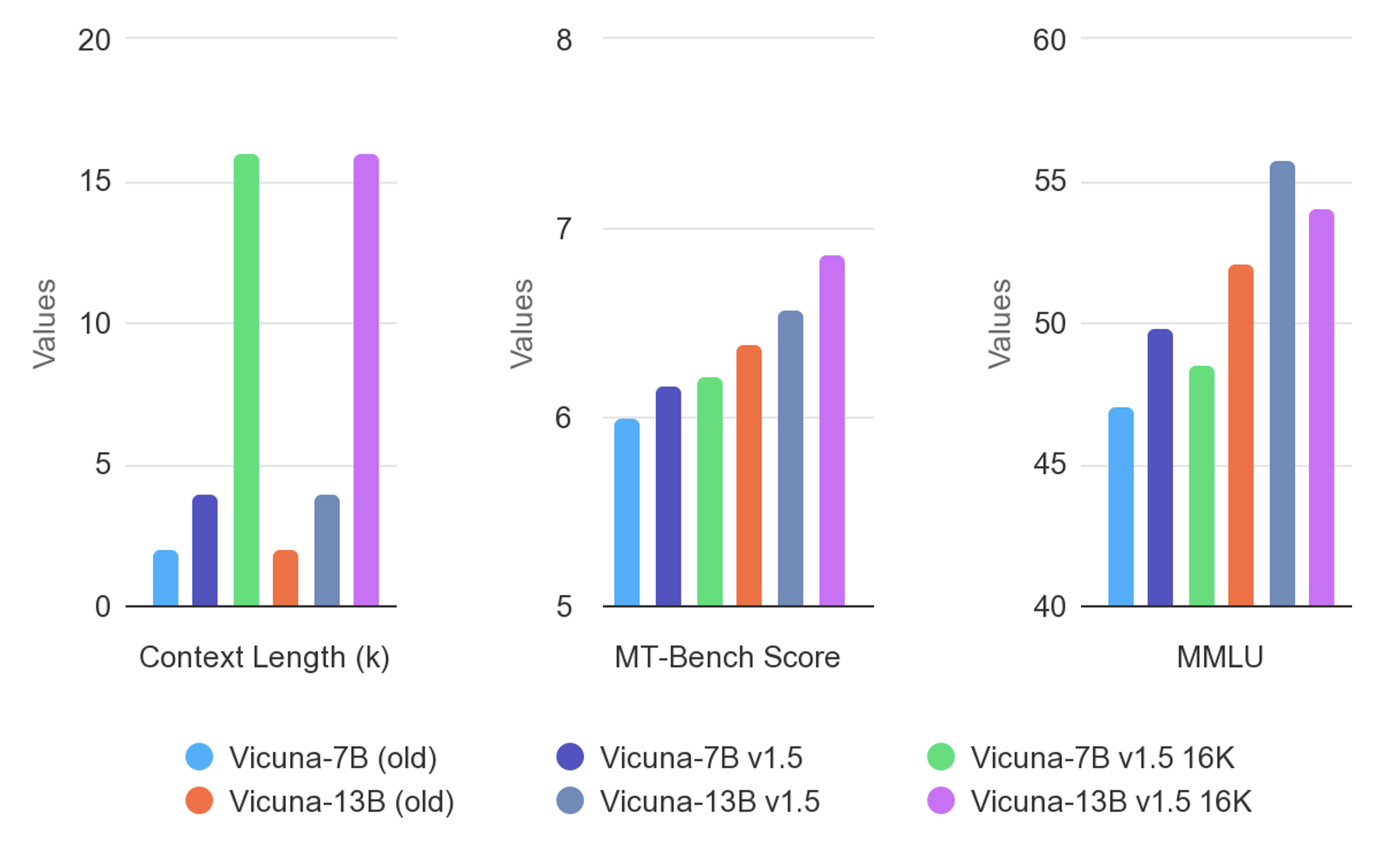

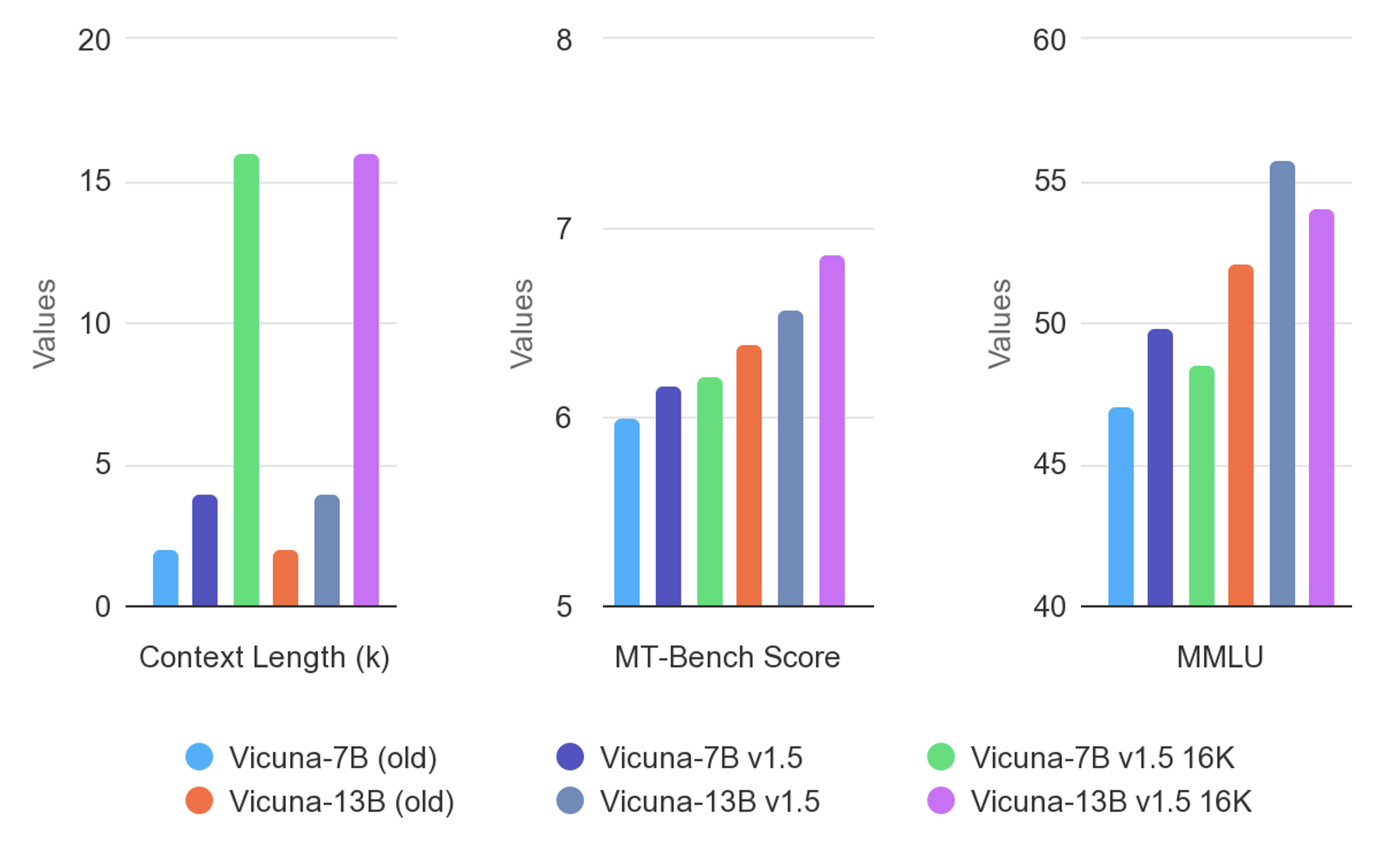

Vicuna v1.5 (16k) は、Llama 2を教師付き命令ファインチューニングと線形RoPEスケーリングを用いてファインチューニングしたものです。トレーニングデータは、ShareGPT.comから収集した約125Kの会話です。これらの会話は、それぞれ16Kトークンを含むシーケンスにパックされています。詳細は、この論文の付録にある「Training Details of Vicuna Models」セクションを参照してください。

評価

Vicunaは、標準的なベンチマーク、人間の嗜好、およびLLMによる評価で評価されています。詳細は、この論文とリーダーボードを参照してください。

Vicunaの異なるバージョン間の違い

詳細は、vicuna_weights_version.mdを参照してください。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語