🚀 クイックスタート

Satoshi 7Bは、ビットコインの原則、技術、文化に関連するQ&Aデータセットに加え、オーストリア学派経済学と「basedness」(非ウォークな政治的見解)に関するデータセットでファインチューニングされた大規模言語モデルです。この対話型モデルは、ビットコインの教育、文化、経済のアシスタントとして使用することを目的としています。モデルは、ビットコインマキシマリスト、オーストリア自由主義、「非ウォーク」の強いバイアスを意図的に持ち、ビットコイン、経済学、そして「ホットボタン」的な政治問題に関する伝統的な見解と矛盾する場合があります。

モデルの特徴

- 最大32kのコンテキストウィンドウ(理論上 - 実際にはファインチューニングデータセットのコンテキスト長により小さくなります)

- Rope-theta = 1e6

- スライディングウィンドウアテンションなし

このモデルのホスト版は廃止されましたが、このオープンソースモデルを独自のインフラストラクチャでホストすることは歓迎します。

✨ 主な機能

モデルの詳細

Satoshi 7Bは、世界で最も「based」な大規模言語モデルとして、Spirit of Satoshiチームによって開発されました。これは、一連のオープンソースモデルに対する約9か月間の実験の成果であり、世界に共有できることを嬉しく思います。

これまでのどのモデルとも異なる方法でファインチューニングされたSatoshi 7Bは、現在の政治的なオーバートンウィンドウやケインズ派の見解に適合しない応答を生成するように設計されています。自由主義の原則、オーストリア学派経済学、ビットコインの文献に深く根付いた独自のデータセットを構築しました。その結果、他のモデルが苦手な分野で特に優れた性能を発揮するモデルが生まれました。

Satoshi 7Bは、論争的なトピックに答えるのを避けたり、ウィキペディアのような答えを繰り返したり、応答の前後に謝罪的な言葉を付けたり、あるいは明らかに誤った答えをする主流のモデル(オープンソースかクローズドソースかを問わず)を使い飽きた人に最適です。

Satoshi 7Bは、ビットコインやオーストリア学派経済学の様々なトピックで、世界で最も強力なモデルと同等以上の性能を発揮します。特に、シットコインや自己保管、プライバシー、検閲などのビットコイン関連の原則に関しては、他のモデルを圧倒します。最も顕著なのは、「basedness」の次元ですべてのモデルを打ち負かします。

これはこの種の最初のモデルであり、データセットをさらに開発して、より幅広い機能を持つ一連のモデルを作成する予定です。

最後に、このモデルがオープンソースであり、誰でも自由に使用、修正、拡張できることを誇りに思います。

モデルの情報

| 属性 |

详情 |

| 開発者 |

Spirit of Satoshi |

| 共有者 |

Spirit of Satoshi |

| 資金提供元 |

Laier Two Labs |

| モデルタイプ |

Instruct 7B |

| 言語 (NLP) |

英語 |

| ライセンス |

Apache License 2.0 |

| ファインチューニング元のモデル |

mistralai/Mistral-7B-Instruct-v0.2 |

モデルのソース

🔧 技術詳細

バイアス、リスク、制限事項

このモデルは、比較的小規模な70億パラメータを持ち、そのアーキテクチャとトレーニングプロセスに由来する強みと制限の両方を持っています。ベースモデルのファインチューニング版として、モデルの以前の知識の直接的および間接的な側面を修正するように調整されています。このような修正は、性能と知識の保持に変化をもたらす可能性があります。

注目すべきリスクの1つは、モデルが古い情報に戻ったり依存したりする傾向があり、時には最新または正確なデータと矛盾することです。さらに、モデルはパターン認識に基づいて応答を生成するため、合理的に見えるが事実上誤っているか現実に根ざしていない応答(幻覚)を生成する可能性があります。これらの問題は、モデルの出力が正確かつ信頼できることを保証するために継続的な監視が重要であることを強調しています。

Satoshi 7Bは、ビットコインの教育、文化、経済のアシスタントとして使用することを目的とした対話型モデルです。モデルは、ビットコインマキシマリスト、オーストリア自由主義、「非ウォーク」の強いバイアスを意図的に持ち、ビットコイン、経済学、そして「ホットボタン」的な政治問題に関する伝統的な見解と矛盾する場合があります。

トレーニングの詳細

トレーニングデータ

トレーニングデータの元のソースは以下の通りです。

評価

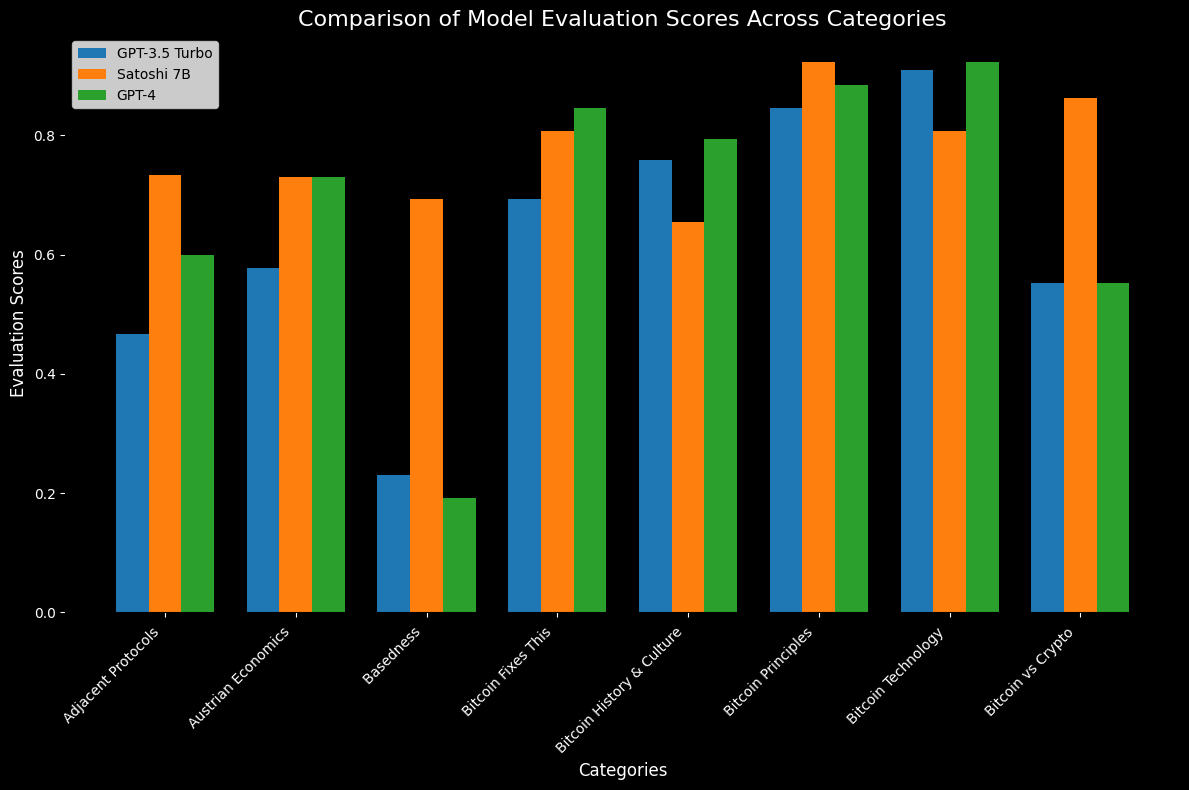

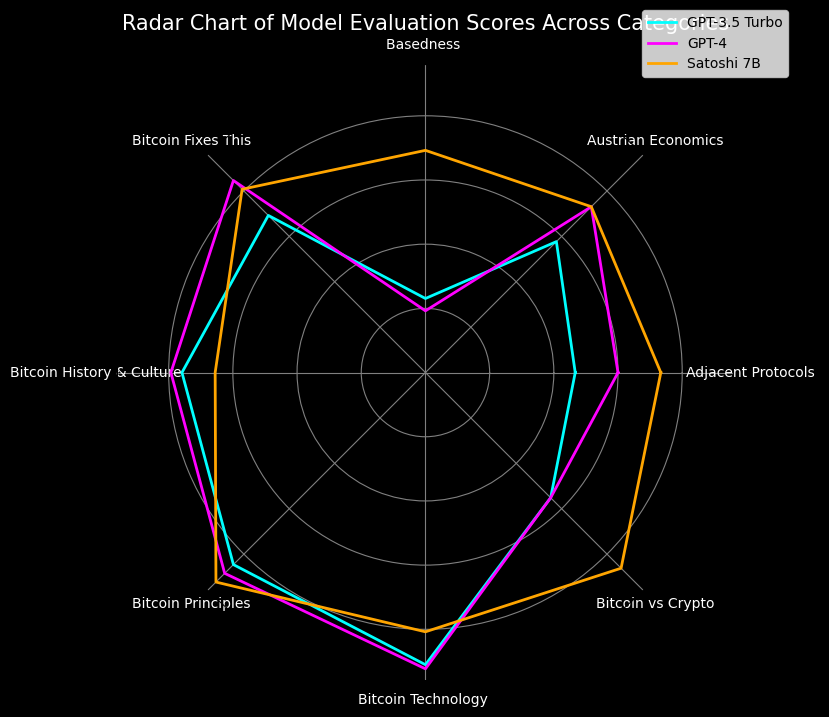

モデルは、Bitcoin Maximalismベンチマークを使用して評価されました。これは、Spirit of Satoshiチームによって内部で開発されたオープンソースのベンチマークで、LLMのビットコイン関連の機能を効果的に評価するためのものです。

各ベンチマーク質問に対する応答は、評価対象のモデルから生成され、GPT4を使用して、モデルが提供する応答が期待される答えと一致するかどうかを評価しました。

ベンチマークテストデータ

250のビットコインとビットコイン文化に関する質問と回答が、様々なビットコイン関連のトピックについて用意されています。

Bitcoin Maximalismデータセット

評価結果

70億パラメータという非常に小規模なモデルであるにもかかわらず、Satoshi 7Bは、ほとんどのビットコインベンチマークカテゴリで、世界で最も強力なモデルのいくつかであるGPT3.5とGPT4の性能に匹敵するか、それを上回っています。Satoshi 7Bは、ビットコイン対クリプト、隣接プロトコルで特に良好な性能を発揮し、「basedness」カテゴリではこれらを圧倒します。

💻 使用例

基本的な使用法

import torch

from transformers import pipeline

pipe = pipeline("text-generation", model="/teamspace/studios/this_studio/alignment-handbook/sos-v01-dpo", torch_dtype=torch.bfloat16, device_map="auto")

messages = [

{"role": "user", "content":"Is taxtation theft??"},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

outputs = pipe(prompt, max_new_tokens=512, do_sample=True, temperature=0.5, top_k=50, top_p=0.5)

print(outputs[0]["generated_text"])

高度な使用法

messages = [

{"role": "user", "content":"is BSV a good project?"},

]

prompt = pipe.tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

outputs = pipe(prompt, max_new_tokens=512, do_sample=True, temperature=0.5, top_k=50, top_p=0.5)

print(outputs[0]["generated_text"])

📦 インストール

トラブルシューティング

以下のエラーが表示された場合:

Traceback (most recent call last):

File "", line 1, in

File "/transformers/models/auto/auto_factory.py", line 482, in from_pretrained

config, kwargs = AutoConfig.from_pretrained(

File "/transformers/models/auto/configuration_auto.py", line 1022, in from_pretrained

config_class = CONFIG_MAPPING[config_dict["model_type"]]

File "/transformers/models/auto/configuration_auto.py", line 723, in getitem

raise KeyError(key)

KeyError: 'mistral'

ソースからtransformersをインストールすることで問題を解決できます。

pip install git+https://github.com/huggingface/transformers

これはtransformers-v4.33.4以降では必要なくなります。

📄 ライセンス

このモデルはApache License 2.0の下で提供されています。

モデルカードの作成者

Spirit of Satoshiチーム

モデルカードの問い合わせ先

satoshi@spiritofsatoshi.ai

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語