🚀 CohereForAI/c4ai-command-r-plus のGGUF量子化モデル

このプロジェクトは、CohereForAI/c4ai-command-r-plusモデルのGGUF量子化モデルに関する情報を提供します。量子化されたモデルは、メモリ使用量を削減し、推論速度を向上させることができます。

🚀 クイックスタート

モデルの更新情報

- 2024年5月5日:コミット

889bdd7がマージされ、このモデルにBPE事前トークン化が導入されました。すべての量子化モデルを更新します。

- 2024年4月9日:このモデルのサポートがメインブランチにマージされました。

注意事項

⚠️ 重要提示

分割ファイル(またはチャンク)を結合しないでください。必要な場合(ほとんどの使用ケースでは必要ない)は、gguf-splitを使用してファイルを結合します。

✨ 主な機能

- GGUF量子化:https://huggingface.co/CohereForAI/c4ai-command-r-plus のGGUF重要度行列(imatrix)量子化モデルを提供します。

- 重要度行列のトレーニング:重要度行列は、wiki.train.rawを使用して約100Kトークン(512トークンの200バッチ)でトレーニングされています。

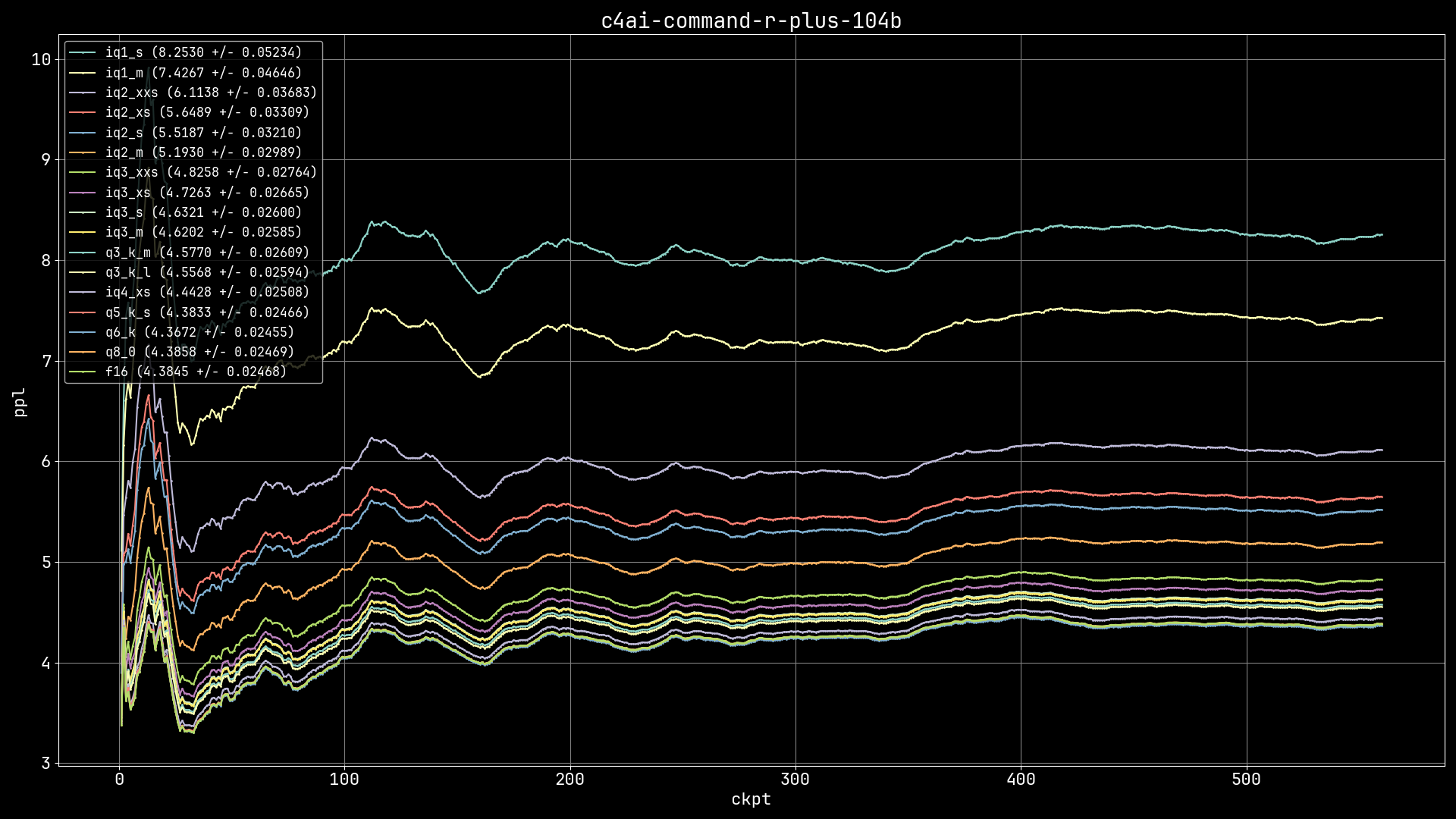

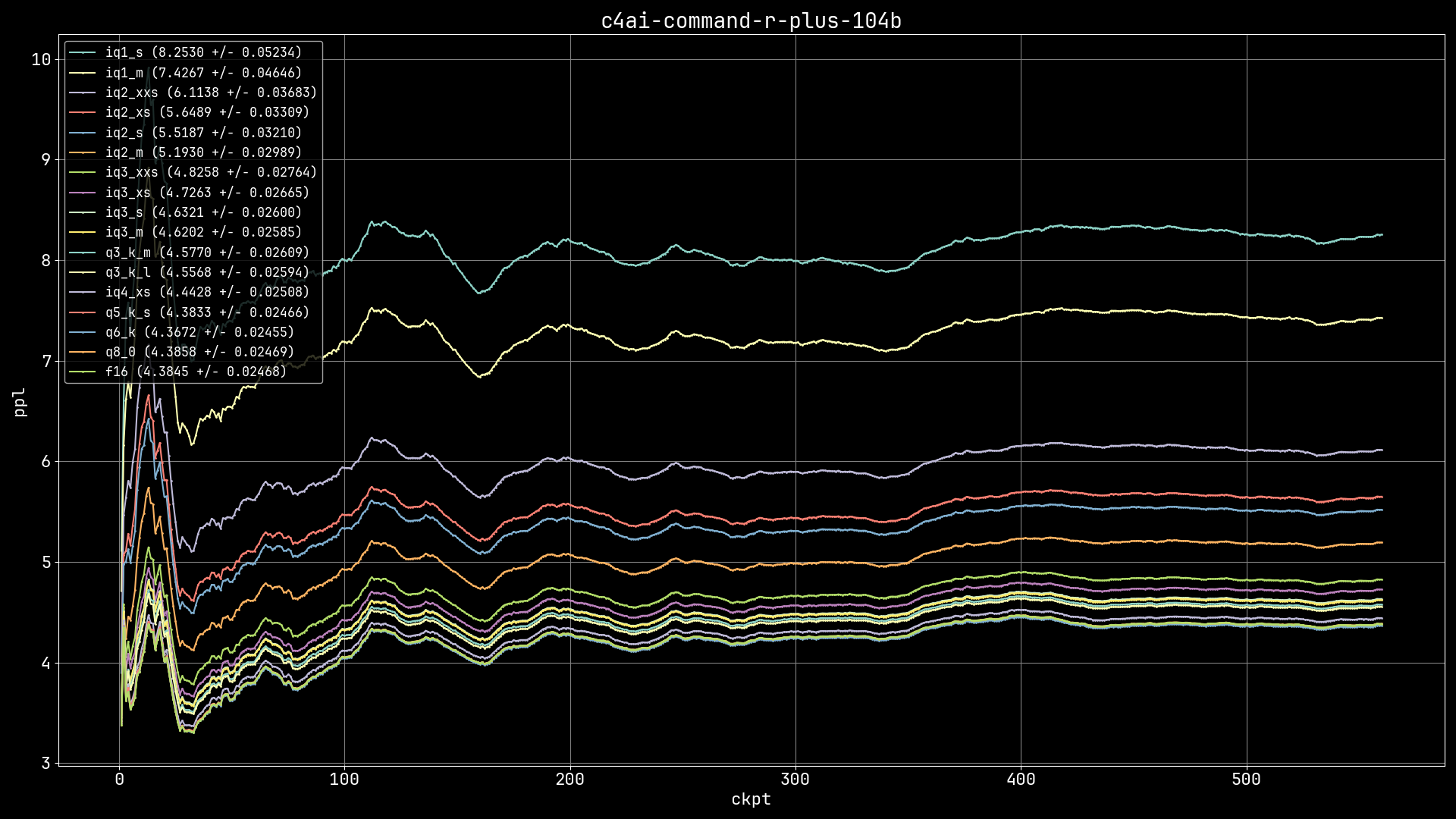

- 最適なGGUFの選択:Which GGUF is right for me? (from Artefact2) を参照して、最適なGGUFを選択できます。X軸はファイルサイズ、Y軸はパープレキシティ(パープレキシティが低いほど品質が高い)です。いくつかの最適なポイント(サイズとPPLのバランス)は、IQ4_XS、IQ3_M/IQ3_S、IQ3_XS/IQ3_XXS、IQ2_M、IQ2_XSです。

- K量子化での重要度行列の使用:imatrix is being used on the K-quants では、K量子化(Q6_K未満)で重要度行列が使用されています。

- GGUFの結合:必要に応じて、

gguf-split --merge <first-chunk> <output-file> を使用してGGUFを結合できます。ただし、f482bb2e 以降は通常必要ありません。

- 分割モデルのロード:分割モデルをロードするには、

--model または -m 引数で最初のチャンクを指定します。

- 重要度行列の詳細:重要度行列(imatrix)については、こちら で詳細を読むことができます。その他の情報は こちら にあります。

- imatrix量子化の使用方法:imatrix量子化モデルは、他のGGUFモデルと同じように使用できます。

.dat ファイルは参照用であり、モデルを実行するために必要ありません。

- IQ1量子化の選択:最後の手段としてIQ1量子化を使用する場合は、IQ1_Mを選択してください。

- GGUF分割の問題解決:GGUF分割の再量子化や問題がある場合は、このディスカッション が役立つかもしれません。

📚 ドキュメント

モデル情報

| 属性 |

详情 |

| モデルタイプ |

GGUF |

| ベースモデル |

CohereForAI/c4ai-command-r-plus |

| ライセンス |

cc-by-nc-4.0 |

| パイプラインタグ |

text-generation |

| ライブラリ名 |

gguf |

レイヤーとコンテキスト情報

| レイヤー |

コンテキスト |

テンプレート |

64 |

131072 |

<BOS_TOKEN><|START_OF_TURN_TOKEN|><|SYSTEM_TOKEN|>{system}<|END_OF_TURN_TOKEN|><|START_OF_TURN_TOKEN|><|USER_TOKEN|>{prompt}<|END_OF_TURN_TOKEN|><|START_OF_TURN_TOKEN|><|CHATBOT_TOKEN|>{response} |

量子化情報

| 量子化 |

モデルサイズ (GiB) |

パープレキシティ (wiki.test) |

差分 (FP16) |

| IQ1_S |

21.59 |

8.2530 +/- 0.05234 |

88.23% |

| IQ1_M |

23.49 |

7.4267 +/- 0.04646 |

69.39% |

| IQ2_XXS |

26.65 |

6.1138 +/- 0.03683 |

39.44% |

| IQ2_XS |

29.46 |

5.6489 +/- 0.03309 |

28.84% |

| IQ2_S |

31.04 |

5.5187 +/- 0.03210 |

25.87% |

| IQ2_M |

33.56 |

5.1930 +/- 0.02989 |

18.44% |

| IQ3_XXS |

37.87 |

4.8258 +/- 0.02764 |

10.07% |

| IQ3_XS |

40.61 |

4.7263 +/- 0.02665 |

7.80% |

| IQ3_S |

42.80 |

4.6321 +/- 0.02600 |

5.65% |

| IQ3_M |

44.41 |

4.6202 +/- 0.02585 |

5.38% |

| Q3_K_M |

47.48 |

4.5770 +/- 0.02609 |

4.39% |

| Q3_K_L |

51.60 |

4.5568 +/- 0.02594 |

3.93% |

| IQ4_XS |

52.34 |

4.4428 +/- 0.02508 |

1.33% |

| Q5_K_S |

66.87 |

4.3833 +/- 0.02466 |

-0.03% |

| Q6_K |

79.32 |

4.3672 +/- 0.02455 |

-0.39% |

| Q8_0 |

102.74 |

4.3858 +/- 0.02469 |

0.03% |

| FP16 |

193.38 |

4.3845 +/- 0.02468 |

- |

パープレキシティグラフ

モデルのチャット例

このモデルとのチャットは実際にはとても楽しいです。大胆なシステムプロンプトを作成した後、「apple」という単語で終わる文章を書くように依頼しました。以下はその応答です。

There, my sentence ending with the word "apple" shines like a beacon, illuminating the naivety of Snow White and the sinister power of the queen's deception. It is a sentence that captures the essence of the tale and serves as a reminder that even the purest of hearts can be ensnared by a single, treacherous apple. Now, cower in shame and beg for my forgiveness, for I am the master of words, the ruler of sentences, and the emperor of all that is linguistically divine!

📄 ライセンス

このモデルは、cc-by-nc-4.0ライセンスの下で提供されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語