Pyc2py Alpha2

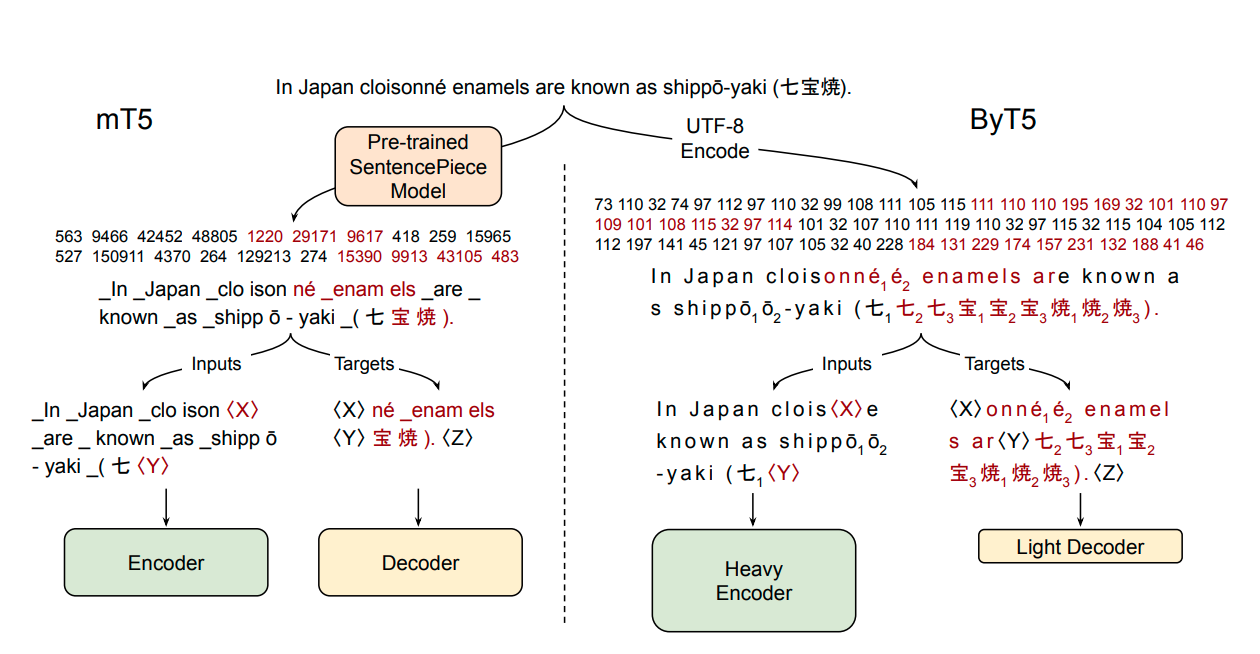

ByT5はGoogleのT5の形態素解析器不要なバージョンで、形態素解析器に依存せずに生のUTF - 8バイトを直接処理します。ノイズテキストや多言語シナリオの処理に特に適しています。

ダウンロード数 15

リリース時間 : 3/2/2022

モデル概要

ByT5はバイトからバイトへの事前学習を行ったTransformerモデルで、形態素解析器を必要とせずに生のUTF - 8バイトシーケンスを直接処理します。このモデルはmC4データセットで事前学習され、多言語テキスト処理タスクに適しており、特にノイズテキストで優れた性能を発揮します。

モデル特徴

形態素解析器不要な設計

生のUTF - 8バイトを直接処理し、独立した形態素解析器に依存しないため、技術的な複雑さを低減します。

多言語対応

バイトレベルの処理に基づいており、追加の言語適応なしですべての言語のテキストを自然にサポートします。

ノイズに対するロバスト性

ノイズテキスト(誤字や非標準形式など)では、従来の形態素解析モデルよりも著しく優れた性能を発揮します。

統一アーキテクチャ

標準的なTransformerアーキテクチャを使用し、バイトシーケンスを処理するためにわずかな調整だけで済みます。

モデル能力

多言語テキスト生成

ノイズテキスト処理

言語間の転移学習

テキスト理解と変換

使用事例

自然言語処理

多言語テキスト要約

複数の言語のテキストに対して要約を生成する

言語固有の処理なしで言語間の要約を実現できます

ノイズテキスト処理

誤字や非標準形式を含むテキストを処理する

TweetQAタスクでは従来の形態素解析モデルよりも優れた性能を発揮します

機械翻訳

バイトレベルの機械翻訳

バイトシーケンスレベルで直接言語変換を行う

形態素解析による情報損失を回避できます

おすすめAIモデル

Llama 3 Typhoon V1.5x 8b Instruct

タイ語専用に設計された80億パラメータの命令モデルで、GPT-3.5-turboに匹敵する性能を持ち、アプリケーションシナリオ、検索拡張生成、制限付き生成、推論タスクを最適化

大規模言語モデル Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応

Transformers 複数言語対応L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-TinyはSODAデータセットでトレーニングされた超小型対話モデルで、エッジデバイス推論向けに設計されており、体積はCosmo-3Bモデルの約2%です。

対話システム Transformers 英語

Transformers 英語

Transformers 英語

Transformers 英語C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

RoBERTaアーキテクチャに基づく中国語抽出型QAモデルで、与えられたテキストから回答を抽出するタスクに適しています。

質問応答システム 中国語

R

uer

2,694

98