🚀 Depth Anything (大型モデル、Transformersバージョン)

Depth Anythingモデルは、Lihe Yangらによる論文 Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data で紹介され、このリポジトリ で最初に公開されました。

オンラインデモ も提供されています。

免責事項:Depth Anythingを公開したチームはこのモデルのモデルカードを作成していないため、このモデルカードはHugging Faceチームによって作成されています。

🚀 クイックスタート

このセクションでは、Depth Anythingモデルの概要と使用方法を紹介します。

✨ 主な機能

- Depth Anythingは、DPT アーキテクチャを DINOv2 バックボーンで活用しています。

- このモデルは約6200万枚の画像で学習され、相対深度推定と絶対深度推定の両方で最先端の結果を得ています。

📦 インストール

このモデルを使用するには、transformers ライブラリが必要です。以下のコマンドでインストールできます。

pip install transformers

💻 使用例

基本的な使用法

ここでは、このモデルを使ってゼロショット深度推定を行う方法を示します。

from transformers import pipeline

from PIL import Image

import requests

pipe = pipeline(task="depth-estimation", model="LiheYoung/depth-anything-large-hf")

url = 'http://images.cocodataset.org/val2017/000000039769.jpg'

image = Image.open(requests.get(url, stream=True).raw)

depth = pipe(image)["depth"]

高度な使用法

クラスを直接使用する方法もあります。

from transformers import AutoImageProcessor, AutoModelForDepthEstimation

import torch

import numpy as np

from PIL import Image

import requests

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

image_processor = AutoImageProcessor.from_pretrained("LiheYoung/depth-anything-large-hf")

model = AutoModelForDepthEstimation.from_pretrained("LiheYoung/depth-anything-large-hf")

inputs = image_processor(images=image, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

predicted_depth = outputs.predicted_depth

prediction = torch.nn.functional.interpolate(

predicted_depth.unsqueeze(1),

size=image.size[::-1],

mode="bicubic",

align_corners=False,

)

より多くのコード例については、ドキュメント を参照してください。

📚 ドキュメント

想定される用途と制限

この生モデルは、ゼロショット深度推定などのタスクに使用できます。関心のあるタスクの他のバージョンを探すには、モデルハブ を参照してください。

モデルの説明

Depth Anythingは、DPT アーキテクチャを DINOv2 バックボーンで活用しています。このモデルは約6200万枚の画像で学習され、相対深度推定と絶対深度推定の両方で最先端の結果を得ています。

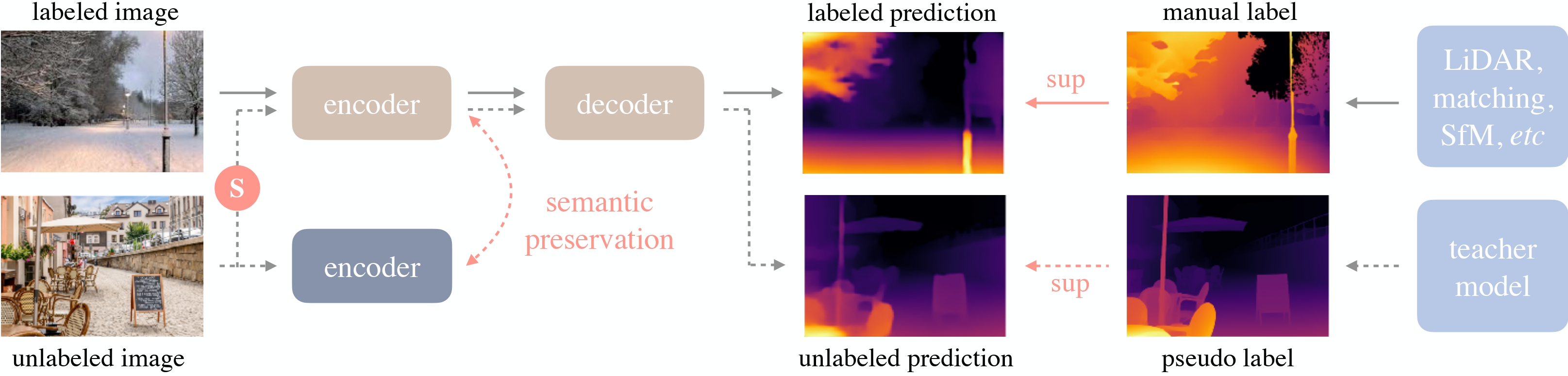

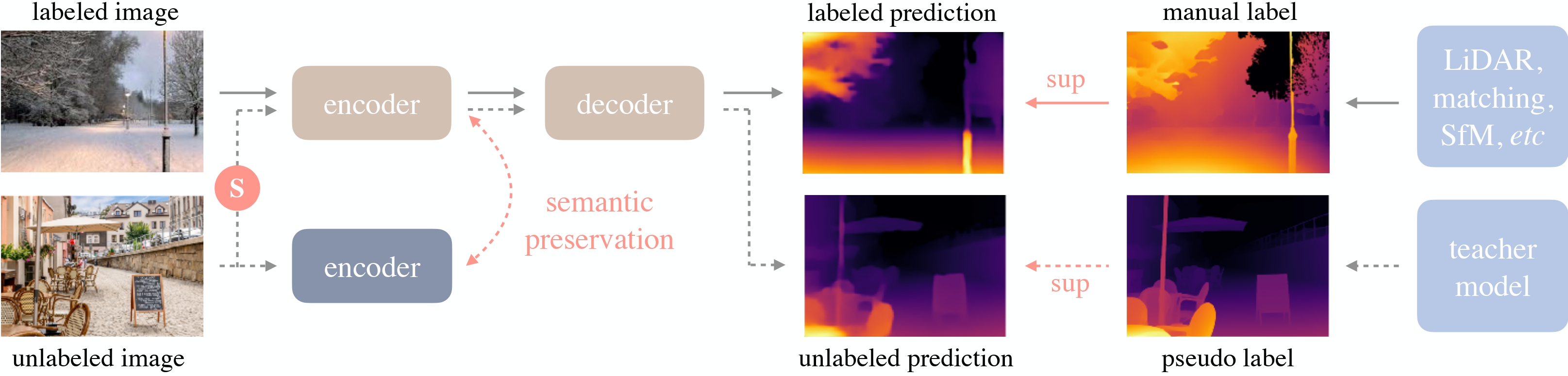

Depth Anythingの概要。元の論文 から引用。

BibTeXエントリと引用情報

@misc{yang2024depth,

title={Depth Anything: Unleashing the Power of Large-Scale Unlabeled Data},

author={Lihe Yang and Bingyi Kang and Zilong Huang and Xiaogang Xu and Jiashi Feng and Hengshuang Zhao},

year={2024},

eprint={2401.10891},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

📄 ライセンス

このモデルは、Apache-2.0ライセンスの下で公開されています。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語