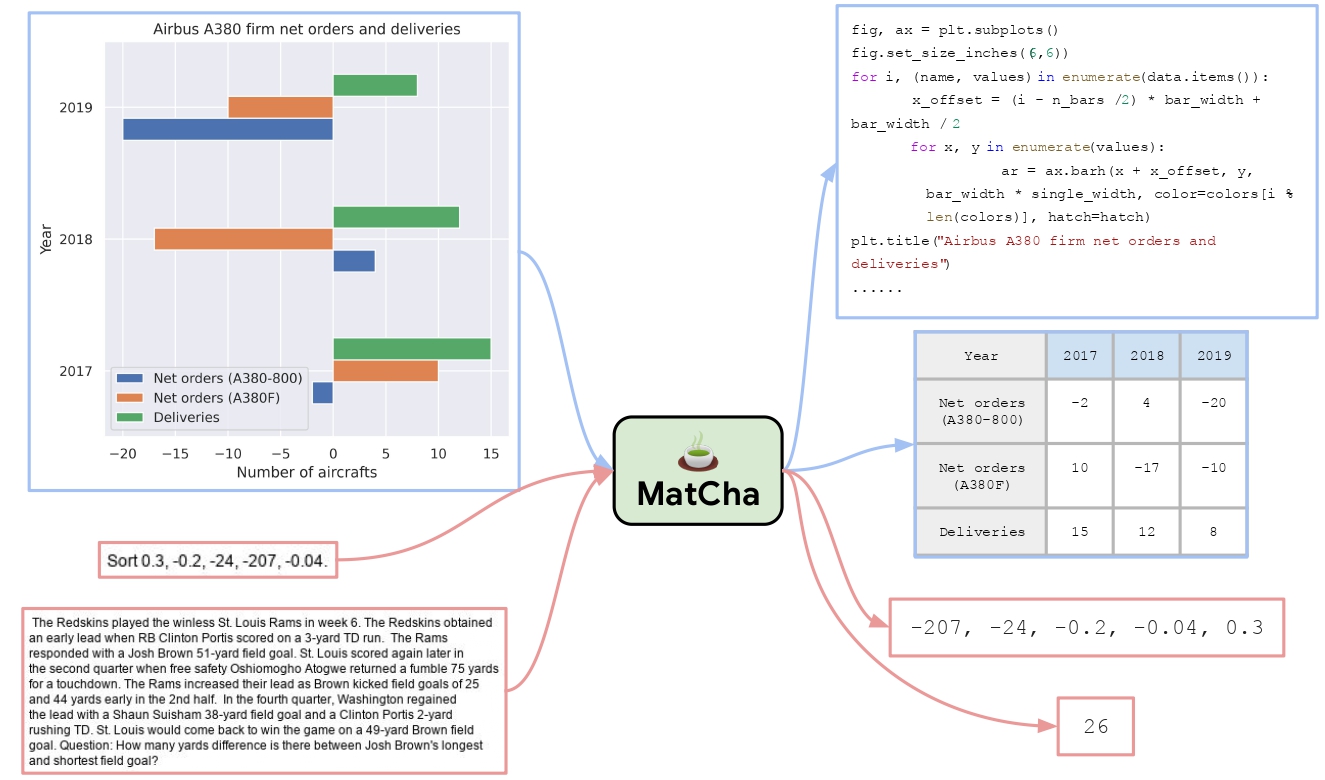

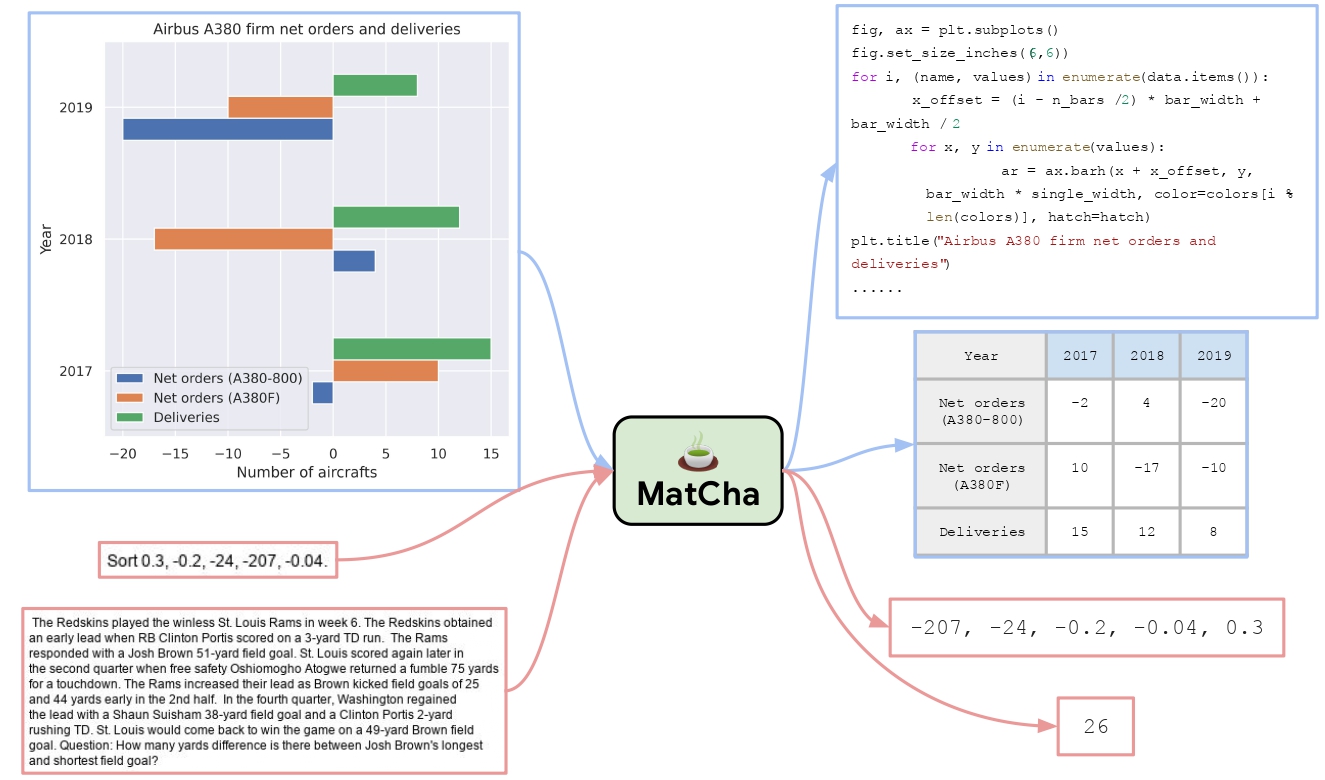

🚀 MatCha - Chart2text - pewでファインチューニングされたモデル

このモデルはMatChaモデルで、Chart2text - pewデータセットでファインチューニングされています。このファインチューニングされたチェックポイントは、チャート要約タスクにより適している可能性があります。

🚀 クイックスタート

目次

- 要約

- モデルの使用方法

- 貢献者

- 引用

📚 要約

論文の概要には以下のように記載されています。

グラフ、チャート、インフォグラフィックなどの視覚言語データは、人間の世界に遍在しています。しかし、最先端のビジョン言語モデルはこれらのデータに対してうまく機能しません。私たちはMATCHA(数学的推論とチャートの逆レンダリング事前学習)を提案し、チャート/グラフと言語データを共同でモデリングするビジョン言語モデルの能力を強化します。具体的には、ビジョン言語モデリングにおける重要な能力であるグラフの分解と数値推論をカバーするいくつかの事前学習タスクを提案します。私たちは、最近提案された画像からテキストへのビジョン言語モデルであるPix2Structから始めてMATCHAの事前学習を行います。PlotQAやChartQAなどの標準的なベンチマークでは、MATCHAモデルは最先端の方法を最大で約20%上回っています。また、MATCHAの事前学習がスクリーンショット、教科書の図、文書の図などのドメインにどれだけ転移するかを調べ、全体的な改善を観察し、より広範なビジョン言語タスクに対するMATCHAの事前学習の有用性を検証しています。

💻 使用例

基本的な使用法

from transformers import Pix2StructProcessor, Pix2StructForConditionalGeneration

import requests

from PIL import Image

processor = Pix2StructProcessor.from_pretrained('google/matcha-chart2text-pew')

model = Pix2StructForConditionalGeneration.from_pretrained('google/matcha-chart2text-pew')

url = "https://raw.githubusercontent.com/vis-nlp/ChartQA/main/ChartQA%20Dataset/val/png/20294671002019.png"

image = Image.open(requests.get(url, stream=True).raw)

inputs = processor(images=image, return_tensors="pt")

predictions = model.generate(**inputs, max_new_tokens=512)

print(processor.decode(predictions[0], skip_special_tokens=True))

T5xからHugging Faceへの変換

convert_pix2struct_checkpoint_to_pytorch.py スクリプトを以下のように使用できます。

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --is_vqa

大規模なモデルを変換する場合は、以下を実行します。

python convert_pix2struct_checkpoint_to_pytorch.py --t5x_checkpoint_path PATH_TO_T5X_CHECKPOINTS --pytorch_dump_path PATH_TO_SAVE --use-large --is_vqa

保存したら、以下のコードで変換したモデルをプッシュできます。

from transformers import Pix2StructForConditionalGeneration, Pix2StructProcessor

model = Pix2StructForConditionalGeneration.from_pretrained(PATH_TO_SAVE)

processor = Pix2StructProcessor.from_pretrained(PATH_TO_SAVE)

model.push_to_hub("USERNAME/MODEL_NAME")

processor.push_to_hub("USERNAME/MODEL_NAME")

🤝 貢献者

このモデルは、もともとLiu Fangyu、Francesco Piccinnoらによって貢献され、Younes BelkadaによってHugging Faceエコシステムに追加されました。

📄 引用

この研究を引用する場合は、元の論文を引用してください。

@misc{liu2022matcha,

title={MatCha: Enhancing Visual Language Pretraining with Math Reasoning and Chart Derendering},

author={Fangyu Liu and Francesco Piccinno and Syrine Krichene and Chenxi Pang and Kenton Lee and Mandar Joshi and Yasemin Altun and Nigel Collier and Julian Martin Eisenschlos},

year={2022},

eprint={2212.09662},

archivePrefix={arXiv},

primaryClass={cs.CL}

}

| 属性 |

详情 |

| 対応言語 |

en、fr、ro、de、多言語 |

| 推論 |

否 |

| パイプラインタグ |

視覚的質問応答 |

| ライセンス |

apache - 2.0 |

| タグ |

matcha |

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語