模型简介

模型特点

模型能力

使用案例

🚀 易(Yi)大语言模型

易(Yi)系列模型是由01.AI从头开始训练的下一代开源大语言模型。它以双语语言模型为目标,在3T多语言语料库上进行训练,成为全球最强大的大语言模型之一,在语言理解、常识推理、阅读理解等方面表现出色。

🚀 快速开始

💡 提示:如果您想开始使用易(Yi)模型并探索不同的推理方法,请查看易(Yi)使用指南。

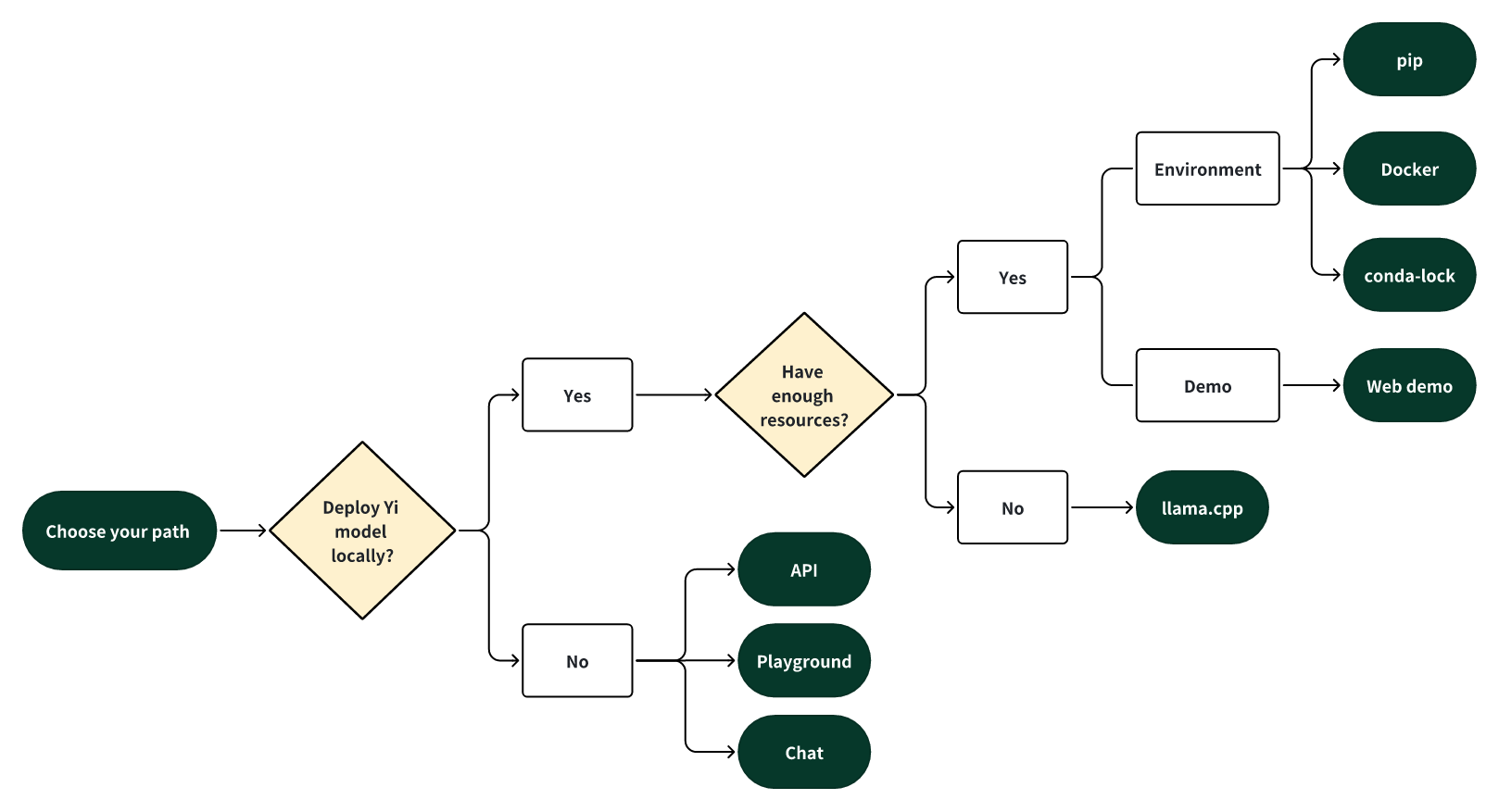

选择您的使用方式

选择以下方式之一开启您的易(Yi)之旅!

🎯 本地部署易(Yi)模型

如果您想在本地部署易(Yi)模型:

- 🙋♀️ 并且您有足够的资源(例如,NVIDIA A800 80GB),您可以选择以下方法:

- pip安装:可参考相应的pip安装步骤。

- docker部署:按照docker部署的流程操作。

- conda - lock:使用conda - lock进行环境管理和部署。

- llama.cpp:借助llama.cpp工具实现本地运行。

- Web演示:通过Web演示体验模型功能。

🎯 使用在线平台体验

您也可以通过以下在线平台体验易(Yi)模型:

✨ 主要特性

- 🤖 易(Yi)系列模型是由01.AI从头开始训练的下一代开源大语言模型。

- 🙌 作为双语语言模型,在3T多语言语料库上训练,成为全球强大的大语言模型之一,在语言理解、常识推理、阅读理解等方面表现出色。例如:

- 易(Yi) - 34B - Chat模型在AlpacaEval排行榜上位居第二(仅次于GPT - 4 Turbo),超越了其他大语言模型(如GPT - 4、Mixtral、Claude)(基于2024年1月的可用数据)。

- 易(Yi) - 34B模型在包括Hugging Face Open LLM Leaderboard(预训练)和C - Eval等各种基准测试中,在英语和中文方面均排名所有现有开源模型之首(如Falcon - 180B、Llama - 70B、Claude)(基于2023年11月的可用数据)。

- 🙏 (感谢Llama)感谢Transformer和Llama开源社区,它们减少了从头构建的工作量,并使AI生态系统中能够使用相同的工具。

如果您对易(Yi)采用Llama架构和许可证使用政策感兴趣,请查看 易(Yi)与Llama的关系 ⬇️

> 💡 简而言之 > > 易(Yi)系列模型采用与Llama相同的模型架构,但**不是**Llama的衍生模型。 - 易(Yi)和Llama都基于Transformer结构,自2018年以来,Transformer结构一直是大语言模型的标准架构。 - 基于Transformer架构,Llama因其出色的稳定性、可靠的收敛性和强大的兼容性,成为大多数最先进开源模型的新基石。这使得Llama成为包括易(Yi)在内的模型公认的基础框架。 - 得益于Transformer和Llama架构,其他模型可以利用它们的优势,减少从头构建的工作量,并在其生态系统中使用相同的工具。 - 然而,易(Yi)系列模型不是Llama的衍生模型,因为它们不使用Llama的权重。 - 由于大多数开源模型都采用Llama的结构,决定模型性能的关键因素是训练数据集、训练管道和训练基础设施。 - 易(Yi)以独特的专有方式发展,完全从头开始独立创建了自己的高质量训练数据集、高效的训练管道和强大的训练基础设施。这一努力使易(Yi)系列模型在[2023年12月的Alpaca排行榜](https://tatsu-lab.github.io/alpaca_eval/)上仅次于GPT4,超越了Llama。

📦 安装指南

文档中未提及具体的安装命令,暂不提供安装指南。

💻 使用示例

基础对话示例

- 易(Yi) - 34B - Chat

- 输入:"hi"

- 输出:" Hello! How can I assist you today?"

- 易(Yi) - 34B

- 输入:"There's a place where time stands still. A place of breath taking wonder, but also"

- 输出:" an eerie sense that something is just not right…\nBetween the two worlds lies The Forgotten Kingdom - home to creatures long since thought extinct and ancient magic so strong it defies belief! Only here can you find what has been lost for centuries: An Elixir Of Life which will restore youth and vitality if only those who seek its power are brave enough to face up against all manner of dangers lurking in this mysterious land! But beware; some say there may even exist powerful entities beyond our comprehension whose intentions towards humanity remain unclear at best ---- they might want nothing more than destruction itself rather then anything else from their quest after immortality (and maybe someone should tell them about modern medicine)? In any event though – one thing remains true regardless : whether or not success comes easy depends entirely upon how much effort we put into conquering whatever challenges lie ahead along with having faith deep down inside ourselves too ;) So let’s get started now shall We?"

📚 详细文档

模型介绍

易(Yi)模型有多种规模,适用于不同的用例。您还可以对易(Yi)模型进行微调,以满足您的特定需求。如果您要部署易(Yi)模型,请确保满足软硬件要求。

对话模型

| 模型 | 下载地址 |

|---|---|

| 易(Yi) - 34B - Chat | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 34B - Chat - 4bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 34B - Chat - 8bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 6B - Chat | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 6B - Chat - 4bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 6B - Chat - 8bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

- 4位系列模型通过AWQ进行量化。

- 8位系列模型通过GPTQ进行量化

- 所有量化模型的使用门槛较低,因为它们可以部署在消费级GPU(如3090、4090)上。

基础模型

| 模型 | 下载地址 |

|---|---|

| 易(Yi) - 34B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 34B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 9B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 9B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 6B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易(Yi) - 6B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

- 200k大约相当于400,000个中文字符。

- 如果您想使用易(Yi) - 34B - 200K的先前版本(2023年11月5日发布),运行git checkout 069cd341d60f4ce4b07ec394e82b79e94f656cf下载权重。

模型信息

-

基础模型和对话模型通用信息 | 模型 | 介绍 | 默认上下文窗口 | 预训练令牌数 | 训练数据截止日期 | | ---- | ---- | ---- | ---- | ---- | | 6B系列模型 | 适用于个人和学术用途。 | 4K | 3T | 截至2023年6月 | | 9B系列模型 | 在易(Yi)系列模型中,最擅长编码和数学。 | 4K | 易(Yi) - 9B在易(Yi) - 6B的基础上继续训练,使用0.8T令牌。 | 截至2023年6月 | | 34B系列模型 | 适用于个人、学术和商业(特别是中小企业)用途。它是一种经济高效的解决方案,价格实惠且具备涌现能力。 | 4K | 3T | 截至2023年6月 |

-

对话模型

关于对话模型的局限性,请查看以下解释 ⬇️

- 幻觉:指模型生成事实错误或无意义的信息。由于模型的响应更加多样化,出现基于不准确数据或逻辑推理的幻觉的可能性更高。

- 再生的非确定性:在尝试重新生成或采样响应时,可能会出现结果不一致的情况。更高的多样性可能导致即使在相似的输入条件下也会产生不同的结果。

- 累积误差:当模型响应中的误差随着时间累积时会出现这种情况。随着模型生成更多样化的响应,小误差累积成更大误差的可能性增加,特别是在复杂任务中,如扩展推理、数学问题解决等。

- 为了获得更连贯和一致的响应,建议调整生成配置参数,如温度、top_p或top_k。这些调整可以帮助平衡模型输出的创造性和连贯性。

发布的对话模型仅使用监督微调(SFT)进行了训练。与其他标准对话模型相比,我们的模型产生的响应更加多样化,适用于各种下游任务,如创意场景。此外,这种多样性有望提高生成更高质量响应的可能性,这将有利于后续的强化学习(RL)训练。

然而,这种更高的多样性可能会加剧某些现有问题,包括:

新闻动态

🔥 2024年7月29日:[易(Yi)使用指南1.0](https://github.com/Haijian06/Yi/tree/main/Cookbook)发布,包含中英文教程和示例。

🎯 2024年5月13日:[易(Yi) - 1.5系列模型](https://github.com/01-ai/Yi-1.5)开源,进一步提高了编码、数学、推理和指令遵循能力。

🎯 2024年3月16日:`易(Yi) - 9B - 200K`开源并向公众开放。

🎯 2024年3月8日:[易(Yi)技术报告](https://arxiv.org/abs/2403.04652)发布!

🔔 2024年3月7日:易(Yi) - 34B - 200K的长文本处理能力得到增强。

在“大海捞针”测试中,易(Yi) - 34B - 200K的性能提高了10.5%,从89.3%提升到令人印象深刻的99.8%。我们继续在5B令牌的长上下文数据混合上对模型进行预训练,并展示了近乎全绿的性能。

🎯 2024年3月6日:`易(Yi) - 9B`开源并向公众开放。

`易(Yi) - 9B`在一系列类似规模的开源模型(包括Mistral - 7B、SOLAR - 10.7B、Gemma - 7B、DeepSeek - Coder - 7B - Base - v1.5等)中表现出色,尤其在代码、数学、常识推理和阅读理解方面表现突出。

🎯 2024年1月23日:易(Yi) - VL模型,`[易(Yi) - VL - 34B](https://huggingface.co/01-ai/Yi-VL-34B)`和`[易(Yi) - VL - 6B](https://huggingface.co/01-ai/Yi-VL-6B)`开源并向公众开放。

`[易(Yi) - VL - 34B](https://huggingface.co/01-ai/Yi-VL-34B)`在最新的基准测试中,包括[MMMU](https://arxiv.org/abs/2311.16502)和[CMMMU](https://arxiv.org/abs/2401.11944)(基于2024年1月的可用数据),在所有现有开源模型中排名**第一**。

🎯 2023年11月23日:[对话模型](https://hf-mirror.com/api/resolve-cache/models/01-ai/Yi-34B-200K/e0ae1afac6b69f604556efd441ab4befafb2a835/README.md?download=true&etag=%222395a3bc02655e084849e9e0a9e2d8462ed0acc9%22#chat-models)开源并向公众开放。

本次发布包含基于先前发布的基础模型的两个对话模型、两个通过GPTQ量化的8位模型和两个通过AWQ量化的4位模型。 - `易(Yi) - 34B - Chat` - `易(Yi) - 34B - Chat - 4bits` - `易(Yi) - 34B - Chat - 8bits` - `易(Yi) - 6B - Chat` - `易(Yi) - 6B - Chat - 4bits` - `易(Yi) - 6B - Chat - 8bits`

您可以在以下平台交互式尝试其中一些模型:

🔔 2023年11月23日:易(Yi)系列模型社区许可协议更新为[2.1版本](https://github.com/01-ai/Yi/blob/main/MODEL_LICENSE_AGREEMENT.txt)。

🔥 2023年11月8日:易(Yi) - 34B对话模型邀请测试。

申请表: - [英文](https://cn.mikecrm.com/l91ODJf) - [中文](https://cn.mikecrm.com/gnEZjiQ)

🎯 2023年11月5日:[基础模型](https://hf-mirror.com/api/resolve-cache/models/01-ai/Yi-34B-200K/e0ae1afac6b69f604556efd441ab4befafb2a835/README.md?download=true&etag=%222395a3bc02655e084849e9e0a9e2d8462ed0acc9%22#base-models),`易(Yi) - 6B - 200K`和`易(Yi) - 34B - 200K`开源并向公众开放。

本次发布包含两个基础模型,参数规模与之前发布的相同,但上下文窗口扩展到200K。

🎯 2023年11月2日:[基础模型](https://hf-mirror.com/api/resolve-cache/models/01-ai/Yi-34B-200K/e0ae1afac6b69f604556efd441ab4befafb2a835/README.md?download=true&etag=%222395a3bc02655e084849e9e0a9e2d8462ed0acc9%22#base-models),`易(Yi) - 6B`和`易(Yi) - 34B`开源并向公众开放。

首次公开发布包含两个双语(英语/中文)基础模型,参数规模分别为6B和34B。它们都以4K序列长度进行训练,在推理时可以扩展到32K。

微调

文档中未提及具体的微调步骤和方法,暂不提供详细内容。

量化

文档中未提及具体的量化步骤和方法,暂不提供详细内容。

部署

文档中未提及具体的部署步骤和软硬件要求,暂不提供详细内容。

常见问题解答(FAQ)

文档中未提及常见问题及解答,暂不提供详细内容。

学习中心

您可以在易(Yi)学习中心进行学习和提升。

🔧 技术细节

文档中未提及具体的技术实现细节,暂不提供详细内容。

📄 许可证

本项目采用Apache - 2.0许可证。

Transformers

Transformers Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语