🚀 动漫角色文本到图像生成模型

该模型专注于动漫角色的图像生成,基于特定动漫角色训练,能根据文本提示生成对应风格的动漫图像,为动漫艺术创作和相关应用提供了强大的支持。

🚀 快速开始

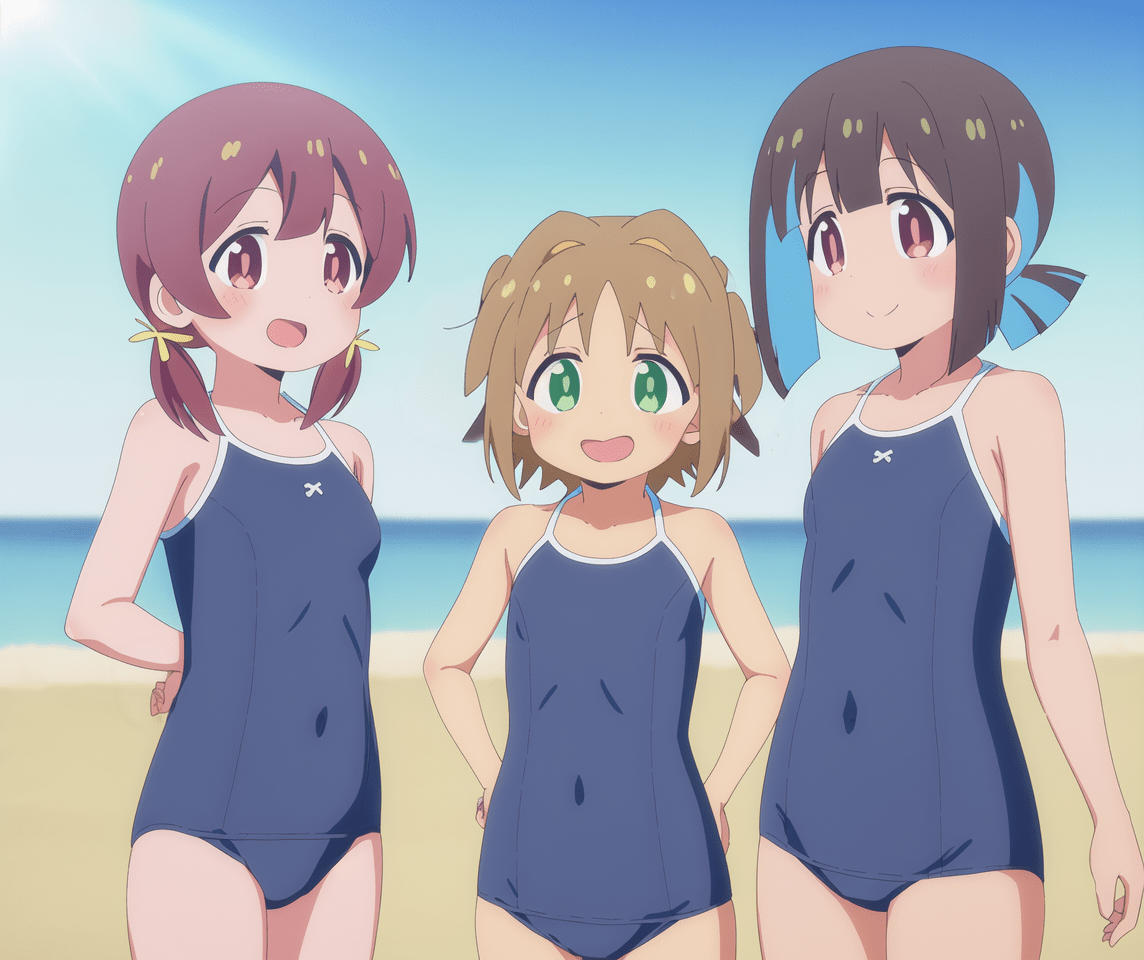

此模型以扩散器(diffuser)和安全张量(safetensors)两种格式共享。触发词方面,六个角色可以使用 OyamaMahiro、OyamaMihari、HozukiKaede、HozukiMomiji、OkaAsahi 和 MurosakiMiyo 进行提示。TenkawaNayuta 虽有标签,但她出现在少于 10 张图像中,因此不要期望有好的生成效果。模型还训练了三种不同风格:aniscreen、edstyle 和 megazine。通常可以生成多角色图像,但从 4 个角色开始就比较困难了。另外,该模型在剪辑跳过(clip skip)为 1 的情况下训练。

✨ 主要特性

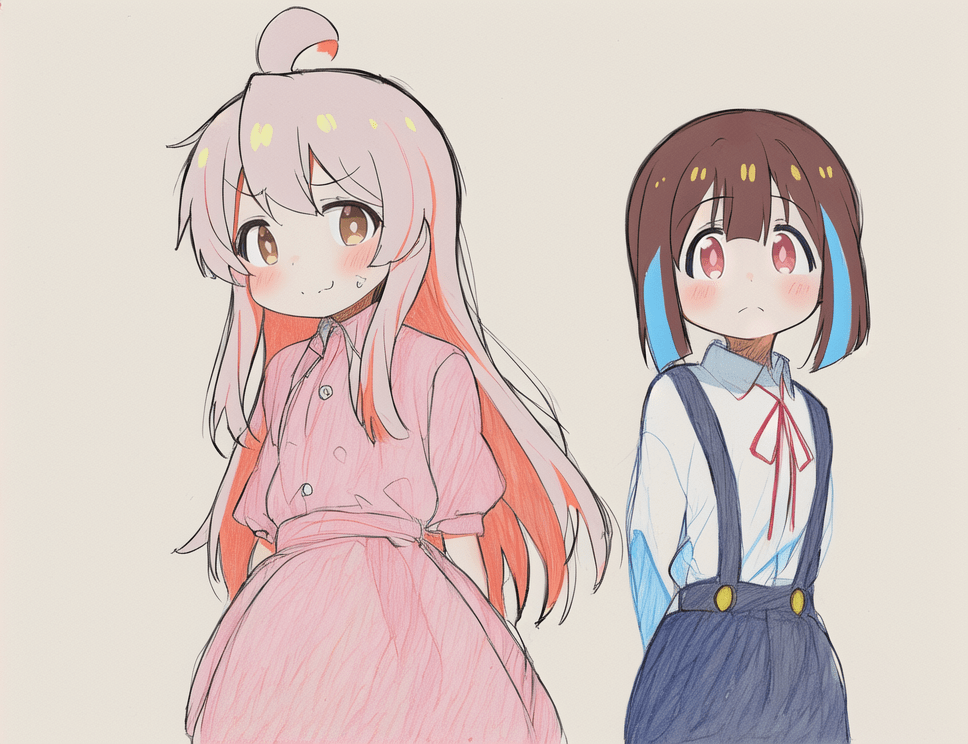

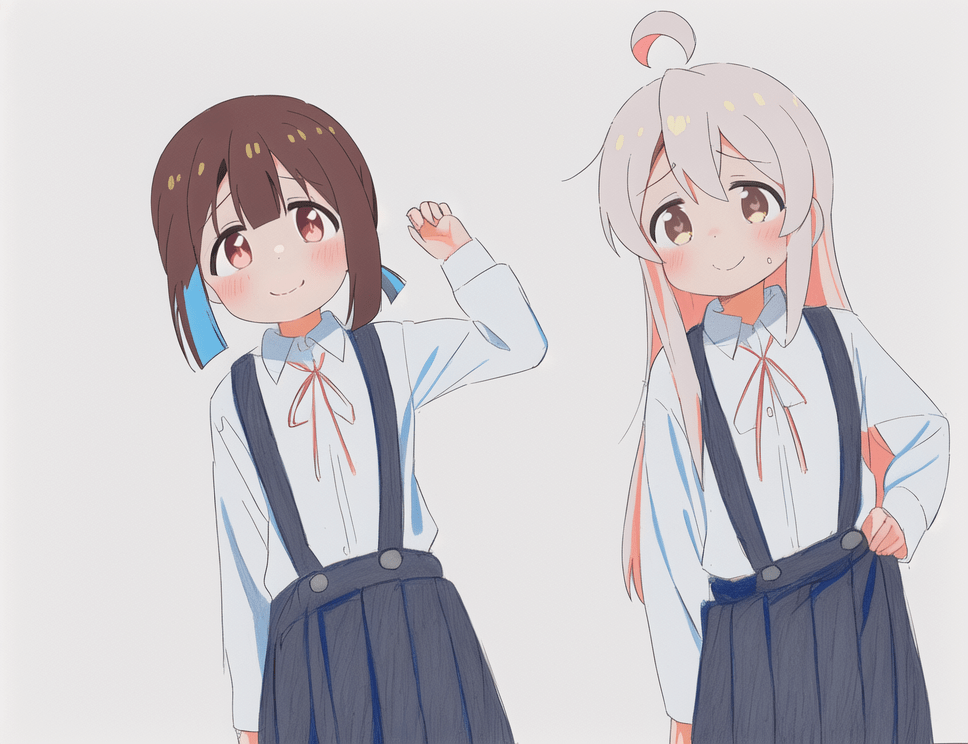

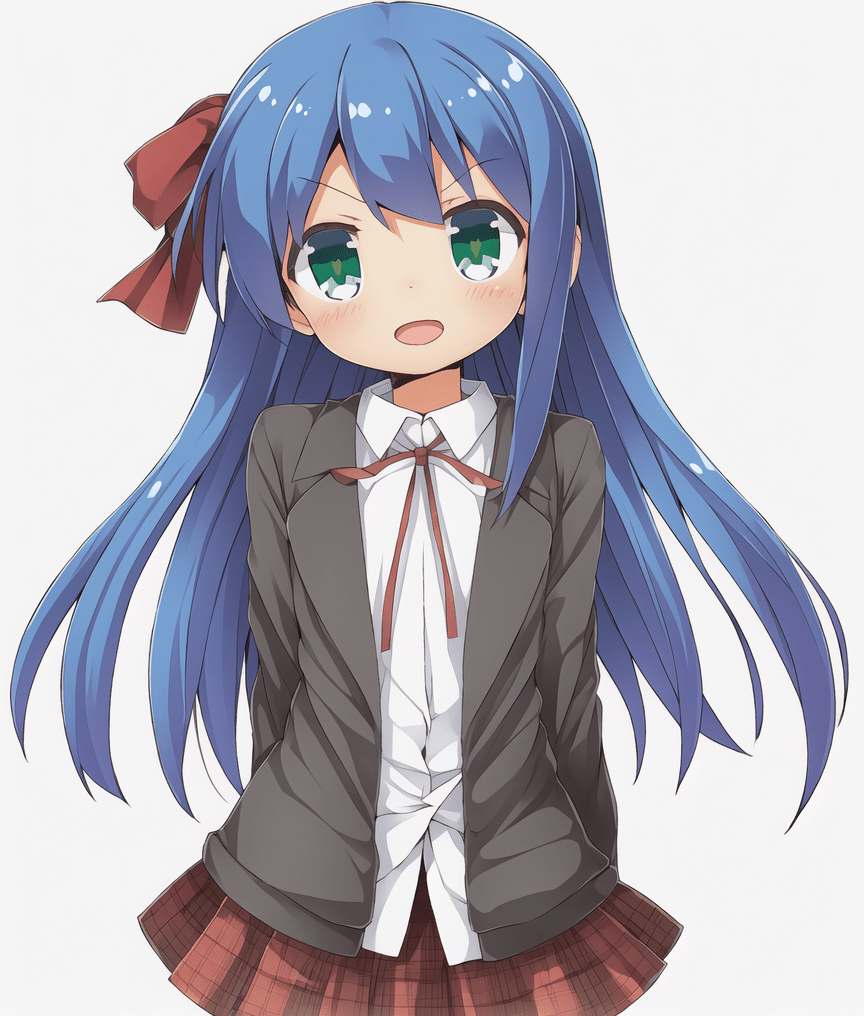

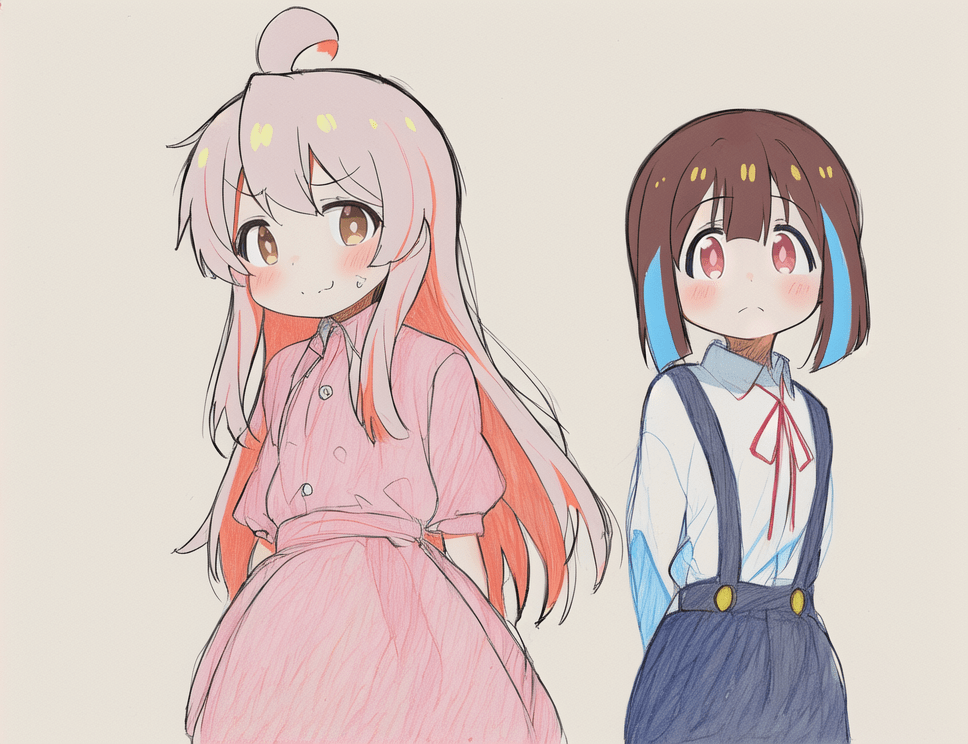

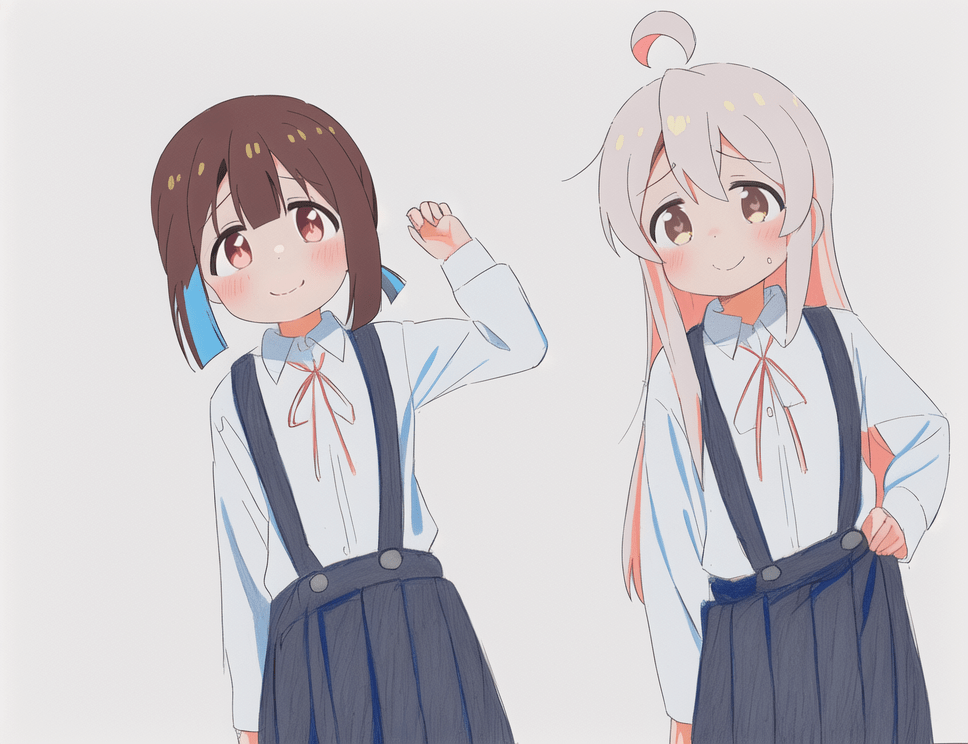

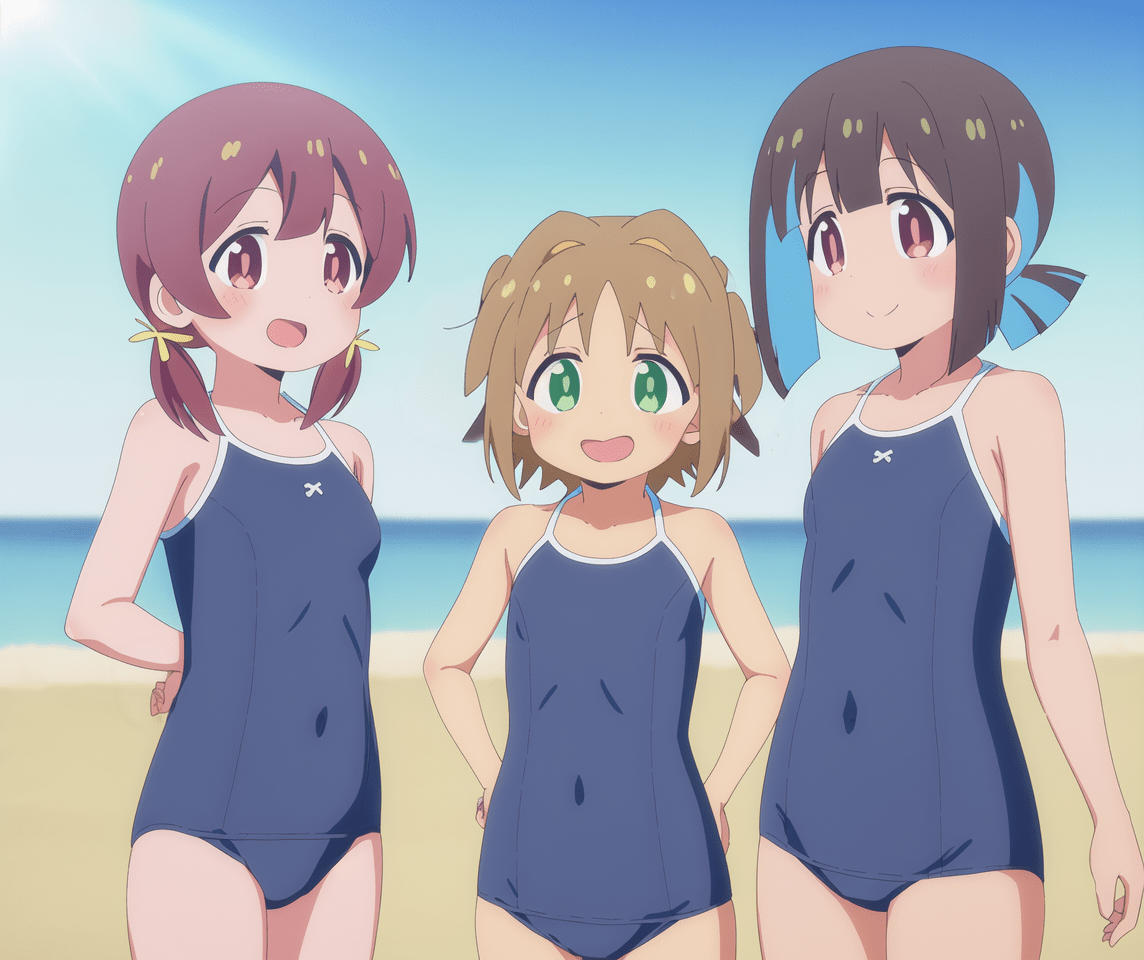

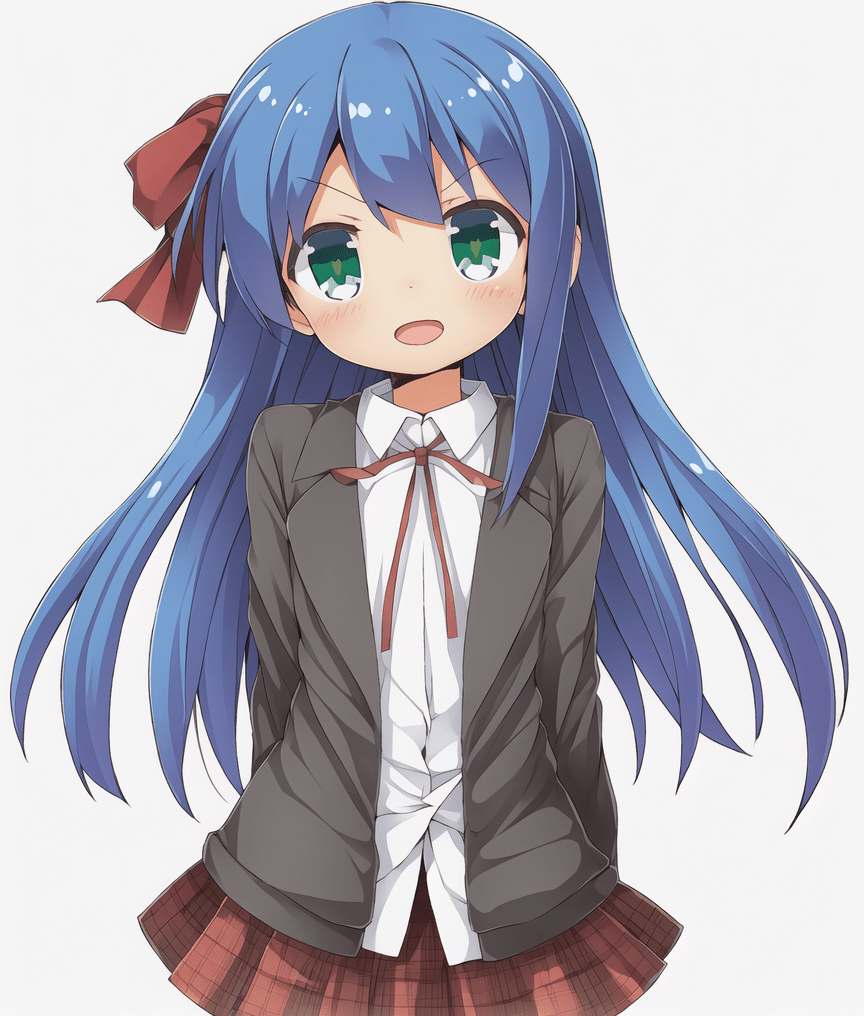

- 角色精准生成:基于《别当欧尼酱了!》(お兄ちゃんはおしまい!)中的 6(+1?)个角色进行训练,能精准生成对应角色的图像。

- 多风格支持:模型训练了

aniscreen、edstyle 和 megazine 三种不同风格,满足多样化的创作需求。

- 双格式共享:以扩散器(diffuser)和安全张量(safetensors)两种格式共享,方便不同用户使用。

💻 使用示例

基础用法

使用触发词生成对应角色图像,例如:

提示词:OyamaMahiro, aniscreen style

高级用法

组合多个触发词和风格,生成多角色、多风格的复杂图像,例如:

提示词:OyamaMahiro, HozukiKaede, edstyle

📚 详细文档

更新记录 -- 2023.02.19

在 loras 子文件夹中添加了两个使用相同数据集训练的 LoRA 检查点。第一个似乎已经可以使用,模型学习到了角色特征,但遗憾的是没有学习到风格和服装特征。该 LoRA 基于 ACertainty 进行训练,在 Orange 和 Anything 模型上效果良好,但在如 MyneFactoryBase 或作者自己的模型等进一步训练的模型上效果不太好。作者仍未弄清楚 LoRA 何时能正确迁移。

LoRA 的维度为 32,alpha 为 1,学习率为 1e-4。以下是一些生成示例:

提示:如果需要更复杂的场景,或者对风格和服装有更高的保真度要求,建议使用完整模型。也可以通过合并模型来改变风格。

更多生成示例

数据集描述

数据集通过此工作流准备:https://github.com/cyber-meow/anime_screenshot_pipeline 。它包含 21412 张图像,组成如下:

- 2133 张《别当欧尼酱了!》相关图像,分为四种类型:

- 1496 张来自前六集的动漫截图(对应

aniscreen 风格)

- 70 张动漫结尾截图(对应

edstyle 风格,不包含在上述 1496 张中)

- 528 张粉丝画作(或可能是一些官方画作)

- 39 张漫画封面扫描图(对应

megazine 风格,不要问为什么选这个名字,虽然不好但效果不错)

- 19279 张正则化图像,旨在尽可能多样化,同时保持动漫风格(即不使用写实照片)

注意,模型使用特定的加权方案进行训练,以平衡不同概念,因此每张图像的权重并不相等。应用每图像重复后,每个 epoch 大约有 145K 张图像。

训练信息

使用 EveryDream2 训练器,以 ACertainty 为基础模型进行训练,使用以下配置:

- 分辨率 512

- 余弦学习率调度器,学习率 2.5e - 6

- 批量大小 8

- 条件丢弃率 0.08

- 在模型调度器的

config.json 中将 beta 调度器从 scaler_linear 更改为 linear

- 剪辑跳过 1

作者训练了两个 epoch,而默认发布模型如上述所提到的训练了 22828 步。

🔧 技术细节

模型训练

模型基于特定的动漫角色数据集进行训练,使用了特定的加权方案来平衡不同概念,确保每个角色和风格都能得到适当的学习。训练过程中采用了余弦学习率调度器和条件丢弃率等技术,以提高模型的泛化能力。

数据集处理

数据集包含动漫截图、粉丝画作、漫画封面扫描图和正则化图像等多种类型,通过特定的工作流进行准备。在训练时,对图像进行了每图像重复处理,以增加每个 epoch 的训练数据量。

📄 许可证

本模型采用 CreativeML OpenRAIL - M 许可证。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语