模型简介

模型特点

模型能力

使用案例

🚀 Controlnet - v1.1 - InPaint Version

Controlnet v1.1 是一种用于控制扩散模型的神经网络结构,可通过添加额外条件来增强扩散模型的功能。本版本为 InPaint 版本,可与 Stable Diffusion 结合使用,实现图像修复等功能。

🚀 快速开始

环境准备

首先,你需要安装 diffusers 及相关依赖包:

pip install diffusers transformers accelerate

代码示例

以下是一个使用本模型进行图像修复的示例代码:

import torch

import os

from diffusers.utils import load_image

from PIL import Image

import numpy as np

from diffusers import (

ControlNetModel,

StableDiffusionControlNetPipeline,

UniPCMultistepScheduler,

)

checkpoint = "lllyasviel/control_v11p_sd15_inpaint"

original_image = load_image(

"https://huggingface.co/lllyasviel/control_v11p_sd15_inpaint/resolve/main/images/original.png"

)

mask_image = load_image(

"https://huggingface.co/lllyasviel/control_v11p_sd15_inpaint/resolve/main/images/mask.png"

)

def make_inpaint_condition(image, image_mask):

image = np.array(image.convert("RGB")).astype(np.float32) / 255.0

image_mask = np.array(image_mask.convert("L"))

assert image.shape[0:1] == image_mask.shape[0:1], "image and image_mask must have the same image size"

image[image_mask < 128] = -1.0 # set as masked pixel

image = np.expand_dims(image, 0).transpose(0, 3, 1, 2)

image = torch.from_numpy(image)

return image

control_image = make_inpaint_condition(original_image, mask_image)

prompt = "best quality"

negative_prompt="lowres, bad anatomy, bad hands, cropped, worst quality"

controlnet = ControlNetModel.from_pretrained(checkpoint, torch_dtype=torch.float16)

pipe = StableDiffusionControlNetPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5", controlnet=controlnet, torch_dtype=torch.float16

)

pipe.scheduler = UniPCMultistepScheduler.from_config(pipe.scheduler.config)

pipe.enable_model_cpu_offload()

generator = torch.manual_seed(2)

image = pipe(prompt, negative_prompt=negative_prompt, num_inference_steps=30,

generator=generator, image=control_image).images[0]

image.save('images/output.png')

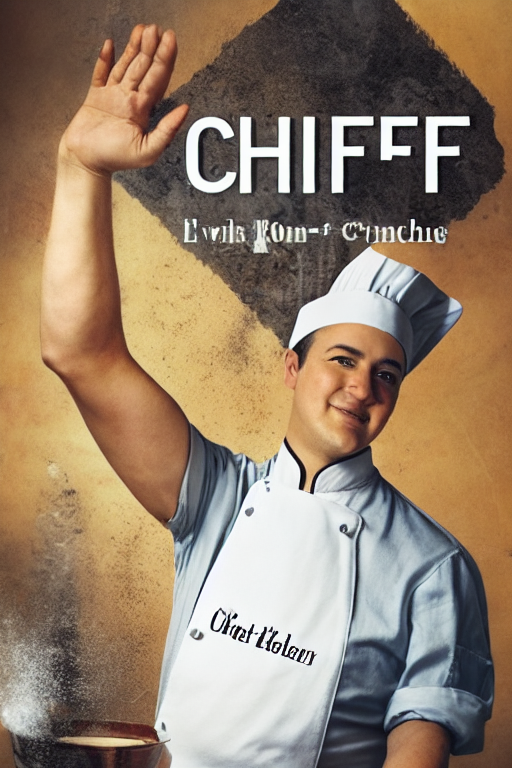

示例图片

✨ 主要特性

- 灵活控制:通过添加额外条件,可灵活控制扩散模型的生成结果。

- 与 Stable Diffusion 兼容:可与 Stable Diffusion 模型(如 runwayml/stable-diffusion-v1-5)结合使用。

- 多种应用场景:适用于图像修复、风格转换等多种图像生成任务。

📦 安装指南

安装 diffusers 及相关依赖包:

pip install diffusers transformers accelerate

💻 使用示例

基础用法

import base64

import requests

HF_TOKEN = 'hf_xxxxxxxxxxxxx'

API_ENDPOINT = 'https://xxxxxxxxxxx.us-east-1.aws.endpoints.huggingface.cloud'

def load_image(path):

try:

with open(path, 'rb') as file:

return file.read()

except FileNotFoundError as error:

print('Error reading image:', error)

def get_b64_image(path):

image_buffer = load_image(path)

if image_buffer:

return base64.b64encode(image_buffer).decode('utf-8')

def process_images(original_image_path, mask_image_path, result_path, prompt, width, height):

original_b64 = get_b64_image(original_image_path)

mask_b64 = get_b64_image(mask_image_path)

if not original_b64 or not mask_b64:

return

body = {

'inputs': prompt,

'image': original_b64,

'mask_image': mask_b64,

'width': width,

'height': height

}

headers = {

'Authorization': f'Bearer {HF_TOKEN}',

'Content-Type': 'application/json',

'Accept': 'image/png'

}

response = requests.post(

API_ENDPOINT,

json=body,

headers=headers

)

blob = response.content

save_image(blob, result_path)

def save_image(blob, file_path):

with open(file_path, 'wb') as file:

file.write(blob)

print('File saved successfully!')

if __name__ == '__main__':

original_image_path = 'images/original.png'

mask_image_path = 'images/mask.png'

result_path = 'images/result.png'

process_images(original_image_path, mask_image_path, result_path, 'cyberpunk mona lisa', 512, 768)

高级用法

本模型可与其他扩散模型结合使用,如 dreamboothed stable diffusion,但建议与 Stable Diffusion v1-5 搭配使用,因为该模型是基于此进行训练的。

📚 详细文档

模型介绍

ControlNet v1.1 由 Lvmin Zhang 在 lllyasviel/ControlNet-v1-1 中发布。本检查点是将 原始检查点 转换为 diffusers 格式,可与 Stable Diffusion 结合使用。

模型原理

ControlNet 是一种神经网络结构,通过添加额外条件来控制扩散模型。其原理是在扩散模型的基础上,引入额外的条件信息,从而实现对生成结果的精确控制。

更多细节

更多详细信息,请参考 🧨 Diffusers 文档。

🔧 技术细节

模型信息

| 属性 | 详情 |

|---|---|

| 模型类型 | 基于扩散的文本到图像生成模型 |

| 训练数据 | 未提及 |

| 开发者 | Lvmin Zhang, Maneesh Agrawala |

| 语言 | 英文 |

| 许可证 | The CreativeML OpenRAIL M license 是一种 Open RAIL M license,改编自 BigScience 和 the RAIL Initiative 在负责任的 AI 许可领域的联合工作。 |

| 更多资源 | GitHub 仓库,论文 |

引用信息

@misc{zhang2023adding,

title={Adding Conditional Control to Text-to-Image Diffusion Models},

author={Lvmin Zhang and Maneesh Agrawala},

year={2023},

eprint={2302.05543},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

论文摘要

本文提出了一种神经网络结构 ControlNet,用于控制预训练的大型扩散模型,以支持额外的输入条件。ControlNet 可以端到端地学习特定任务的条件,即使训练数据集较小(< 50k),学习过程也很稳健。此外,训练 ControlNet 的速度与微调扩散模型相当,并且可以在个人设备上进行训练。如果有强大的计算集群,模型可以扩展到大量(数百万到数十亿)的数据。实验表明,像 Stable Diffusion 这样的大型扩散模型可以通过 ControlNet 进行增强,以支持边缘图、分割图、关键点等条件输入。这可能会丰富控制大型扩散模型的方法,并进一步促进相关应用的发展。

📄 许可证

本模型使用 The CreativeML OpenRAIL M license 许可证。

其他已发布的检查点 v1-1

作者发布了 14 种不同的检查点,每种检查点都基于 Stable Diffusion v1-5 在不同类型的条件下进行训练:

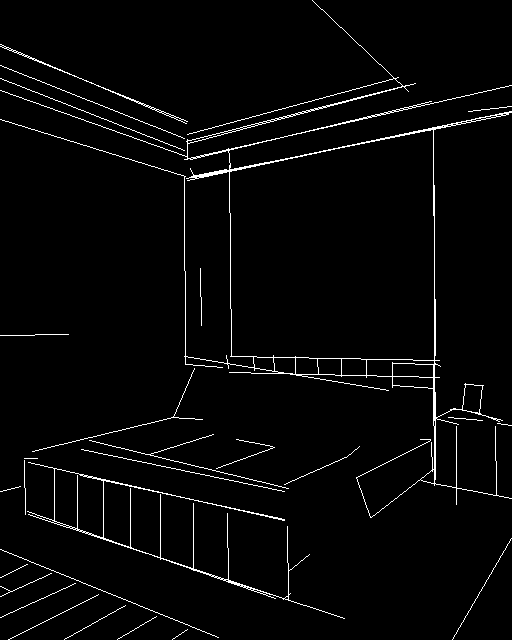

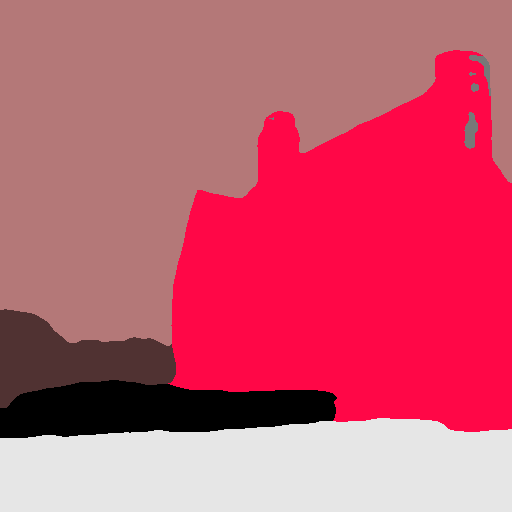

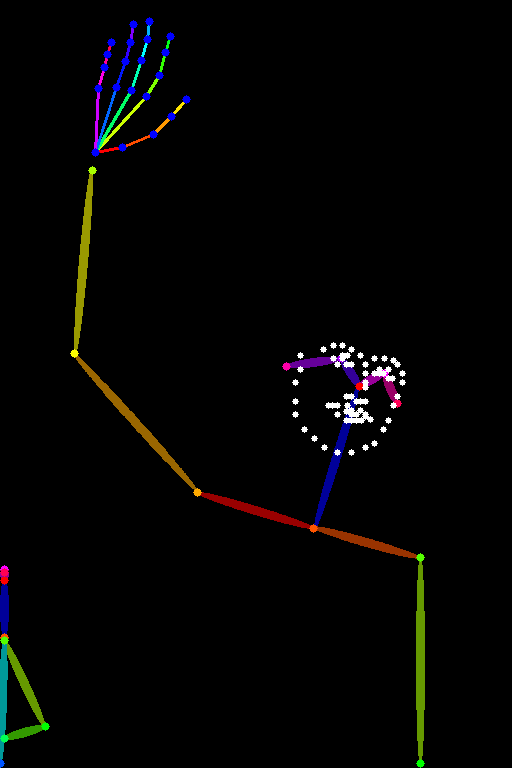

| 模型名称 | 控制图像概述 | 条件图像 | 控制图像示例 | 生成图像示例 |

|---|---|---|---|---|

| lllyasviel/control_v11p_sd15_canny |

使用 Canny 边缘检测进行训练 | 黑色背景上带有白色边缘的单色图像。 |  |

|

| lllyasviel/control_v11e_sd15_ip2p |

使用像素到像素指令进行训练 | 无条件。 |  |

|

| lllyasviel/control_v11p_sd15_inpaint |

使用图像修复进行训练 | 无条件。 |  |

|

| lllyasviel/control_v11p_sd15_mlsd |

使用多级线段检测进行训练 | 带有注释线段的图像。 |  |

|

| lllyasviel/control_v11f1p_sd15_depth |

使用深度估计进行训练 | 带有深度信息的图像,通常表示为灰度图像。 |  |

|

| lllyasviel/control_v11p_sd15_normalbae |

使用表面法线估计进行训练 | 带有表面法线信息的图像,通常表示为彩色编码图像。 |  |

|

| lllyasviel/control_v11p_sd15_seg |

使用图像分割进行训练 | 带有分割区域的图像,通常表示为彩色编码图像。 |  |

|

| lllyasviel/control_v11p_sd15_lineart |

使用线稿生成进行训练 | 带有线稿的图像,通常是白色背景上的黑色线条。 |  |

|

| lllyasviel/control_v11p_sd15s2_lineart_anime |

使用动漫线稿生成进行训练 | 带有动漫风格线稿的图像。 |  |

|

| lllyasviel/control_v11p_sd15_openpose |

使用人体姿态估计进行训练 | 带有人体姿态的图像,通常表示为一组关键点或骨架。 |  |

|

| lllyasviel/control_v11p_sd15_scribble |

使用基于涂鸦的图像生成进行训练 | 带有涂鸦的图像,通常是随机或用户绘制的笔触。 |  |

|

| lllyasviel/control_v11p_sd15_softedge |

使用软边缘图像生成进行训练 | 带有软边缘的图像,通常用于创建更具绘画风格或艺术效果的图像。 |  |

|

| lllyasviel/control_v11e_sd15_shuffle |

使用图像洗牌进行训练 | 带有洗牌补丁或区域的图像。 |  |

|

| lllyasviel/control_v11f1e_sd15_tile |

使用图像平铺进行训练 | 模糊图像或图像的一部分。 |  |

|

更多信息

更多信息,请参考 Diffusers ControlNet 博客文章 和 官方文档。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语