🚀 Mask2Former

Mask2Former 是一个在 COCO 全景分割任务上训练的模型(小尺寸版本,采用 Swin 骨干网络)。它由论文 Masked-attention Mask Transformer for Universal Image Segmentation 提出,并首次在 此仓库 中发布。该模型可用于图像分割领域,为图像分割任务提供了高效且准确的解决方案。

🚀 快速开始

Mask2Former 模型可直接用于全景分割任务。若你对其他微调版本感兴趣,可查看 模型中心。

以下是使用此模型的示例代码:

import requests

import torch

from PIL import Image

from transformers import AutoImageProcessor, Mask2FormerForUniversalSegmentation

processor = AutoImageProcessor.from_pretrained("facebook/mask2former-swin-small-coco-panoptic")

model = Mask2FormerForUniversalSegmentation.from_pretrained("facebook/mask2former-swin-small-coco-panoptic")

url = "http://images.cocodataset.org/val2017/000000039769.jpg"

image = Image.open(requests.get(url, stream=True).raw)

inputs = processor(images=image, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

class_queries_logits = outputs.class_queries_logits

masks_queries_logits = outputs.masks_queries_logits

result = processor.post_process_panoptic_segmentation(outputs, target_sizes=[image.size[::-1]])[0]

predicted_panoptic_map = result["segmentation"]

更多代码示例可参考 文档。

✨ 主要特性

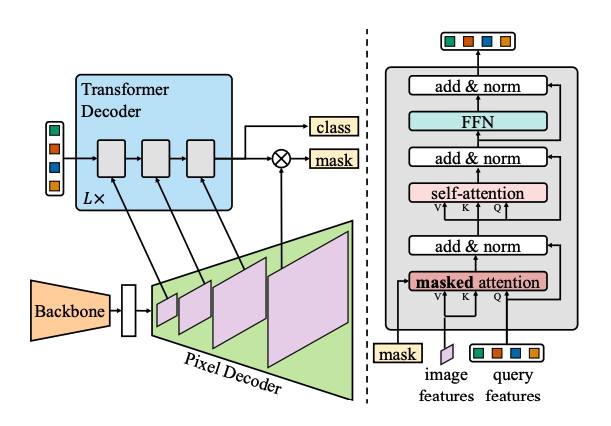

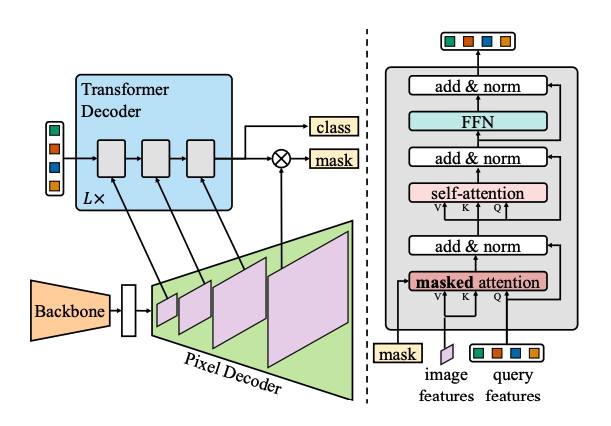

Mask2Former 采用相同的范式处理实例分割、语义分割和全景分割任务,即通过预测一组掩码和相应的标签来完成。因此,这三个任务都被视为实例分割任务。与之前的最优模型 MaskFormer 相比,Mask2Former 在性能和效率上都更胜一筹,主要体现在以下几个方面:

- 用更先进的多尺度可变形注意力 Transformer 取代像素解码器;

- 采用带有掩码注意力的 Transformer 解码器,在不增加额外计算量的情况下提升性能;

- 通过在子采样点上计算损失而非整个掩码,提高训练效率。

📚 详细文档

模型描述

Mask2Former 以统一的方式处理实例、语义和全景分割任务,通过预测一组掩码和对应的标签来完成。它将这三个任务都当作实例分割任务处理。与之前的 SOTA 模型 MaskFormer 相比,Mask2Former 在性能和效率上都有显著提升,具体改进如下:

- 用更先进的多尺度可变形注意力 Transformer 替换像素解码器;

- 采用带有掩码注意力的 Transformer 解码器,在不增加额外计算的情况下提升性能;

- 通过在子采样点上计算损失而非整个掩码,提高训练效率。

预期用途和限制

此特定检查点可用于全景分割任务。若你对其他微调版本感兴趣,可查看 模型中心。

📄 许可证

本模型使用其他许可证。

信息表格

免责声明

发布 Mask2Former 的团队并未为此模型编写模型卡片,此模型卡片由 Hugging Face 团队编写。

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语