🚀 AnimateDiff-Lightning

AnimateDiff-Lightning是一款闪电般快速的文本到视频生成模型,它生成视频的速度比原始的AnimateDiff快十倍以上。本模型作为研究成果发布,更多信息请参考我们的研究论文:AnimateDiff-Lightning: Cross-Model Diffusion Distillation。

🚀 快速开始

你可以通过以下方式快速体验AnimateDiff-Lightning:

- 试用我们的文本到视频生成演示。

- 按照下文的使用示例进行操作。

✨ 主要特性

- 高速生成:相比原始的AnimateDiff,生成视频的速度快十倍以上。

- 多步选择:提供1步、2步、4步和8步蒸馏模型的检查点。

- 高质量输出:2步、4步和8步模型的生成质量出色。

- 广泛适配:与多种风格化基础模型兼容,适用于不同场景。

📦 安装指南

本模型的使用依赖于一些Python库,你可以通过以下命令安装:

pip install diffusers torch safetensors huggingface_hub

💻 使用示例

基础用法

以下是使用Diffusers库调用AnimateDiff-Lightning的示例代码:

import torch

from diffusers import AnimateDiffPipeline, MotionAdapter, EulerDiscreteScheduler

from diffusers.utils import export_to_gif

from huggingface_hub import hf_hub_download

from safetensors.torch import load_file

device = "cuda"

dtype = torch.float16

step = 4

repo = "ByteDance/AnimateDiff-Lightning"

ckpt = f"animatediff_lightning_{step}step_diffusers.safetensors"

base = "emilianJR/epiCRealism"

adapter = MotionAdapter().to(device, dtype)

adapter.load_state_dict(load_file(hf_hub_download(repo ,ckpt), device=device))

pipe = AnimateDiffPipeline.from_pretrained(base, motion_adapter=adapter, torch_dtype=dtype).to(device)

pipe.scheduler = EulerDiscreteScheduler.from_config(pipe.scheduler.config, timestep_spacing="trailing", beta_schedule="linear")

output = pipe(prompt="A girl smiling", guidance_scale=1.0, num_inference_steps=step)

export_to_gif(output.frames[0], "animation.gif")

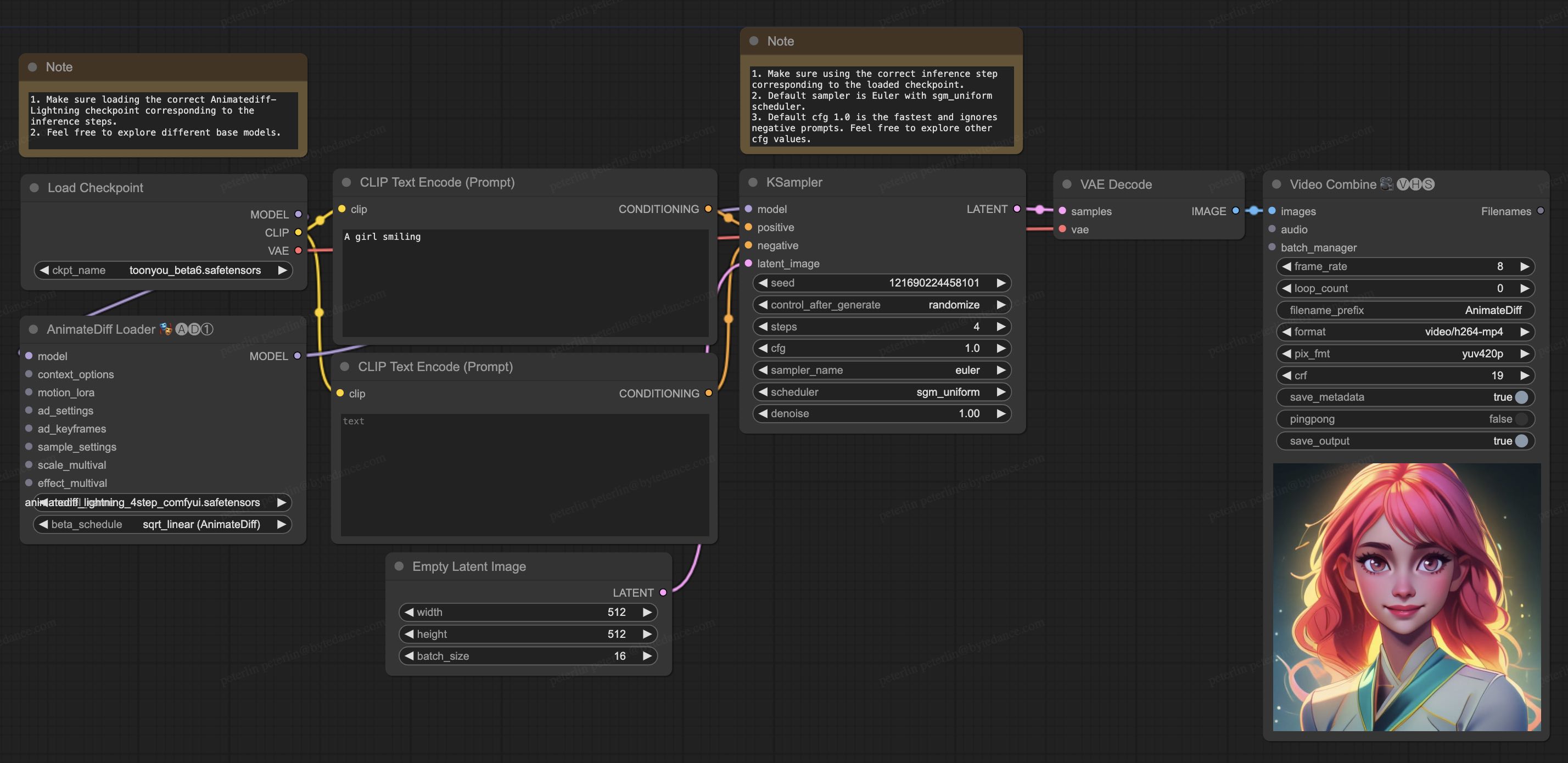

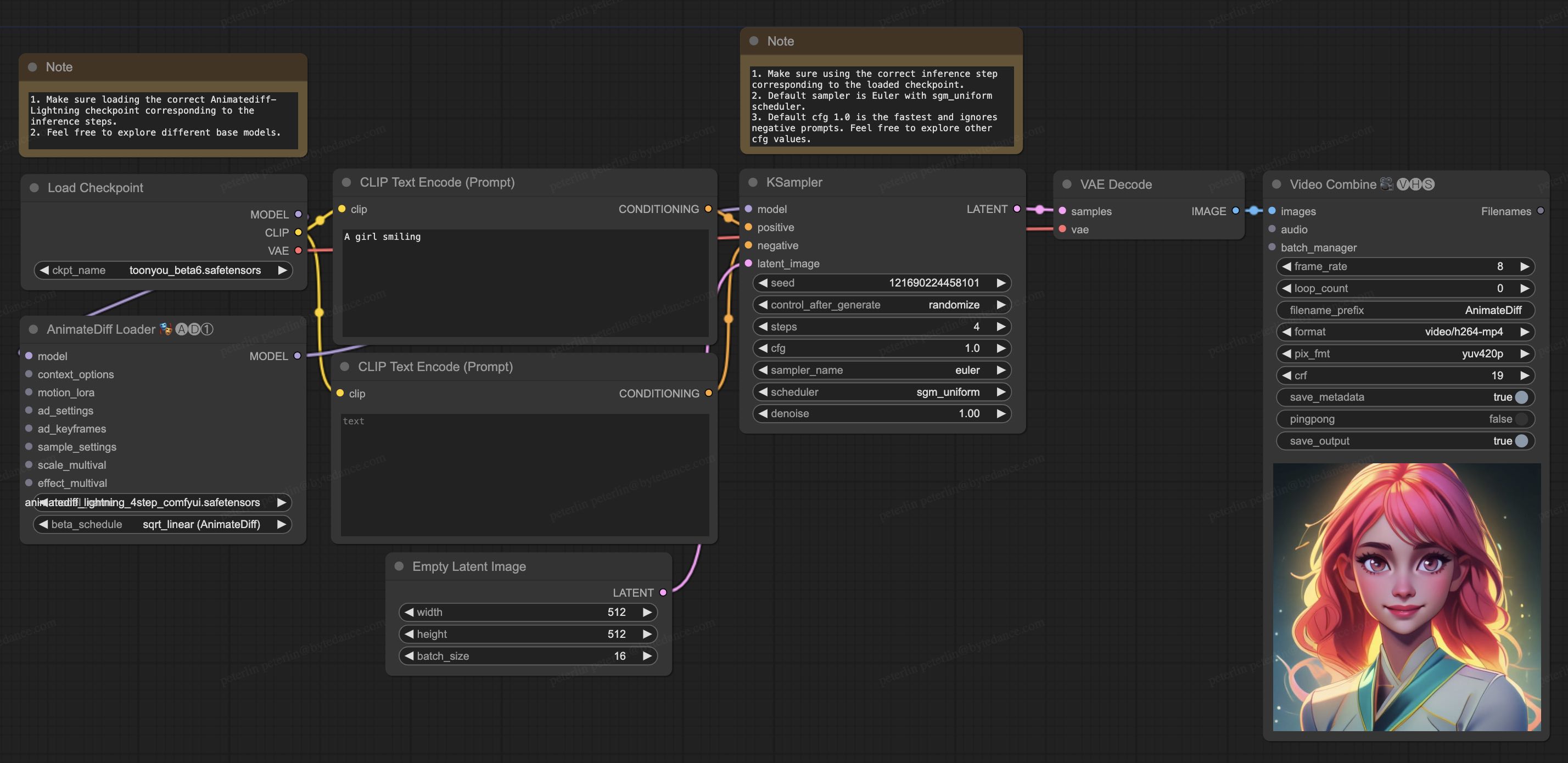

ComfyUI使用方法

- 下载animatediff_lightning_workflow.json并在ComfyUI中导入。

- 安装节点。你可以手动安装或使用ComfyUI-Manager:

- 下载你喜欢的基础模型检查点并将其放在

/models/checkpoints/目录下。

- 下载AnimateDiff-Lightning检查点

animatediff_lightning_Nstep_comfyui.safetensors并将其放在/custom_nodes/ComfyUI-AnimateDiff-Evolved/models/目录下。

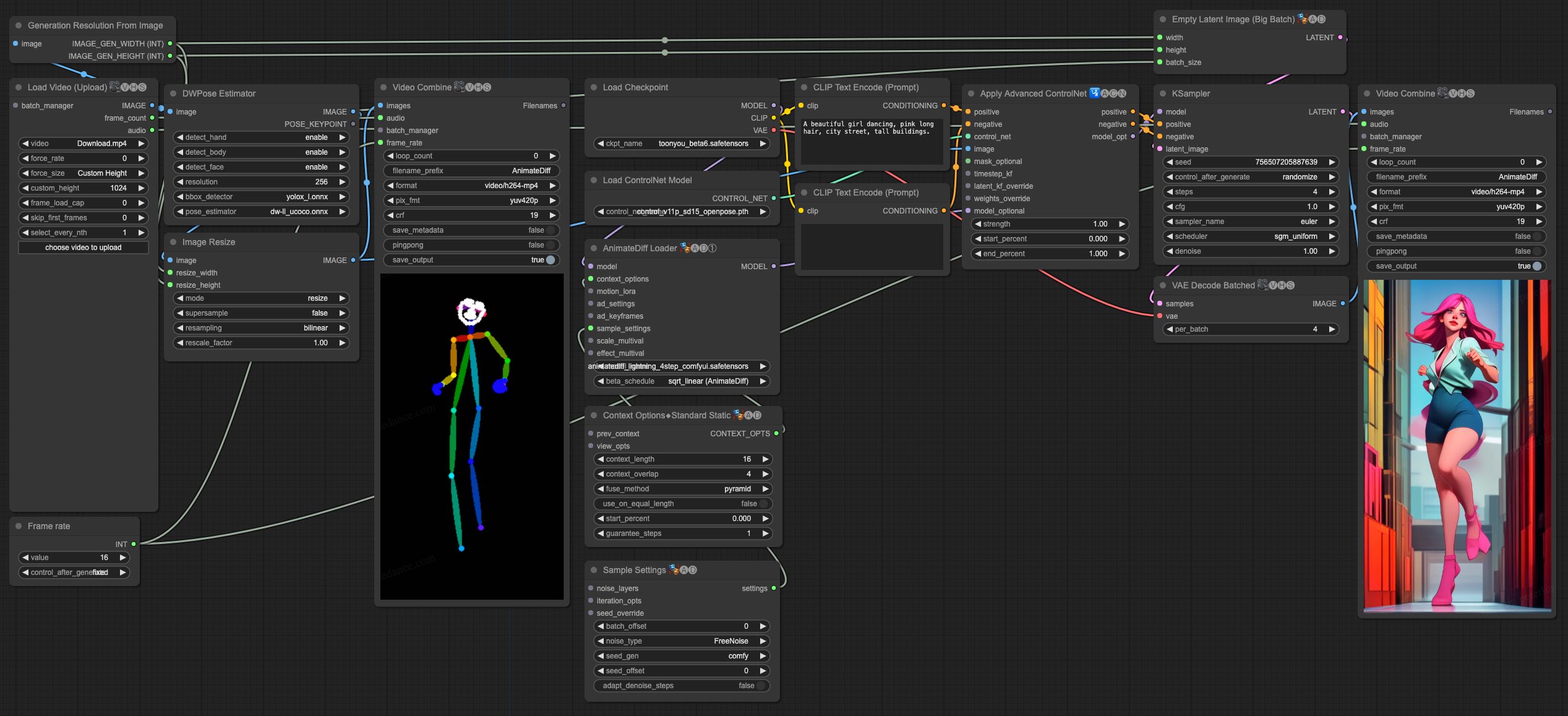

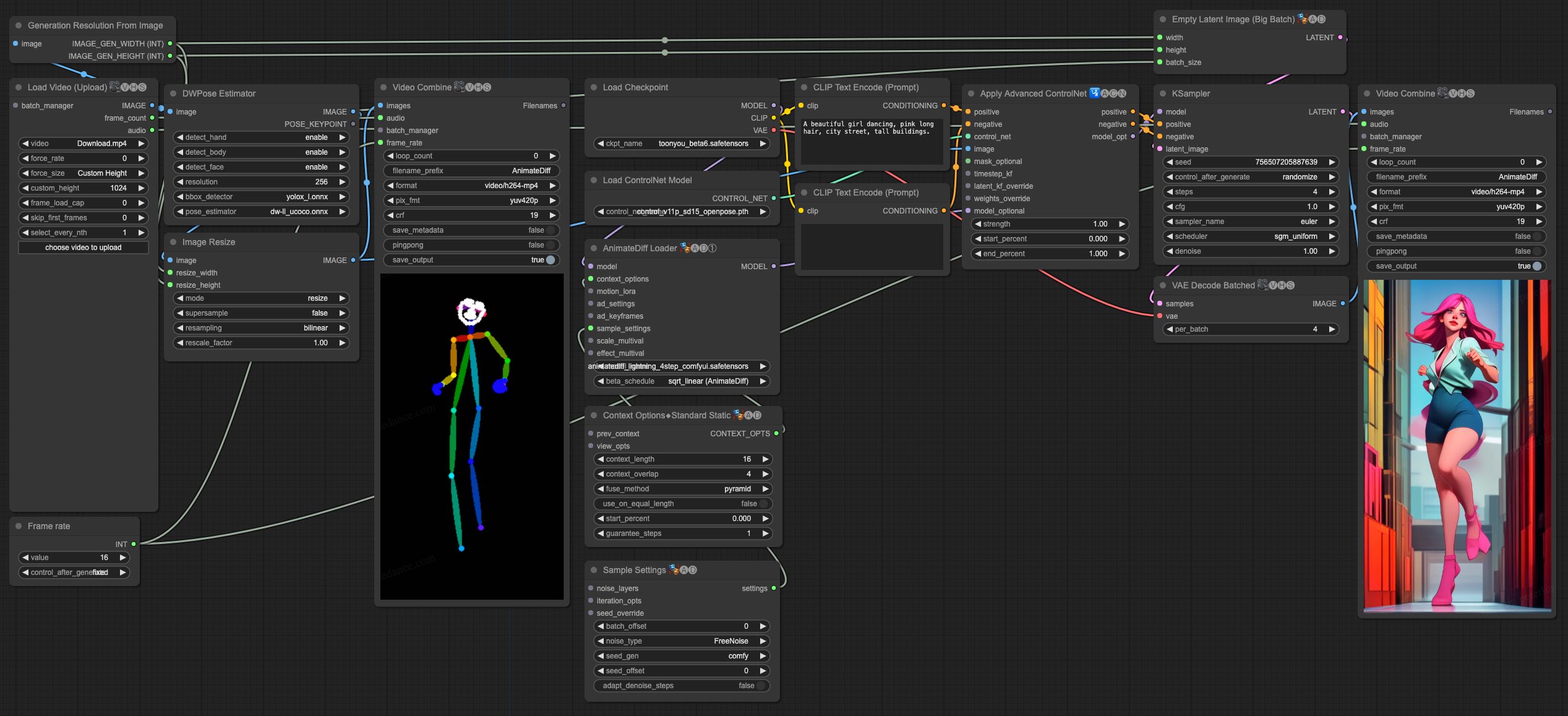

视频到视频生成

AnimateDiff-Lightning在视频到视频生成方面表现出色。以下是使用ControlNet的简单ComfyUI工作流程:

- 下载animatediff_lightning_v2v_openpose_workflow.json并在ComfyUI中导入。

- 安装节点。你可以手动安装或使用ComfyUI-Manager:

- 下载你喜欢的基础模型检查点并将其放在

/models/checkpoints/目录下。

- 下载AnimateDiff-Lightning检查点

animatediff_lightning_Nstep_comfyui.safetensors并将其放在/custom_nodes/ComfyUI-AnimateDiff-Evolved/models/目录下。

- 下载ControlNet OpenPose

control_v11p_sd15_openpose.pth检查点到/models/controlnet/目录下。

- 上传你的视频并运行管道。

额外注意事项

- 视频不应过长或分辨率过高。我们使用576x1024、8秒、30fps的视频进行测试。

- 设置帧率以匹配输入视频,这样可以使音频与输出视频匹配。

- DWPose在首次运行时会自行下载检查点。

- DWPose可能会在UI中卡住,但管道实际上仍在后台运行。请检查ComfyUI日志和输出文件夹。

📚 详细文档

推荐基础模型

AnimateDiff-Lightning与风格化基础模型配合使用时效果最佳。我们推荐使用以下基础模型:

写实风格

动漫与卡通风格

使用建议

- 尝试不同的设置。我们发现2步模型使用3次推理步骤可以产生很好的效果。

- 某些基础模型与CFG配合使用效果更好。

- 推荐使用Motion LoRAs,它们可以产生更强的运动效果。我们使用强度为0.7~0.8的Motion LoRAs以避免水印。

📄 许可证

本项目采用creativeml-openrail-m许可证。

🔖 引用

如果您使用了本项目的成果,请引用以下论文:

@misc{lin2024animatedifflightning,

title={AnimateDiff-Lightning: Cross-Model Diffusion Distillation},

author={Shanchuan Lin and Xiao Yang},

year={2024},

eprint={2403.12706},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语 Transformers 英语

Transformers 英语