🚀 AnimateDiff-Lightning

AnimateDiff-Lightningは、超高速なテキストから動画を生成するモデルです。元のAnimateDiffよりも10倍以上高速に動画を生成することができます。詳細については、当社の研究論文AnimateDiff-Lightning: Cross-Model Diffusion Distillationを参照してください。本モデルは研究の一環として公開されています。

🚀 クイックスタート

AnimateDiff-Lightningは、スタイル化されたベースモデルと組み合わせて使用すると、最良の結果を得ることができます。以下のベースモデルの使用をおすすめします。

リアリスティック

アニメ&カートゥーン

また、さまざまな設定を自由に試してみることをおすすめします。2ステップモデルで3回の推論ステップを使用すると、素晴らしい結果が得られることがわかっています。特定のベースモデルでは、CFGを使用するとより良い結果が得られます。また、Motion LoRAsを使用すると、より強力なモーションが得られるため、おすすめです。ウォーターマークを避けるために、強度0.7~0.8のMotion LoRAsを使用しています。

✨ 主な機能

- 超高速なテキストから動画への生成

- 元のAnimateDiffよりも10倍以上高速な動画生成

- 1ステップ、2ステップ、4ステップ、8ステップの蒸留モデルのチェックポイントを提供

- 動画から動画への生成にも優れた性能を発揮

📦 インストール

このセクションでは、DiffusersとComfyUIを使用したAnimateDiff-Lightningのインストール方法を説明します。

Diffusersを使用したインストール

import torch

from diffusers import AnimateDiffPipeline, MotionAdapter, EulerDiscreteScheduler

from diffusers.utils import export_to_gif

from huggingface_hub import hf_hub_download

from safetensors.torch import load_file

device = "cuda"

dtype = torch.float16

step = 4

repo = "ByteDance/AnimateDiff-Lightning"

ckpt = f"animatediff_lightning_{step}step_diffusers.safetensors"

base = "emilianJR/epiCRealism"

adapter = MotionAdapter().to(device, dtype)

adapter.load_state_dict(load_file(hf_hub_download(repo ,ckpt), device=device))

pipe = AnimateDiffPipeline.from_pretrained(base, motion_adapter=adapter, torch_dtype=dtype).to(device)

pipe.scheduler = EulerDiscreteScheduler.from_config(pipe.scheduler.config, timestep_spacing="trailing", beta_schedule="linear")

output = pipe(prompt="A girl smiling", guidance_scale=1.0, num_inference_steps=step)

export_to_gif(output.frames[0], "animation.gif")

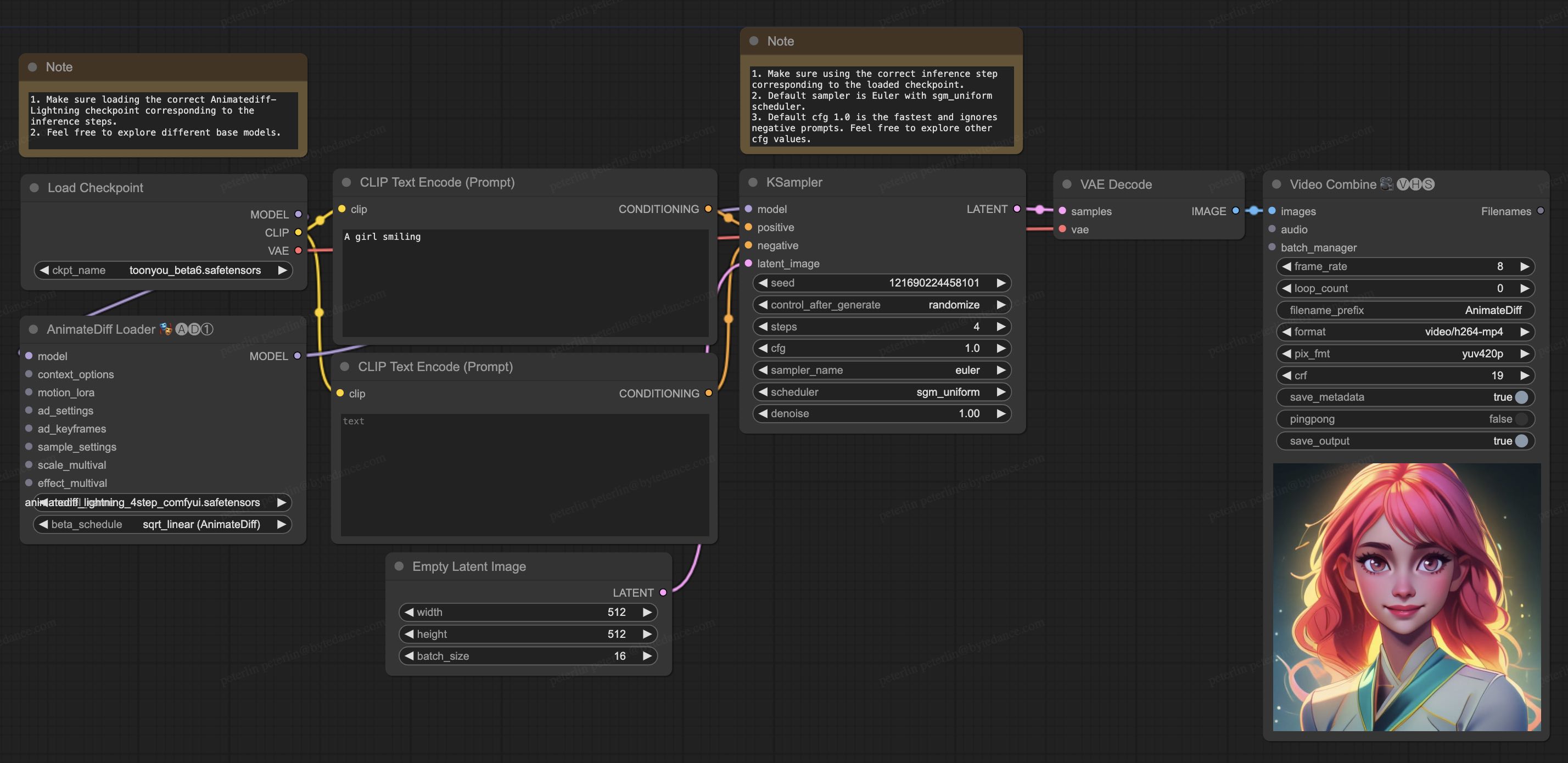

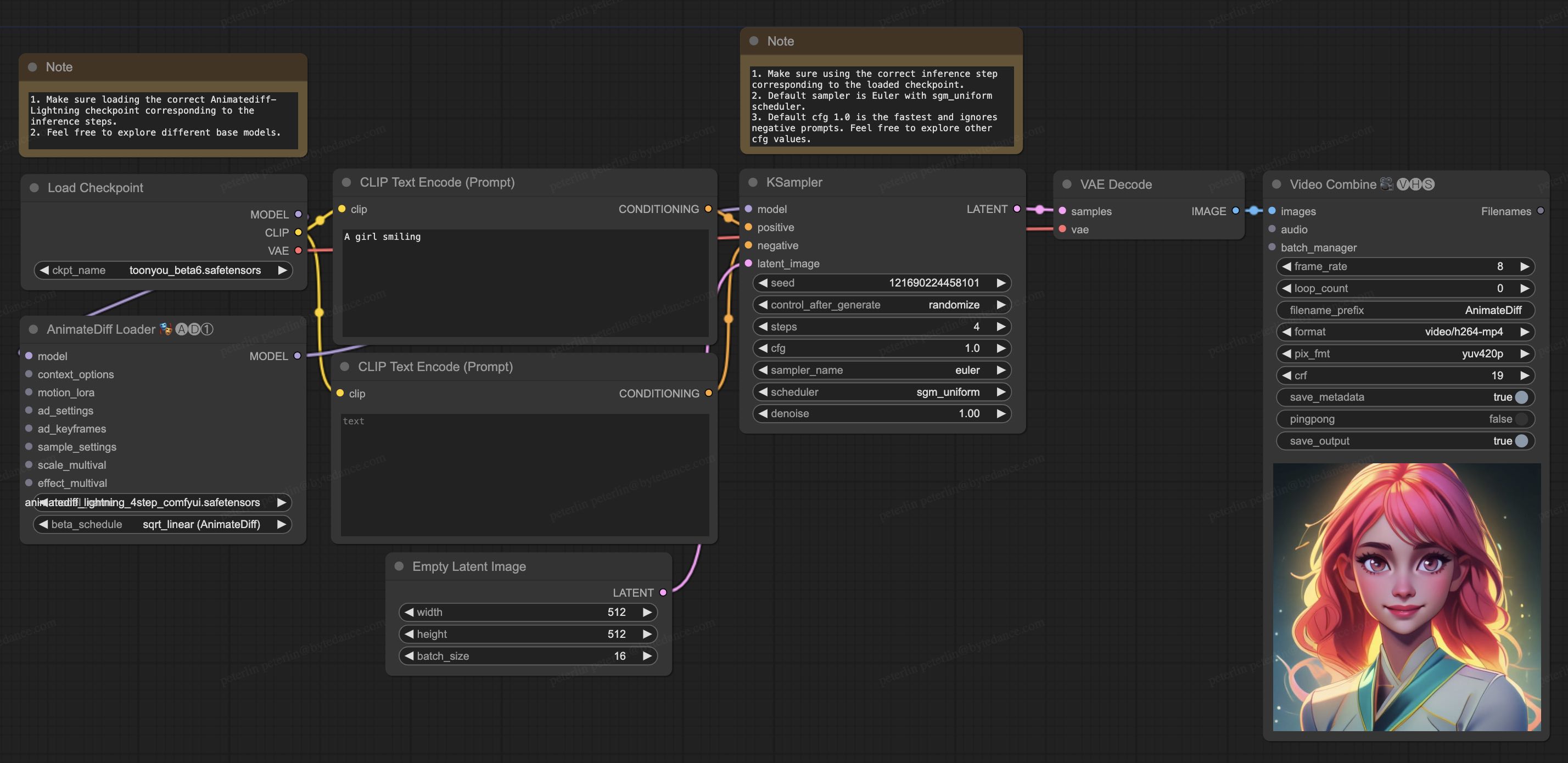

ComfyUIを使用したインストール

- animatediff_lightning_workflow.jsonをダウンロードし、ComfyUIにインポートします。

- ノードをインストールします。手動でインストールすることも、ComfyUI-Managerを使用することもできます。

- 好きなベースモデルのチェックポイントをダウンロードし、

/models/checkpoints/に配置します。

- AnimateDiff-Lightningのチェックポイント

animatediff_lightning_Nstep_comfyui.safetensorsをダウンロードし、/custom_nodes/ComfyUI-AnimateDiff-Evolved/models/に配置します。

💻 使用例

テキストから動画への生成

上記のDiffusersのコード例を参照してください。

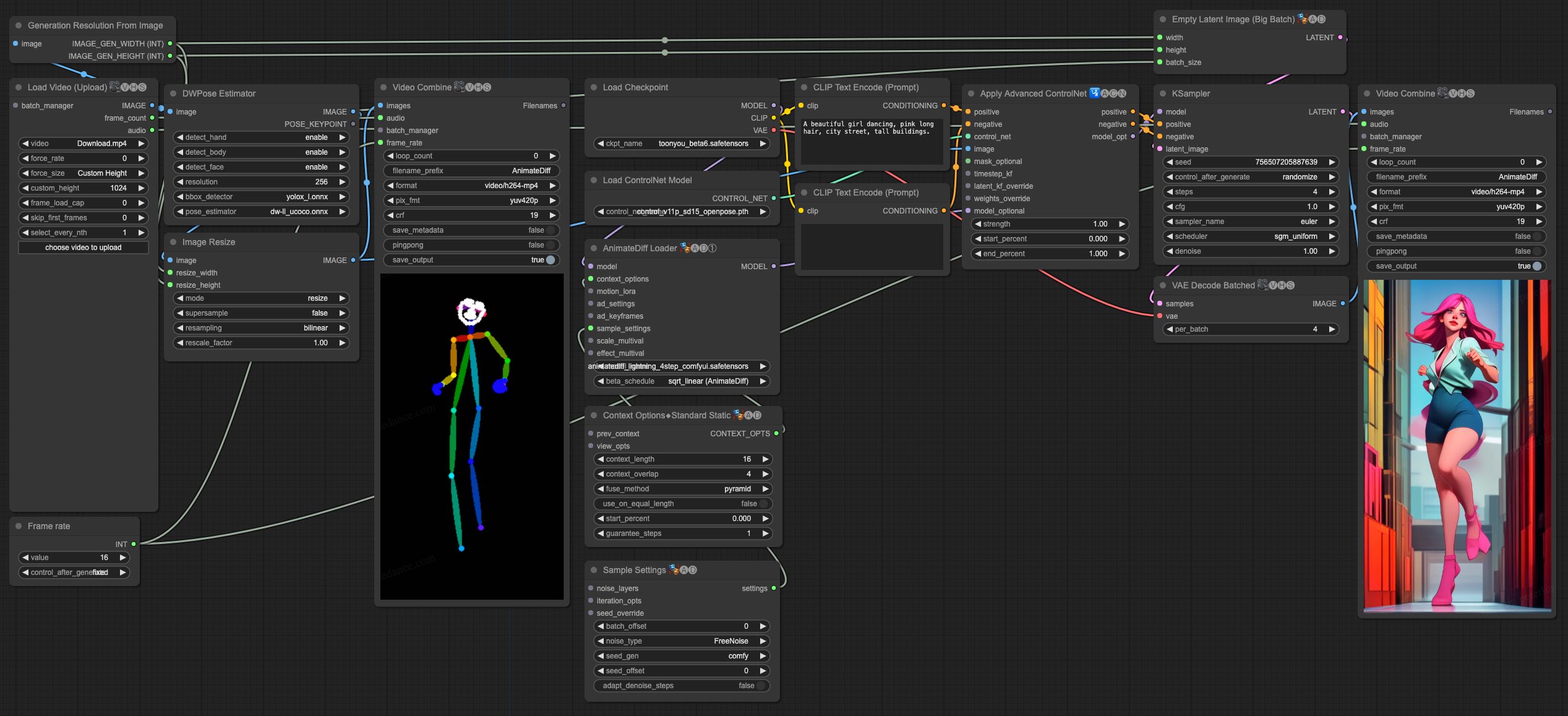

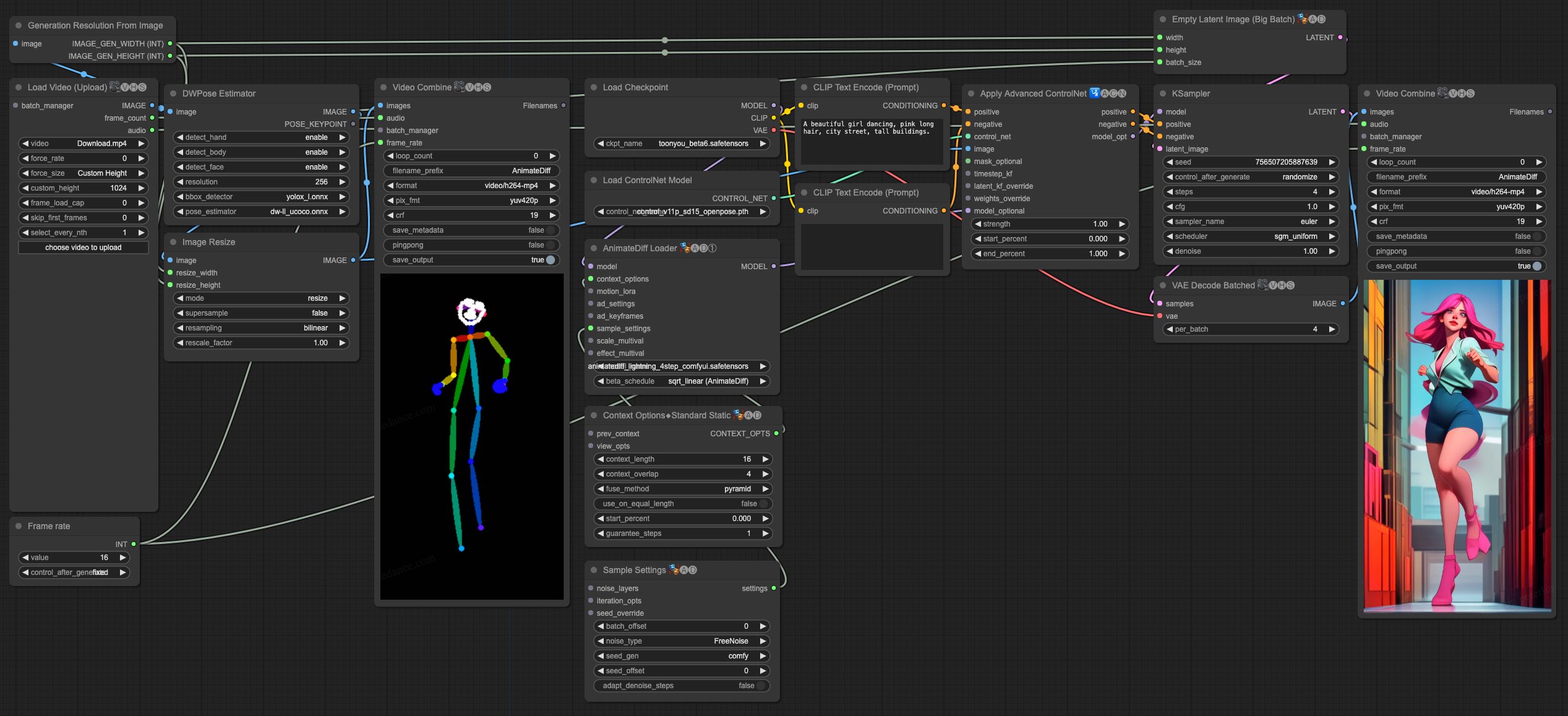

動画から動画への生成

AnimateDiff-Lightningは、動画から動画への生成にも優れた性能を発揮します。ControlNetを使用した最もシンプルなComfyUIワークフローを提供しています。

- animatediff_lightning_v2v_openpose_workflow.jsonをダウンロードし、ComfyUIにインポートします。

- ノードをインストールします。手動でインストールすることも、ComfyUI-Managerを使用することもできます。

- 好きなベースモデルのチェックポイントをダウンロードし、

/models/checkpoints/に配置します。

- AnimateDiff-Lightningのチェックポイント

animatediff_lightning_Nstep_comfyui.safetensorsをダウンロードし、/custom_nodes/ComfyUI-AnimateDiff-Evolved/models/に配置します。

- ControlNet OpenPoseの

control_v11p_sd15_openpose.pthチェックポイントを/models/controlnet/にダウンロードします。

- 動画をアップロードし、パイプラインを実行します。

追加注意事項

- 動画はあまり長く、または解像度が高すぎないようにしてください。テストには、576x1024、8秒、30fpsの動画を使用しています。

- フレームレートを入力動画に合わせて設定してください。これにより、オーディオが出力動画と一致します。

- DWPoseは初回実行時に自動的にチェックポイントをダウンロードします。

- DWPoseはUIで停止することがありますが、実際にはパイプラインはバックグラウンドで実行されています。ComfyUIのログと出力フォルダを確認してください。

📄 ライセンス

このモデルは、CreativeML OpenRAIL-Mライセンスの下で公開されています。

📚 ドキュメント

詳細については、当社の研究論文AnimateDiff-Lightning: Cross-Model Diffusion Distillationを参照してください。

📖 引用

@misc{lin2024animatedifflightning,

title={AnimateDiff-Lightning: Cross-Model Diffusion Distillation},

author={Shanchuan Lin and Xiao Yang},

year={2024},

eprint={2403.12706},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

💡 使用アドバイス

- スタイル化されたベースモデルを使用すると、より良い結果が得られます。

- 2ステップモデルで3回の推論ステップを使用すると、素晴らしい結果が得られます。

- 特定のベースモデルでは、CFGを使用するとより良い結果が得られます。

- Motion LoRAsを使用すると、より強力なモーションが得られます。

- ウォーターマークを避けるために、強度0.7~0.8のMotion LoRAsを使用してください。

⚠️ 重要な注意事項

- 動画はあまり長く、または解像度が高すぎないようにしてください。

- フレームレートを入力動画に合わせて設定してください。

- DWPoseは初回実行時に自動的にチェックポイントをダウンロードします。

- DWPoseはUIで停止することがありますが、実際にはパイプラインはバックグラウンドで実行されています。ComfyUIのログと出力フォルダを確認してください。

Transformers 複数言語対応

Transformers 複数言語対応 Transformers 複数言語対応

Transformers 複数言語対応 Transformers 英語

Transformers 英語 Transformers 英語

Transformers 英語