Yi 34B

Yi-34B-Chat是由01.AI训练的新一代开源双语大语言模型,在语言理解、常识推理、阅读理解等方面表现卓越,是全球最强大的LLM之一。

下载量 3,738

发布时间 : 11/1/2023

模型简介

Yi-34B-Chat是基于3T多语言语料训练的双语优化语言模型,支持中英文,在多项基准测试中表现优异。

模型特点

双语优化

专门针对中英文优化的语言模型,在双语环境下表现卓越

高性能

在AlpacaEval排行榜上仅次于GPT-4 Turbo,超越其他主流LLM

开源

完全开源,采用Apache-2.0许可证

长文本处理

支持200K上下文长度,在长文本任务中表现优异

模型能力

文本生成

对话交互

常识推理

阅读理解

指令遵循

使用案例

智能助手

客服对话

用于构建智能客服系统,处理用户咨询

能够理解复杂问题并提供准确回答

内容创作

文章写作

辅助进行中英文内容创作

生成流畅、连贯的文本内容

教育

学习辅导

作为学习助手解答学生问题

提供准确的知识解释和推理过程

🚀 零一万物大模型 Yi

零一万物大模型 Yi 是由 01.AI 从头开始训练的下一代开源大语言模型。它以双语语言模型为目标,在 3T 多语言语料上进行训练,在语言理解、常识推理、阅读理解等方面表现出色,是全球最强大的大语言模型之一。

🚀 快速开始

💡 提示:如果您想开始使用 Yi 模型并探索不同的推理方法,请查看 Yi 手册。

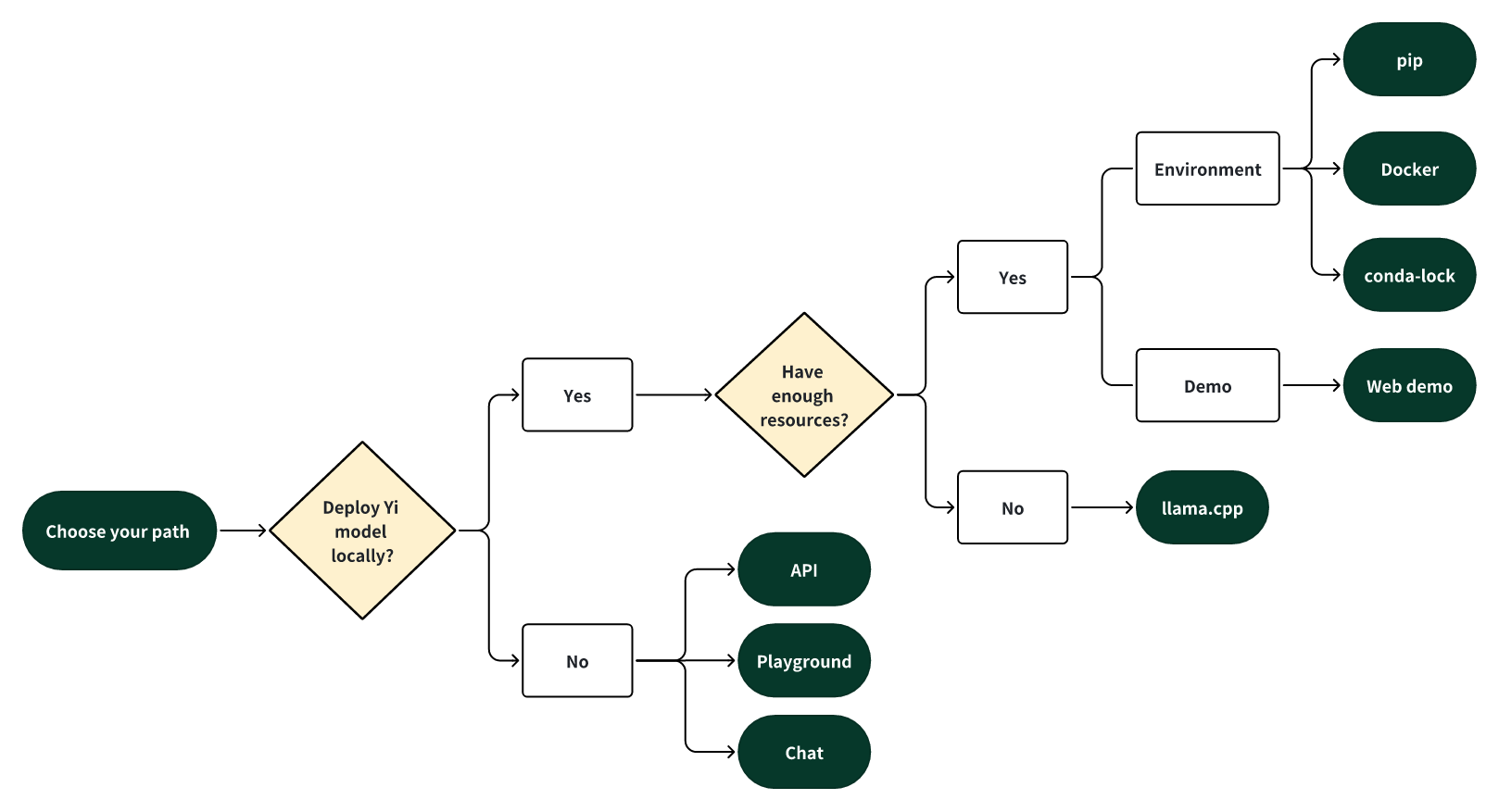

选择路径

选择以下路径之一开启您的 Yi 之旅!

🎯 本地部署 Yi

如果您想在本地部署 Yi 模型,

- 🙋♀️ 并且您有充足的资源(例如,NVIDIA A800 80GB),您可以选择以下方法之一:

- 🙋♀️ 并且您的资源有限(例如,MacBook Pro),您可以使用 llama.cpp 安装。

🎯 不进行本地部署

如果您不想在本地部署 Yi 模型,您可以通过以下任何选项探索 Yi 的功能。

-

🙋♀️ 使用 API 运行 Yi 如果您想探索 Yi 的更多功能,可以采用以下方法之一:

-

🙋♀️ 在 playground 中运行 Yi 如果您想通过更多可定制选项(例如系统提示、温度、重复惩罚等)与 Yi 聊天,可以尝试以下选项之一:

- Yi-34B-Chat-Playground(Yi 官方):通过白名单访问,欢迎申请(填写英文或中文表格)。

💻 使用示例

基础用法

# 以下是使用 pip 进行推理的示例代码

from transformers import AutoModelForCausalLM, AutoTokenizer

model_path = '<your-model-path>'

tokenizer = AutoTokenizer.from_pretrained(model_path, use_fast=False)

# 从 transformers 4.35.0 版本开始,可以使用 AutoModelForCausalLM 加载 GPT-Q/AWQ 模型

model = AutoModelForCausalLM.from_pretrained(

model_path,

device_map="auto",

torch_dtype='auto'

).eval()

# 提示内容:"hi"

messages = [

{"role": "user", "content": "hi"}

]

input_ids = tokenizer.apply_chat_template(conversation=messages, tokenize=True, add_generation_prompt=True, return_tensors='pt')

output_ids = model.generate(input_ids.to('cuda'))

response = tokenizer.decode(output_ids[0][input_ids.shape[1]:], skip_special_tokens=True)

# 模型响应:"Hello! How can I assist you today?"

print(response)

高级用法

# 以下是使用 Docker 进行推理的示例命令

docker run -it --gpus all \

-v <your-model-path>:/models

ghcr.io/01-ai/yi:latest

✨ 主要特性

- 强大性能:Yi-34B-Chat 模型在 AlpacaEval 排行榜上排名第二(仅次于 GPT-4 Turbo),超越了其他大语言模型(如 GPT-4、Mixtral、Claude)。Yi-34B 模型在多个基准测试中,包括 Hugging Face Open LLM 排行榜(预训练)和 C-Eval,在英语和中文方面均排名第一,超越了所有现有开源模型(如 Falcon-180B、Llama-70B、Claude)。

- 架构优势:Yi 系列模型采用与 Llama 相同的模型架构,但并非 Llama 的衍生模型。它独立创建了自己的高质量训练数据集、高效训练管道和强大训练基础设施,性能优异。

- 全面生态:拥有全面的生态系统,提供一系列工具、服务和模型,包括上游可利用 Llama 生态系统的现有资源,下游有服务、量化、微调、API 等多种应用。

📦 安装指南

pip 安装

git clone https://github.com/01-ai/Yi.git

cd yi

pip install -r requirements.txt

Docker 安装

docker run -it --gpus all \

-v <your-model-path>:/models

ghcr.io/01-ai/yi:latest

conda-lock 安装

micromamba install -y -n yi -f conda-lock.yml

llama.cpp 安装

git clone git@github.com:ggerganov/llama.cpp.git

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/XeIaso/yi-chat-6B-GGUF

git-lfs pull --include yi-chat-6b.Q2_K.gguf

📚 详细文档

模型信息

| 属性 | 详情 |

|---|---|

| 模型类型 | 包括聊天模型和基础模型,有 6B、9B、34B 等不同尺寸 |

| 训练数据 | 3T 多语言语料,其中 Yi-9B 基于 Yi-6B 继续训练,使用 0.8T 令牌 |

| 默认上下文窗口 | 4K(部分模型可扩展) |

| 预训练令牌 | 3T(Yi-9B 基于 Yi-6B 继续训练使用 0.8T 令牌) |

| 训练数据日期 | 截至 2023 年 6 月 |

常见问题解答

如果您在使用 Yi 系列模型时遇到任何问题,以下答案可能会对您有所帮助。 ⬇️

💡 微调相关

- 基础模型还是聊天模型 - 选择哪个进行微调?

选择用于微调的预训练语言模型取决于您可用的计算资源和任务的特定需求。

- 如果您有大量的微调数据(例如,超过 10,000 个样本),基础模型可能是您的首选。

- 如果您的微调数据不是很多,选择聊天模型可能更合适。

- 通常建议同时微调基础模型和聊天模型,比较它们的性能,然后选择最符合您特定需求的模型。

- 全量微调 Yi-34B 和 Yi-34B-Chat 有什么区别?

Yi-34B和Yi-34B-Chat全量微调的关键区别在于微调方法和结果。- Yi-34B-Chat 采用特殊微调(SFT)方法,生成的响应更接近人类对话风格。

- 基础模型的微调更具通用性,性能潜力相对较高。

- 如果您对数据质量有信心,可以选择使用

Yi-34B进行微调。 - 如果您希望模型生成的响应更能模仿人类对话风格,或者对数据质量有疑虑,

Yi-34B-Chat可能是您的最佳选择。

💡 量化相关

- 量化模型与原始模型的性能差距是多少? 性能差异在很大程度上取决于所采用的量化方法和这些模型的具体用例。例如,从基准测试的角度来看,对于 AWQ 官方提供的模型,量化可能会导致几个百分点的轻微性能下降。 从主观上来说,在逻辑推理等情况下,即使 1% 的性能变化也可能影响输出结果的准确性。

💡 通用相关

- 在哪里可以获取微调问答数据集? 您可以在 Hugging Face 等平台上找到微调问答数据集,例如 m-a-p/COIG-CQIA。此外,Github 提供了微调框架,如 hiyouga/LLaMA-Factory,其中集成了预建的数据集。

- 微调 Yi-34B FP16 需要多少 GPU 内存? 微调 34B FP16 所需的 GPU 内存取决于所采用的具体微调方法。对于全参数微调,您需要 8 个每个 80GB 的 GPU;然而,像 Lora 这样更经济的解决方案需要的内存较少。更多详细信息,请查看 hiyouga/LLaMA-Factory。此外,考虑使用 BF16 而不是 FP16 进行微调以优化性能。

- 是否有支持 Yi-34b-200k 模型聊天功能的第三方平台? 如果您正在寻找第三方聊天平台,选项包括 fireworks.ai。

🔧 技术细节

模型架构

Yi 系列模型采用与 Llama 相同的模型架构,但并非 Llama 的衍生模型。它基于 Transformer 结构,利用了 Llama 架构的稳定性、收敛性和兼容性等优点,但通过独立创建的高质量训练数据集、高效训练管道和强大训练基础设施,实现了出色的性能。

训练过程

在 3T 多语言语料上进行训练,其中 Yi-9B 基于 Yi-6B 继续训练,使用 0.8T 令牌。训练过程中使用数据合规检查算法,以确保训练模型的合规性,但由于数据复杂和语言模型使用场景的多样性,不能保证模型在所有场景下都能生成正确、合理的输出。

量化方法

支持 GPT-Q 和 AWQ 两种量化方法:

python quantization/gptq/quant_autogptq.py \

--model /base_model \

--output_dir /quantized_model \

--trust_remote_code

- AWQ:使用 AutoAWQ 进行量化,是一种高效准确的低比特权重量化方法(INT3/4)。

python quantization/awq/quant_autoawq.py \

--model /base_model \

--output_dir /quantized_model \

--trust_remote_code

📄 许可证

Yi 系列模型的代码和权重根据 Apache 2.0 许可证 分发,这意味着 Yi 系列模型可免费用于个人使用、学术目的和商业用途。如果您基于此模型创建衍生作品,请在衍生作品中包含以下归属声明:

This work is a derivative of [The Yi Series Model You Base On] by 01.AI, used under the Apache 2.0 License.

Phi 2 GGUF

其他

Phi-2是微软开发的一个小型但强大的语言模型,具有27亿参数,专注于高效推理和高质量文本生成。

大型语言模型 支持多种语言

P

TheBloke

41.5M

205

Roberta Large

MIT

基于掩码语言建模目标预训练的大型英语语言模型,采用改进的BERT训练方法

大型语言模型 英语

R

FacebookAI

19.4M

212

Distilbert Base Uncased

Apache-2.0

DistilBERT是BERT基础模型的蒸馏版本,在保持相近性能的同时更轻量高效,适用于序列分类、标记分类等自然语言处理任务。

大型语言模型 英语

D

distilbert

11.1M

669

Llama 3.1 8B Instruct GGUF

Meta Llama 3.1 8B Instruct 是一个多语言大语言模型,针对多语言对话用例进行了优化,在常见的行业基准测试中表现优异。

大型语言模型 英语

L

modularai

9.7M

4

Xlm Roberta Base

MIT

XLM-RoBERTa是基于100种语言的2.5TB过滤CommonCrawl数据预训练的多语言模型,采用掩码语言建模目标进行训练。

大型语言模型 支持多种语言

X

FacebookAI

9.6M

664

Roberta Base

MIT

基于Transformer架构的英语预训练模型,通过掩码语言建模目标在海量文本上训练,支持文本特征提取和下游任务微调

大型语言模型 英语

R

FacebookAI

9.3M

488

Opt 125m

其他

OPT是由Meta AI发布的开放预训练Transformer语言模型套件,参数量从1.25亿到1750亿,旨在对标GPT-3系列性能,同时促进大规模语言模型的开放研究。

大型语言模型 英语

O

facebook

6.3M

198

1

基于transformers库的预训练模型,适用于多种NLP任务

大型语言模型 Transformers

Transformers

Transformers

Transformers1

unslothai

6.2M

1

Llama 3.1 8B Instruct

Llama 3.1是Meta推出的多语言大语言模型系列,包含8B、70B和405B参数规模,支持8种语言和代码生成,优化了多语言对话场景。

大型语言模型 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言L

meta-llama

5.7M

3,898

T5 Base

Apache-2.0

T5基础版是由Google开发的文本到文本转换Transformer模型,参数规模2.2亿,支持多语言NLP任务。

大型语言模型 支持多种语言

T

google-t5

5.4M

702

精选推荐AI模型

Llama 3 Typhoon V1.5x 8b Instruct

专为泰语设计的80亿参数指令模型,性能媲美GPT-3.5-turbo,优化了应用场景、检索增强生成、受限生成和推理任务

大型语言模型 Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言

Transformers 支持多种语言L

scb10x

3,269

16

Cadet Tiny

Openrail

Cadet-Tiny是一个基于SODA数据集训练的超小型对话模型,专为边缘设备推理设计,体积仅为Cosmo-3B模型的2%左右。

对话系统 Transformers 英语

Transformers 英语

Transformers 英语

Transformers 英语C

ToddGoldfarb

2,691

6

Roberta Base Chinese Extractive Qa

基于RoBERTa架构的中文抽取式问答模型,适用于从给定文本中提取答案的任务。

问答系统 中文

R

uer

2,694

98