模型简介

模型特点

模型能力

使用案例

🚀 易模型(Yi)

易(Yi)系列模型是由 01.AI 从头开始训练的下一代开源大语言模型。该系列模型以双语语言模型为目标,在 3T 多语言语料上进行训练,成为全球最强大的大语言模型之一,在语言理解、常识推理、阅读理解等方面表现出色。

🚀 快速开始

💡 提示:如果您想开始使用易模型并探索不同的推理方法,请查看 易模型使用指南。

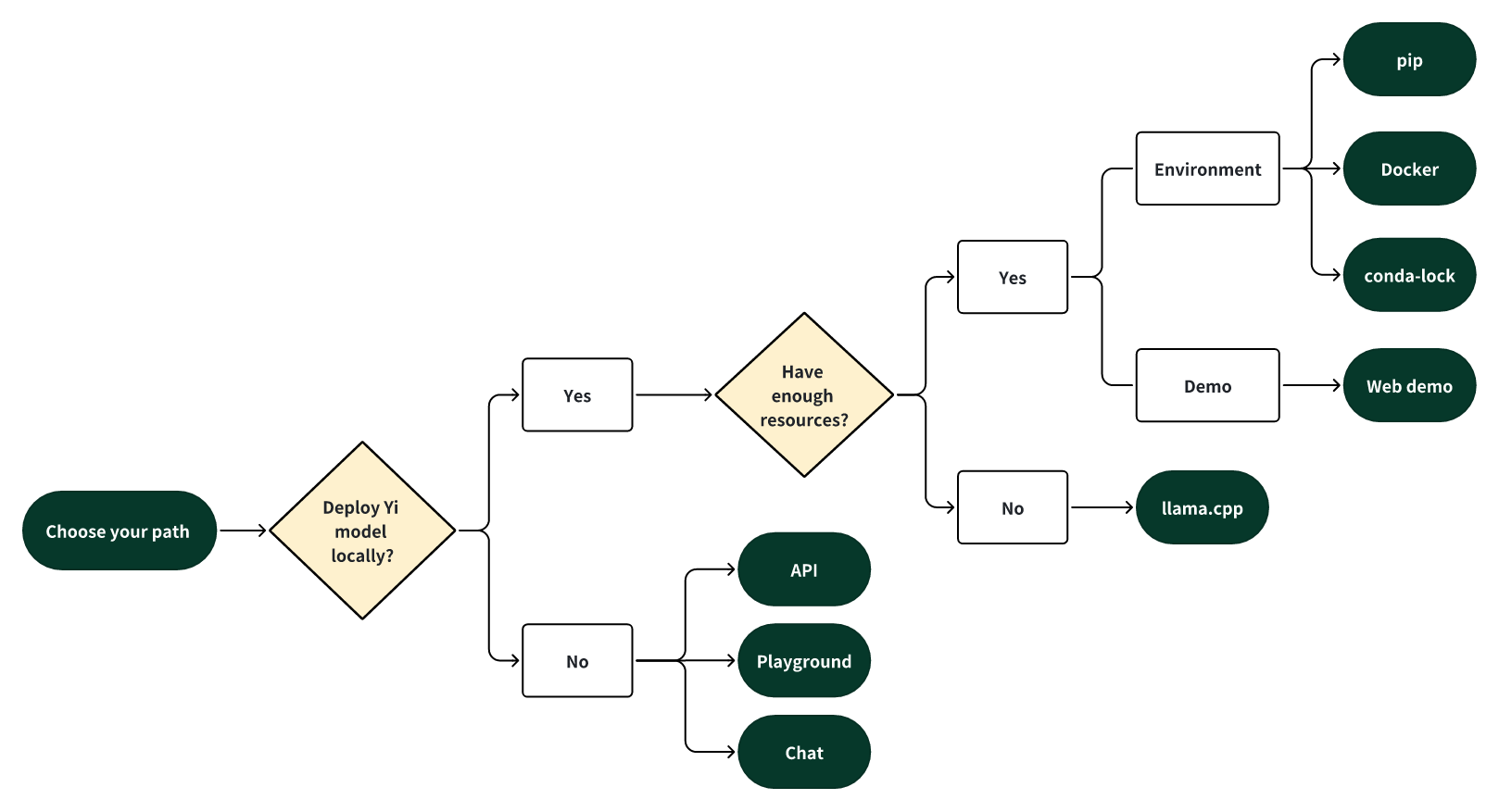

选择使用方式

选择以下其中一种方式开启您的易模型之旅!

🎯 本地部署易模型

如果您想在本地部署易模型:

- 🙋♀️ 若您有 充足 的资源(例如,NVIDIA A800 80GB),可以选择以下方法之一:

- 🙋♀️ 若您的资源 有限(例如,MacBook Pro),可以使用 llama.cpp。

🎯 非本地部署易模型

如果您不想在本地部署易模型,可以通过以下任意选项探索易模型的能力。

🙋♀️ 使用 API 运行易模型

如果您想探索易模型的更多功能,可以采用以下方法之一:

🙋♀️ 在 playground 中运行易模型

如果您想以更多可定制选项(例如,系统提示、温度、重复惩罚等)与易模型聊天,可以尝试以下选项之一:

- 易 - 34B - 聊天 - 游乐场(官方)

- 易 - 34B - 聊天 - 游乐场(Replicate)

✨ 主要特性

- 🤖 易系列模型是由 01.AI 从头开始训练的下一代开源大语言模型。

- 🙌 以双语语言模型为目标,在 3T 多语言语料上进行训练,成为全球最强大的大语言模型之一,在语言理解、常识推理、阅读理解等方面表现出色。例如:

- 易 - 34B - 聊天模型在 AlpacaEval 排行榜上 位居第二(仅次于 GPT - 4 Turbo),超越了其他大语言模型(如 GPT - 4、Mixtral、Claude)(基于截至 2024 年 1 月的数据)。

- 易 - 34B 模型在包括 Hugging Face 开源大语言模型排行榜(预训练)和 C - Eval 在内的各种基准测试中,在 英语和中文方面 均 在所有现有开源模型中排名第一(如 Falcon - 180B、Llama - 70B、Claude)(基于截至 2023 年 11 月的数据)。

- 🙏(感谢 Llama)感谢 Transformer 和 Llama 开源社区,它们减少了从头构建的工作量,并使我们能够在人工智能生态系统中使用相同的工具。

如果您对易模型采用 Llama 架构和许可证使用政策感兴趣,请查看 易模型与 Llama 的关系 ⬇️

- 易模型和 Llama 均基于 Transformer 结构,自 2018 年以来,Transformer 一直是大语言模型的标准架构。

- 基于 Transformer 架构,Llama 因其出色的稳定性、可靠的收敛性和强大的兼容性,已成为大多数最先进开源模型的新基石。这使得 Llama 成为包括易模型在内的模型公认的基础框架。

- 由于 Transformer 和 Llama 架构,其他模型可以利用它们的优势,减少从头构建的工作量,并在其生态系统中使用相同的工具。

- 然而,易系列模型并非 Llama 的衍生模型,因为它们没有使用 Llama 的权重。

- 由于大多数开源模型都采用了 Llama 的结构,决定模型性能的关键因素是训练数据集、训练管道和训练基础设施。

- 易模型以独特的专有方式发展,完全从头开始独立创建了自己的高质量训练数据集、高效的训练管道和强大的训练基础设施。这一努力使得易系列模型表现出色,在 2023 年 12 月的 Alpaca 排行榜 上仅次于 GPT4 并超越了 Llama。

💡 简而言之

易系列模型采用了与 Llama 相同的模型架构,但 并非 Llama 的衍生模型。

📦 安装指南

pip 安装

暂未提及具体 pip 安装命令,可参考 易模型使用指南 进行安装。

Docker 部署

暂未提及具体 Docker 部署命令,可参考 易模型使用指南 进行部署。

conda-lock 安装

暂未提及具体 conda - lock 安装命令,可参考 易模型使用指南 进行安装。

llama.cpp 安装

暂未提及具体 llama.cpp 安装命令,可参考 易模型使用指南 进行安装。

💻 使用示例

基础用法

以下是使用易模型 API 的示例代码:

# 示例代码,假设使用 Replicate 的 API

import replicate

model = replicate.models.get("01-ai/yi-34b-chat")

version = model.versions.get("your_version_number")

input = {

"prompt": "Hello!",

"temperature": 0.7,

"max_length": 200

}

output = version.predict(**input)

print(output)

高级用法

# 高级用法示例,使用系统提示和更多参数

import replicate

model = replicate.models.get("01-ai/yi-34b-chat")

version = model.versions.get("your_version_number")

input = {

"prompt": "Hello!",

"system_prompt": "You are a helpful assistant.",

"temperature": 0.7,

"max_length": 200,

"repetition_penalty": 1.2

}

output = version.predict(**input)

print(output)

📚 详细文档

模型介绍

易模型有多种尺寸,适用于不同的用例。您还可以对易模型进行微调以满足您的特定需求。

如果您想部署易模型,请确保满足 软件和硬件要求。

聊天模型

| 模型 | 下载地址 |

|---|---|

| 易 - 34B - 聊天 | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 34B - 聊天 - 4bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 34B - 聊天 - 8bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 6B - 聊天 | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 6B - 聊天 - 4bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 6B - 聊天 - 8bits | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

- 4 - bit 系列模型由 AWQ 量化。

- 8 - bit 系列模型由 GPTQ 量化

- 所有量化模型的使用门槛较低,因为它们可以部署在消费级 GPU 上(例如,3090、4090)。

基础模型

| 模型 | 下载地址 |

|---|---|

| 易 - 34B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 34B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 9B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 9B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 6B | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

| 易 - 6B - 200K | • 🤗 Hugging Face • 🤖 ModelScope • 🟣 wisemodel |

- 200k 大约相当于 400,000 个中文字符。

- 如果您想使用易 - 34B - 200K 的先前版本(2023 年 11 月 5 日发布),请运行 git checkout 069cd341d60f4ce4b07ec394e82b79e94f656cf 下载权重。

模型信息

- 聊天模型和基础模型

| 模型 | 介绍 | 默认上下文窗口 | 预训练令牌 | 训练数据日期 |

|---|---|---|---|---|

| 6B 系列模型 | 适用于个人和学术用途。 | 4K | 3T | 截至 2023 年 6 月 |

| 9B 系列模型 | 在易系列模型中,它在编码和数学方面表现最佳。 | 4K | 易 - 9B 基于易 - 6B 持续训练,使用 0.8T 令牌。 | 截至 2023 年 6 月 |

| 34B 系列模型 | 适用于个人、学术和商业(特别是中小企业)用途。这是一种经济高效的解决方案,价格实惠且具备涌现能力。 | 4K | 3T | 截至 2023 年 6 月 |

- 聊天模型

关于聊天模型的局限性,请查看以下解释 ⬇️

发布的聊天模型仅使用监督微调(SFT)进行了训练。与其他标准聊天模型相比,我们的模型生成的响应更加多样化,适用于各种下游任务,如创意场景。此外,这种多样性有望提高生成高质量响应的可能性,这将有利于后续的强化学习(RL)训练。

<br> 然而,这种更高的多样性可能会放大某些现有问题,包括:

<li> 幻觉:这是指模型生成事实错误或无意义的信息。由于模型的响应更加多样化,出现基于不准确数据或逻辑推理的幻觉的可能性更高。</li>

<li> 重新生成的非确定性:在尝试重新生成或采样响应时,可能会出现结果不一致的情况。增加的多样性可能导致即使在相似的输入条件下也会产生不同的结果。</li>

<li> 累积误差:当模型响应中的误差随着时间累积时就会出现这种情况。随着模型生成的响应更加多样化,小的不准确累积成大误差的可能性增加,特别是在复杂任务中,如扩展推理、数学问题解决等。</li>

<li> 为了获得更连贯和一致的响应,建议调整生成配置参数,如温度、top_p 或 top_k。这些调整可以帮助平衡模型输出的创造性和连贯性。</li>

新闻

🔥 2024 - 07 - 29:易模型使用指南 1.0 发布,包含中英文教程和示例。

🎯 2024 - 05 - 13:易 - 1.5 系列模型 开源。进一步提高了编码、数学、推理和指令跟随能力。

🎯 2024 - 03 - 16:易 - 9B - 200K 开源并向公众开放。

🎯 2024 - 03 - 08:易模型技术报告 发布!

🔔 2024 - 03 - 07:易 - 34B - 200K 的长文本处理能力得到增强。

在 “大海捞针” 测试中,易 - 34B - 200K 的性能提高了 10.5%,从 89.3% 提升到令人印象深刻的 99.8%。我们继续在 5B 令牌的长上下文数据混合上对模型进行预训练,并展示了近乎全绿的性能。

🎯 2024 - 03 - 06:易 - 9B 开源并向公众开放。

易 - 9B 在一系列类似规模的开源模型(包括 Mistral - 7B、SOLAR - 10.7B、Gemma - 7B、DeepSeek - Coder - 7B - Base - v1.5 等)中脱颖而出,尤其在代码、数学、常识推理和阅读理解方面表现出色。

🎯 2024 - 01 - 23:易 - VL 模型 易 - VL - 34B 和 易 - VL - 6B 开源并向公众开放。

易 - VL - 34B 在包括 MMMU 和 CMMMU 在内的最新基准测试中,在所有现有开源模型中 **排名第一**(基于截至 2024 年 1 月的数据)。

🎯 2023 - 11 - 23:聊天模型 开源并向公众开放。

此版本包含两个基于先前发布的基础模型的聊天模型、两个由 GPTQ 量化的 8 位模型和两个由 AWQ 量化的 4 位模型。

易 - 34B - 聊天易 - 34B - 聊天 - 4bits易 - 34B - 聊天 - 8bits易 - 6B - 聊天易 - 6B - 聊天 - 4bits易 - 6B - 聊天 - 8bits

您可以在以下平台交互式尝试其中一些模型:

🔔 2023 - 11 - 23:易系列模型社区许可协议更新为 v2.1。

🎯 2023 - 11 - 05:基础模型 易 - 6B - 200K 和 易 - 34B - 200K 开源并向公众开放。

此版本包含两个与之前版本参数大小相同的基础模型,只是上下文窗口扩展到了 200K。

🎯 2023 - 11 - 02:基础模型 易 - 6B 和 易 - 34B 开源并向公众开放。

首次公开发布包含两个双语(英语/中文)基础模型,参数大小分别为 6B 和 34B。它们都使用 4K 序列长度进行训练,并且在推理时可以扩展到 32K。

微调

暂未提供详细的微调步骤,可参考相关文档进一步探索。

量化

暂未提供详细的量化步骤,可参考相关文档进一步探索。

部署

暂未提供详细的部署要求和步骤,可参考相关文档进一步探索。

常见问题解答(FAQ)

暂未提供常见问题解答内容,可参考相关文档进一步探索。

学习中心

暂未提供学习中心的详细内容,可参考相关文档进一步探索。

🔧 技术细节

暂未提供详细的技术细节,可参考 易模型技术报告 进一步了解。

📄 许可证

本项目采用 Apache - 2.0 许可证。

⚠️ 重要提示

请仔细阅读 易系列模型社区许可协议。

💡 使用建议

在使用易模型时,根据您的具体需求选择合适的模型和使用方式。如果您对模型的性能有较高要求,建议使用 34B 系列模型;如果您的资源有限,可以考虑使用量化模型。同时,注意调整生成配置参数,以获得更满意的结果。

Transformers

Transformers Transformers 支持多种语言

Transformers 支持多种语言 Transformers 支持多种语言

Transformers 支持多种语言 Transformers 英语

Transformers 英语